PanopticSegFormer:Transformer引领的全景分割新高度

69 浏览量

更新于2025-01-16

收藏 982KB PDF 举报

“PanopticSegFormer:使用Transformers提升全景分割性能”

本文介绍了一种名为PanopticSegFormer的新框架,该框架旨在改进全景分割任务的性能,结合了语义分割和实例分割的优势。全景分割是计算机视觉领域的重要任务,旨在将图像内容划分为“事物”(可数实例)和“东西”(背景或不可计数对象)两类。

PanopticSegFormer的创新之处在于它采用了Transformer架构,这种架构在自然语言处理和计算机视觉领域都表现出色。Transformer的引入带来了三个关键组件:

1. **深度监督掩码解码器**:这个组件对注意力模块进行逐层监督,使模型能够更快地聚焦于有意义的语义区域。这种深度监督策略提升了模型的学习效率,同时减少了训练所需的时间,对比可变形DETR,性能得到提高,训练速度翻倍。

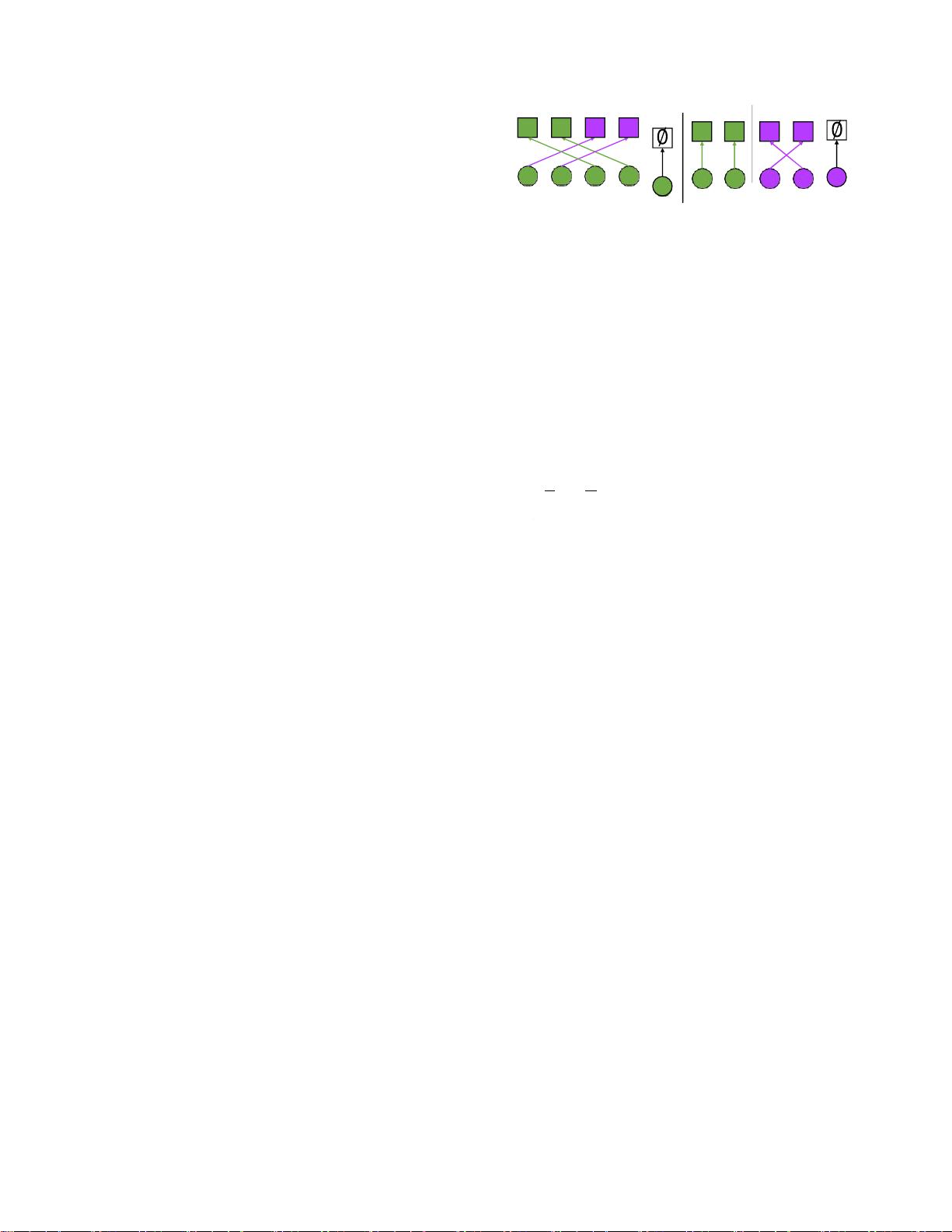

2. **查询解耦策略**:此策略将查询集的职责分离,防止事物实例之间的相互干扰。这样可以更准确地区分不同的实例,降低混淆的可能性。

3. **改进的后处理方法**:针对冲突的掩码重叠,该策略通过同时考虑分类和分割质量来解决,提高了性能,且无需额外计算成本。

实验表明,PanopticSegFormer在COCO测试开发集上取得了最先进的结果,PQ(Panoptic Quality)达到56.2%,相比基线DETR模型提升了6.2%的准确性。此外,该方法还显示出了强大的零射击(zero-shot)鲁棒性,意味着它能在未见过的类别上表现出色。

图1展示了PanopticSegFormer与现有技术在COCOval2017拆分上的比较,显示了其在不同参数设置下的性能优势。这表明,即使在较低的参数量下,PanopticSegFormer也能保持较高的分割质量,证明了其效率和有效性。

PanopticSegFormer为全景分割提供了一个新的视角,通过Transformer架构和特定的设计决策,提高了模型的性能和训练效率,对于未来的研究和应用具有重要价值。

点击了解资源详情

点击了解资源详情

点击了解资源详情

206 浏览量

475 浏览量

2025-02-12 上传

112 浏览量

484 浏览量

1339 浏览量

cpongm

- 粉丝: 6

最新资源

- C#实现程序A的监控启动机制

- Delphi与C#交互加密解密技术实现与源码分析

- 高效财务发票管理软件

- VC6.0编程实现删除磁盘空白文件夹工具

- w5x00-master.zip压缩包解析:W5200/W5500系列Linux驱动程序

- 数字通信经典教材第五版及其答案分享

- Extjs多表头设计与实现技巧

- VBA压缩包子技术未来展望

- 精选多类型导航菜单,总有您钟爱的一款

- 局域网聊天新途径:Android平台UDP技术实现

- 深入浅出神经网络模式识别与实践教程

- Junit测试实例分享:纯Java与SSH框架案例

- jquery xslider插件实现图片的流畅自动及按钮控制滚动

- MVC架构下的图书馆管理系统开发指南

- 里昂理工学院RecruteSup项目:第5年实践与Java技术整合

- iOS 13.2真机调试包使用指南及安装