动态表示学习提升视频模型的迁移与泛化能力

109 浏览量

更新于2025-01-16

收藏 16.93MB PDF 举报

本文主要探讨了在视频理解领域中的一个关键问题——如何通过动态表示学习来改进视频模型的迁移性能。传统的深度卷积神经网络虽然在大规模视频识别任务中表现突出,但它们在捕捉视频的长期时间结构方面存在局限性,从而影响了模型在新数据集上的泛化能力。作者针对这一问题,引入了动态分数这一概念,它衡量了视频网络所学习到的表示中除空间信息外的额外动态信息,这部分信息对于理解视频动态至关重要。

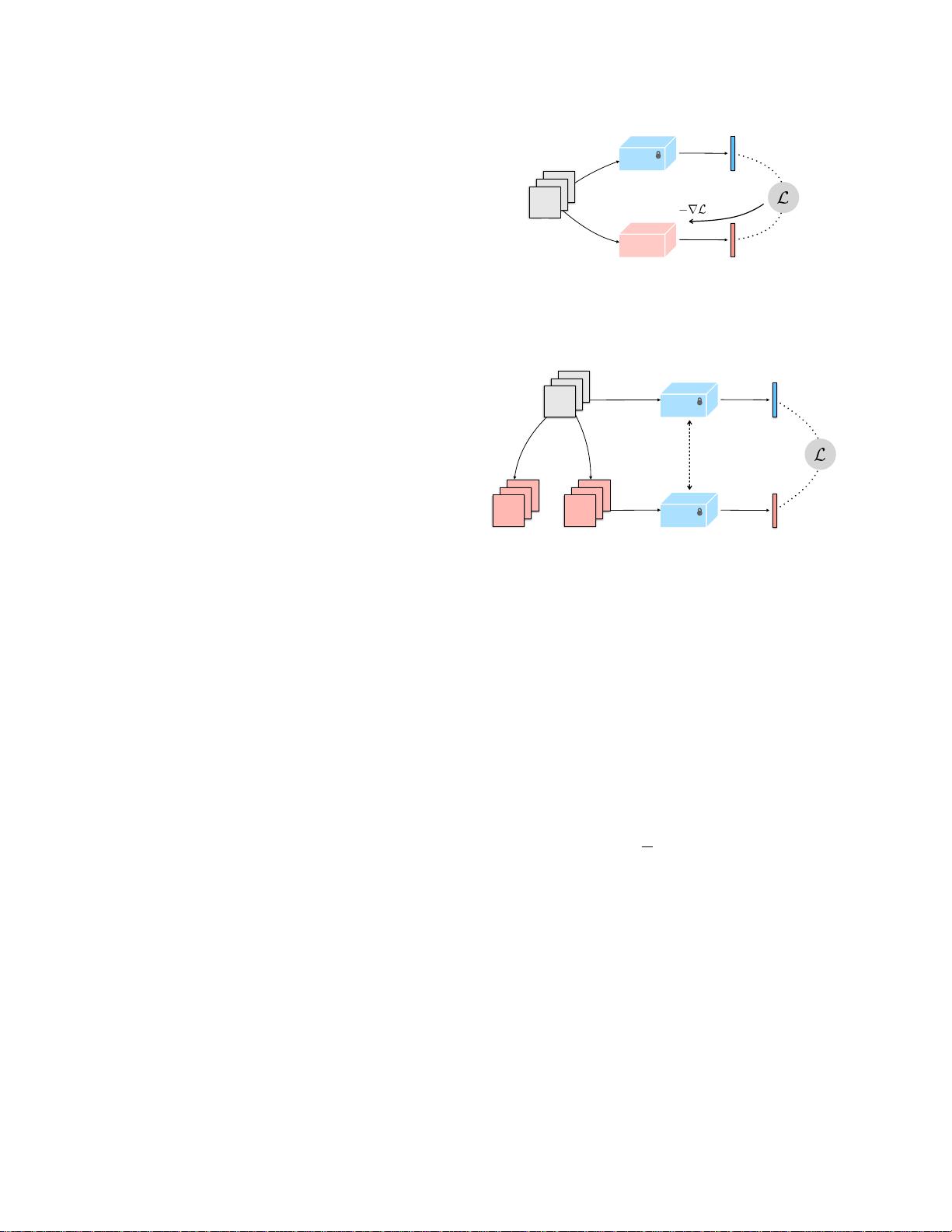

动态分数被看作是视频和空间模型之间对抗学习的工具,通过将时空分类器的性能提升作为目标,鼓励模型学习到更丰富的动态特征。作者设计了一种动态表示学习框架,旨在最大化这种动态分数,以增强模型对时间序列关系的建模能力。实验结果显示,经过动态表示学习(DRL)训练的模型在处理多样化的迁移学习任务,如动作分类,特别是面对少样本和新领域时,显示出显著的优势,证明了其在动态建模方面的优越性和更好的泛化能力。

文章首先回顾了深度学习在视频分类领域的进展,尤其是卷积神经网络相对于循环网络的优势,但同时也指出这些模型在处理复杂视频数据集时遇到的挑战,如空间偏见问题。空间偏见源于动作标签可能与视频帧中的视觉信息相关,而非动作本身,这使得模型容易依赖于静态画面而忽视视频的时间动态特性。

为了克服这些问题,作者强调了动态表示学习在解决视频时间建模中的重要性,并提出了一种创新的方法,通过对抗学习来增强模型的动态适应能力。这种方法不仅有助于提高模型在现有数据集上的性能,而且在面临未知环境和任务时展现出更强的迁移和泛化能力,这对于视频理解和相关应用具有实际价值。

总结来说,本文的研究为视频模型的改进提供了新的视角,特别是在处理时间依赖性问题上,动态表示学习作为一种有效手段,能够提升模型的鲁棒性和泛化能力,有望推动视频分析技术在实际场景中的应用。

290 浏览量

137 浏览量

134 浏览量

点击了解资源详情

点击了解资源详情

273 浏览量

cpongm

- 粉丝: 6

最新资源

- ITween插件实用教程:路径运动与应用案例

- React三纤维动态渐变背景应用程序开发指南

- 使用Office组件实现WinForm下Word文档合并功能

- RS232串口驱动:Z-TEK转接头兼容性验证

- 昆仑通态MCGS西门子CP443-1以太网驱动详解

- 同步流密码实验研究报告与实现分析

- Android高级应用开发教程与实践案例解析

- 深入解读ISO-26262汽车电子功能安全国标版

- Udemy Rails课程实践:开发财务跟踪器应用

- BIG-IP LTM配置详解及虚拟服务器管理手册

- BB FlashBack Pro 2.7.6软件深度体验分享

- Java版Google Map Api调用样例程序演示

- 探索设计工具与材料弹性特性:模量与泊松比

- JAGS-PHP:一款PHP实现的Gemini协议服务器

- 自定义线性布局WidgetDemo简易教程

- 奥迪A5双门轿跑SolidWorks模型下载