语义引导的图注意网络在指称理解中的创新应用

8 浏览量

更新于2025-01-16

收藏 1.49MB PDF 举报

"基于语义引导的图注意网络在指称表达理解中的应用"

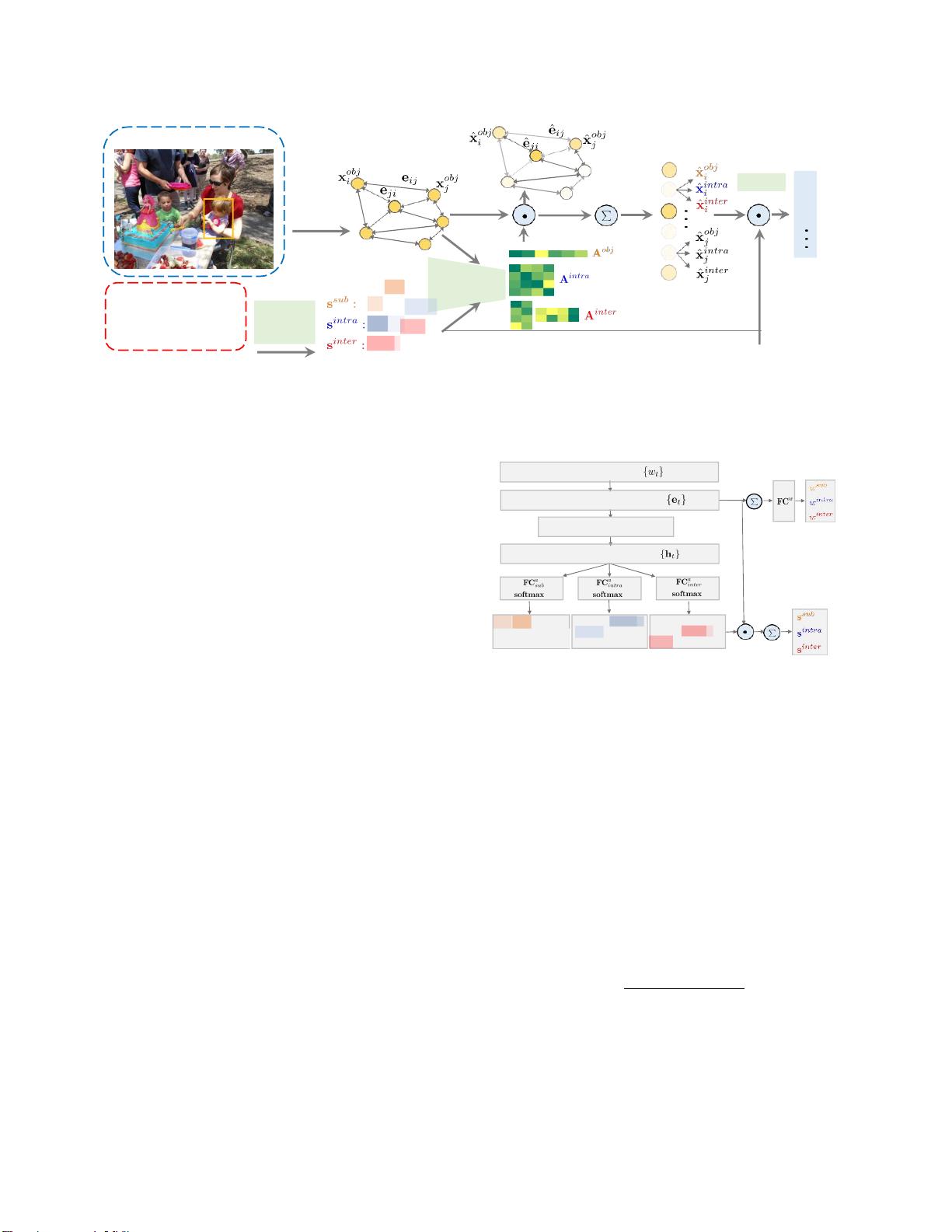

本文探讨了在指称表达理解任务中,如何利用语义引导的图注意网络来提升模型的性能和解释性。指称表达理解涉及到识别自然语言描述在图像中的对应对象,这需要对文本和视觉信息进行深入的理解。在传统方法中,区域通常通过CNN特征、空间特征和上下文特征等组合表示,然后用LSTM处理语言表达。然而,这种方法往往受限于单一向量表示,忽视了复杂的语言结构和图像中的结构信息。

文章提出了一种基于图的、语言引导的注意力机制,通过构建对象实例的有向图来捕获对象间的关系和属性。图中的节点代表对象区域,边则表示类内和类间的关系。图注意力机制包含节点注意力和边注意力,能够灵活、有效地表示对象间的关系,这是传统的竞争方法所不具备的。此外,这种图形注意机制使得决策过程变得可视化和可解释,有助于理解模型的工作原理。

实验结果在三个不同的参考表达式理解数据集上验证了该方法的有效性,证明了所提出的图注意机制在理解和匹配语言表达与图像区域方面的优越性。与以往方法相比,它解决了语言和区域特征独立学习的问题,促进了两种模态特征的相互适应,尤其在处理复杂表达时更具优势。

该研究引入了语义引导的图注意网络,以解决指称表达理解中的关键挑战,即适应复杂的语言表达和理解图像中的结构信息。通过这种创新的注意力机制,模型能够更好地捕捉到对象间的语义关系,从而提高识别精度和可解释性。这一研究对于自然语言处理和计算机视觉的交叉领域具有重要的理论价值和实际应用前景。

cpongm

- 粉丝: 6

最新资源

- 普天身份证阅读器新版二次开发包发布

- C# 实现文件的数据库保存与导出操作

- CkEditor增强功能:轻松实现图片上传

- 掌握DLL注入技术:测试工具使用与探索

- 实现带节假日农历功能的jQuery日历选择器

- Spring循环依赖示例:深入理解与Git代码仓库实践

- ABB PLC液压阀门控制程序开发指南

- 揭秘4核旋风密版626象棋引擎的超牛实力

- HTML5实现的经典游戏:小霸王坦克大战源码分享

- 让Visual Studio兼容APM硬件信息的方法

- Kotlin入门:创建我的第一个应用

- Android语音识别技术研究报告与应用分析

- 掌握JavaScript基础:第8版教程源代码解析

- jQuery制作动态侧面浮动图片广告特效教程

- Android PinView仿支付宝密码输入框源码分析

- HTML5 Canvas制作的围住神经猫游戏源码分享