ZEROQ:无样本量化新框架,实现混合精度优化

PDF格式 | 2.11MB |

更新于2025-01-16

| 190 浏览量 | 举报

"ZeroQ: 一种新的零镜头量化框架"

在神经网络模型的应用中,量化技术已经成为减小模型推理时间和内存占用的关键方法。然而,大多数量化技术依赖于原始训练数据集来进行再训练,这对于处理敏感或专有数据的场景来说是不可行的,因为这可能涉及数据隐私和安全问题。针对这一挑战,"ZeroQ" 提出了一种全新的零镜头量化框架,它不需要访问任何训练或验证数据,实现了混合精度量化。

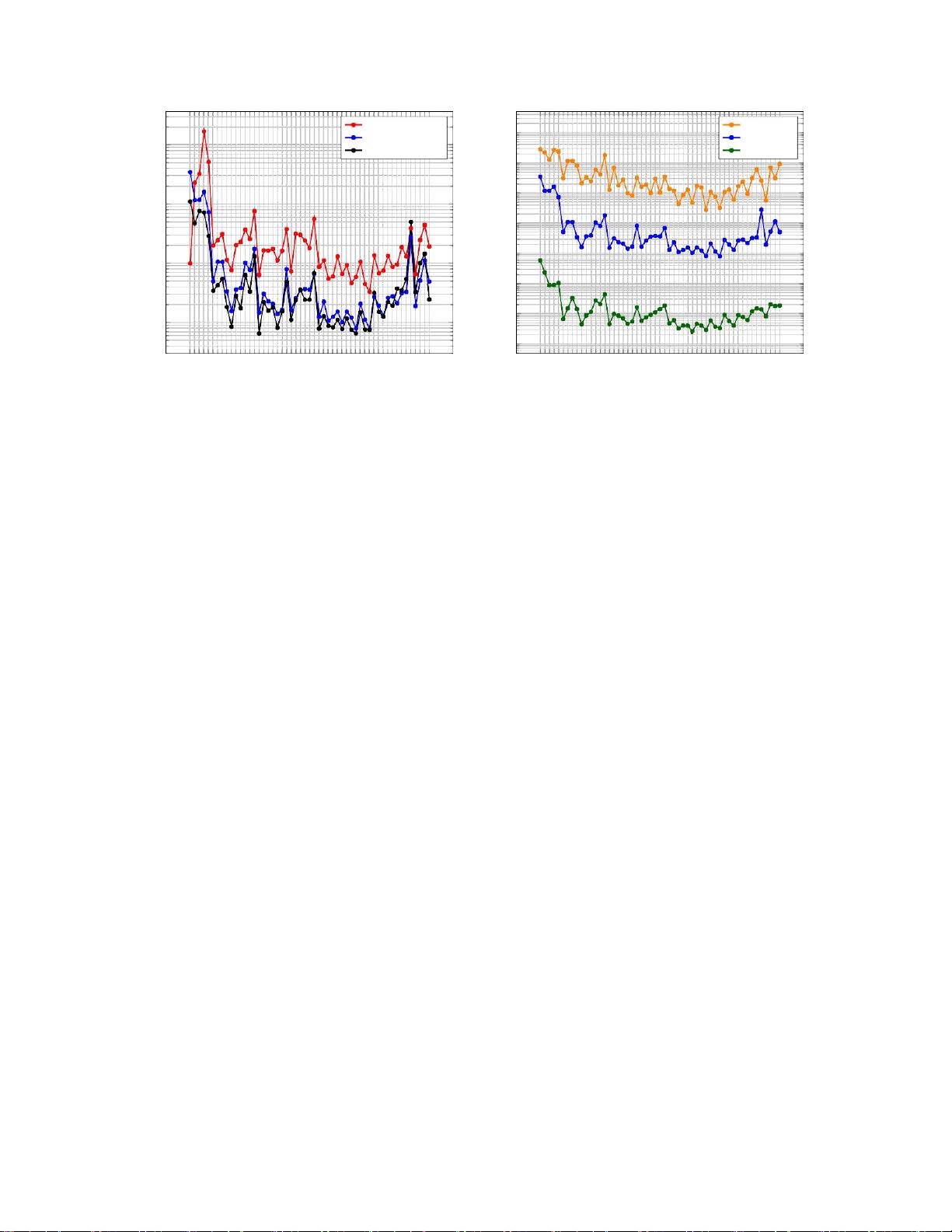

ZeroQ 的核心在于通过优化蒸馏数据集来完成模型的量化,同时支持均匀和混合精度量化。对于混合精度量化,它引入了一个基于帕累托边界的自动化方法,能自动确定每个层的最佳位宽设置,避免了手动搜索的过程。这种创新的方法不仅保持了模型性能,还在多个模型上,如 ImageNet 上的 ResNet18/50/152 和 MobileNetV2,显示了与现有量化方法相当甚至更高的精度。例如,在 MobileNetV2 上,ZeroQ 可以达到 1.71% 的高精度,与 DFQ 方法相当。

除了性能优势,ZeroQ 还以极低的计算开销著称。它能在短短 30 秒内完成整个量化过程,这仅占 ResNet50 在 ImageNet 上一个训练 epoch 时间的 0.5%,大大提升了效率。此外,ZeroQ 已经开源,可供研究者和开发者使用。

深度学习模型的广泛应用,尤其是在边缘设备上,受到了高内存占用、推理时间和能源消耗的限制。量化是缓解这些问题的有效途径,因为它能将模型的权重和激活值从浮点数转换为整数,从而减少模型大小,加快计算速度,并节省能源。量化还可以减少内存流量,进一步降低能耗。

然而,传统的量化方法往往依赖于重新训练,这对敏感数据应用来说是一个障碍。ZeroQ 的出现打破了这一限制,提供了一种安全且高效的量化策略。通过在不牺牲性能的前提下实现无数据量化,ZeroQ 为隐私保护和高效计算开辟了新的可能性,对推动神经网络模型在各种环境中的部署具有重要意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- VB通过Modbus协议控制三菱PLC通讯实操指南

- simfinapi:R语言中简化SimFin数据获取与分析的包

- LabVIEW温度控制上位机程序开发指南

- 西门子工业网络通信实例解析与CP243-1应用

- 清华紫光全能王V9.1软件深度体验与功能解析

- VB实现Access数据库数据同步操作指南

- VB实现MSChart绘制实时监控曲线

- VC6.0通过实例深入访问Excel文件技巧

- 自动机可视化工具:编程语言与正则表达式的图形化解释

- 赛义德·莫比尼:揭秘其开创性技术成果

- 微信小程序开发教程:如何实现模仿ofo共享单车应用

- TrueTable在Windows10 64位及CAD2007中的完美适配

- 图解Win7搭建IIS7+PHP+MySQL+phpMyAdmin教程

- C#与LabVIEW联合采集NI设备的电压电流信号并创建Excel文件

- LP1800-3最小系统官方资料压缩包

- Linksys WUSB54GG无线网卡驱动程序下载指南