融合相机雷达的水面小目标检测提升精准度

PDF格式 | 2.73MB |

更新于2025-01-16

| 61 浏览量 | 举报

本文主要探讨了在内陆水域USV任务中,针对水面小目标检测面临的挑战,尤其是在基于视觉的方法存在的局限性背景下,如何通过融合相机和毫米波雷达的技术来提升检测性能。作者程宇伟、徐胡和刘益民来自清华大学、ORCA-Uboat和西北工业大学,他们提出了一种新颖的雷达-视觉融合策略,旨在解决小目标检测中的光照反射、周围景物反射干扰等问题。

首先,无人水面车辆(USV)的应用领域正在不断扩展,从海洋研究到环境监测和废物清理等,对精确和可靠的环境感知提出了更高要求。在内陆水域中,水面小目标检测对于USV的安全导航和特定任务(如清理漂浮垃圾)至关重要。然而,传统基于视觉的方法在应对这些挑战时表现出局限性,比如高光照导致的过曝光和小目标被遮蔽,以及周围景物反射带来的识别难度。

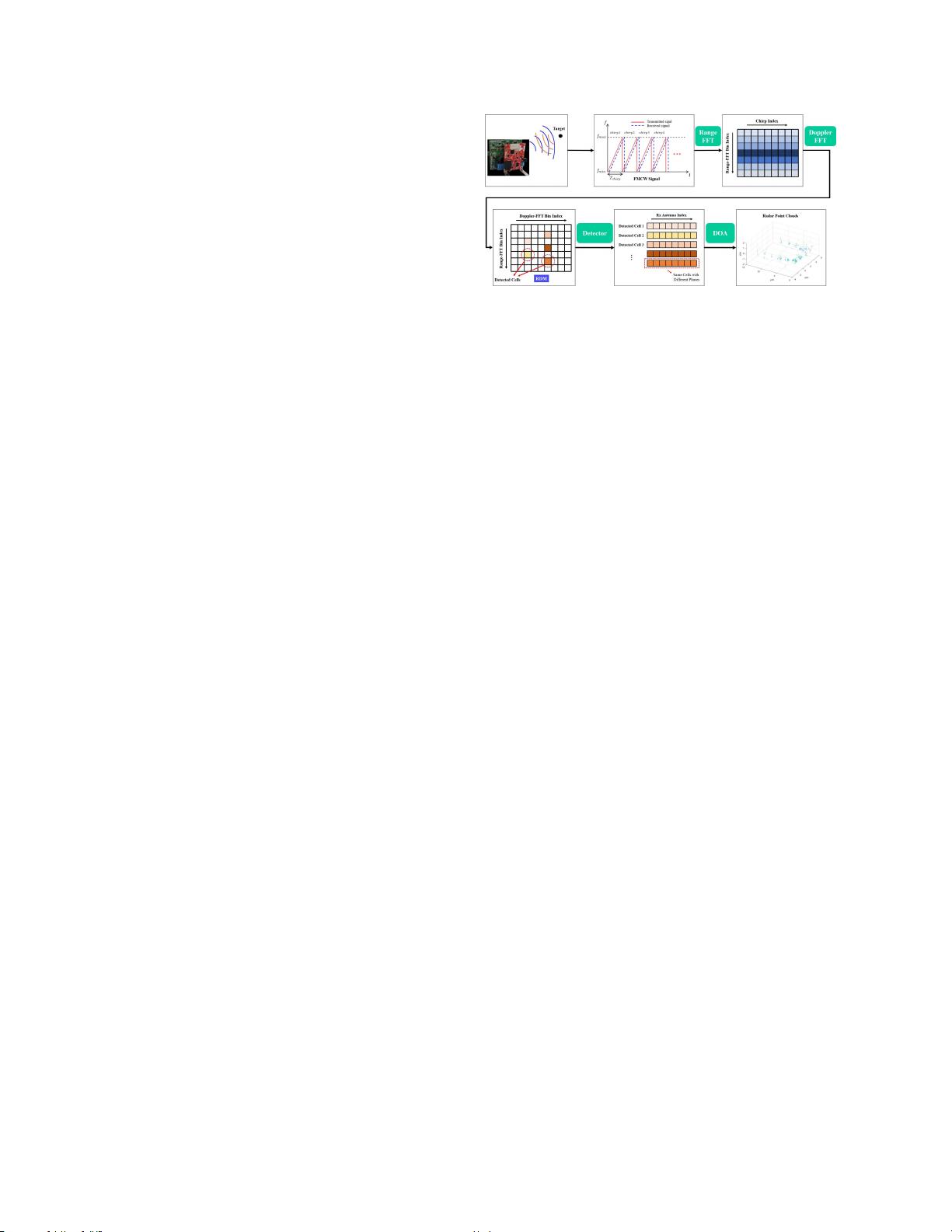

为解决这些问题,研究者设计了一种深度多尺度融合框架,将RGB图像和毫米波雷达数据相结合。毫米波雷达点云以新的表示形式被引入,其特性如距离、角度和速度信息能够弥补视觉传感器的不足。通过这种融合,算法能够更有效地利用雷达数据,增强对水面小目标的检测能力。

实验证明,相较于单纯的视觉方法,该雷达-视觉融合方案显著提高了平均检测精度,达到当前最先进的水平。此外,这种方法展现出良好的鲁棒性,即使在单传感器失效的情况下也能保持有效的环境感知。研究团队通过他们收集并发布的实际漂流瓶数据集进行测试,验证了这一方法的有效性和实用性。

这篇论文不仅介绍了融合技术在解决水面小目标检测问题上的创新应用,还展示了其在实际场景中的优越性能,对于推动无人水面车辆在内陆水域中的智能化操作具有重要意义。未来,这种融合方法可能成为USV在多样化环境下的标准感知策略。

相关推荐

cpongm

- 粉丝: 6

最新资源

- Ruby语言集成Mandrill API的gem开发

- 开源嵌入式qt软键盘SYSZUXpinyin可移植源代码

- Kinect2.0实现高清面部特征精确对齐技术

- React与GitHub Jobs API整合的就业搜索应用

- MATLAB傅里叶变换函数应用实例分析

- 探索鼠标悬停特效的实现与应用

- 工行捷德U盾64位驱动程序安装指南

- Apache与Tomcat整合集群配置教程

- 成为JavaScript英雄:掌握be-the-hero-master技巧

- 深入实践Java编程珠玑:第13章源代码解析

- Proficy Maintenance Gateway软件:实时维护策略助力业务变革

- HTML5图片上传与编辑控件的实现

- RTDS环境下电网STATCOM模型的应用与分析

- 掌握Matlab下偏微分方程的有限元方法解析

- Aop原理与示例程序解读

- projete大语言项目登陆页面设计与实现