自适应边界建议网络:解决任意形状文本检测难题

145 浏览量

更新于2025-01-16

收藏 3.23MB PDF 举报

本文主要探讨了任意形状文本检测这一具有挑战性的任务,尤其是在场景文本检测领域,如在线教育、产品搜索和视频场景解析中的应用。随着深度学习技术的快速发展,对于能够适应各种复杂和多样场景的任意形状文本检测需求日益增长。当前的任意形状文本检测方法虽然取得了一定的进步,但依然面临着诸如多变形状、纹理和尺度等问题。

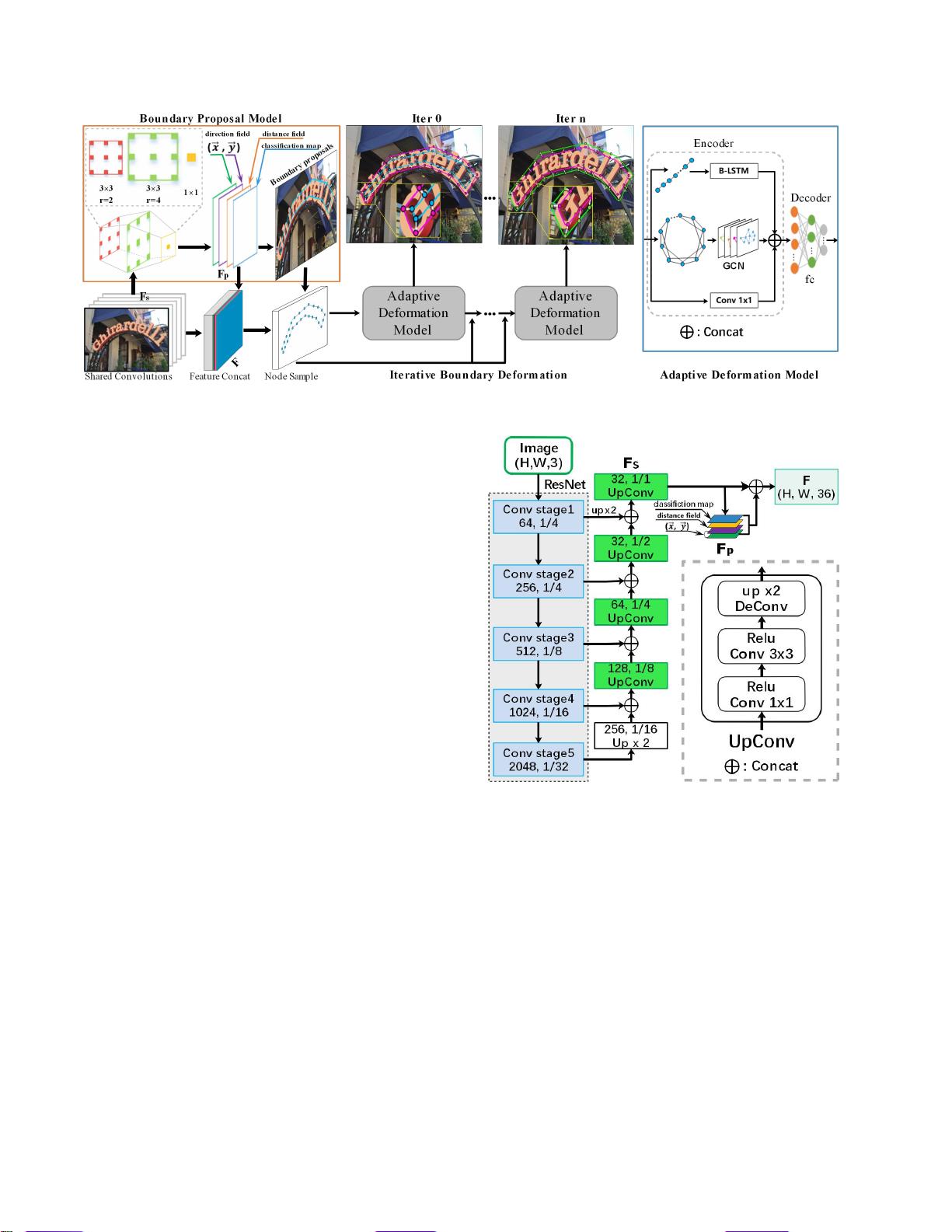

作者提出的自适应边界建议网络(Adaptive Boundary Proposal Network, TextBPN)旨在解决这些问题。核心部分包括两个关键组件:边界建议模型和自适应边界变形模型。边界建议模型采用多层扩张卷积,生成包含分类信息、距离场和方向场的先验信息,以及初步的粗边界建议。这个模型为后续的边界精确化提供了基础。

自适应边界变形模型则是一个编解码器结构,由图卷积网络(Graph Convolutional Networks, GCN)和递归神经网络(Recurrent Neural Networks, RNN)构成。它利用边界建议模型提供的先验信息,通过迭代的方式精细调整边界,从而更准确地捕捉文本实例的形状。这种方法的一大优点在于,它可以直接生成准确的文本边界,避免了传统方法中复杂的后处理步骤,显著提高了检测精度和效率。

论文还提到,尽管基于像素级分割的方法已经在一定程度上增强了对形状变化的鲁棒性,但在处理相邻文本实例的分离方面仍存在问题。为解决这个问题,TextBPN尝试通过自适应边界变形模型来增强实例间的区分能力,减少误检或漏检。

通过在公开可用数据集上的大量实验,作者展示了他们的方法在任意形状文本检测任务上表现出最先进的性能。此外,论文作者还提供了GitHub代码仓库(<https://github.com/GXYM/TextBPN>),以便于其他研究者和开发者进一步研究和应用这一技术。

总结来说,本文贡献了一种创新的任意形状文本检测框架,通过自适应边界处理,提高了文本检测的准确性和效率,为场景文本分析领域的实际应用提供了有力支持。

cpongm

- 粉丝: 6

最新资源

- 计算机组成原理期末试题及答案(2011参考)

- 均值漂移算法深入解析及实践应用

- 掌握npm与yarn在React和pg库中的使用

- C++开发学生信息管理系统实现多功能查询

- 深入解析SIMATIC NET OPC服务器与PLC的S7连接技术

- 离心式水泵原理与Matlab仿真教程

- 实现JS星级评论打分与滑动提示效果

- VB.NET图书馆管理系统源码及程序发布

- C#实现程序A监控与自动启动机制

- 构建简易Android拨号功能的应用开发教程

- HTML技术在在线杂志中的应用

- 网页开发中的实用树形菜单插件应用

- 高压水清洗技术在储罐维修中的关键应用

- 流量计校正方法及操作指南

- WinCE系统下SD卡磁盘性能测试工具及代码解析

- ASP.NET学生管理系统的源码与数据库教程