LwM: 新增信息保持惩罚与注意力蒸馏损失提升增量学习性能

200 浏览量

更新于2025-01-16

收藏 1.85MB PDF 举报

增量学习(Incremental Learning, IL)是一种机器学习领域的关键挑战,目标是让模型在面对不断增加的新类别时能够持续改进其性能,同时保持对已有类别的识别能力。传统的训练模型往往受限于固定的类别数量,一旦增加新类别,就可能面临灾难性遗忘问题,即模型会忘记已学习的基础类别。

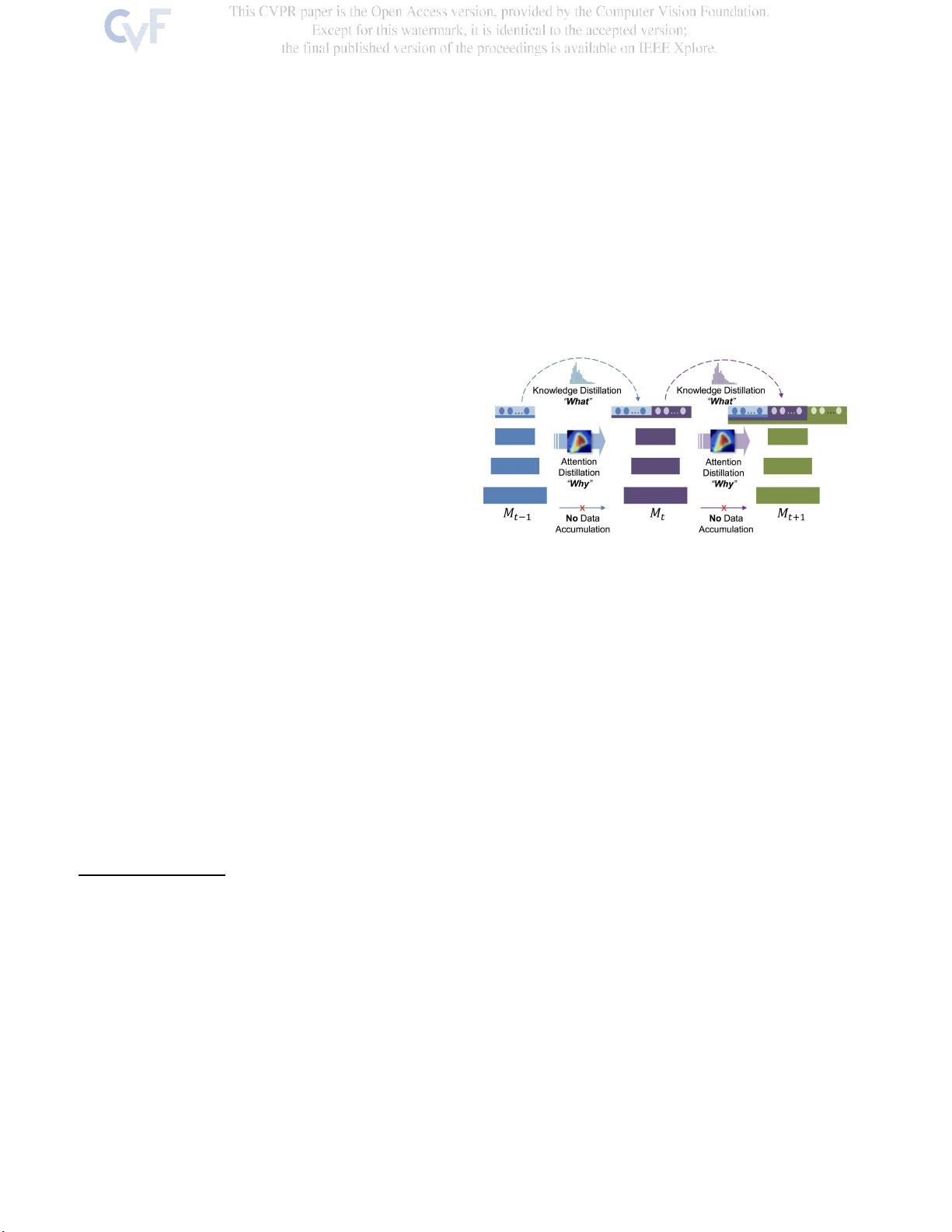

为了解决这个问题,本文提出了一个新的方法——LwM(Lightweight Memory, 轻量级记忆),其中的关键创新是引入了一个名为Attention Distillation Loss (LAD)的信息保持惩罚。LAD关注的是模型在处理新任务时注意力分布的变化,通过这种方式,它能够有效地抑制模型对新类别学习过度而忽视原有知识的情况。

LAD是在现有蒸馏损失的基础上发展起来的,蒸馏损失是一种信息保留策略,旨在确保模型在接收新数据时能保留对旧知识的记忆。通过结合LAD,研究者证明了这种惩罚能够显著提升模型在既定和新增类别上的整体准确性,从而实现增量学习过程中良好的知识迁移和保持。

论文的研究背景指出,许多先进的视觉识别系统依赖于专门针对任务训练的模型,但这类模型的复杂性随着目标类别的增加而受限。为了适应不断变化的环境,如工业应用中的对象分类,模型需要具备动态学习的能力,既能处理新出现的类别,又不会丢失原有的识别能力。

LwM方法通过控制注意力分布,实现了存储效率的提升,这对于资源受限的边缘设备尤为重要,如在内存有限的设备上进行实时学习。它克服了存储旧类别数据或编码信息的模型所带来的扩展性问题,并在实际场景中展示了其有效性和实用性。

这篇论文提出了一种创新的增量学习策略,通过LAD惩罚机制,平衡了新类别学习和旧类别保持,有助于构建一个在不断变化的任务环境中更加灵活和高效的模型。这对于推动人工智能在实际场景中的应用具有重要意义。

200 浏览量

1599 浏览量

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

cpongm

- 粉丝: 6

最新资源

- A7Demo.appstudio:探索JavaScript应用开发

- 百度地图范围内的标注点技术实现

- Foobar2000绿色汉化版:全面提升音频播放体验

- Rhythm Core .NET库:字符串与集合扩展方法详解

- 深入了解Tomcat源码及其依赖包结构

- 物流节约里程法的文档整理与实践分享

- NUnit3.vsix:快速安装NUnit三件套到VS2017及以上版本

- JQuery核心函数使用速查手册详解

- 多种风格的Select下拉框美化插件及其js代码下载

- Mac用户必备:SmartSVN版本控制工具介绍

- ELTE IK Web编程与Web开发课程内容详解

- QuartusII环境下的Verilog锁相环实现

- 横版过关游戏完整VC源码及资源包

- MVC后台管理框架2021版:源码与代码生成器详解

- 宗成庆主讲的自然语言理解课程PPT解析

- Memcached与Tomcat会话共享与Kryo序列化配置指南