首页

简述模型剪枝,模型量化,模型蒸馏的基本原理

简述模型剪枝,模型量化,模型蒸馏的基本原理

时间: 2023-03-20 22:02:46

浏览: 299

模型剪枝是一种模型压缩技术,它通过减少模型中参数数量和参数规模来减少模型的大小,从而提高模型性能。模型量化是指在保持模型性能的前提下,对模型中的参数进行重新编码,以减少模型的大小。模型蒸馏是一种模型的知识转移方法,它通过将深度神经网络中的知识转移到较浅的神经网络中,从而提高模型性能。

阅读全文

相关推荐

模型蒸馏1

模型蒸馏李威• Noval Transformer distillation method• the output of the embedding layer

YOLOv8模型优化:量化与剪枝的实战指南

量化和剪枝是两种常见的模型优化技术,它们可以显著减少模型的大小和提高推理速度,同时尽量保持模型的准确性。本文将详细介绍如何对YOLOv8模型进行量化和剪枝,并提供实际的代码示例。 量化和剪枝是提高YOLOv8模型...

【Gensim模型持久化】:保存加载模型,优化你的工作流程

在本章中,我们将简要介绍Gensim模型持久化的基本概念,并解释为什么持久化对处理大规模文本数据的项目来说至关重要。Gensim是一个专注于主题建模和文档相似性的Python库,它支持无监督的NLP模型,并且需要一种方法...

【多语言模型应用】:transformers库支持的多语言模型使用案例大解析

多语言模型作为自然语言处理(NLP)领域的重要组成部分,它在理解多种语言和促进跨文化交流方面扮演着至关重要的角色。这些模型能够捕捉到不同语言间深层的语言学结构和语义信息,从而实现有效的翻译、文本生成、...

PyTorch注意力机制:提升模型性能的核心技术

注意力机制的基本概念 注意力机制是一种技术,它允许模型在处理信息时,能够动态地聚焦于最关键的部分。这种机制的设计灵感来源于人类视觉注意力的处理方式,即在面对大量信息时,能够迅速选择性地关注某些区域,...

NLP新篇章:Transformer模型的架构与实战应用

Transformer模型的起源与原理 ## 1.1 引言 在深度学习领域,Transformer模型的出现无疑是近年来最重大的技术突破之一。本章我们将追溯这一创新的起源,解析它的核心原理,并探索它是如何在自然语言处理(NLP)领域...

【构建高效CNN】:架构设计要点详解,打造性能卓越模型

# 1. 卷积神经网络(CNN)简介与应用场景 ...## 1.2 CNN的工作原理

YOLOv8自定义数据集训练手册:打造你的专属模型专家指南

![YOLOv8]...# 1. YOLOv8自定义数据集训练概述 YOLOv8,作为YOLO系列的最新成员,代表了目标检测领域的尖端技术。本章旨在为读者提供一个全面的概述,讲解如何使用YOLOv8进

【深度学习模型调优实战手册】:从实验到优化的必备策略

![【深度学习模型调优实战手册】:从实验到优化的必备策略]...深度学习模型的调优是一个迭代的过程,目的是为了提高模型的预测准确度和泛化能力。良好的模型

AI的可解释性设计:模型复杂度与透明度的融合之道

## 1.1 AI可解释性的概念简述 可解释性是人工智能(AI)领域中一个日益受到关注的概念,其涉及AI模型的输出结果是如何产生的,以及能否以一种对人类有意义的方式被解释和理解。随着AI在各个领域的应用越来越广泛,...

PyTorch模型保存与加载进阶:掌握torch.save和torch.load的秘诀

![PyTorch模型保存与加载进阶:掌握torch.save...掌握PyTorch模型保存与加载的机制不仅能够保证实验的可复现性,还能够高效地管理你的模型。本章节将为读者提供模型保存与加载的基础知识,确保读者能够从最基础的保存和

【深度学习模型压缩】:简化复杂网络以适应边缘计算的6种方法

![【深度学习模型压缩】:简化复杂网络以适应边缘计算的6种方法]...随着深度学习模型的日益复杂,模

【移动端深度学习精度保持】:实现移动设备上的高精度深度学习模型策略

本文首先介绍了移动端深度学习的理论基础,包括基本模型构成和移动端硬件限制。随后,探讨了提升模型精度的策略,如模型压缩、优化技术和精度与性能之间的平衡。在实际应用部分,文中分析了图像识别和自然语言处理等...

【实时目标检测技术挑战】:在资源受限设备上部署YOLO抽烟模型的技巧

![【实时目标检测技术挑战】:在资源受限设备上部署YOLO抽烟模型的技巧]...# 1. 实时目标检测技术概述 在当今信息迅速流动的时代,实时目标检测技术作为计算机视觉的一个重要分支,在安防监控、自动驾驶、工业检测等...

【YOLOv8非极大值抑制详解】:原理与在边界框回归中的改进

[【YOLOv8非极大值抑制详解】:原理与在边界框回归中的改进](https://ucc.alicdn.com/images/user-upload-01/img_convert/bc223841c1cf7c8560065fb3389be898.png?x-oss-process=image/resize,s_500,m_lfit) ...

精选毕设项目-微笑话.zip

精选毕设项目-微笑话

在线教育系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

Spring Boot是Spring框架的一个模块,它简化了基于Spring应用程序的创建和部署过程。Spring Boot提供了快速启动Spring应用程序的能力,通过自动配置、微服务支持和独立运行的特性,使得开发者能够专注于业务逻辑,而不是配置细节。Spring Boot的核心思想是约定优于配置,它通过自动配置机制,根据项目中添加的依赖自动配置Spring应用。这大大减少了配置文件的编写,提高了开发效率。Spring Boot还支持嵌入式服务器,如Tomcat、Jetty和Undertow,使得开发者无需部署WAR文件到外部服务器即可运行Spring应用。 Java是一种广泛使用的高级编程语言,由Sun Microsystems公司(现为Oracle公司的一部分)在1995年首次发布。Java以其“编写一次,到处运行”(WORA)的特性而闻名,这一特性得益于Java虚拟机(JVM)的使用,它允许Java程序在任何安装了相应JVM的平台上运行,而无需重新编译。Java语言设计之初就是为了跨平台,同时具备面向对象、并发、安全和健壮性等特点。 Java语言广泛应用于企业级应用、移动应用、桌面应用、游戏开发、云计算和物联网等领域。它的语法结构清晰,易于学习和使用,同时提供了丰富的API库,支持多种编程范式,包括面向对象、命令式、函数式和并发编程。Java的强类型系统和自动内存管理减少了程序错误和内存泄漏的风险。随着Java的不断更新和发展,它已经成为一个成熟的生态系统,拥有庞大的开发者社区和持续的技术创新。Java 8引入了Lambda表达式,进一步简化了并发编程和函数式编程的实现。Java 9及以后的版本继续在模块化、性能和安全性方面进行改进,确保Java语言能够适应不断变化的技术需求和市场趋势。 MySQL是一个关系型数据库管理系统(RDBMS),它基于结构化查询语言(SQL)来管理和存储数据。MySQL由瑞典MySQL AB公司开发,并于2008年被Sun Microsystems收购,随后在2010年,Oracle公司收购了Sun Microsystems,从而获得了MySQL的所有权。MySQL以其高性能、可靠性和易用性而闻名,它提供了多种特性来满足不同规模应用程序的需求。作为一个开源解决方案,MySQL拥有一个活跃的社区,不断为其发展和改进做出贡献。它的多线程功能允许同时处理多个查询,而其优化器则可以高效地执行复杂的查询操作。 随着互联网和Web应用的快速发展,MySQL已成为许多开发者和公司的首选数据库之一。它的可扩展性和灵活性使其能够处理从小规模应用到大规模企业级应用的各种需求。通过各种存储引擎,MySQL能够适应不同的数据存储和检索需求,从而为用户提供了高度的定制性和性能优化的可能性。

基于智能推荐的卫生健康系统-springboot毕业项目,适合计算机毕-设、实训项目、大作业学习.zip

Spring Boot是Spring框架的一个模块,它简化了基于Spring应用程序的创建和部署过程。Spring Boot提供了快速启动Spring应用程序的能力,通过自动配置、微服务支持和独立运行的特性,使得开发者能够专注于业务逻辑,而不是配置细节。Spring Boot的核心思想是约定优于配置,它通过自动配置机制,根据项目中添加的依赖自动配置Spring应用。这大大减少了配置文件的编写,提高了开发效率。Spring Boot还支持嵌入式服务器,如Tomcat、Jetty和Undertow,使得开发者无需部署WAR文件到外部服务器即可运行Spring应用。 Java是一种广泛使用的高级编程语言,由Sun Microsystems公司(现为Oracle公司的一部分)在1995年首次发布。Java以其“编写一次,到处运行”(WORA)的特性而闻名,这一特性得益于Java虚拟机(JVM)的使用,它允许Java程序在任何安装了相应JVM的平台上运行,而无需重新编译。Java语言设计之初就是为了跨平台,同时具备面向对象、并发、安全和健壮性等特点。 Java语言广泛应用于企业级应用、移动应用、桌面应用、游戏开发、云计算和物联网等领域。它的语法结构清晰,易于学习和使用,同时提供了丰富的API库,支持多种编程范式,包括面向对象、命令式、函数式和并发编程。Java的强类型系统和自动内存管理减少了程序错误和内存泄漏的风险。随着Java的不断更新和发展,它已经成为一个成熟的生态系统,拥有庞大的开发者社区和持续的技术创新。Java 8引入了Lambda表达式,进一步简化了并发编程和函数式编程的实现。Java 9及以后的版本继续在模块化、性能和安全性方面进行改进,确保Java语言能够适应不断变化的技术需求和市场趋势。 MySQL是一个关系型数据库管理系统(RDBMS),它基于结构化查询语言(SQL)来管理和存储数据。MySQL由瑞典MySQL AB公司开发,并于2008年被Sun Microsystems收购,随后在2010年,Oracle公司收购了Sun Microsystems,从而获得了MySQL的所有权。MySQL以其高性能、可靠性和易用性而闻名,它提供了多种特性来满足不同规模应用程序的需求。作为一个开源解决方案,MySQL拥有一个活跃的社区,不断为其发展和改进做出贡献。它的多线程功能允许同时处理多个查询,而其优化器则可以高效地执行复杂的查询操作。 随着互联网和Web应用的快速发展,MySQL已成为许多开发者和公司的首选数据库之一。它的可扩展性和灵活性使其能够处理从小规模应用到大规模企业级应用的各种需求。通过各种存储引擎,MySQL能够适应不同的数据存储和检索需求,从而为用户提供了高度的定制性和性能优化的可能性。

精选毕设项目-课程预约.zip

精选毕设项目-课程预约

同步机(VSG)三相并网仿真模型 有功功率从20k突变到10k再恢复至20k 系统始终稳定运行 该仿真主要用于基础原理的学习

同步机(VSG)三相并网仿真模型 有功功率从20k突变到10k再恢复至20k 系统始终稳定运行 该仿真主要用于基础原理的学习

CSDN会员

开通CSDN年卡参与万元壕礼抽奖

海量

VIP免费资源

千本

正版电子书

商城

会员专享价

千门

课程&专栏

全年可省5,000元

立即开通

全年可省5,000元

立即开通

大家在看

alertmanager-0.19.0.linux-amd64.tar.gz

prometheus的alermanager报警组件

5G分组核心网专题.pptx

5G分组核心网专题

LTE Signaling & Protocol Analysis Focus: E-UTRAN and UE

非常不错,采用问答的方式来学习LTE和EPC,本章主要关注于UE和RAN部分。 This eBook is a must for everybody who requires a detailed understanding of the protocols and signaling procedures within E-UTRAN and the EPC. In that respect the clear focus of this course is on the protocols of the UE and the E-UTRAN. The eBook starts with a review of the LTE physical layer and the concepts and protocol stacks of E-UTRAN. This part concludes with the review of the EPS network architecture. Immediately afterwards we jump into real-life call flows and scenarios and confront the student with the look & feel of the LTE protocol suite. This part ends with an assessment of what will be the focus of the following chapters. The next chapters are dedicated to the different protocols EMM, ESM, MAC, RLC, RRC, S1-AP, X2-AP, SGs-AP and S101-AP. The eBook concludes with the presentation and analysis of LTE signaling flows and real-life call flows.

r3epthook-master.zip

VT ept进行hook,可以隐藏hook

LITE-ON FW spec PS-2801-9L rev A01_20161118.pdf

LITE-ON FW spec PS-2801-9L

最新推荐

PyTorch使用cpu加载模型运算方式

在PyTorch中,当你没有GPU或者CUDA支持时,仍可以使用CPU进行模型的加载和运算。本篇文章将详细介绍如何在PyTorch中利用CPU来加载和执行模型运算。 首先,当你从磁盘加载一个已经训练好的模型时,通常会使用`torch....

《文本深度学习模型压缩》综述论文

基于教师模型的知识蒸馏方法将教师模型的知识传递给小模型,而基于学生模型的知识蒸馏方法则将学生模型的知识传递给小模型。知识蒸馏可以有效地减少模型的规模,并且可以保持模型的准确性。 四、参数共享...

精选毕设项目-微笑话.zip

精选毕设项目-微笑话

免安装JDK 1.8.0_241:即刻配置环境运行

资源摘要信息:"JDK 1.8.0_241 是Java开发工具包(Java Development Kit)的版本号,代表了Java软件开发环境的一个特定发布。它由甲骨文公司(Oracle Corporation)维护,是Java SE(Java Platform, Standard Edition)的一部分,主要用于开发和部署桌面、服务器以及嵌入式环境中的Java应用程序。本版本是JDK 1.8的更新版本,其中的241代表在该版本系列中的具体更新编号。此版本附带了Java源码,方便开发者查看和学习Java内部实现机制。由于是免安装版本,因此不需要复杂的安装过程,解压缩即可使用。用户配置好环境变量之后,即可以开始运行和开发Java程序。" 知识点详细说明: 1. JDK(Java Development Kit):JDK是进行Java编程和开发时所必需的一组工具集合。它包含了Java运行时环境(JRE)、编译器(javac)、调试器以及其他工具,如Java文档生成器(javadoc)和打包工具(jar)。JDK允许开发者创建Java应用程序、小程序以及可以部署在任何平台上的Java组件。 2. Java SE(Java Platform, Standard Edition):Java SE是Java平台的标准版本,它定义了Java编程语言的核心功能和库。Java SE是构建Java EE(企业版)和Java ME(微型版)的基础。Java SE提供了多种Java类库和API,包括集合框架、Java虚拟机(JVM)、网络编程、多线程、IO、数据库连接(JDBC)等。 3. 免安装版:通常情况下,JDK需要进行安装才能使用。但免安装版JDK仅需要解压缩到磁盘上的某个目录,不需要进行安装程序中的任何步骤。用户只需要配置好环境变量(主要是PATH、JAVA_HOME等),就可以直接使用命令行工具来运行Java程序或编译代码。 4. 源码:在软件开发领域,源码指的是程序的原始代码,它是由程序员编写的可读文本,通常是高级编程语言如Java、C++等的代码。本压缩包附带的源码允许开发者阅读和研究Java类库是如何实现的,有助于深入理解Java语言的内部工作原理。源码对于学习、调试和扩展Java平台是非常有价值的资源。 5. 环境变量配置:环境变量是操作系统中用于控制程序执行环境的参数。在JDK中,常见的环境变量包括JAVA_HOME和PATH。JAVA_HOME是JDK安装目录的路径,配置此变量可以让操作系统识别到JDK的位置。PATH变量则用于指定系统命令查找的路径,将JDK的bin目录添加到PATH后,就可以在命令行中的任何目录下执行JDK中的命令,如javac和java。 在实际开发中,了解并正确配置JDK对于Java开发者来说是一个基础且重要的环节。掌握如何安装和配置JDK,以及如何理解JDK中的源码和各种工具,对于进行Java编程和解决问题至关重要。

管理建模和仿真的文件

管理Boualem Benatallah引用此版本:布阿利姆·贝纳塔拉。管理建模和仿真。约瑟夫-傅立叶大学-格勒诺布尔第一大学,1996年。法语。NNT:电话:00345357HAL ID:电话:00345357https://theses.hal.science/tel-003453572008年12月9日提交HAL是一个多学科的开放存取档案馆,用于存放和传播科学研究论文,无论它们是否被公开。论文可以来自法国或国外的教学和研究机构,也可以来自公共或私人研究中心。L’archive ouverte pluridisciplinaire

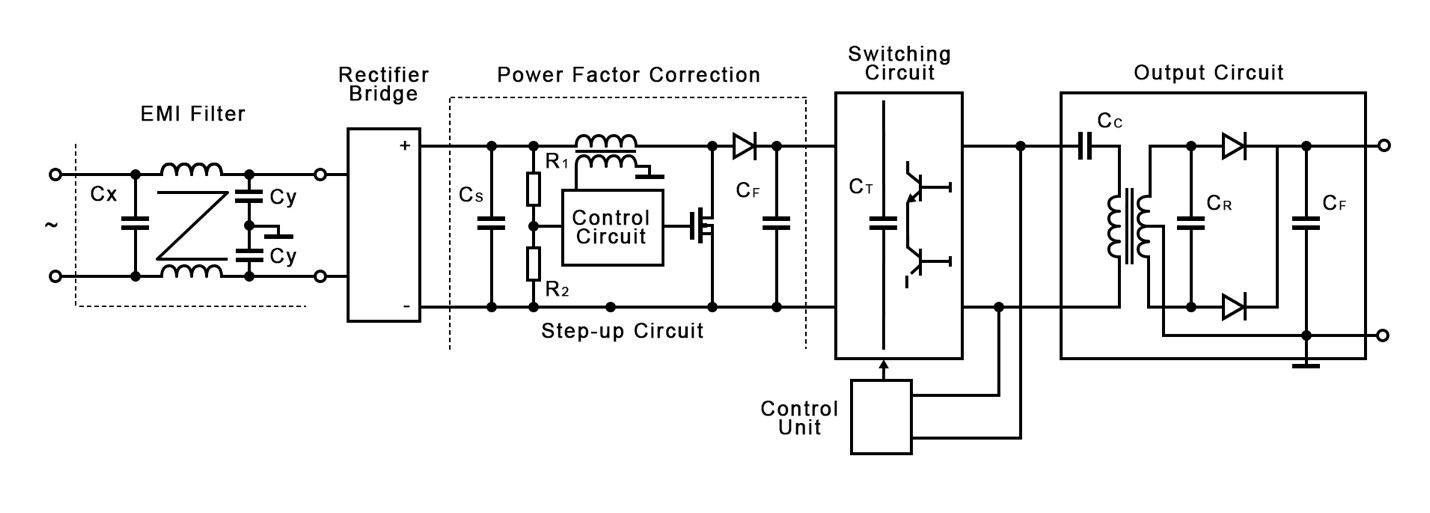

【提升效率与稳定性】:深入掌握单相整流器的控制策略

# 摘要 单相整流器作为电力电子技术的基础设备,广泛应用于电力系统和工业自动化领域。本文首先概述了单相整流器的基本概念,详细分析了其工作原理,包括电力电子器件的角色、数学模型以及控制策略。随后,针对控制技术进行了深入探讨,包括传统控制技术如PID控制和高级控制策略如模糊逻辑控制及自适应控制的应用。进一步地,本文提出了一系列提升单相整流器性能的方法,如效率提升策略、系统稳定性措施,以及性能评估与优化方案。最后,文章探讨了单相整流器在不同领域的应用案例,并对新兴技术与市场趋势进行了展望。 # 关键字 单相整流器;电力电子器件;数学模型;控制策略;性能提升;应用案例 参考资源链接:[单相PWM整

你看这是ashx映射的cs文件初始代码,你看这里边根本就没有写对action参数进行任何操作但你.ashx?action=submit这样去做他就能返回出数据这是为什么

在ASP.NET中,.ashx文件(也称为HTTP处理程序)用于处理HTTP请求并返回响应。即使在初始代码中没有对action参数进行任何操作,系统仍然可以通过默认的ProcessRequest方法处理请求并返回数据。 当你在URL中传递参数(如?action=submit)时,这些参数会被包含在请求的查询字符串中。虽然你的代码没有显式地处理这些参数,但默认的ProcessRequest方法会接收这些参数并执行一些默认操作。 以下是一个简单的.ashx文件示例: ```csharp <%@ WebHandler Language="C#" Class="MyHandler" %> us

机器学习预测葡萄酒评分:二值化品尝笔记的应用

资源摘要信息:"wine_reviewer:使用机器学习基于二值化的品尝笔记来预测葡萄酒评论分数" 在当今这个信息爆炸的时代,机器学习技术已经被广泛地应用于各个领域,其中包括食品和饮料行业的质量评估。在本案例中,将探讨一个名为wine_reviewer的项目,该项目的目标是利用机器学习模型,基于二值化的品尝笔记数据来预测葡萄酒评论的分数。这个项目不仅对于葡萄酒爱好者具有极大的吸引力,同时也为数据分析和机器学习的研究人员提供了实践案例。 首先,要理解的关键词是“机器学习”。机器学习是人工智能的一个分支,它让计算机系统能够通过经验自动地改进性能,而无需人类进行明确的编程。在葡萄酒评分预测的场景中,机器学习算法将从大量的葡萄酒品尝笔记数据中学习,发现笔记与葡萄酒最终评分之间的相关性,并利用这种相关性对新的品尝笔记进行评分预测。 接下来是“二值化”处理。在机器学习中,数据预处理是一个重要的步骤,它直接影响模型的性能。二值化是指将数值型数据转换为二进制形式(0和1)的过程,这通常用于简化模型的计算复杂度,或者是数据分类问题中的一种技术。在葡萄酒品尝笔记的上下文中,二值化可能涉及将每种口感、香气和外观等属性的存在与否标记为1(存在)或0(不存在)。这种方法有利于将文本数据转换为机器学习模型可以处理的格式。 葡萄酒评论分数是葡萄酒评估的量化指标,通常由品酒师根据酒的品质、口感、香气、外观等进行评分。在这个项目中,葡萄酒的品尝笔记将被用作特征,而品酒师给出的分数则是目标变量,模型的任务是找出两者之间的关系,并对新的品尝笔记进行分数预测。 在机器学习中,通常会使用多种算法来构建预测模型,如线性回归、决策树、随机森林、梯度提升机等。在wine_reviewer项目中,可能会尝试多种算法,并通过交叉验证等技术来评估模型的性能,最终选择最适合这个任务的模型。 对于这个项目来说,数据集的质量和特征工程将直接影响模型的准确性和可靠性。在准备数据时,可能需要进行数据清洗、缺失值处理、文本规范化、特征选择等步骤。数据集中的标签(目标变量)即为葡萄酒的评分,而特征则来自于品酒师的品尝笔记。 项目还提到了“kaggle”和“R”,这两个都是数据分析和机器学习领域中常见的元素。Kaggle是一个全球性的数据科学竞赛平台,提供各种机器学习挑战和数据集,吸引了来自全球的数据科学家和机器学习专家。通过参与Kaggle竞赛,可以提升个人技能,并有机会接触到最新的机器学习技术和数据处理方法。R是一种用于统计计算和图形的编程语言和软件环境,它在统计分析、数据挖掘、机器学习等领域有广泛的应用。使用R语言可以帮助研究人员进行数据处理、统计分析和模型建立。 至于“压缩包子文件的文件名称列表”,这里可能存在误解或打字错误。通常,这类名称应该表示存储项目相关文件的压缩包,例如“wine_reviewer-master.zip”。这个压缩包可能包含了项目的源代码、数据集、文档和其它相关资源。在开始项目前,研究人员需要解压这个文件包,并且仔细阅读项目文档,以便了解项目的具体要求和数据格式。 总之,wine_reviewer项目是一个结合了机器学习、数据处理和葡萄酒品鉴的有趣尝试,它不仅展示了机器学习在实际生活中的应用潜力,也为研究者提供了丰富的学习资源和实践机会。通过这种跨领域的合作,可以为葡萄酒行业带来更客观、一致的评价标准,并帮助消费者做出更加明智的选择。

"互动学习:行动中的多样性与论文攻读经历"

多样性她- 事实上SCI NCES你的时间表ECOLEDO C Tora SC和NCESPOUR l’Ingén学习互动,互动学习以行动为中心的强化学习学会互动,互动学习,以行动为中心的强化学习计算机科学博士论文于2021年9月28日在Villeneuve d'Asq公开支持马修·瑟林评审团主席法布里斯·勒菲弗尔阿维尼翁大学教授论文指导奥利维尔·皮耶昆谷歌研究教授:智囊团论文联合主任菲利普·普雷教授,大学。里尔/CRISTAL/因里亚报告员奥利维耶·西格德索邦大学报告员卢多维奇·德诺耶教授,Facebook /索邦大学审查员越南圣迈IMT Atlantic高级讲师邀请弗洛里安·斯特鲁布博士,Deepmind对于那些及时看到自己错误的人...3谢谢你首先,我要感谢我的两位博士生导师Olivier和Philippe。奥利维尔,"站在巨人的肩膀上"这句话对你来说完全有意义了。从科学上讲,你知道在这篇论文的(许多)错误中,你是我可以依

【单相整流器终极指南】:电气工程师的20年实用技巧大揭秘

# 摘要 单相整流器是电力电子技术中应用广泛的设备,用于将交流电转换为直流电。本文首先介绍了单相整流器的基础知识和工作原理,分析了其设计要点,性能评估方法以及在电力系统和电子设备中的应用。接着,探讨了单相整流器的进阶应用和优化策略,包括提高效率和数字化改造。文章还通过具体案例分析,展示了单