【多语言模型应用】:transformers库支持的多语言模型使用案例大解析

发布时间: 2024-09-30 17:08:26 阅读量: 9 订阅数: 13

# 1. 多语言模型的理论基础与transformers库概述

## 1.1 理论基础简介

多语言模型作为自然语言处理(NLP)领域的重要组成部分,它在理解多种语言和促进跨文化交流方面扮演着至关重要的角色。这些模型能够捕捉到不同语言间深层的语言学结构和语义信息,从而实现有效的翻译、文本生成、摘要和其他多种NLP任务。

## 1.2 模型理论的核心概念

多语言模型的理论基础主要涉及以下几个核心概念:

- **语言表示学习**:理解模型如何通过大规模语料训练,捕捉到各种语言的共性和特性。

- **上下文相关性**:了解模型如何处理和理解上下文信息,以正确地预测语言中的多义性和歧义性。

- **迁移学习**:掌握在预训练阶段学习到的知识如何被迁移到特定的下游任务中。

## 1.3 transformers库概述

transformers库是目前实现多语言模型和进行NLP任务的主流工具之一。它由Hugging Face团队开发,并且已经成为一个极为丰富的资源库,其中包含了多种预训练模型,如BERT、GPT、T5等,支持多种语言处理任务。transformers库的特点包括:

- **易用性**:通过高级API,用户可以方便地加载预训练模型,并在自定义数据上进行微调。

- **灵活性**:它提供了丰富的模型架构,适用于不同的NLP任务,从文本分类到问答系统。

- **社区支持**:transformers拥有一个活跃的开发者和用户社区,不断有新的模型和功能加入其中。

接下来,我们将会探讨如何安装和配置transformers库,以便于在各种环境中高效使用。

# 2. transformers库安装与环境配置

## 2.1 安装transformers库

### 2.1.1 官方安装指南

在安装transformers库之前,我们推荐您首先访问官方文档,了解最新和最详细的安装步骤。以下是通用的安装指南:

```bash

pip install transformers

```

上述命令适用于大多数用户,它会从PyPI安装transformers库。然而,由于transformers依赖于PyTorch或TensorFlow等深度学习框架,因此在安装之前请确保已经安装了正确的版本。

### 2.1.2 环境依赖检查

为了确保transformers库能顺利运行,您需要检查以下环境依赖是否满足:

- Python版本(推荐3.6及以上)

- 深度学习框架版本(如PyTorch或TensorFlow)

执行以下命令以检查您的Python版本:

```bash

python --version

```

接下来,根据transformers库的需要,您可能还需要安装PyTorch或TensorFlow。以下是一个示例命令,用于安装PyTorch:

```bash

pip install torch torchvision torchaudio

```

### 2.1.3 安装问题解决

如果您遇到安装问题,首先检查错误信息。常见的错误包括版本不兼容、缺少依赖库或网络问题。以下是几个常见的解决方法:

- 如果提示版本不兼容,请更新您的Python或深度学习框架。

- 如果缺少依赖库,请使用以下命令安装缺失的库:

```bash

pip install -r requirements.txt

```

- 如果遇到网络问题,可以尝试使用国内镜像源进行安装:

```bash

pip install transformers -i ***

```

## 2.2 环境配置详解

### 2.2.1 Python环境配置

Python环境是使用transformers库的基础。推荐使用Anaconda来管理Python环境,因为它可以帮助我们轻松创建、管理多个独立的Python环境。

以下是使用Anaconda创建新环境的步骤:

```bash

conda create -n transformers-env python=3.8

```

创建新环境后,您需要激活它:

```bash

conda activate transformers-env

```

然后,您可以按照之前的安装指南安装transformers库。

### 2.2.2 GPU加速设置

对于需要进行大规模训练或推理任务的用户,GPU加速是必不可少的。确保您的系统已经安装了CUDA,并根据您的GPU型号选择合适的版本。接下来,安装支持GPU加速的PyTorch版本:

```bash

pip install torch torchvision torchaudio --extra-index-url ***

```

您可以通过在Python中运行以下代码来检查PyTorch是否正确安装了GPU支持:

```python

import torch

print(torch.cuda.is_available())

```

### 2.2.3 额外依赖库安装

transformers库可能需要一些额外的依赖库来支持特定功能,例如用于自然语言处理的各种工具。以下命令将安装`nltk`和`beautifulsoup4`这两个库:

```bash

pip install nltk beautifulsoup4

```

如果您需要进行文本预处理,可能还需要安装如`punkt`等附加包:

```bash

python -m nltk.downloader punkt

```

以上就是transformers库的安装与环境配置的详细介绍。在此基础上,您将能够顺利地使用transformers库,开展您的多语言处理项目。

# 3. ```

# 第三章:多语言模型使用案例详解

## 3.1 BERT系列模型案例

### 3.1.1 中文BERT案例

在多语言自然语言处理任务中,中文BERT模型展现了其独特的魅力和强大的能力。由于中文语境的特殊性,比如没有明显的单词分隔符,与英文相比,中文的分词和词性标注等预处理步骤更为复杂。中文BERT通过预训练的掩码语言模型处理了这些问题,提供了对中文的深入理解能力。

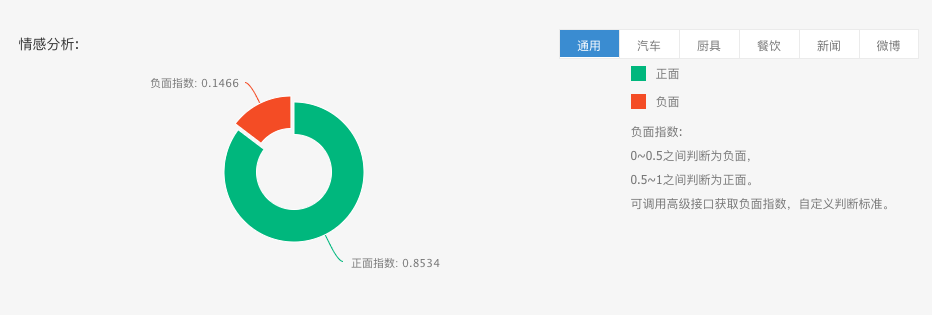

在使用中文BERT时,预训练模型通过在大量中文文本上学习到深层的语言表征。这些表征可以捕捉到词义、句法乃至文本级别的语义信息。在特定的任务上,比如情感分析、命名实体识别或问答系统,我们可以通过在特定数据集上进行微调,以适应特定任务。

以下是使用中文BERT的一个简单示例:

```python

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 初始化模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

# 编码输入文本

input_text = "我非常喜欢这部电影。"

input_ids = torch.tensor([tokenizer.encode(input_text, add_special_tokens=True)])

# 预测结果

with torch.no_grad():

outputs = model(input_ids)

predictions = torch.argmax(outputs.logits, dim=1)

print(predictions)

```

在这段代码中,首先导入了BERT模型和分词器,并从预训练的BERT模型中加载了模型权重和分词器字典。然后将输入文本编码为模型所需的ID格式,输入模型并得到预测结果。这个例子展示了如何使用BERT模型进行文本分类任务。

### 3.1.2 多语言BERT案例

多语言BERT(mBERT)是在多种语言的维基百科文本上进行预训练的BERT模型。不同于单语BERT模型,mBERT旨在捕捉跨语言的通用语言特征,并能够更好地处理语言间迁移学习的场景。

使用mBERT进行文本分类任务的一个例子如下:

```python

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 加载分词器和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-multilingual-cased')

model = BertForSequenceClassification.from_pretrained('bert-base-multilingual-cased')

# 示例文本

input_text = "Je suis très content de ce film."

inputs = tokenizer(input_text, return_tensors="pt")

# 模型前向传播

outputs = model(**inputs)

logits = outputs.logits

# 预测结果

predictions = torch.ar

0

0