【集成最新研究进展】:transformers库与最新NLP研究结合指南

发布时间: 2024-09-30 17:25:10 阅读量: 3 订阅数: 13

# 1. transformers库概述

transformers库是现代自然语言处理(NLP)技术的重要组成部分,它是一个开源库,为NLP任务提供了强大的工具,如BERT、GPT和T5等预训练模型。这些模型已在各种NLP任务中取得了突破性成果。transformers库通过封装深度学习算法和预训练模型,使研究者和开发人员能够轻松实现复杂的NLP应用,从文本分类到问答系统,再到机器翻译。

本章节旨在为读者提供transformers库的入门知识,包括其架构、关键概念及其与NLP任务的关联。我们将简要介绍如何安装transformers库并执行简单的文本处理任务,为后续更深入的讨论打下基础。

## 安装transformers库

安装transformers库非常简单。您可以使用pip命令轻松进行安装:

```bash

pip install transformers

```

一旦安装完成,您就可以开始使用transformers库提供的各种功能了。接下来我们用transformers库中的预训练模型来完成一个基础的文本分类任务,以此引入库的使用方法。

## 示例:使用transformers进行文本分类

```python

from transformers import pipeline

# 初始化文本分类器

classifier = pipeline("sentiment-analysis")

# 对文本进行分类

result = classifier("I love using the transformers library!")

# 输出分类结果

print(result)

```

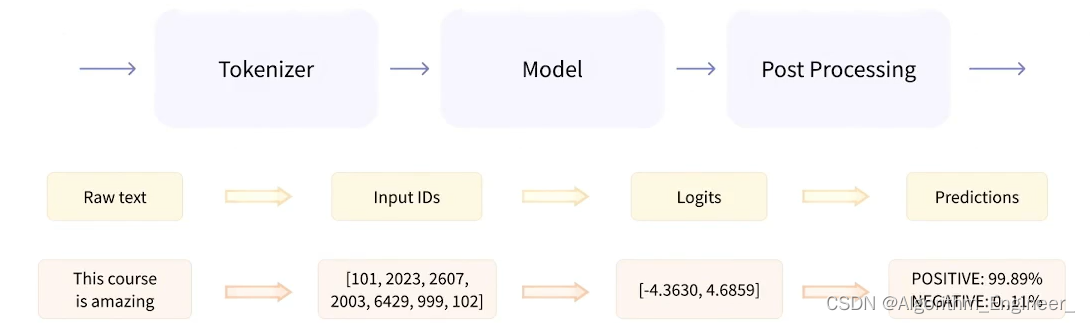

上述示例中,我们用`pipeline`方法快速地创建了一个情感分析的文本分类器,并对一条积极情绪的文本进行了情感倾向的判断。通过这一简单的例子,我们可以感受到transformers库的强大功能和便捷性,这为我们的NLP之旅提供了一个良好的开端。

# 2. NLP基础理论与transformers库的实践

### 2.1 NLP基础概念回顾

#### 2.1.1 语言模型与文本表示

自然语言处理(NLP)中,语言模型是理解文本的核心。一个语言模型可以定义为一个概率分布,它能够预测一段文本序列的下一个单词出现的概率。在深度学习领域,语言模型通常通过神经网络来构建,其中transformers库扮演着关键角色。

文本表示方法经历了从简单的词袋模型(Bag of Words)到更复杂的词嵌入(Word Embeddings)如Word2Vec和GloVe,再到BERT、GPT等预训练语言模型的演进。这些模型通过深度学习捕捉语境信息和词义关系,极大提高了NLP任务的性能。

```python

import numpy as np

def build LANGUAGE MODEL(data, vocabulary_size):

"""

简单构建语言模型函数

参数:

data -- 训练文本数据

vocabulary_size -- 词汇表大小

返回:

language_model -- 语言模型

"""

# 初始化词汇表出现次数

vocabulary_count = np.zeros(vocabulary_size, dtype=int)

for word in data:

vocabulary_count[word] += 1

vocabulary_probability = vocabulary_count / np.sum(vocabulary_count)

language_model = {

'vocabulary_count': vocabulary_count,

'vocabulary_probability': vocabulary_probability

}

return language_model

# 示例使用构建的语言模型

# 假设vocabulary_size是词汇表的大小,data是训练数据

language_model = build_LANGUAGE_MODEL(data, vocabulary_size)

```

在上面的代码中,我们创建了一个非常基础的语言模型。这个模型考虑了每个单词出现的频率,然后用这个频率来表示单词的出现概率。尽管这是一个简化的例子,它展示了构建语言模型的基础逻辑。现代的深度学习模型使用更复杂的技术来生成概率分布。

#### 2.1.2 自然语言处理的历史与现状

NLP的发展历史可以追溯到上世纪50年代,经历了符号主义和统计学方法的尝试,直到深度学习的兴起,才真正实现了跨越式的进步。目前,NLP的现状是深度学习模型如transformers统治了各个NLP任务,它们通过预训练和微调的方式,在各种语言处理任务上取得了突破性的表现。

从2018年的BERT到现在的GPT-3,NLP领域见证了预训练语言模型的快速发展。这些模型在大规模语料库上预训练,通过学习语言的深层规律,实现对下游任务的高效微调,显著提升了模型的泛化能力。

### 2.2 transformers库的组件解析

#### 2.2.1 编码器(Encoder)结构详解

编码器是transformers库中的核心组件之一,它主要负责将输入的文本信息转换为编码表示。编码器由多层结构组成,每层包含两个子层:多头自注意力(Multi-Head Attention)机制和前馈神经网络(Feed-Forward Neural Network)。

多头自注意力机制允许模型在序列的不同位置同时聚焦,捕捉长距离依赖关系,这对于理解文本的语境至关重要。前馈神经网络则作为每一层的第二部分,负责处理和变换数据。

```python

class EncoderLayer(nn.Module):

def __init__(self, d_model, num_heads):

super(EncoderLayer, self).__init__()

self.self_attention = MultiHeadAttention(d_model, num_heads)

self.feed_forward = PositionwiseFeedForward(d_model)

def forward(self, x):

x = self.self_attention(x, x, x)

return self.feed_forward(x)

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super(MultiHeadAttention, self).__init__()

# 初始化多头注意力层

# 参数包括模型维度d_model和头数num_heads

def forward(self, query, key, value):

# 实现多头注意力机制

# 返回处理后的输出

class PositionwiseFeedForward(nn.Module):

def __init__(self, d_model):

super(PositionwiseFeedForward, self).__init__()

# 初始化前馈神经网络层

def forward(self, x):

# 实现前馈神经网络的前向传播

return x

```

通过上述代码展示了transformers库中编码器层的基本结构。`MultiHeadAttention`、`PositionwiseFeedForward`分别代表了多头自注意力机制和前馈神经网络。代码提供了这些组件如何组合在一起的直观理解。

#### 2.2.2 解码器(Decoder)结构详解

解码器的主要作用是基于编码器的输出进行解码,生成最终的序列。它同样由多层结构组成,每一层包含三个子层:第一个子层是掩码多头自注意力(Masked Multi-Head Attention),第二个是编码器-解码器注意力(Encoder-Decoder Attention),第三个是前馈神经网络。

掩码多头自注意力机制确保了在生成序列时,模型不会"偷看"未来的单词。编码器-解码器注意力层允许解码器关注编码器输出的特定部分,有助于解码器更好地理解输入上下文。

```python

class DecoderLayer(nn.Module):

def __init__(self, d_model, num_heads):

super(DecoderLayer, self).__init__()

self.masked_attention = MultiHeadAttention(d_model, num_heads)

self.encoder_attention = MultiHeadAttention(d_model, num_heads)

self.feed_forward = PositionwiseFeedForward(d_model)

def forward(self, x, enc_output):

x = self.masked_attention(x, x, x)

x = self.encoder_attention(x, enc_output, enc_output)

return self.feed_forward(x)

class Decoder(nn.Module):

def __init__(self, d_model, num_heads):

super(Decoder, self).__init__()

self.decoder_layer = DecoderLayer(d_model, num_heads)

def forward(self, x, enc_output):

return self.decoder_layer(x, enc_output)

```

上述代码片段展示了transformers解码器层的基本架构。`DecoderLayer`包含了解码器层的三个子层,`Decoder`将这些层组合起来执行整个解码过程。代码的逻辑分析和参数说明提供了对解码器层具体工作的深入理解。

#### 2.2.3 注意力机制(Attention)原理

注意力机制是transformers库的核心,它赋予模型在处理数据时"注意"不同部分的能力。注意力权重表明了在生成输出时,模型应该对输入序列中的哪些部分赋予更多的注意力。

基本的注意力机制可以表示为一个权重矩阵,通过这个矩阵,模型可以学习输入序列中不同位置之间的依赖关系。这在处理自然语言时非常有效,因为语言中的单词往往与文本中的其他单词存在某种联系。

```python

class ScaledDotProductAttention(nn.Module):

def forward(self, Q, K, V):

# Scaled dot-product attention计算

# 返回加权的V值

pass

class MultiHeadAttention(nn.Module):

def __init__(self, d_model, num_heads):

super(MultiHeadAttention, self).__init__()

# Multi-head attention初始化

# 参数包括模型维度d_model和头数num_heads

def forward(self, Q, K, V):

# Multi-head attention前向传播

return self.output

```

在上面的代码示例中,`ScaledDotProductAttention`负责实现缩放的点积注意力机制,而`MultiHeadAttention`利用这个机制实现多头注意力。这段代码展示了注意力机制在transformers中的实现方式,并在逻辑上进行了解释。

### 2.3 从理论到实践:实现基础NLP任务

#### 2.3.1 文本分类任务

文本分类是NLP中的基本任务之一,transformers库使得构建高性能的文本分类模型变得简单高效。一个典型的文本分类任务包括将一段文本分配到一个或多个预定义的类别中。

transformers库提供了BERT、RoBERTa等预训练模型,可以直接用于文本分类任务,通过在特定数据集上进行微调(fine-tuning),可以快速构建出效果卓越的分类器。

```python

from transformers import BertTokenizer, BertForSequenceClassification

from transformers import Trainer, TrainingArguments

# 加载预训练模型和分词器

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 准备数据集

train_dataset = load_dataset_function('your_dataset')

# 微调模型

training_args = Traini

```

0

0