首页

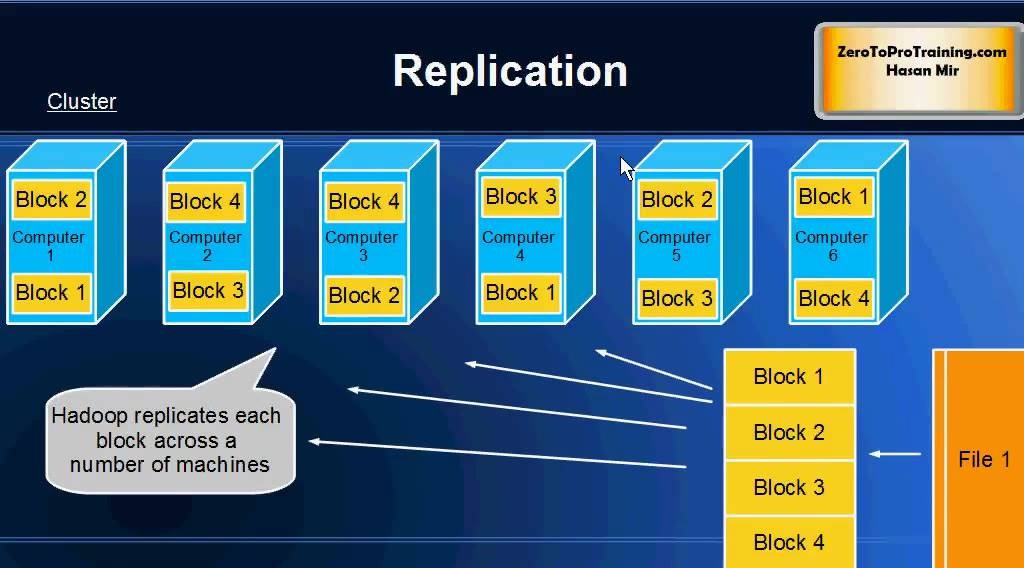

4节点的HDFS,存储5G文件,需要多少空间?75g默认大小1G

4节点的HDFS,存储5G文件,需要多少空间?75g默认大小1G

时间: 2024-06-04 15:13:32

浏览: 185

根据HDFS的副本机制,默认情况下会存储3个副本,因此需要的总空间为5G × 3 = 15G。而每个副本的大小为1G,默认情况下每个数据块的大小也是1G,因此一个5G的文件会被分成5个数据块,每个数据块存储在不同的节点上。因此,对于4个节点的HDFS,每个节点需要存储5G × 3 ÷ 4 = 3.75G的数据。

阅读全文

相关推荐

跨HDFS集群的高效文件资源分布式存储策略

数据块是文件的基本存储单元,名字节点负责全局命名空间管理和元数据存储,数据节点则是实际存储数据的地方。客户端负责用户的文件操作请求,而通信协议则确保节点间的通信高效稳定。 文章首先分析了这些特征并深入...

华为Uma Maheshwara Rao G探讨HDFS NameNode的高可用性关键技术

在2012年的HBTC会议上,来自华为电信与核心网产品线BigData团队的架构师Uma Maheshwara Rao G,以其深厚的专业背景和丰富的HDFS开发经验,分享了关于HDFS Name Node高可用性的深入研究。作为HDFS的核心设计者之一,...

SQL-DFS:优化HDFS小文件存储的解决方案

在HDFS的默认设置下,存储大量小文件会导致NameNode的内存占用率急剧增加,因为NameNode需要维护所有文件的元数据。为解决这一问题,SQL-DFS引入了元数据存储集群的概念,将小文件的元数据从NameNode的内存中移出,...

云存储及云计算使用(运维).docx

1. 读写性能和数据安全:Hadoop通过HDFS(Hadoop Distributed File System)提供高容错性的分布式存储,支持快速的读写操作。然而,数据安全性是其关注的重点,通过副本机制保证数据冗余,但同时也可能导致较高的...

掌握UXM-5G:打造无缝5G用户体验的7大策略

本文综合分析了5G网络架构的关键特性,如高带宽、低延迟和网络切片技术,并探讨了影响用户体验的重要因素,包括信号覆盖、连接稳定性、安全性和隐私保护。通过提出优化网络性能、个性化用户体验设计和多维度监控的...

大规模集群挑战:HDFS如何应对容错性能问题

![大规模集群挑战:HDFS如何...Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件之一,它是为存储大型数据集设计的可扩展且高可靠的分布式文件系统。其设计目标是能够跨越廉价的商用硬件存储大量数据,同时保证高

数据均衡术:保持HDFS集群性能与容错的平衡

在大数据时代,Hadoop分布式文件系统(HDFS)是构建大规模数据存储解决方案的核心组件。HDFS集群作为高可用、分布式存储系统,支持高度容错的能力,特别适用于拥有大量数据的分布式应用环境。 ## 1.1 HDFS的基本...

HDFS副本策略调整先决条件:如何进行数据重要性评估

# 1. 数据重要性评估的基础概念 数据是现代企业运营的核心,但在深入分析和应用之前,评估数据的重要性是至关重要的第一步。在本章节中,我们将探索数据重要性评估的核心概念,解释为什么这一过程对于任何数据驱动...

HDFS心跳机制的负载均衡策略:任务合理分配提升集群效率的法宝

![HDFS心跳机制的负载均衡策略:任务合理分配...Hadoop分布式文件系统(HDFS)中,心跳机制是监控和维护集群状态的重要手段。各个节点通过定期发送心跳信号给主节点NameNode和数据节点DataNode,以证明它们的存活状态和

Linux存储解决方案:RAID到分布式文件系统的全面解析

# 1. Linux存储基础知识 在当今IT行业中,Linux操作系统是服务器和存储解决方案中的重要一环。为了有效地管理和部署存储资源,掌握Linux存储的基础知识是必不可少的。本章将带您从Linux存储基础开始,深入探讨存储...

Linux文件系统揭秘:Ubuntu 14.04文件系统管理的内行知识

![Linux文件系统]...# 1. Linux文件系统概述 Linux操作系统的一大特色在于其灵活且功能强大的文件系统。在Linux中,一切皆文件,这意味着硬件设备、系统资源以及网络连接

JBACI文件系统解码:深入剖析文件系统原理与优化技巧!

![JBACI文件系统解码:深入剖析文件系统原理与优化技巧!]...在当今IT环境中,文件系统作为存储管理的基础,其效率和稳定性对整个系统性能至关重要。J

【文件系统性能调整】:选择与优化文件系统,提升速度

在IT系统中,文件系统扮演着数据存储和管理的关键角色。随着数据量的不断增长和技术的发展,文件系统的性能调整成为提升系统整体效率的重要环节。本章节首先介绍文件系统性能调整的重要性,并概述性能调整的几个核心...

scp命令性能测试:大数据文件传输与调优

# 1. scp命令基础与大数据传输概述 ## 1.1 scp命令简介 scp(secure copy)是一个用于在Linux和Unix系统之间安全地复制文件和目录的命令行工具。它利用SSH协议确保数据传输过程的安全性。 scp命令适用于不同主机...

大文件问题分析与解决方案:MapReduce专家观点

...大文件处理问题不仅仅局限于文件的物理存储,它还涉及到数据的读取、写入、处理等多

【批量大小与分布式系统】:扩展性挑战的解决方案

# 摘要 本文全面探讨了消息队列在PHP环境下的基础...

【云计算中的移动存储】:云服务中优化移动存储角色的策略

!... # 摘要 本文对云计算中移动存储技术进行了全面的...最后,本文针对移动存储技术面临的挑战,提出了可扩展性、数据一致性和可靠性等方面的解决方案,并给出了对企业和用户的建议,以期为移动存储技术的研究和应用提

大数据采集与存储技术的发展

# 1. 引言 ## 1.1 背景介绍 在当今信息爆炸的时代,数据成为了我们生活中不可或缺的一部分。随着互联网的普及和技术的进步,大量的数据被产生并积累起来。而这些数据中蕴含着丰富的信息和价值,对于个人、企业乃至...

CSDN会员

开通CSDN年卡参与万元壕礼抽奖

海量

VIP免费资源

千本

正版电子书

商城

会员专享价

千门

课程&专栏

全年可省5,000元

立即开通

全年可省5,000元

立即开通

大家在看

yolo开发人工智能小程序经验和总结.zip

yolo开发人工智能小程序经验和总结.zipyolo开发人工智能小程序经验和总结.zipyolo开发人工智能小程序经验和总结.zipyolo开发人工智能小程序经验和总结.zip

USB_HUB硬件电路引脚原理解析.docx

USB_HUB硬件电路引脚原理解析,与个人博文一致,这是word版本。 USB_HUB硬件电路引脚原理解析,与个人博文一致,这是word版本。

Keysight N6705C直流电源分析仪.pdf

Keysight N6705C直流电源分析仪

AS400 自学笔记集锦

AS400 自学笔记集锦 AS400学习笔记(V1.2) 自学使用的400操作命令集锦

LQR与PD控制在柔性机械臂中的对比研究

LQR与PD控制在柔性机械臂中的对比研究,路恩,杨雪锋,针对单杆柔性机械臂末端位置控制的问题,本文对柔性机械臂振动主动控制中较为常见的LQR和PD方法进行了控制效果的对比研究。首先,�

最新推荐

Python连接HDFS实现文件上传下载及Pandas转换文本文件到CSV操作

标题中的知识点主要涉及Python连接HDFS进行文件上传下载以及Pandas转换文本文件到CSV的操作。在描述中,提到了Python在Linux环境下与HDFS交互的需求,以及使用Pandas进行数据处理的场景。从标签中我们可以进一步了解...

python读取hdfs上的parquet文件方式

Python 读取 HDFS 上的 Parquet 文件是大数据分析和机器学习中常见的操作。Parquet 是一种列式存储格式,适合大规模数据处理,因为它能够高效地处理结构化数据。HDFS(Hadoop Distributed File System)是分布式文件...

HDFS文件系统基本文件命令、编程读写HDFS

HDFS 文件系统基本文件命令、编程读写 HDFS HDFS(Hadoop Distributed File System)是一种分布式文件系统,用于存储和管理大规模数据。它是 Hadoop 云计算平台的核心组件之一,提供了高效、可靠、可扩展的数据存储...

第二章 分布式文件系统HDFS+MapReduce(代码实现检查文件是否存在&WordCount统计).docx

【分布式文件系统HDFS】 Hadoop Distributed File System (HDFS) 是Apache Hadoop项目的核心组件之一,设计用于存储和处理大规模数据。HDFS是一种高度容错性的分布式文件系统,能够在廉价硬件上运行,能够自动处理...

HDFS管理工具HDFS Explorer下载地址、使用方法.docx

在Hadoop集群中,为了使HDFS Explorer能够通过WebHDFS接口访问HDFS,需要在Hadoop的配置文件`hdfs-site.xml`中启用WebHDFS服务。为此,你需要添加以下配置: ```xml <name>dfs.webhdfs.enabled <value>true ...

HTML挑战:30天技术学习之旅

资源摘要信息: "desafio-30dias" 标题 "desafio-30dias" 暗示这可能是一个与挑战或训练相关的项目,这在编程和学习新技能的上下文中相当常见。标题中的数字“30”很可能表明这个挑战涉及为期30天的时间框架。此外,由于标题是西班牙语,我们可以推测这个项目可能起源于或至少是针对西班牙语使用者的社区。标题本身没有透露技术上的具体内容,但挑战通常涉及一系列任务,旨在提升个人的某项技能或知识水平。 描述 "desafio-30dias" 并没有提供进一步的信息,它重复了标题的内容。因此,我们不能从中获得关于项目具体细节的额外信息。描述通常用于详细说明项目的性质、目标和期望成果,但由于这里没有具体描述,我们只能依靠标题和相关标签进行推测。 标签 "HTML" 表明这个挑战很可能与HTML(超文本标记语言)有关。HTML是构成网页和网页应用基础的标记语言,用于创建和定义内容的结构、格式和语义。由于标签指定了HTML,我们可以合理假设这个30天挑战的目的是学习或提升HTML技能。它可能包含创建网页、实现网页设计、理解HTML5的新特性等方面的任务。 压缩包子文件的文件名称列表 "desafio-30dias-master" 指向了一个可能包含挑战相关材料的压缩文件。文件名中的“master”表明这可能是一个主文件或包含最终版本材料的文件夹。通常,在版本控制系统如Git中,“master”分支代表项目的主分支,用于存放项目的稳定版本。考虑到这个文件名称的格式,它可能是一个包含所有相关文件和资源的ZIP或RAR压缩文件。 结合这些信息,我们可以推测,这个30天挑战可能涉及了一系列的编程任务和练习,旨在通过实践项目来提高对HTML的理解和应用能力。这些任务可能包括设计和开发静态和动态网页,学习如何使用HTML5增强网页的功能和用户体验,以及如何将HTML与CSS(层叠样式表)和JavaScript等其他技术结合,制作出丰富的交互式网站。 综上所述,这个项目可能是一个为期30天的HTML学习计划,设计给希望提升前端开发能力的开发者,尤其是那些对HTML基础和最新标准感兴趣的人。挑战可能包含了理论学习和实践练习,鼓励参与者通过构建实际项目来学习和巩固知识点。通过这样的学习过程,参与者可以提高在现代网页开发环境中的竞争力,为创建更加复杂和引人入胜的网页打下坚实的基础。

【CodeBlocks精通指南】:一步到位安装wxWidgets库(新手必备)

# 摘要 本文旨在为使用CodeBlocks和wxWidgets库的开发者提供详细的安装、配置、实践操作指南和性能优化建议。文章首先介绍了CodeBlocks和wxWidgets库的基本概念和安装流程,然后深入探讨了CodeBlocks的高级功能定制和wxWidgets的架构特性。随后,通过实践操作章节,指导读者如何创建和运行一个wxWidgets项目,包括界面设计、事件

andorid studio 配置ERROR: Cause: unable to find valid certification path to requested target

### 解决 Android Studio SSL 证书验证问题 当遇到 `unable to find valid certification path` 错误时,这通常意味着 Java 运行环境无法识别服务器提供的 SSL 证书。解决方案涉及更新本地的信任库或调整项目中的网络请求设置。 #### 方法一:安装自定义 CA 证书到 JDK 中 对于企业内部使用的私有 CA 颁发的证书,可以将其导入至 JRE 的信任库中: 1. 获取 `.crt` 或者 `.cer` 文件形式的企业根证书; 2. 使用命令行工具 keytool 将其加入 cacerts 文件内: ```

VC++实现文件顺序读写操作的技巧与实践

资源摘要信息:"vc++文件的顺序读写操作" 在计算机编程中,文件的顺序读写操作是最基础的操作之一,尤其在使用C++语言进行开发时,了解和掌握文件的顺序读写操作是十分重要的。在Microsoft的Visual C++(简称VC++)开发环境中,可以通过标准库中的文件操作函数来实现顺序读写功能。 ### 文件顺序读写基础 顺序读写指的是从文件的开始处逐个读取或写入数据,直到文件结束。这与随机读写不同,后者可以任意位置读取或写入数据。顺序读写操作通常用于处理日志文件、文本文件等不需要频繁随机访问的文件。 ### VC++中的文件流类 在VC++中,顺序读写操作主要使用的是C++标准库中的fstream类,包括ifstream(用于从文件中读取数据)和ofstream(用于向文件写入数据)两个类。这两个类都是从fstream类继承而来,提供了基本的文件操作功能。 ### 实现文件顺序读写操作的步骤 1. **包含必要的头文件**:要进行文件操作,首先需要包含fstream头文件。 ```cpp #include <fstream> ``` 2. **创建文件流对象**:创建ifstream或ofstream对象,用于打开文件。 ```cpp ifstream inFile("example.txt"); // 用于读操作 ofstream outFile("example.txt"); // 用于写操作 ``` 3. **打开文件**:使用文件流对象的成员函数open()来打开文件。如果不需要在创建对象时指定文件路径,也可以在对象创建后调用open()。 ```cpp inFile.open("example.txt", std::ios::in); // 以读模式打开 outFile.open("example.txt", std::ios::out); // 以写模式打开 ``` 4. **读写数据**:使用文件流对象的成员函数进行数据的读取或写入。对于读操作,可以使用 >> 运算符、get()、read()等方法;对于写操作,可以使用 << 运算符、write()等方法。 ```cpp // 读取操作示例 char c; while (inFile >> c) { // 处理读取的数据c } // 写入操作示例 const char *text = "Hello, World!"; outFile << text; ``` 5. **关闭文件**:操作完成后,应关闭文件,释放资源。 ```cpp inFile.close(); outFile.close(); ``` ### 文件顺序读写的注意事项 - 在进行文件读写之前,需要确保文件确实存在,且程序有足够的权限对文件进行读写操作。 - 使用文件流进行读写时,应注意文件流的错误状态。例如,在读取完文件后,应检查文件流是否到达文件末尾(failbit)。 - 在写入文件时,如果目标文件不存在,某些open()操作会自动创建文件。如果文件已存在,open()操作则会清空原文件内容,除非使用了追加模式(std::ios::app)。 - 对于大文件的读写,应考虑内存使用情况,避免一次性读取过多数据导致内存溢出。 - 在程序结束前,应该关闭所有打开的文件流。虽然文件流对象的析构函数会自动关闭文件,但显式调用close()是一个好习惯。 ### 常用的文件操作函数 - `open()`:打开文件。 - `close()`:关闭文件。 - `read()`:从文件读取数据到缓冲区。 - `write()`:向文件写入数据。 - `tellg()` 和 `tellp()`:分别返回当前读取位置和写入位置。 - `seekg()` 和 `seekp()`:设置文件流的位置。 ### 总结 在VC++中实现顺序读写操作,是进行文件处理和数据持久化的基础。通过使用C++的标准库中的fstream类,我们可以方便地进行文件读写操作。掌握文件顺序读写不仅可以帮助我们在实际开发中处理数据文件,还可以加深我们对C++语言和文件I/O操作的理解。需要注意的是,在进行文件操作时,合理管理和异常处理是非常重要的,这有助于确保程序的健壮性和数据的安全。

【大数据时代必备:Hadoop框架深度解析】:掌握核心组件,开启数据科学之旅

# 摘要 Hadoop作为一个开源的分布式存储和计算框架,在大数据处理领域发挥着举足轻重的作用。本文首先对Hadoop进行了概述,并介绍了其生态系统中的核心组件。深入分