大模型迁移学习指南:跨域应用的艺术与实践

C++类构造与析构机制详解:掌握对象生命周期管理核心技术

1. 迁移学习与大模型的基础知识

简介

迁移学习是一种机器学习方法,它利用一个领域或任务获得的知识来帮助解决另一个不同但相关的领域或任务。随着机器学习技术的发展,特别是深度学习的兴起,迁移学习已经成为提高模型性能、减少计算资源消耗的有效途径。

迁移学习的定义

迁移学习(Transfer Learning)是指将从一个任务(源任务)学到的知识应用到另一个任务(目标任务)的过程。源任务和目标任务通常在某些方面是相似的,但又有所差异。这种知识的迁移可以在模型训练之前(基于实例的迁移)、训练中(基于特征的迁移)或训练后(基于模型参数的迁移)进行。

大模型与迁移学习的关系

在大模型(如BERT、GPT等)的背景下,迁移学习变得更加重要。由于大模型通常需要大量的数据和计算资源进行训练,直接从零开始训练大模型往往是不切实际的。通过迁移学习,我们可以将预训练的大型模型应用到数据量较小的任务上,只需进行少量的微调(fine-tuning)即可达到较好的效果。这种方式不仅减少了计算资源的消耗,也缩短了模型的训练时间。

2. 迁移学习的关键理论和方法

2.1 迁移学习的核心概念

迁移学习是指将从一个任务学习到的知识应用到另一个相关但不同的任务的过程。这种方法在机器学习领域尤为重要,因为许多任务的标注数据稀缺或者成本高昂,直接从头开始训练模型并非总是可行。

2.1.1 传统机器学习中的迁移学习

在传统机器学习中,迁移学习通常涉及两个阶段:源任务学习和目标任务迁移。源任务通常拥有大量标注数据,而目标任务数据较少。通过从源任务学习到的特征表示或模型参数来初始化目标任务,可以显著减少目标任务所需的训练数据量,提高模型泛化能力。

2.1.2 大模型在迁移学习中的优势

大模型,尤其是深度神经网络,因其能够学习复杂的数据表示,已经成为迁移学习的一个关键工具。大模型由于参数众多,可以捕捉到更加抽象和通用的特征,因此在迁移到新任务时往往能够获得更好的性能。不过,随之而来的是过拟合的风险和计算成本的增加,这要求我们在实践中要精心设计迁移学习策略。

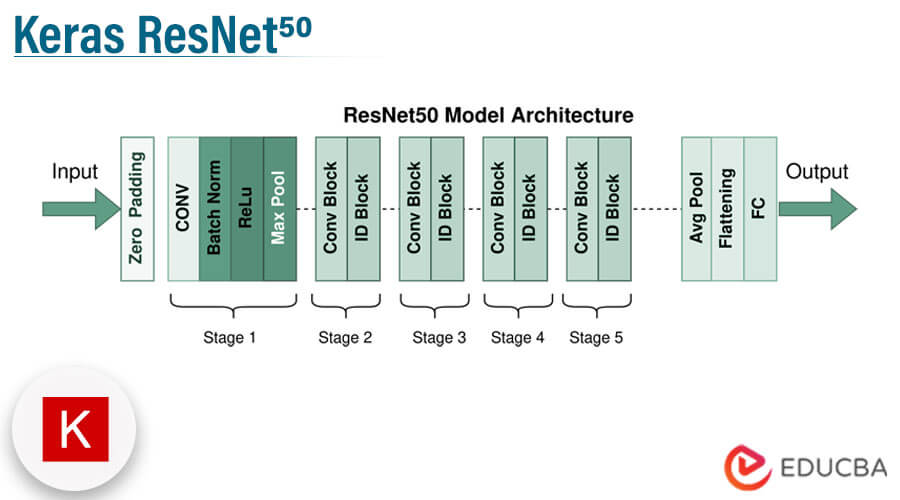

2.1.3 应用实例:图像识别任务的迁移

以图像识别任务为例,一个在ImageNet数据集上训练好的深度卷积神经网络可以很好地识别成千上万种物体。如果要将这个模型迁移到一个新的图像分类任务中,如医学图像分析,可以通过迁移网络的低层特征(比如边缘和纹理检测器)和高层特征(比如复杂物体的部分),结合新任务的小型标注数据集进行微调,以适应新任务。

2.2 迁移学习的主要方法论

2.2.1 实例迁移、特征提取与模型微调

实例迁移是指直接迁移训练好的模型实例到新的任务。特征提取则是在源任务上训练模型,然后仅使用模型的中间层特征来训练目标任务的分类器。模型微调是指在特征提取的基础上,进一步微调整个模型或部分模型的权重以适应新任务。

2.2.2 多任务学习与领域自适应

多任务学习是将多个相关任务一起学习,模型共享某些层或模块,以期望模型在所有任务上都表现更好。领域自适应专注于处理源领域和目标任务领域数据分布不一致的问题,通过领域对齐技术使源模型更好地泛化到目标任务上。

2.3 迁移学习中的度量学习与对齐

2.3.1 度量学习的原理和应用

度量学习旨在学习一个有效的距离度量函数,使得同类数据的相似度高,不同类数据的相似度低。在迁移学习中,度量学习可以帮助识别源任务和目标任务之间的相似性和差异性,从而更好地引导知识迁移。

2.3.2 领域对齐的技术和策略

领域对齐技术包括统计方法、领域适应技术和对抗训练等,旨在减少源领域和目标任务领域之间的分布差异。通过对齐技术的应用,模型能够更好地在源领域学到的知识迁移到目标任务中。

2.3.3 实现领域对齐的实例

一个具体实例是在多源领域自适应设置中,使用对抗网络来实现领域对齐。例如,在图像识别任务中,假设源领域包含了多种天气条件下的车辆图片,而目标任务则是某种特定天气条件下的车辆图片。通过构建一个鉴别器来判断数据样本是否来源于目标任务领域,并在模型训练过程中让特征提取器与鉴别器进行对抗,以期达到特征空间上的领域对齐。

2.3.4 领域对齐技术的挑战

尽管领域对齐技术在实践中已经取得了一定成效,但是它仍然面临着挑战。比如,如何确定最佳的对齐策略、如何评估对齐效果以及如何在保持模型泛化能力的同时最大化迁移效率等。

在这一章节中,我们详细探讨了迁移学习中的关键理论和方法,从核心概念到主要方法论,再到度量学习与对齐技术的应用和挑战。在后续章节中,我们将深入到具体实践案例分析和模型调优与评估,以期为读者提供一个全面而深入的理解。

3. 大模型迁移学习的实践案例分析

3.1 NLP领域的迁移学习应用

3.1.1 文本分类任务的迁移策略

迁移学习在自然语言处理(NLP)领域有广泛的应用,其中一个主要应用是在文本分类任务中。文本分类是将文本数据分配到不同的类别中,常见的应用场景包括垃圾邮件过滤、情感分析、新闻分类等。

在迁移学习框架下,训练数据和测试数据通常来自不同的分布,这种情况下,可以使用预训练的大模型,如BERT、GPT或RoBERTa,作为特征提取器或微调模型。以BERT为例,它的预训练任务是掩码语言模型(Masked Language Model, MLM)和下一个句子预测(Next Sentence Prediction, NSP),这使得BERT能够捕捉丰富的文本语境信息。

以下是使用BERT进行文本分类任务的基本步骤:

- 加载预训练的BERT模型和对应的分词器(tokenizer)。

- 准备你的文本数据,并使用分词器将其转换为BERT能够理解的格式。

- 选择一个适合任务的微调策略,例如全微调或仅微调顶部的几层。

- 在一个有标签的文本分类数据集上训练模型。

- 使用训练好的模型进行文本分类。

具体的代码块如下:

- from transformers import BertTokenizer, BertForSequenceClassification

- import torch

- # 初始化分词器和模型

- tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

- model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

- # 准备输入数据

- inputs = tokenizer("Here is the sentence I want to encode", return_tensors="pt")

- outputs = model(**