数据预处理在时间序列预测中的黄金法则

发布时间: 2025-01-09 05:08:20 阅读量: 6 订阅数: 12

时间序列预测天气数据

# 摘要

数据预处理与时间序列预测是数据科学和统计学中的关键环节。本文首先介绍了数据预处理的理论基础,包括数据清洗、转换、集成和融合的关键技术。接着,详细探讨了时间序列特征工程,涉及特征提取技巧、时间窗口构建以及数据分解与重构方法。随后,文章阐述了时间序列预测模型的预处理步骤,包括输入数据的准备与处理、模型选择与超参数调优,以及预测结果的评估与后处理。最后,通过综合应用案例分析,本文展示了实时数据流的预处理流程设计以及复杂环境下时间序列分析的应用,特别是经济指标的预测与应用,为相关领域提供了一套完整的理论与实践框架。

# 关键字

数据预处理;时间序列预测;特征工程;模型调优;实时数据流;经济指标

参考资源链接:[Transformer在时序预测中的应用:ConvTrans算法解析](https://wenku.csdn.net/doc/7pa18zquui?spm=1055.2635.3001.10343)

# 1. 数据预处理与时间序列预测概论

在现代数据分析中,时间序列预测是一种常见的方法,用于预测未来时间点的数据值。准确地进行时间序列预测需要高质量的数据和精密的算法。本章将概览数据预处理与时间序列预测的基本概念、方法以及它们在各种场景下的应用。

时间序列预测不仅仅是简单的统计分析,它涉及到数据挖掘、机器学习甚至深度学习的诸多先进技术。从基础的移动平均和自回归积分滑动平均模型(ARIMA),到复杂的长短期记忆网络(LSTM)和卷积神经网络(CNN),在众多工具和算法中,选择合适的模型并进行有效的数据预处理是达成可靠预测的关键。

在接下来的章节中,我们将详细介绍数据预处理的理论和实践,包括数据清洗、转换、集成等策略,以及时间序列特征工程的具体技巧,为深入学习时间序列预测打下坚实的基础。

# 2. 数据预处理的理论基础

数据预处理是数据分析和预测模型建立中不可或缺的步骤。一个良好设计的数据预处理流程可以显著提高模型的准确度和效率。在本章中,我们将探讨数据预处理的不同理论和技术,以确保数据的质量与可用性。

### 2.1 数据清洗的重要性与方法

#### 2.1.1 缺失数据的处理

在现实世界的数据集中,缺失数据是常见问题之一。缺失数据不仅降低了数据的可用性,还可能引入偏见,影响分析结果。处理缺失数据的主要方法包括:

- 删除缺失数据:如果缺失数据的比例较低,可以考虑直接删除含有缺失值的记录。

- 数据填充:使用统计方法填充缺失值,例如,可以用均值、中位数或众数替代缺失数值。

- 数据插值:对于时间序列数据,可以使用插值方法来估计缺失值,如线性插值或多项式插值。

```python

import numpy as np

import pandas as pd

# 示例数据集,含有缺失值

data = pd.DataFrame({

'A': [1, 2, np.nan, 4],

'B': [5, np.nan, np.nan, 8],

'C': [9, 10, 11, 12]

})

# 用均值填充缺失值

data_filled = data.fillna(data.mean())

print(data_filled)

```

在代码中,我们创建了一个含有缺失值的`pandas` DataFrame,并用均值填充了这些空缺。这是一个简单而广泛使用的填充策略,但实际应用中可能需要根据数据的特征和缺失模式选择最合适的方法。

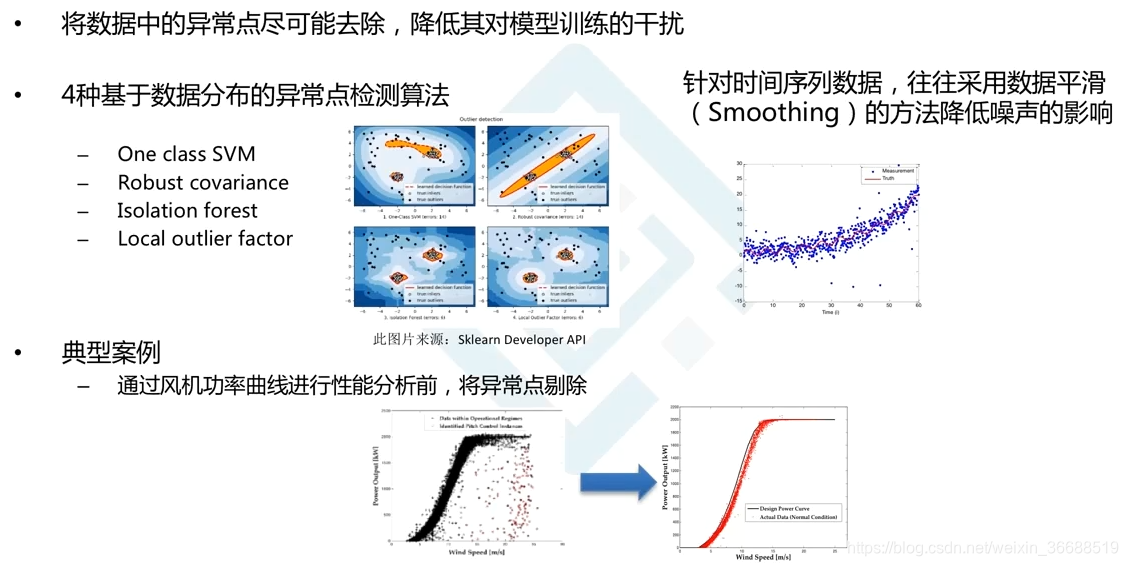

#### 2.1.2 异常值的检测与处理

异常值是那些与数据集中其他观测值显著不同的数据点。它们可能是由测量错误、数据录入错误或其他异常事件造成的。处理异常值的策略通常包括:

- 删除异常值:如果确定数据中的异常值是由于错误引起的,可以选择删除这些点。

- 转换异常值:可以采用数学变换将异常值转化为较为合理的数值。

- 缩放异常值:使用缩放技术,如 Winsorize,将数据集中的极端值替换为阈值附近的值。

```python

# 检测并处理异常值

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

# 计算四分位数范围并找出异常值

outliers = (data < (Q1 - 1.5 * IQR)) | (data > (Q3 + 1.5 * IQR))

data_out = data[~(outliers).any(axis=1)]

print(data_out)

```

这里,我们使用四分位数范围的方法识别并排除了异常值。异常值处理是一个复杂的问题,需要根据具体案例来决定最佳策略。

### 2.2 数据转换的关键技术

#### 2.2.1 数据标准化与归一化

数据标准化和归一化是数据预处理中常用的技术,目的是将数据转换为统一的格式或范围,以便进行有效的比较和分析。

- 标准化:通常指将数据的均值变为0,标准差变为1的过程,也称为 Z-score 标准化。

- 归一化:将数据按比例缩放,使之落入一个小的特定区间,如0到1。

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 数据标准化

scaler_standard = StandardScaler()

data_standard = scaler_standard.fit_transform(data)

# 数据归一化

scaler_minmax = MinMaxScaler()

data_minmax = scaler_minmax.fit_transform(data)

# 将处理后的数据转换回 DataFrame 格式

data_standard_df = pd.DataFrame(data_standard, columns=data.columns)

data_minmax_df = pd.DataFrame(data_minmax, columns=data.columns)

print(data_standard_df.head())

print(data_minmax_df.head())

```

在上述代码中,我们使用`scikit-learn`库中的`StandardScaler`和`MinMaxScaler`类对数据进行了标准化和归一化处理。数据的分布形态可能会影响到模型的选择和结果,因此数据转换是模型建立前的重要步骤。

#### 2.2.2 特征提取与降维技术

在多变量数据分析中,特征提取和降维技术可以减少特征空间的复杂度,并提高模型的性能。

- 主成分分析(PCA):通过线性变换将数据转换到新的坐标系统中,使得数据在新的坐标系统中具有最大的方差。

- 特征选择:通过某种方法识别并选择最相关、最有信息量的特征,剔除不相关或冗余的特征。

```python

from sklearn.decomposition import PCA

from sklearn.feature_selection import SelectKBest, chi2

# 使用 PCA 进行降维

pca = PCA(n_components=2) # 降维到2个主成分

data_pca = pca.fit_transform(data)

# 特征选择

select_k_best = SelectKBest(score_func=chi2, k=3)

data_k_best = select_k_best.fit_transform(data, y)

# 打印结果

print("PCA 结果:", data_pca.shape)

print("特征选择结果:", data_k_best.shape)

```

在示例代码中,我们展示了如何使用PCA进行降维和如何通过`SelectKBest`进行特征选择。这些技术能够帮助我们在保留关键信息的同时简化模型。

### 2.3 数据集成与融合策略

#### 2.3.1 多源数据的整合方法

在许多实际应用中,数据来源多样,整合多源数据是数据预处理过程中的一个挑战。这需要考虑数据的格式一致性、时间对齐、以及数据融合的方式。

- 数据格式转换:将不同来源的数据转换为统一的格式,便于后续处理。

- 时间对齐:确保不同数据源中的时间标签是匹配的,特别是在时间序列数据中。

- 数据融合:将来自不同来源的数据综合到一起,可能是通过合并、连接、或是更复杂的融合技术。

```python

# 假设 data1 和 data2 是来自两个不同数据源的 DataFrame

data1 = pd.DataFrame({

'timestamp': pd.date_range(start='1/1/2021', periods=100, freq='D'),

'value1': np

```

0

0