云原生技术应用实践:地炼行业云转型的实操指南

发布时间: 2025-01-10 01:12:50 阅读量: 6 订阅数: 5

# 摘要

云原生技术作为构建和运行应用程序的一种现代化方法,其架构设计强调微服务、容器化以及服务网格技术的应用,已成为地炼等行业数字化转型的关键推动力。本文概述了云原生技术的基础和架构设计,着重分析了其在地炼行业的应用、面临的挑战以及解决方案,并探讨了与新兴技术的集成方向与可持续发展。通过对技术实践的深入剖析和未来趋势的预测,本文旨在为地炼行业的云原生技术实施提供实操指南,并为相关领域的研究人员和工程师提供指导和参考。

# 关键字

云原生技术;微服务架构;容器化;服务网格;地炼行业;可持续发展

参考资源链接:[2024年中国地炼行业:规模缩减、清洁能源转型与技术升级关键](https://wenku.csdn.net/doc/6n6wx5rhdt?spm=1055.2635.3001.10343)

# 1. 云原生技术概述

云原生技术是IT行业近年来发展最为迅速的领域之一。它旨在构建和运行可应对快速变化的业务需求的应用程序。从基础设施的弹性、自动化部署、微服务架构到服务网格,云原生技术为应用提供了更好的敏捷性、扩展性和可靠性。

## 1.1 云原生技术的定义与特点

云原生技术的定义涉及到了一系列的开发、运行和管理应用程序的技术和实践。它允许开发团队构建可移植、可扩展且易于管理的分布式系统。特点包括容器化、微服务、持续集成和持续部署(CI/CD)以及动态调度。这些特点共同作用,以达到在云环境中快速开发、发布和运行应用程序的目的。

## 1.2 云原生技术的发展背景

云原生技术的发展与云计算服务的普及密切相关。随着企业对云服务依赖程度的加深,传统的部署和运维模型已不能满足快速迭代和动态伸缩的需求。云原生技术应运而生,它利用云计算的优势,如资源的弹性伸缩、按需付费,以及服务的高可用性,为现代应用的开发和运行提供了更优的解决方案。这种变革不仅为企业带来了更高的效率和更低的成本,还推动了整个IT行业的技术进步和业务创新。

以上是对云原生技术概述的一个简要介绍,接下来的章节将深入探讨云原生技术架构设计及其在地炼行业的应用案例。

# 2. 云原生技术架构设计

## 2.1 微服务架构基础

### 2.1.1 微服务的核心概念

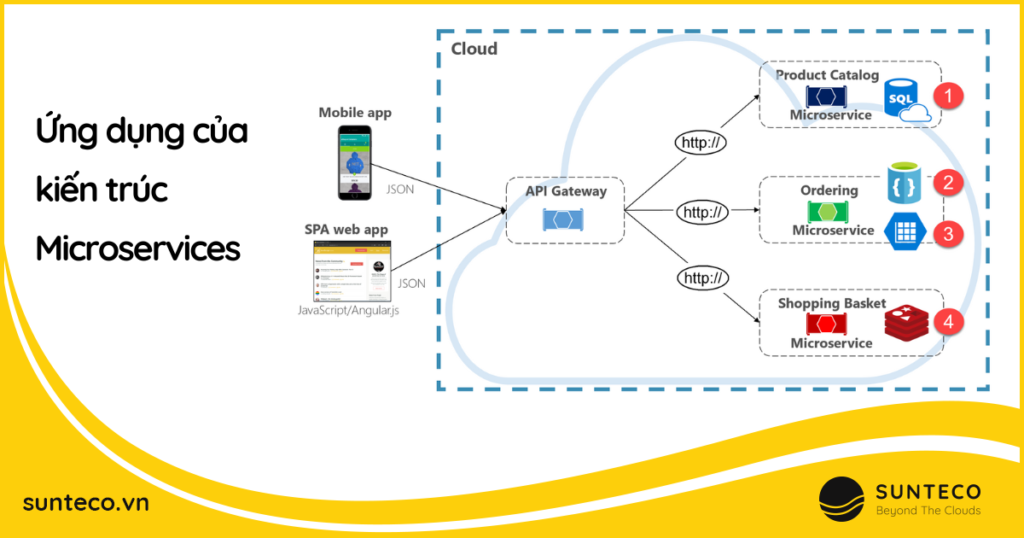

微服务架构是一种设计模式,它将复杂的应用程序分解为一系列小的、松耦合的服务。每个服务运行在其独立的进程中,并围绕业务能力构建,使用轻量级的通信机制相互协调。微服务的核心优势包括更好的可维护性、灵活性和可扩展性。在微服务架构中,一个大型应用被拆分成多个小型服务,这些服务可以通过自动化部署流水线独立部署,并能使用不同的编程语言、数据库和数据存储技术。

与传统单体架构相比,微服务架构更适应于快速迭代和持续部署的需求,因为每个服务都可以独立地更新、扩展和修复而不影响整个应用程序。微服务通过定义清晰的API边界,使得不同的团队可以并行地工作在不同的服务上,这极大地提高了开发效率。

微服务架构也引入了一些挑战,比如服务之间的通信可能会变得复杂,因此服务治理、服务发现、负载均衡等机制变得至关重要。此外,分布式系统的复杂性意味着需要处理更多的故障场景,这要求开发者在设计服务时必须考虑到容错性和弹性。

### 2.1.2 服务的拆分策略和原则

服务拆分是将大型单体应用重构为微服务架构的第一步。在拆分策略中,合理定义服务边界是至关重要的。通常,服务边界应当与业务边界保持一致,以便于微服务能够独立对应一个或多个业务功能。以下是一些关键原则和建议:

- **业务能力划分**:每个微服务应该代表一个业务能力,服务的范围应当紧密围绕一个或多个相关的业务活动。

- **服务自治性**:服务应该尽可能自主,即能独立更新、部署和扩展。这样的服务对于持续改进和创新是至关重要的。

- **数据一致性**:在多个服务之间共享数据时,需要确保数据的一致性,这常常通过分布式事务、事件驱动架构或最终一致性模式来实现。

- **接口定义**:定义清晰的API接口对于服务之间进行良好沟通至关重要。API应当遵循REST原则,采用轻量级的数据格式,如JSON。

- **技术异构性**:在同一个微服务架构中,不同服务可以使用不同的技术栈。这种异构性可以提升开发效率,但也需要有效的服务治理。

拆分策略本身并没有标准答案,这通常取决于具体业务场景和组织的实际情况。常见的拆分方法包括按功能拆分、按业务领域拆分、按子域拆分等。在拆分过程中,团队应持续考虑如何最小化服务间的依赖和交互,以及如何在保持独立性的同时实现服务间必要的协作。

## 2.2 容器化技术实施

### 2.2.1 容器与虚拟机的比较

容器化技术,尤其是Docker的普及,已经成为云原生架构中的关键组成部分。容器和虚拟机都是在隔离环境中运行应用程序和相关组件的方式,但它们在资源管理和隔离机制上有着本质的不同。

虚拟机通过一个叫做虚拟机监控器(Hypervisor)的软件在物理硬件上创建虚拟机实例,每个实例都有自己的操作系统副本。因此,虚拟机的资源开销比较大,每个虚拟机实例会占用较多的内存和存储资源。

相比之下,容器共享宿主机的操作系统,仅包含运行应用所需的应用程序代码和依赖包。因此,容器的开销较小,启动速度更快,也更容易移植和扩展。容器之间相互隔离,但共享同一宿主机的操作系统内核。

从资源利用角度来看,容器化技术通常提供更高的密度,意味着在同样物理资源上可以运行更多的应用程序实例。此外,由于容器的轻量级特性,它们在资源管理和自动化方面提供了更高的效率,使得应用程序的持续交付和运维更加容易。

### 2.2.2 Docker的安装与配置

Docker是一个开源的应用容器引擎,允许开发者将他们的应用程序和依赖打包到一个可移植的容器中,然后运行在任何支持Docker的系统上。Docker容器可以在开发、测试和生产环境之间无缝迁移,实现了一致的运行环境。

安装Docker依赖于宿主机的操作系统。以下是在Linux、Windows和Mac操作系统上安装Docker的基本步骤:

- **Linux**:根据发行版的不同,可以通过包管理器(如apt-get、yum等)安装Docker CE(社区版)。例如,在Ubuntu上,可以运行:

```

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io

```

- **Windows**:可以下载并安装Docker Desktop for Windows。安装过程中会自动安装虚拟机(通常是Microsoft Hyper-V),以便在Windows上运行Linux容器。

- **Mac**:同样,下载并安装Docker Desktop for Mac。Mac上运行Docker需要启用HyperKit虚拟化技术。

安装完成后,可以使用`docker`命令来验证Docker是否正确安装,例如,运行`docker --version`来检查版本信息,使用`docker run hello-world`来运行一个简单的测试容器。

### 2.2.3 Kubernetes集群管理

Kubernetes(简称k8s)是一个开源的、用于自动化部署、扩展和管理容器化应用的系统。它已经成为容器编排领域的事实标准,提供了跨主机集群部署应用程序的功能。

Kubernetes集群由两个主要组件构成:主节点(Master)和工作节点(Node)。主节点负责整个集群的管理和控制,而工作节点则是运行应用程序容器的地方。

在Kubernetes集群管理中,核心概念包括Pod、Service、ReplicaSet和Deployment等:

- **Pod**:Pod是Kubernetes中的最小部署单元,一个Pod可以包含一个或多个容器。

- **Service**:Service定义了一组Pod的访问规则,可以提供负载均衡和发现机制。

- **ReplicaSet**:ReplicaSet负责维护一组Pod的副本,确保指定数量的Pod副本始终运行。

- **Deployment**:Deployment提供声明式的更新,允许用户描述应用的期望状态,并且持续监控和自动更新Pod和ReplicaSet。

安装和配置Kubernetes集群涉及以下步骤:

1. **选择安装方式**:可以根据不同需求选择使用kubeadm、minikube、kubespray等工具进行安装。

2. **配置Master节点**:在主节点上安装和配置API服务器、调度器、控制器等组件。

3. **配置Worker节点**:在工作节点上安装容器运行时(如Docker),并将节点注册到主节点。

4. **配置网络**:为集群配置网络插件,确保Pod之间能够通信。

5. **测试部署**:创建简单的Deployment和Service来测试集群功能是否正常。

下面是一个简单的Kubernetes配置示例:

```yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

```

通过上述配置文件,可以部署一个包含3个副本的Nginx Pod。在创建Deployment后,Kubernetes会自动确保3个Pod始终运行。

Kubernetes集群的管理涉及到持续的监控、日志收集和故障排除。除了标准的命令行工具kubectl之外,还需要利用Kubernetes Dashboard或者第三方监控工具如P

0

0