软件工程中的并发控制:理论结合实践,教你如何优化并发性能

发布时间: 2024-12-05 10:11:31 阅读量: 32 订阅数: 29

软件工程与软件性能优化评估.pptx

参考资源链接:[吕云翔《软件工程-理论与实践》习题答案解析](https://wenku.csdn.net/doc/814p2mg9qb?spm=1055.2635.3001.10343)

# 1. 并发控制的理论基础

并发控制是多任务程序设计的核心。它确保多个并发操作可以协调执行,防止数据不一致和资源竞争。

## 1.1 并发与并行的区别

首先,理解并发(Concurrency)与并行(Parallelism)之间的区别至关重要。并发指的是程序在逻辑上同时执行多个任务的能力,而不必担心实际的物理时间;并行则是指在同一时刻执行多个任务。在单核处理器上实现并发,通常是通过时间分片(time slicing)技术,而在多核处理器上可以真正实现并行。

## 1.2 并发控制的重要性

在多用户或多进程的环境中,未受控的并发可能导致资源冲突、数据不一致和死锁等问题。因此,并发控制不仅是为了保证任务的正确执行,也是为了优化系统性能。

## 1.3 基本概念

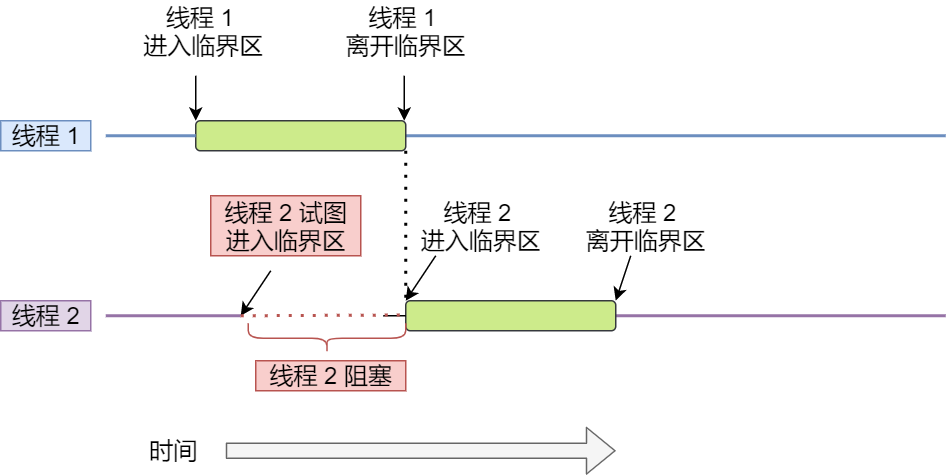

在深入并发模型和同步机制之前,掌握几个基本概念非常重要,如临界区(Critical Section)、互斥(Mutual Exclusion, 简称Mutex)、等待(Blocking)、非阻塞(Non-blocking)和无锁(Lock-free)操作等。这些概念构成了并发控制的理论基础,并影响着并发编程的实践。

```markdown

**临界区**:指的是访问共享资源(例如:变量、文件)的一段代码,同一时间只能有一个线程执行这段代码。

**互斥**:确保一次只有一个线程可以进入临界区的技术或机制。

**等待**:线程在没有得到想要的资源或条件时,被挂起等待的过程。

**非阻塞**:系统或线程在没有获得所需资源时,可以执行其他任务,而不是简单地等待。

**无锁**:一种编程技术,让线程在不使用互斥机制的情况下访问共享资源。

```

通过以上理论基础,我们可以为深入探讨并发控制在不同层次的应用打下坚实的基础。下一章我们将深入了解并发模型的分类与选择,以及同步机制的基本原理。

# 2. 并发模型与同步机制

## 2.1 并发模型的分类与选择

### 2.1.1 任务级并发模型

任务级并发模型是一种将工作分解为独立任务单元的并发处理方法。这些任务可以在不同的线程或进程中独立执行,并通过任务调度器进行管理。这种模型的一个核心优势在于任务之间较少的依赖关系,从而简化了并行化处理。任务级并发模型适用于可以被自然分割成多个独立部分的计算密集型问题。选择任务级并发模型时需要考虑的问题包括:

- 任务分解的粒度:如何将大任务拆分成小任务,以实现负载均衡和高效的并行处理。

- 任务调度策略:选择合适的调度算法来决定任务执行的顺序和时机。

- 系统资源:考虑系统对任务并发执行的资源支持,如 CPU 核心数量,内存带宽等。

任务级并发模型的一个典型例子是 MapReduce 编程模型,它在大数据处理场景中得到了广泛的应用。MapReduce 将数据处理任务分解为 Map 和 Reduce 两个阶段,每个阶段的任务可以独立执行,并由调度器统一管理。

### 2.1.2 线程级并发模型

线程级并发模型侧重于操作系统线程的使用,每个线程都是操作系统可以调度的最小单位。与任务级并发模型不同,线程级模型更关注于控制流程的并发执行。线程之间共享进程资源,但可以通过同步机制(如互斥锁、信号量等)来控制对共享资源的访问。适用于需要紧密协作的任务和频繁数据共享的场景。在选择线程级并发模型时,需要考虑以下因素:

- 上下文切换开销:由于线程共享资源,上下文切换可能带来更高的开销。

- 线程生命周期管理:如何高效地创建、终止线程,以及线程池的管理策略。

- 数据同步和锁竞争:需要合理设计同步机制,以减少线程间的竞争,提升性能。

Java 的 `java.util.concurrent` 包提供了大量线程级并发模型的支持,比如线程池(ExecutorService),以及丰富的同步工具(如 CountDownLatch、CyclicBarrier 和 Phaser)。

## 2.2 同步机制的基本原理

### 2.2.1 互斥锁(Mutex)

互斥锁(Mutex)是最简单的同步机制之一,它用于保证当一个资源被一个线程访问时,其他线程不能访问该资源。互斥锁通常有两个状态:锁定(locked)和解锁(unlocked)。当一个线程请求一个锁定的资源时,该线程将被阻塞,直到锁被释放。互斥锁的典型应用场景是保护共享数据不被并发访问破坏。

为了加深理解,我们通过一个简单的Java代码示例来展示互斥锁的使用:

```java

import java.util.concurrent.locks.Lock;

import java.util.concurrent.locks.ReentrantLock;

public class MutexExample {

private final Lock mutex = new ReentrantLock();

public void accessResource() {

mutex.lock(); // 尝试获取锁

try {

// 模拟操作共享资源的代码

// ...

} finally {

mutex.unlock(); // 保证锁总是被释放

}

}

}

```

在上述代码中,`mutex.lock()` 方法尝试获取锁,若锁已被其他线程获取,则当前线程将阻塞,直到锁被释放。`mutex.unlock()` 方法用于释放锁,这是非常关键的,它确保即使在发生异常的情况下,锁也能被正确释放。

### 2.2.2 信号量(Semaphore)

信号量是一种更通用的同步机制,它允许一定数量的线程同时访问某个资源。信号量维护了一个内部计数器,表示可用资源的数量。当线程请求访问时,计数器会减一;当线程离开时,计数器会加一。当计数器为零时,其他线程请求访问将被阻塞,直到有可用资源。

我们用一个简单的代码示例来演示信号量的使用:

```java

import java.util.concurrent.Semaphore;

public class SemaphoreExample {

private final Semaphore semaphore = new Semaphore(3); // 初始化信号量,最多允许3个线程同时访问

public void accessResource() throws InterruptedException {

semaphore.acquire(); // 请求一个许可

try {

// 模拟操作共享资源的代码

// ...

} finally {

semaphore.release(); // 释放一个许可

}

}

}

```

在这个例子中,信号量初始化为3,意味着最多有3个线程可以同时访问被保护的资源。如果一个线程调用 `semaphore.acquire()`,而许可的数量小于或等于零,则该线程将被阻塞,直到有可用的许可。

## 2.3 并发编程中的死锁问题

### 2.3.1 死锁的成因与预防

死锁是指两个或多个线程在执行过程中,因争夺资源而造成的一种僵局。发生死锁时,相关线程都在等待其他线程释放资源,而线程本身又被其他线程所等待。死锁的四个必要条件通常被总结为:

1. 互斥条件:资源不能被共享,只能由一个线程使用。

2. 占有和等待条件:线程至少持有一个资源,并且正在等待获取其他线程占有的资源。

3. 不可剥夺条件:线程已获得的资源在未使用完之前不能被强行剥夺,只能由线程自愿释放。

4. 循环等待条件:发生死锁时,必然存在一个线程—资源的环形链。

预防死锁的方法可以分为两种:破坏死锁的必要条件,或者使用死锁避免算法。例如,通过破坏“循环等待”条件,可以为资源强制排序,确保每个线程按顺序请求资源。另外,可以使用银行家算法来避免死锁的发生,这是一种确保系统始终处于安全状态的资源分配策略。

### 2.3.2 死锁的检测与解决策略

当死锁无法完全避免时,就需要通过死锁检测机制来诊断问题,并采取解决策略。死锁检测通常涉及到构建资源分配图,并检查是否存在环形等待链。如果检测到死锁,解决策略包括:

1. 资源剥夺:从一个线程处抢占资源,并分配给另一个线程。

2. 线程终止:逐步终止涉及死锁的线程,直到打破死锁状态。

3. 回滚操作:将线程回滚到某个安全状态,并释放资源。

在实际应用中,自动死锁检测和解决策略可能会涉及较为复杂的系统设计,因此在软件设计阶段应尽量避免死锁的发生。通过合理地设计资源请求顺序、使用超时机制以及进行资源预分配等手段,可以在很大程度上减少死锁的可能性。

# 3. 并发性能优化策略

## 3.1 线程池的使用与优化

### 3.1.1 线程池的工作原理

线程池是管理线程生命周期的一种并发工具,它根据任务的类型和数量动态地创建和回收线程资源。线程池由一系列的池化组件构成,主要包括任务队列、工作线程集合、线程池控制器等。在执行任务时,线程池将任务提交到任务队列,工作线程从中取出任务进行执行。使用线程池可以有效减少线程创建和销毁带来的性能开销,减少资源消耗,提高系统响应速度。

线程池的工作流程一般如下:

1. 创建线程池实例并配置参数,如核心线程数、最大线程数、任务队列容量等。

2. 提交任务到线程池,如果当前线程数小于核心线程数,则创建新线程执行任务。

3. 如果核心线程都处于忙碌状态,新任务会被放入任务队列等待。

4. 如果任务队列已满,但还有更多的任务提交,则根据当前线程数是否达到最大线程数,来决定是否创建新的线程来执行任务。

5. 任务执行完毕后,线程不会立即销毁,而是空闲一段时间后才会被回收。

### 3.1.2 线程池配置的最佳实践

线程池的配置对于并发性能优化至关重要。以下是一些配置线程池的最佳实践:

1. 根据任务类型确定合适的线程池类型。CPU密集型任务应设置核心线程数等于可用处理器数,而IO密集型任务可以设置更高,因为IO等待期间线程可以被其它任务利用。

2. 合理设定线程池大小。过多的线程会增加上下文切换的开销,过少则不能充分利用CPU资源。

3. 使用有界的任务队列。无界的任务队列可能导致内存消耗过大,甚至引发OutOfMemoryError。

4. 设置合理的线程存活时间。避免线程长时间空闲导致资源浪费,同时也需要给线程足够的存活时间避免频繁的线程创建和销毁。

5. 考虑使用自定义拒绝策略。默认的拒绝策略可能不适用于所有的场景,合理的拒绝策略能够防止系统过载并提供更好的错误处理。

## 3.2 避免锁的性能开销

### 3.2.1 锁粒度的调整

在并发编程中,锁是一种用来协调多个线程对共享资源访问的机制。锁会带来两个主要的性能开销:上下文切换和线程等待时间。锁的粒度决定了这些开销的大小,同时也影响并发性能。

锁粒度可以大致分为:

- **粗粒度锁**:对较大范围的资源使用同一个锁,简化并发控制,但容易成为性能瓶颈。

- **细粒度锁**:对小范围或单个资源使用多个锁,减少了锁竞争,提高了并发能力。

调整锁粒度通常需要注意以下几点:

1. 分析线程间的冲突热点,找到合适分割锁的界限。

2. 避免过度细分锁,因为锁自身也会带来开销。

3. 使用锁分离技术,将读写操作放在不同的锁控

0

0