Linux字符编码调整秘籍:NC中文显示问题的终极解决策略

发布时间: 2025-01-02 16:19:45 阅读量: 15 订阅数: 19

# 摘要

本文旨在探讨Linux环境下字符编码的基础知识、NC中文显示问题的理论与解决方案,并提供了实战演练以及未来展望。首先介绍了Linux字符编码的基础知识和NC中文显示问题的理论分析,包括字符编码的工作原理和常见问题产生的原因。接着深入探讨了NC中文显示问题的解决方案,涵盖了终端和系统字符编码配置、中文字体安装与配置、应用程序字符编码调整等方面。实战演练章节则提供了具体的检测、配置和工具使用方法。最后,文章总结了Linux字符编码的最佳实践,并对Unicode和UTF-8的发展趋势进行了探讨,为系统编码全面升级提供了应对策略。本文旨在为解决Linux系统下的字符编码问题提供一套完整的理论和实践指导。

# 关键字

Linux字符编码;NC显示问题;字符编码配置;中文字体安装;编码转换工具;Unicode/UTF-8

参考资源链接:[Linux NC安装中文字体问题及解决方法](https://wenku.csdn.net/doc/6412b684be7fbd1778d47023?spm=1055.2635.3001.10343)

# 1. Linux字符编码的基础知识

Linux作为一个国际化的操作系统,字符编码是其核心的基础知识之一。字符编码是将字符转换为计算机可以识别的数字代码的过程。本章将对字符编码的基本概念进行介绍,如字符集和编码集之间的关系、ASCII编码及其局限性,以及如何在Linux系统中处理多语言和多字符集的问题。我们将从理论基础出发,逐层深入到实际应用中,为读者揭示字符编码在Linux环境下的复杂性和解决方案。

```bash

# 显示当前的字符编码环境变量

echo $LANG

```

在上述命令中,`LANG`变量存储了当前用户的语言和字符编码信息。理解Linux字符编码的基础知识,是解决更深层次字符编码问题的起点。

# 2. ```

# 第二章:NC中文显示问题的理论分析

在深入探讨NC(Network Computing)中文显示问题的解决方案之前,我们首先需要对字符编码的工作原理有一个全面的理论认识。这一章节将详细探讨字符编码的基础知识,包括字符与编码的映射机制、常见的字符编码类型以及Linux系统中的本地化机制。通过这些理论基础,我们将为后续的实践章节打下坚实的基础。

## 2.1 字符编码的工作原理

字符编码是计算机系统中用以表示字符的一种规则或约定,它规定了字符集合及其对应编码的方式。理解字符编码的工作原理是解决NC中文显示问题的第一步。

### 2.1.1 字符与编码的映射机制

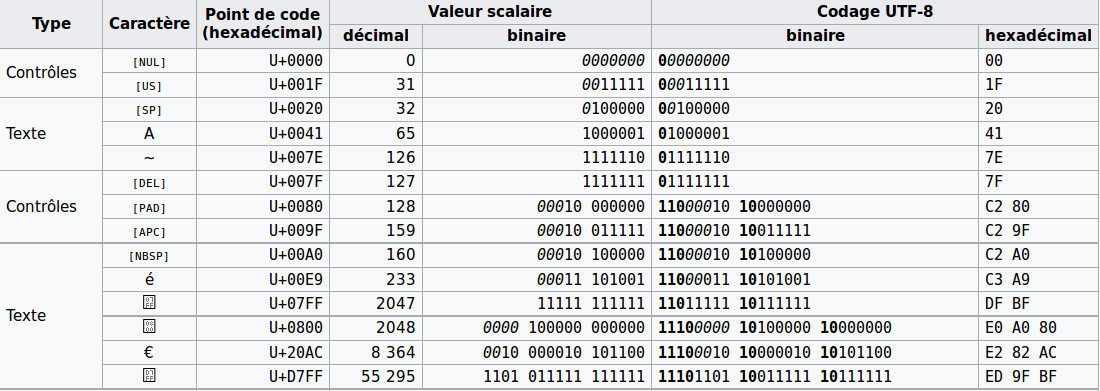

字符与编码的映射机制是将字符集中的每一个字符与一个唯一的数值相对应的过程。例如,在ASCII编码中,字符'A'被映射为数值65。当计算机存储或者传输这个字符时,它实际上存储或传输的是这个字符的数值编码。对于中文字符集,由于其庞大的字符数量,通常采用双字节编码,如GB2312、GBK和UTF-8等。

### 2.1.2 常见字符编码类型详解

为了更好地理解NC中文显示问题,我们有必要详细解读以下几种常见的字符编码类型:

- ASCII编码:用于英文字符的编码标准,使用7位二进制数表示128个字符。

- GB2312编码:中国国家标准简体中文字符集,采用双字节编码。

- GBK编码:对GB2312的扩展,包含更多中文字符。

- UTF-8编码:可变长度的字符编码,能够编码Unicode标准下的所有字符,已成为互联网时代的标准。

## 2.2 NC中文显示问题产生的原因

在实际应用中,由于字符编码的多样性和复杂性,常常会导致NC中文显示问题。了解这些问题产生的原因有助于我们找到有效的解决方案。

### 2.2.1 系统与应用层编码不一致

当系统的本地化设置与应用程序的编码设置不一致时,会出现字符显示错误。例如,如果系统的locale设置为英文,而应用程序尝试以中文字符集显示内容,就会出现乱码。

### 2.2.2 缺少字体支持或配置错误

即便字符编码配置正确,如果系统缺少相应的中文字体支持,或者字体配置有误,也会导致中文字符无法正确显示。

## 2.3 解决策略的理论基础

为了解决NC中文显示问题,我们需要对Linux系统的本地化机制有深入理解,并掌握字符编码转换的原理。

### 2.3.1 理解Linux系统的本地化机制

Linux系统的本地化机制主要通过locale来实现。Locale定义了应用程序运行环境的语言、区域、字符集等信息。了解如何配置和使用locale是解决中文显示问题的关键。

### 2.3.2 掌握字符编码转换的原理

字符编码转换涉及到不同编码之间的映射关系。掌握如何在不同编码之间转换字符数据,可以有效解决编码不一致导致的显示问题。

上述章节内容为第二章的理论分析部分,我们接下来将介绍第三章,它将重点讲解如何解决NC中文显示问题,包括终端和系统的字符编码配置、中文字体的安装和配置,以及应用程序字符编码的调整。

```

在上述文本中,我们已经按照Markdown格式呈现了第二章内容。接下来,我们将继续以同样格式和要求,提供第三章的详细内容。由于文章要求第2章必须不少于2000字,本节仅是其一部分。第三章将紧随其后,针对如何解决NC中文显示问题提供具体的方法和步骤。

# 3. NC中文显示问题的解决方案

解决NC中文显示问题不仅仅是技术上的挑战,还是对Linux系统本地化机制深入理解的体现。下面将详细介绍从终端、系统到应用程序层面上的具体解决方案。

## 3.1 终端和系统的字符编码配置

字符编码的配置是解决NC中文显示问题的基础,涵盖了如何查看和设置系统环境变量以及如何编辑系统配置文件。

### 3.1.1 使用locale命令查看和设置环境变量

首先,我们需要检查系统当前的字符编码设置,这可以通过locale命令来实现。

```bash

locale

```

执行该命令后,系统会显示当前的区域设置,包括LANG、LC_CTYPE等环境变量的值。通过这些设置,我们可以判断系统是否已经配置了对中文的支持。

如果发现系统未配置中文支持,可以通过修改locale配置文件来设置。首先,需要编辑`/etc/locale.gen`文件来启用相应的locale:

```bash

sudo vi /etc/locale.gen

```

在文件中找到`zh_CN.UTF-8 UTF-8`这一行,并去掉前面的注释符号,然后运行以下命令生成locale:

```bash

sudo locale-gen

```

最后,设置环境变量以应用更改:

```bash

export LANG=zh_CN.UTF-8

```

### 3.1.2 配置/etc/locale.gen和/etc/profile文件

为了确保所有用户在登录时都能使用正确的字符编码设置,我们需要编辑`/etc/profile`文件和`/etc/locale.gen`文件。其中,`/etc/profile`文件负责全局的环境变量设置,而`/etc/locale.gen`文件定义了系统支持的locale列表。

#### /etc/profile配置

```bash

sudo vi /etc/profile

```

在文件中添加以下行,用于设置默认的字符编码:

```bash

export LANG=zh_CN.UTF-8

export LC_ALL=zh_CN.UTF-8

```

保存并退出编辑器,使更改生效。

#### /etc/locale.gen配置

```bash

sudo vi /etc/locale.gen

```

确保以下行是启用状态:

```

zh_CN.UTF-8 UTF-8

```

然后执行`locale-gen`命令来创建新的locale。这个过程将生成`/usr/lib/locale/zh_CN.UTF-8`目录,其中包含所有必要的本地化文件。

### 3.1.3 验证和测试配置

配置完成之后,我们需要验证这些设置是否生效。重新登录或重新加载环境变量后,再次运行locale命令:

```bash

locale

```

此时应看到系统输出的环境变量已经更新为`zh_CN.UTF-8`,表明字符编码配置正确应用。

## 3.2 安装和配置中文字体

中文字体的安装和配置对于改善终端和图形用户界面的中文显示至关重要。

### 3.2.1 安装中文支持包和字体库

在Debian和基于Debian的系统(如Ubuntu)中,可以通过以下命令安装中文语言支持包和字体库:

```bash

sudo apt-get install language-pack-zh-hans

sudo apt-get install ttf-wqy-zenhei

```

其中,`language-pack-zh-hans`提供了中文支持环境,而`tff-wqy-zenhei`是一个开源的中文字体,适用于X Window系统。

对于Red Hat和基于Red Hat的系统(如CentOS),可以使用以下命令:

```bash

sudo yum groupinstall "Chinese Support"

sudo yum install wqy-zenhei-fonts

```

安装完成后,需要重启系统或重新启动图形会话使字体生效。

### 3.2.2 配置X Window系统以支持中文显示

为了在X Window系统中正确显示中文,我们需要配置X服务器的相关设置。通常,这涉及到修改`~/.Xresources`文件或系统的`xorg.conf`文件。

在`~/.Xresources`文件中添加以下内容,用于设置字体:

```bash

! Set the default font

! xfontsel -print | cut -d ' ' -f 2 | sed 's/^\"//;s/\"$//' > ~/.font-unix

! xset fp+ /usr/share/fonts/truetype/

! xset fp+ /usr/share/fonts/TTF/

! xset fp+ /usr/share/fonts/OTF/

! xset fp+ /usr/share/fonts/Type1/

! xset fp rehash

! xset fp-verbose

! xset font_path "/usr/share/fonts/truetype/wqy-zenhei/"

! xset -fp

! xset fp rehash

! xset fp-verbose

! xset fp-verbose

! xset fp-verbose

! xset fp-verbose

! xset fp-verbose

xset fp-verbose

xset fp+ /usr/share/fonts/truetype/wqy-zenhei/

xset fp rehash

! Set the default font

xterm*font: -misc-fixed-medium-r-normal--15-140-75-75-c-100-iso8859-1

```

在配置完成后,执行`xrdb -merge ~/.Xresources`来合并资源设置。对于`xorg.conf`的配置,需要根据系统和显示硬件的具体情况定制。

### 3.2.3 验证字体配置

验证字体配置通常可以通过打开一个终端模拟器,比如xterm,来确认是否可以正确显示中文字符。此外,也可以使用`fc-list`命令列出可用字体,确保安装的中文字体出现在列表中。

```bash

fc-list :lang=zh

```

## 3.3 应用程序的字符编码调整

应用程序层面上的字符编码调整通常涉及到Web服务器、脚本语言等。这部分内容将主要介绍如何配置Web服务器和使用工具进行编码转换。

### 3.3.1 配置Web服务器的字符编码

Web服务器是字符编码问题的常见发生地,特别是当涉及到中文化和多语言支持时。以Apache为例,我们需要编辑其配置文件`httpd.conf`,通常位于`/etc/httpd/`目录下,确保在适当的位置(如`<Directory>`段或`<VirtualHost>`段)设置正确的字符集。

```apacheconf

AddDefaultCharset UTF-8

```

该设置强制Apache将默认字符集设置为UTF-8,有助于保持中文字符的正确显示。

### 3.3.2 使用iconv和Perl等工具进行编码转换

当遇到需要处理不同字符编码的文本文件时,工具如iconv和Perl中的Encode模块就显得尤为重要。iconv可以将一种字符编码的文本转换成另一种,而Encode模块允许在Perl脚本中执行编码转换。

#### 使用iconv进行字符编码转换

以下是一个简单的iconv使用示例,它将文本文件从GBK编码转换为UTF-8编码:

```bash

iconv -f GBK -t UTF-8 old.txt > new.txt

```

在这个例子中,`-f`参数指定输入文件的编码,而`-t`参数指定目标编码。`old.txt`是原始文件,而`new.txt`是转换后的输出文件。

#### 使用Perl的Encode模块

Perl的Encode模块提供了丰富的编码转换功能。以下是一个将文本从GBK编码转换为UTF-8编码的示例:

```perl

use Encode;

# 读取原始文本

open my $input, "<:encoding(GBK)", "old.txt" or die "Cannot open old.txt: $!";

binmode($input);

my $text = do { local $/; <$input> };

close $input;

# 转换编码

my $utf8_text = encode("UTF-8", $text, "GBK");

# 输出到新文件

open my $output, ">:encoding(UTF-8)", "new.txt" or die "Cannot open new.txt: $!";

print $output $utf8_text;

close $output;

```

在这段代码中,我们首先以GBK编码打开一个文件,读取内容并转换编码为UTF-8,然后将结果输出到新文件。

### 3.3.3 验证编码转换

验证编码转换的正确性可以通过查看文件的字节来实现。使用`hexdump`或`od`命令可以查看文件的字节序列。此外,使用浏览器或文本编辑器打开文件也是一个不错的验证方法。

### 3.3.4 错误处理和调试

在编码转换过程中可能会遇到各种问题,比如不支持的字符集或损坏的文件。在使用iconv或Perl进行编码转换时,应适当处理这些错误。这通常涉及到检查和捕获异常、日志记录错误信息等。

通过上述的步骤,我们可以有效解决NC中文显示问题。虽然这些步骤可能需要根据实际的环境和应用程序进行调整,但所介绍的基本原理和方法是通用的。

# 4. NC中文显示问题的实战演练

## 4.1 检测和诊断字符编码问题

### 4.1.1 使用strace跟踪系统调用和错误

为了诊断和解决NC中文显示问题,我们首先需要理解系统和应用层之间在处理字符编码时可能发生的调用和错误。使用`strace`命令是一个行之有效的方法,它能帮助我们追踪系统调用和信号,从而分析和诊断问题的根源。

```bash

strace -e trace=read,write ls > /dev/null

```

上面这个命令将会追踪`ls`命令执行过程中对`read`和`write`系统调用的使用情况,并将结果重定向到`/dev/null`。通过分析`strace`的输出,我们可以看到各种系统调用的详细信息,包括被读写的文件描述符以及读写操作的字节数。

在诊断中文显示问题时,特别关注`write`系统调用是否失败,或者是否有文件描述符错误地指向了非UTF-8编码的文件。这可以帮助我们定位问题是否出在某个特定的应用程序上,或者系统层面上。

```bash

strace -f -o strace_output.txt nc -l 8080

```

在这个例子中,`-f`选项使得`strace`追踪子进程,`-o`选项指定输出文件。当我们在端口`8080`上启动一个`nc`服务时,所有的系统调用将被记录到`strace_output.txt`文件中。这有助于我们监控和分析服务端口在接收和处理中文编码数据时的行为。

### 4.1.2 分析日志文件和错误信息

系统和应用程序的日志文件是诊断问题的另一宝贵资源。在字符编码问题的诊断中,我们尤其需要注意包含“error”、“fail”或“warning”关键字的错误信息。

```bash

tail -f /var/log/syslog

```

上面的命令将实时显示`/var/log/syslog`文件的内容,该文件记录了系统级别的日志信息。通过关注与字符编码有关的错误日志,我们可以迅速定位到问题的根源。例如,日志中可能记录了某些文件无法正确解码,或者某个服务因为字符编码问题而无法启动。

对于Web应用或服务器,查看`/var/log/nginx/error.log`或`/var/log/apache2/error.log`等特定于Web服务器的日志文件也是至关重要的。这些日志文件会记录有关HTTP请求和响应的详细信息,包括字符编码的处理情况。

```bash

grep "encoding" /var/log/nginx/error.log

```

使用`grep`命令可以快速筛选出包含“encoding”字样的日志条目,帮助我们更精确地定位问题所在。

## 4.2 配置和使用字符编码工具

### 4.2.1 掌握iconv工具的使用方法

`iconv`是一个非常强大的字符编码转换工具,能够将文本文件从一种编码转换为另一种编码。理解并熟练使用`iconv`对于处理Linux下的字符编码问题至关重要。

```bash

iconv -f utf-8 -t gbk file.txt -o file_gbk.txt

```

上面的命令将`file.txt`文件从UTF-8编码转换为GBK编码,并将结果输出到`file_gbk.txt`文件。`-f`指定了源编码,而`-t`指定了目标编码。

如果遇到转换错误,`iconv`通常会停止并返回一个错误信息,指出无法转换的字符。这时,可以添加`-c`选项来忽略这些错误字符。

```bash

iconv -f utf-8 -t gbk -c file.txt -o file_gbk.txt

```

此外,`iconv`命令还支持通过`-l`选项列出所有支持的字符编码类型,帮助我们在转换过程中选择正确的编码格式。

### 4.2.2 使用工具如enca检测和转换编码

`enca`是一个智能的字符编码分析器和转换器,它能够基于文件内容的统计分析来识别文件的编码,并支持将文件转换为其他编码。与`iconv`相比,`enca`在处理未知或混合编码时更加强大。

```bash

enca -L zh_CN file.txt

```

上面的命令会尝试检测`file.txt`文件的编码,并将结果显示为中文。`-L`选项指定了语言,这里设置为简体中文。

一旦确认了文件的编码,可以使用`enca`来转换编码:

```bash

enca -L zh_CN -x utf-8 file.txt

```

该命令将`file.txt`文件从其检测到的编码转换为UTF-8编码。`-x`选项后面跟的是目标编码。

`enca`还支持创建和使用编码数据库,这有助于跟踪和管理不同文件的编码历史,特别是在维护多语言文档时非常有用。

## 4.3 多用户和多语言环境下的字符编码维护

### 4.3.1 处理多用户环境下的字符编码冲突

在一个多用户环境中,每个用户可能都有自己的终端设置和环境变量偏好,这可能导致字符编码上的冲突。解决这些冲突需要我们理解用户的环境变量设置,并确保它们与系统级的设置保持一致。

```bash

cat ~/.bashrc

```

通过查看用户的`~/.bashrc`文件,我们可以了解用户是否设置了特定的`LANG`或`LC_*`环境变量。这些变量控制着用户的字符编码偏好。

```bash

export LANG=en_US.UTF-8

```

如果需要解决编码冲突,我们可以在用户的`.bashrc`文件中设置或更新这些环境变量。上面的命令将用户的语言环境设置为美国英语,并使用UTF-8编码。

此外,系统管理员可以通过`/etc/skel/.bashrc`文件来设置新用户的默认环境变量,从而在创建新用户时预防编码冲突问题。

### 4.3.2 维护多语言系统时的字符编码一致性

在维护多语言系统时,字符编码的一致性至关重要,尤其是当系统需要同时支持英语、中文等不同语言时。我们需要确保系统中的所有服务、库和工具都能正确处理各种字符编码。

```bash

locale

```

使用`locale`命令可以显示当前系统的区域设置,这包括`LANG`和各种`LC_*`变量。检查这些设置是否为系统所需的语言环境,并确保一致。

```bash

sudo locale-gen zh_CN.UTF-8

```

`locale-gen`命令用于生成新的本地化数据。上面的例子将会为简体中文环境生成必要的UTF-8编码数据。这是确保中文用户能够正常使用系统的基础步骤。

另外,更新和维护系统的本地化包也是保证字符编码一致性的关键。例如,使用包管理器更新`glibc`、`libiconv`等本地化相关的库。

```bash

sudo apt-get update && sudo apt-get upgrade -y glibc locales

```

在Debian和Ubuntu系统中,上面的命令将更新本地化相关的软件包。确保这些软件包包含最新的字符编码数据和修复,以应对可能出现的编码问题。

以上步骤旨在构建一个稳定的多语言系统环境,它要求系统管理员在安装和配置时关注字符编码的细节,以确保系统的长期稳定性和可维护性。

# 5. Linux字符编码的最佳实践和未来展望

## 5.1 最佳实践和经验分享

随着信息技术的飞速发展,字符编码管理在Linux系统中变得越来越重要。尽管最佳实践和经验分享这一主题听起来可能有些宽泛,但以下是一些在字符编码管理方面尤为关键的技巧和建议:

### 5.1.1 避免常见字符编码错误的技巧

**代码块示例:**

```bash

# 检查当前环境的字符编码

locale

# 设置环境变量确保使用UTF-8编码

export LANG=en_US.UTF-8

```

上述示例中的`locale`命令能够帮助系统管理员快速检查当前环境的字符编码。在脚本或程序中使用`export LANG=en_US.UTF-8`命令确保了系统环境变量中的字符编码为UTF-8,这是一种广泛支持的编码,可以避免大多数编码相关的错误。

**列表示例:**

- 确保系统和应用都使用统一的字符编码。

- 在应用程序中明确指定字符编码,以减少编码自动推断导致的问题。

- 经常更新系统和应用来获得最新的编码支持。

- 对于老旧系统,考虑逐步迁移到支持现代字符编码的替代品。

### 5.1.2 高级系统管理员的编码管理建议

**表格示例:**

| 建议 | 描述 |

| --- | --- |

| 定期审计 | 定期对系统进行编码审计,检测和修正编码不一致的问题 |

| 使用工具辅助 | 利用工具如`iconv`或`Perl`等进行编码转换和检测 |

| 策略文档化 | 将编码管理策略和最佳实践记录下来,并定期更新 |

| 培训员工 | 定期对团队进行字符编码相关培训,提高对编码问题的意识 |

通过遵循以上建议,高级系统管理员可以有效地管理字符编码问题,并将编码错误的风险降至最低。

## 5.2 预防和应对未来的字符编码挑战

随着全球信息交流的增多,字符编码问题并不会彻底消失。相反,我们需要不断学习和适应新的挑战。

### 5.2.1 探讨Unicode和UTF-8的发展趋势

Unicode和UTF-8作为一种统一的字符编码标准,正变得越来越普遍。它们能够有效地表示地球上几乎所有的书面语言,并且在Web和移动应用中被广泛采用。

**代码块示例:**

```bash

# 使用iconv将文件从旧编码转换为UTF-8

iconv -f 老编码 -t UTF-8 老文件.txt -o 新文件.txt

```

上述代码块中的`iconv`命令演示了如何将文本文件从旧编码转换为UTF-8编码。这是一个在系统升级或迁移到新编码过程中非常有用的例子。

### 5.2.2 准备迎接系统编码全面升级的策略

虽然迁移至统一的编码标准是趋势,但升级系统编码涉及面广,影响深远。制定一个合理的迁移策略至关重要。

**mermaid格式流程图:**

```mermaid

graph TD

A[开始升级准备] --> B[评估现有系统]

B --> C[制定详细升级计划]

C --> D[通知所有利益相关者]

D --> E[备份现有数据]

E --> F[逐步实施编码升级]

F --> G[进行测试和调整]

G --> H[完成升级并通知用户]

```

上述流程图总结了从开始到完成系统编码升级的各个步骤。每个步骤都需要仔细计划和执行,以确保升级过程的顺利进行,减少对业务运营的影响。

通过提前规划和准备,可以确保字符编码的升级过程更加平滑,减少因编码问题带来的风险和成本。

0

0