YOLO视频检测训练集:数据收集、标注、预处理,打造高质量训练集

发布时间: 2024-08-17 06:19:08 阅读量: 95 订阅数: 23

java计算器源码.zip

# 1. YOLO视频检测训练集概述**

视频检测任务中,高质量的训练集至关重要。YOLO视频检测训练集包含用于训练YOLO模型的视频帧和标注数据。本文将概述YOLO视频检测训练集的关键组成部分,包括数据收集、标注、预处理和质量评估。

# 2. 数据收集与标注

### 2.1 视频数据收集方法

视频数据收集是YOLO视频检测训练集构建的第一步,其质量直接影响模型的性能。常见的视频数据收集方法包括:

- **网络爬取:**从YouTube、Vimeo等视频网站下载符合训练目标的视频。

- **自有拍摄:**使用摄像头或无人机拍摄特定场景或活动。

- **购买或租赁:**从视频库或数据提供商购买或租赁高质量视频。

### 2.2 标注工具选择与标注策略

标注是将视频中的目标对象标记出来,为模型提供训练数据。常用的标注工具有:

- **LabelImg:**开源的标注工具,支持图像和视频标注。

- **VOTT:**谷歌开发的视频标注工具,支持多帧标注和复杂目标标注。

- **CVAT:**开源的视频标注平台,支持协作标注和数据管理。

标注策略根据目标检测任务的不同而有所差异。对于目标检测任务,通常采用以下标注策略:

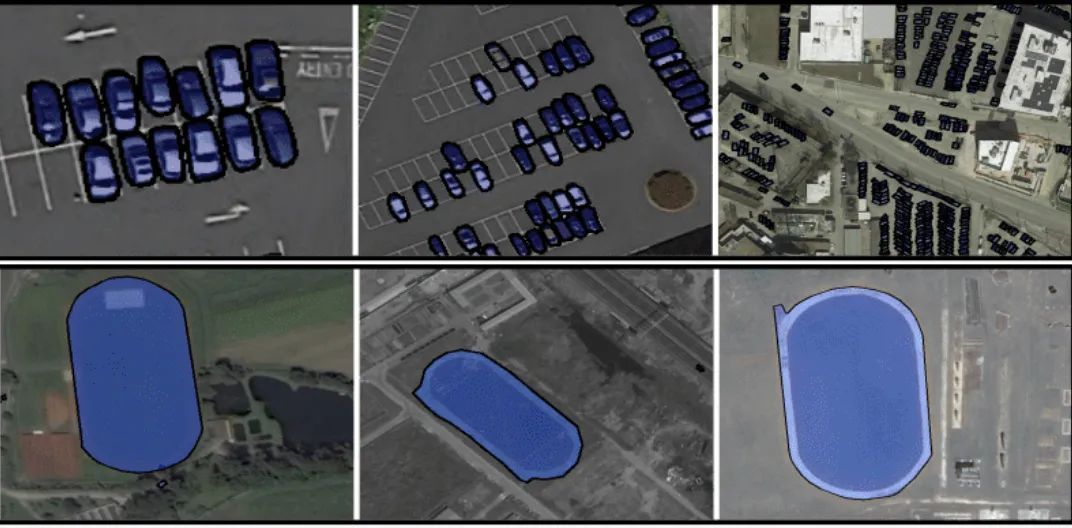

- **边界框标注:**使用矩形框标注目标对象的位置和大小。

- **多边形标注:**使用多边形标注目标对象的任意形状。

- **关键点标注:**标注目标对象的关键点,如人脸中的眼睛、鼻子、嘴巴。

#### 代码块:LabelImg标注工具使用示例

```python

import labelImg

# 加载视频文件

video_path = "path/to/video.mp4"

video = labelImg.Video(video_path)

# 创建标注框

bbox = labelImg.BBox(x1, y1, x2, y2)

# 添加标注框到视频

video.add_bbox(bbox)

# 保存标注结果

video.save("path/to/annotated_video.mp4")

```

#### 代码逻辑分析:

该代码块演示了如何使用LabelImg标注工具标注视频中的目标对象。它加载视频文件,创建标注框,并将标注框添加到视频中。最后,将标注结果保存为新的视频文件。

#### 参数说明:

- `video_path`:要标注的视频文件的路径。

- `bbox`:标注框对象,包含目标对象的坐标信息。

- `x1, y1, x2, y2`:标注框的左上角和右下角坐标。

# 3. 数据预处理

数据预处理是视频检测训练集构建的关键步骤,它可以有效提高模型的训练效率和准确性。本章将详细介绍数据预处理的两种主要技术:数据增强和数据格式转换与归一化。

### 3.1 数据增强技术

数据增强是一种通过对原始数据进行变换和处理,生成新的训练样本的技术。它可以有效增加训练集的多样性,防止模型过拟合,提高泛化能力。常用的数据增强技术包括:

- **随机裁剪:**从原始视频中随机裁剪出不同大小和宽高比的子视频。

- **随机翻转:**水平或垂直翻转视频帧。

- **随机旋转:**以一定角度旋转视频帧。

- **颜色抖动:**调整视频帧的亮度、对比度、饱和度和色相。

- **添加噪声:**向视频帧中添加高斯噪声或椒盐噪声。

**代码块:**

```python

import cv2

import numpy as np

def random_crop(frame, size):

"""

随机裁剪视频帧。

参数:

frame: 视频帧。

size: 裁剪后的尺寸。

"""

height, width, _ = frame.shape

x = np.random.randint(0, width - size[0])

y = np.random.randint(0, height - size[1])

return frame[y:y+size[1], x:x+size[0]]

def random_flip(frame):

"""

随机翻转视频帧。

参数:

frame: 视频帧。

"""

if np.random.rand() > 0.5:

return cv2.flip(frame, 1)

else:

return cv2.flip(frame, 0)

```

### 3.2 数据格式转换与归一化

视频检测模型通常需要将视频帧转换为特定格式才能进行训练。常见的格式转换包括:

- **从BGR转换为RGB:**将视频帧从BGR(蓝绿红)格式转换为RGB(红绿蓝)格式。

- **调整大小:**将视频帧调整为模型要求的尺寸。

- **归一化:**将视频帧的像素值归一化为[0, 1]范围。

**代码块:**

```python

import cv2

def convert_bgr_to_rgb(frame):

"""

将视频帧从BGR格式转换为RGB格式。

参数:

frame: 视频帧。

"""

return cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

def resize(frame, size):

"""

调整视频帧的尺寸。

参数:

frame: 视频帧。

size: 调整后的尺寸。

"""

return cv2.resize(frame, size)

def normalize(frame):

"""

将视频帧的像素值归一化为[0, 1]范围。

参数:

frame: 视频帧。

"""

return frame / 255.0

```

**逻辑分析:**

以上代码块实现了视频帧的格式转换和归一化。`convert_bgr_to_rgb()`函数将视频帧从BGR格式转换为RGB格式。`resize()`函数将视频帧调整为指定尺寸。`normalize()`函数将视频帧的像素值归一化为[0, 1]范围。

**参数说明:**

- `frame`: 输入的视频帧。

- `size`: 调整后的尺寸(对于`resize()`函数)或归一化后的范围(对于`normalize()`函数)。

# 4. 训练集质量评估

### 4.1 数据集多样性与代表性

数据集的多样性是指训练集中包含不同场景、物体大小、光照条件和运动模式的视频。代表性是指训练集中视频的分布与实际应用场景中视频的分布相似。

**评估方法:**

* **场景多样性:**统计训练集中不同场景(如室内、室外、街道、公园等)的比例。

* **物体大小:**计算训练集中物体的大小分布,确保覆盖从小型到大型物体的范围。

* **光照条件:**分析训练集中视频的光照条件(如白天、夜晚、阴天等)的分布。

* **运动模式:**统计训练集中物体运动模式(如静止、行走、奔跑等)的比例。

### 4.2 标注准确性与一致性

标注的准确性是指标注框与真实物体边界框的重叠程度。一致性是指不同标注人员对相同物体的标注结果的一致性。

**评估方法:**

* **准确性:**使用交并比(IoU)来衡量标注框与真实物体边界框的重叠程度。IoU 越高,标注越准确。

* **一致性:**计算不同标注人员对同一视频中相同物体的标注框的IoU。IoU 越高,标注越一致。

### 4.3 代码示例:计算数据集多样性

```python

import pandas as pd

# 读取训练集元数据

metadata = pd.read_csv('train_metadata.csv')

# 统计场景多样性

scenes = metadata['scene'].unique()

scene_counts = metadata['scene'].value_counts()

scene_diversity = len(scenes) / len(metadata)

# 计算物体大小分布

object_sizes = metadata['object_size'].unique()

object_size_counts = metadata['object_size'].value_counts()

# 分析光照条件分布

lighting_conditions = metadata['lighting_condition'].unique()

lighting_condition_counts = metadata['lighting_condition'].value_counts()

# 统计运动模式分布

motion_patterns = metadata['motion_pattern'].unique()

motion_pattern_counts = metadata['motion_pattern'].value_counts()

```

**逻辑分析:**

* 使用 Pandas 读取训练集元数据,其中包含场景、物体大小、光照条件和运动模式等信息。

* 计算场景多样性,即不同场景的比例。

* 计算物体大小分布,即不同物体大小的比例。

* 分析光照条件分布,即不同光照条件的比例。

* 统计运动模式分布,即不同运动模式的比例。

### 4.4 代码示例:计算标注准确性

```python

import numpy as np

# 加载标注框

ground_truth_boxes = np.load('ground_truth_boxes.npy')

predicted_boxes = np.load('predicted_boxes.npy')

# 计算IoU

ious = np.zeros((len(ground_truth_boxes), len(predicted_boxes)))

for i in range(len(ground_truth_boxes)):

for j in range(len(predicted_boxes)):

ious[i, j] = compute_iou(ground_truth_boxes[i], predicted_boxes[j])

# 计算平均IoU

mean_iou = np.mean(ious)

```

**逻辑分析:**

* 加载真实物体边界框和预测边界框。

* 计算每个真实物体边界框与所有预测边界框之间的IoU。

* 计算所有IoU的平均值作为标注准确性的度量。

### 4.5 代码示例:计算标注一致性

```python

import numpy as np

# 加载不同标注人员的标注框

annotator1_boxes = np.load('annotator1_boxes.npy')

annotator2_boxes = np.load('annotator2_boxes.npy')

# 计算IoU

ious = np.zeros((len(annotator1_boxes), len(annotator2_boxes)))

for i in range(len(annotator1_boxes)):

for j in range(len(annotator2_boxes)):

ious[i, j] = compute_iou(annotator1_boxes[i], annotator2_boxes[j])

# 计算平均IoU

mean_iou = np.mean(ious)

```

**逻辑分析:**

* 加载不同标注人员的标注框。

* 计算每个标注人员的标注框与所有其他标注人员的标注框之间的IoU。

* 计算所有IoU的平均值作为标注一致性的度量。

# 5. YOLO视频检测训练集实践

### 5.1 训练集构建流程

**步骤 1:收集视频数据**

- 使用爬虫或手动下载公开数据集(如 YouTube-VOS、DAVIS)

- 考虑视频内容的多样性,包括场景、动作、对象大小和形状

**步骤 2:标注视频帧**

- 选择标注工具(如 LabelImg、VOTT)

- 定义标注类别(例如,目标对象、背景)

- 逐帧标注视频帧,包括边界框和类别标签

**步骤 3:数据增强**

- 应用数据增强技术,如随机裁剪、旋转、翻转

- 增强数据集的多样性,提高模型鲁棒性

**步骤 4:数据格式转换**

- 将标注数据转换为 YOLO 训练集格式(例如,VOC 或 COCO)

- 确保数据格式符合训练算法的要求

**步骤 5:数据归一化**

- 对图像像素值进行归一化,通常使用均值和标准差归一化

- 提高模型收敛速度和稳定性

### 5.2 训练集优化技巧

**技巧 1:增加数据集大小**

- 收集更多视频数据,增加训练集规模

- 提高模型泛化能力,处理更多场景和对象

**技巧 2:提高标注质量**

- 采用一致的标注准则,确保标注准确性

- 使用多个标注员进行交叉验证,减少标注错误

**技巧 3:优化数据增强策略**

- 根据数据集特性调整数据增强参数

- 避免过度增强,防止引入噪声和降低模型性能

**技巧 4:使用预训练模型**

- 使用在 ImageNet 等通用数据集上预训练的模型作为初始权重

- 减少训练时间,提高模型收敛速度

0

0