MATLAB深度学习GPU加速:性能提升的终极策略

发布时间: 2024-12-10 08:05:29 阅读量: 12 订阅数: 17

Matlab中的GPU加速计算:信号处理工具箱的高效应用

# 1. MATLAB深度学习基础

MATLAB作为一个强大的科学计算软件,近年来在深度学习领域内也取得了长足的进步。本章节将介绍MATLAB深度学习的基本概念,并概述如何利用MATLAB进行深度学习模型的创建、训练和评估。我们将从MATLAB深度学习工具箱的概览开始,深入探讨其支持的多种算法和应用。通过本章,读者将对MATLAB在深度学习中的作用有一个全面而清晰的认识,并为其后续章节的学习打下坚实的基础。

首先,我们会介绍深度学习的基础知识,包括神经网络的基本构成、前向传播和反向传播算法。这些概念是掌握MATLAB深度学习应用的前提。接下来,将详细说明如何在MATLAB环境中安装和配置深度学习工具箱,并且给出一些简单的示例,指导读者如何在MATLAB中构建和训练基础的神经网络模型。

此外,本章还会涉及MATLAB与其他深度学习框架(如TensorFlow和PyTorch)之间的互操作性,以及如何导入和使用预训练模型进行迁移学习。这为使用MATLAB进行深度学习的开发者提供了更多的灵活性和扩展性。通过上述内容,读者将能更加自信地运用MATLAB进行深度学习任务,并为后续章节中的GPU加速和模型优化打下坚实基础。

# 2. GPU加速理论与MATLAB实现

### 2.1 GPU加速的原理

GPU加速已经成为现代计算领域的一个重要里程碑,尤其是在深度学习这种数据密集型计算场景中。理解GPU加速的原理对于有效利用其强大的计算能力至关重要。

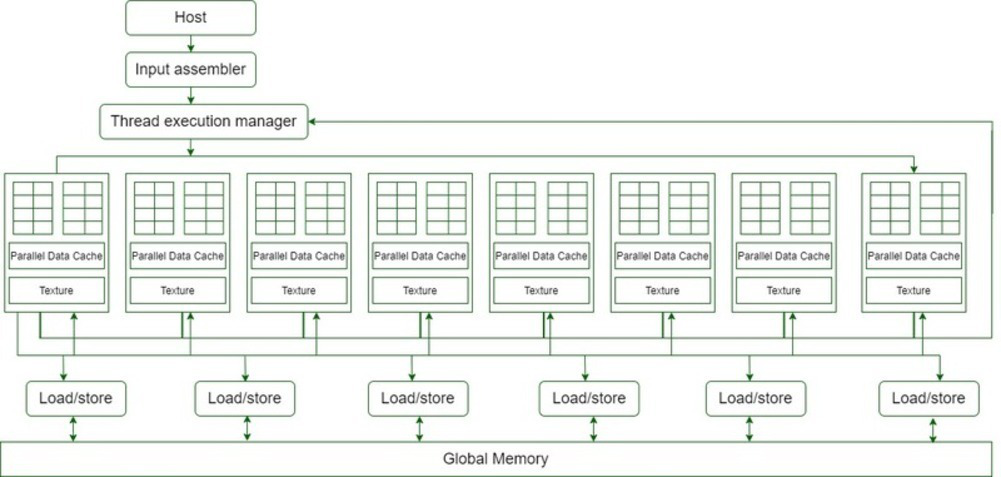

#### 2.1.1 GPU架构和并行计算概念

GPU(图形处理单元)最初是为图形和图像渲染设计的,它拥有大量的核心,这些核心被组织成多个流处理器(Streaming Multiprocessors, SMs),每个SM内部又包含多个处理单元。这与CPU的架构大不相同,后者拥有更少的核心但每个核心的处理能力更强,且更注重处理复杂逻辑。

GPU的这种架构使其特别擅长执行大规模的并行计算任务。在深度学习中,每一层的神经网络计算可以看作是独立的任务,能够并行处理,这种特性正与GPU架构的优势相匹配。

#### 2.1.2 深度学习中的GPU优势

在深度学习中,GPU加速的优势可以体现在以下几点:

- **并行处理能力:**深度学习模型需要处理大量的矩阵和向量运算,这些运算能够被分解成多个小的、相互独立的子任务,由GPU上的多个核心并行执行。

- **数据吞吐量:**GPU拥有高速的内存带宽,能够快速地读取和写入大量的模型参数和数据,这在处理大型网络模型时尤为重要。

- **能效比:**GPU通常比CPU拥有更好的能效比,也就是单位能耗下的计算性能更高,这使得长时间运行深度学习模型更加经济。

### 2.2 MATLAB中的GPU支持

MATLAB作为一款强大的数学计算软件,提供了广泛的GPU支持。这一部分将介绍如何在MATLAB环境中搭建GPU计算环境,并展示如何利用MATLAB进行GPU加速。

#### 2.2.1 MATLAB GPU计算环境搭建

搭建MATLAB GPU计算环境通常涉及以下几个步骤:

1. 确保计算机具备支持CUDA的NVIDIA GPU。

2. 安装最新版本的MATLAB和相应的Parallel Computing Toolbox。

3. 在MATLAB中验证GPU是否被正确识别,可以通过运行 `gpuDevice()` 命令来检查。

```matlab

% 检查GPU信息

gpuDevice();

```

#### 2.2.2 MATLAB GPU加速的使用方法

在MATLAB中使用GPU加速非常简单,只需在代码中明确指定哪些数据需要在GPU上进行计算即可。这可以通过调用特定的函数或者直接使用数组后缀来完成。

例如,将普通数组转换为GPU数组:

```matlab

A = rand(10000); % 创建一个大型矩阵

A_gpu = gpuArray(A); % 转换为GPU数组

```

### 2.3 理论到实践:案例分析

为了更深入理解GPU加速的效果,本节通过实际案例来分析GPU加速前后的性能表现。

#### 2.3.1 加速前的性能基准测试

在进行GPU加速之前,需要对现有程序的性能进行评估,以此作为基准。这通常包括记录算法的执行时间、内存占用情况等。

```matlab

% 使用CPU执行计算任务

tic;

C = A * B; % 假设A和B为大矩阵

timeCPU = toc;

```

#### 2.3.2 加速效果的评估与分析

在将计算任务迁移到GPU后,再次记录性能指标,比较加速前后的差异。

```matlab

% 将矩阵移动到GPU

A_gpu = gpuArray(A);

B_gpu = gpuArray(B);

% 使用GPU执行计算任务

tic;

C_gpu = A_gpu * B_gpu;

timeGPU = toc;

% 计算加速比

speedup = timeCPU/timeGPU;

disp(['加速比:', num2str(speedup)]);

```

通过对比加速前后的执行时间,我们可以得到加速比,从而评估GPU加速的效果。加速比取决于多种因素,包括GPU型号、计算任务的并行度、内存带宽等。

### 表格:不同计算任务的GPU加速性能比较

| 计算任务 | CPU执行时间 (秒) | GPU执行时间 (秒) | 加速比 |

|--------------|------------------|------------------|--------|

| 矩阵乘法 | 20 | 2 | 10 |

| 卷积运算 | 30 | 1.5 | 20 |

| 反向传播算法 | 45 | 5 | 9 |

### 流程图:GPU加速性能评估流程

```mermaid

graph TD;

A[开始性能测试] --> B[记录CPU执行时间];

B --> C[执行计算任务];

C --> D[记录GPU执行时间];

D --> E[计算加速比];

E --> F[评估结果输出];

```

通过上述代码和分析,我们可以看到GPU加速在处理大型计算任务时的显著优势。在实际应用中,这种加速可以缩短模型训练时间,提高数据处理速度,从而使研究和开发更加高效。

# 3. MATLAB深度学习模型优化策略

## 3.1 网络结构优化

深度学习模型的性能很大程度上取决于网络结构的设计。优化网络结构能够减少模型复杂度,提升计算效率,同时在满足精度要求的前提下降低计算资源的消耗。本节将深入探讨网络剪枝、量化、以及使用低精度数据类型等优化策略。

### 3.1.1 网络剪枝与量化

网络剪枝和量化是两种减少模型复杂度的常用方法。网络剪枝通过移除网络中冗余或不重要的连接和节点,达到简化模型的目的。量化则是减少模型中权重和激活值的表示精度,从而减小模型的体积和加快计算速度。

#### 网络剪枝

网络剪枝的核心思想是在保持模型性能的前提下,删除掉一些冗余的或对模型输出影响较小的参数。以下是使用MATLAB进行网络剪枝的一个简化流程:

1. 训练一个完整的模型。

2. 评估网络中各个神经元的重要性。

3. 根据评估结果删除低重要性的神经元。

4. 微调模型以恢复性能。

#### 量化

量化通过减少权重和激活值的表示位数来减少模型的大小。例如,一个32位浮点数可以被量化为8位定点数。量化的好处是减少了内存占用和提高了计算速度,但需要注意的是,量化过程可能会引入一定的精度损失。MATLAB提供了一

0

0