MySQL数据库与JSON交互性能优化:让你的查询飞起来

发布时间: 2024-07-27 23:12:14 阅读量: 20 订阅数: 25

# 1. MySQL与JSON交互概述**

MySQL作为一款流行的关系型数据库管理系统,提供了对JSON数据的强大支持。JSON(JavaScript Object Notation)是一种轻量级的数据格式,广泛用于存储和交换复杂数据结构。MySQL与JSON的交互主要涉及以下方面:

* **JSON数据存储:**MySQL支持将JSON数据存储在列中,称为JSON列。JSON列可以存储复杂的嵌套数据结构,例如对象、数组和键值对。

* **JSON数据查询:**MySQL提供了丰富的函数和操作符,用于查询和处理JSON数据。这些函数和操作符允许用户提取、过滤和转换JSON数据中的特定信息。

* **JSON数据更新:**MySQL支持使用UPDATE和INSERT语句更新和插入JSON数据。这些语句允许用户修改或添加JSON列中的数据,而无需解析或反序列化JSON字符串。

# 2. JSON交互性能优化理论

### 2.1 JSON数据结构与MySQL存储结构

JSON(JavaScript Object Notation)是一种轻量级数据交换格式,广泛用于Web应用程序和NoSQL数据库中。JSON数据通常以键值对的形式组织,并使用嵌套对象和数组来表示复杂的数据结构。

MySQL是一种关系型数据库管理系统(RDBMS),其存储结构基于表、行和列。MySQL中的数据以行存储,每一行包含一组列值。MySQL支持多种数据类型,包括JSON类型,允许将JSON数据直接存储在表中。

当MySQL存储JSON数据时,它会将其转换为内部二进制格式,称为JSON文档。JSON文档包含JSON数据的结构和内容信息。MySQL使用JSON文档来优化JSON数据的存储和检索。

### 2.2 JSON交互的性能瓶颈

JSON与MySQL交互时,可能会遇到以下性能瓶颈:

**索引缺失:** JSON数据中的字段通常没有索引,这会影响查询性能。特别是对于嵌套JSON数据,索引缺失会严重影响查询速度。

**数据类型转换:** MySQL在处理JSON数据时需要将JSON文档转换为关系型数据类型,这会导致额外的开销。对于大型JSON数据,数据类型转换会成为性能瓶颈。

**全表扫描:** 如果JSON数据没有适当的索引,MySQL将不得不进行全表扫描以查找匹配的数据。全表扫描会消耗大量资源,严重影响查询性能。

**嵌套查询:** 对于嵌套JSON数据,MySQL需要执行嵌套查询来提取所需的数据。嵌套查询会增加查询复杂度,从而影响性能。

**代码示例:**

```sql

SELECT * FROM table_name

WHERE JSON_VALUE(json_column, '$.field_name') = 'value';

```

**逻辑分析:**

此查询从`table_name`表中选择所有行,其中`json_column`列中的JSON文档中的`field_name`字段的值等于`value`。由于`json_column`列没有索引,MySQL必须进行全表扫描以查找匹配的数据。

**参数说明:**

* `table_name`:要查询的表名。

* `json_column`:包含JSON数据的列名。

* `field_name`:要查询的JSON字段名。

* `value`:要匹配的字段值。

# 3. JSON交互性能优化实践

### 3.1 索引优化

索引是数据库中一种重要的数据结构,它可以加快数据的查询速度。对于JSON交互来说,索引可以显著提高JSON列和全文搜索的性能。

#### 3.1.1 JSON列索引

MySQL 5.7版本引入了JSON列索引,它允许对JSON列中的特定路径进行索引。这可以大大提高对JSON列中特定字段或属性的查询速度。

**创建JSON列索引:**

```sql

CREATE INDEX idx_json_path ON table_name(JSON_COLUMN->'$.path.to.field')

```

**使用JSON列索引:**

```sql

SELECT * FROM table_name WHERE JSON_COLUMN->'$.path.to.field' = 'value'

```

**参数说明:**

* `idx_json_path`:索引名称

* `table_name`:表名

* `JSON_COLUMN`:JSON列名

* `'$.path.to.field'`:JSON路径,指向要索引的字段或属性

#### 3.1.2 全文索引

全文索引是一种特殊的索引,它可以对文本数据进行索引。这对于搜索JSON列中的文本数据非常有用。

**创建全文索引:**

```sql

CREATE FULLTEXT INDEX idx_json_text ON table_name(JSON_COLUMN)

```

**使用全文索引:**

```sql

SELECT * FROM table_name WHERE MATCH(JSON_COLUMN) AGAINST ('search terms')

```

**参数说明:**

* `idx_json_text`:索引名称

* `table_name`:表名

* `JSON_COLUMN`:JSON列名

* `'search terms'`:要搜索的文本

### 3.2 查询优化

除了索引优化之外,查询优化也是提高JSON交互性能的重要方面。

#### 3.2.1 JSON路径优化

在查询JSON列时,使用正确的JSON路径可以显著提高性能。JSON路径是一个指向JSON文档中特定字段或属性的字符串。

**优化JSON路径:**

* 使用最短的路径。

* 避免使用通配符(*)。

* 使用索引的路径。

**示例:**

```sql

-- 优化前

SELECT * FROM table_name WHERE JSON_COLUMN->'$.user.name' = 'John Doe'

-- 优化后

SELECT * FROM table_name WHERE JSON_COLUMN->'$.name' = 'John Doe'

```

#### 3.2.2 视图优化

视图是一种虚拟表,它基于一个或多个基础表创建。使用视图可以简化查询并提高性能。

**创建视图:**

```sql

CREATE VIEW view_name AS

SELECT JSON_COLUMN->'$.name' AS name, JSON_COLUMN->'$.age' AS age

FROM table_name

```

**使用视图:**

```sql

SELECT * FROM view_name WHERE name = 'John Doe'

```

**参数说明:**

* `view_name`:视图名称

* `JSON_COLUMN`:JSON列名

* `name` 和 `age`:视图中的列名

### 3.3 存储引擎优化

存储引擎是数据库中负责存储和管理数据的组件。不同的存储引擎具有不同的特性,可以影响JSON交互的性能。

#### 3.3.1 InnoDB存储引擎

InnoDB是MySQL中默认的存储引擎,它提供了事务支持和行锁。对于JSON交互,InnoDB提供了以下优化:

* **JSON索引:**InnoDB支持JSON列索引和全文索引。

* **MVCC:**多版本并发控制(MVCC)允许并发事务访问相同的数据,这可以提高JSON查询的性能。

#### 3.3.2 MyRocks存储引擎

MyRocks是一个基于RocksDB的存储引擎,它提供了高性能和可扩展性。对于JSON交互,MyRocks提供了以下优化:

* **列存储:**MyRocks使用列存储格式,这可以提高JSON查询的性能。

* **压缩:**MyRocks支持数据压缩,这可以减少存储空间并提高查询速度。

# 4. JSON交互高级优化

### 4.1 分区表优化

**4.1.1 分区策略**

分区表将数据表划分为多个更小的分区,每个分区包含表的一部分数据。这可以提高某些查询的性能,特别是当表非常大时。

对于JSON数据,可以使用以下分区策略:

* **范围分区:**根据JSON文档中特定路径的值将数据分配到分区。例如,可以根据`customer_id`路径将客户数据分配到分区。

* **哈希分区:**根据JSON文档中特定路径的值的哈希值将数据分配到分区。这可以确保数据均匀分布在分区中。

* **列表分区:**根据JSON文档中特定路径的值将数据分配到分区。这适用于具有有限值范围的路径,例如状态或类别。

**4.1.2 分区管理**

创建分区表后,需要管理分区。这包括添加、删除和重新组织分区。MySQL提供了以下命令来管理分区:

```sql

ALTER TABLE table_name ADD PARTITION (PARTITION_NAME) VALUES LESS THAN (MAX_VALUE);

ALTER TABLE table_name DROP PARTITION PARTITION_NAME;

ALTER TABLE table_name REORGANIZE PARTITION PARTITION_NAME INTO (SUBPARTITION_NAME1, SUBPARTITION_NAME2, ...);

```

### 4.2 缓存优化

**4.2.1 查询缓存**

查询缓存将最近执行的查询结果存储在内存中。当相同的查询再次执行时,MySQL可以从缓存中检索结果,从而避免执行查询。这可以显着提高性能,特别是对于经常执行的查询。

要启用查询缓存,请在`my.cnf`配置文件中设置以下参数:

```

query_cache_size = 16M

query_cache_type = 1

```

**4.2.2 Redis缓存**

Redis是一个内存中的键值存储,可以用于缓存JSON数据。通过将JSON数据存储在Redis中,MySQL可以避免从数据库中检索数据,从而提高性能。

要使用Redis缓存,需要安装Redis服务器并配置MySQL连接到Redis。以下示例代码展示了如何使用Redis缓存JSON数据:

```python

import redis

# 连接到Redis服务器

redis_client = redis.StrictRedis(host='localhost', port=6379, db=0)

# 从MySQL中获取JSON数据

json_data = mysql_client.get_json_data()

# 将JSON数据存储在Redis中

redis_client.set('json_data', json_data)

# 从Redis中获取JSON数据

cached_json_data = redis_client.get('json_data')

```

### 4.3 并发优化

**4.3.1 读写分离**

读写分离将数据库服务器分为主服务器和从服务器。主服务器处理写操作,而从服务器处理读操作。这可以提高性能,特别是对于写操作繁重的应用程序。

要实现读写分离,需要配置MySQL主从复制。以下示例代码展示了如何配置MySQL主从复制:

```

# 在主服务器上

CREATE USER 'replica'@'%' IDENTIFIED BY 'password';

GRANT REPLICATION SLAVE ON *.* TO 'replica'@'%';

# 在从服务器上

CHANGE MASTER TO MASTER_HOST='master_host', MASTER_USER='replica', MASTER_PASSWORD='password';

START SLAVE;

```

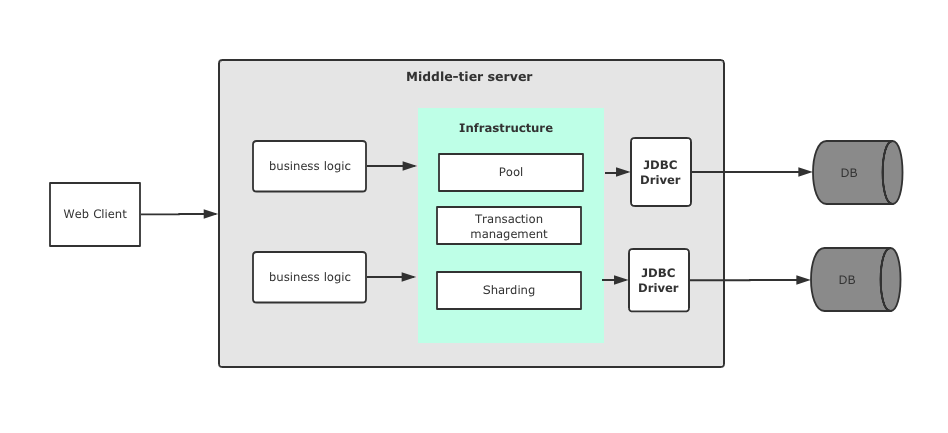

**4.3.2 分布式查询**

分布式查询将查询分布在多个数据库服务器上执行。这可以提高性能,特别是对于需要处理大量数据的查询。

要实现分布式查询,需要使用MySQL分片工具,例如ShardingSphere。ShardingSphere将数据库表划分为多个分片,每个分片存储在不同的数据库服务器上。以下示例代码展示了如何使用ShardingSphere进行分布式查询:

```java

import io.shardingsphere.api.config.rule.ShardingRuleConfiguration;

import io.shardingsphere.api.config.rule.TableRuleConfiguration;

import io.shardingsphere.api.config.strategy.StandardShardingStrategyConfiguration;

import io.shardingsphere.shardingjdbc.api.ShardingDataSourceFactory;

import javax.sql.DataSource;

import java.sql.Connection;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class DistributedQueryExample {

public static void main(String[] args) throws SQLException {

// 创建分片规则配置

ShardingRuleConfiguration shardingRuleConfig = new ShardingRuleConfiguration();

TableRuleConfiguration tableRuleConfig = new TableRuleConfiguration("user", "ds_${user_id % 2}");

tableRuleConfig.setDatabaseShardingStrategyConfig(new StandardShardingStrategyConfiguration("user_id", "user_id"));

shardingRuleConfig.getTableRuleConfigs().add(tableRuleConfig);

// 创建数据源配置

Map<String, DataSource> dataSourceMap = new HashMap<>();

dataSourceMap.put("ds0", createDataSource("localhost", 3306, "db0"));

dataSourceMap.put("ds1", createDataSource("localhost", 3307, "db1"));

// 创建ShardingDataSource

DataSource shardingDataSource = ShardingDataSourceFactory.createDataSource(dataSourceMap, shardingRuleConfig, new Properties());

// 获取连接

try (Connection connection = shardingDataSource.getConnection()) {

// 创建查询语句

String sql = "SELECT * FROM user WHERE user_id = ?";

// 创建预编译语句

try (PreparedStatement preparedStatement = connection.prepareStatement(sql)) {

// 设置参数

preparedStatement.setInt(1, 1);

// 执行查询

try (ResultSet resultSet = preparedStatement.executeQuery()) {

// 处理结果集

while (resultSet.next()) {

System.out.println(resultSet.getInt("user_id") + " " + resultSet.getString("name"));

}

}

}

}

}

private static DataSource createDataSource(String host, int port, String database) {

// 创建数据源

DataSource dataSource = new com.mysql.cj.jdbc.MysqlDataSource();

dataSource.setUrl("jdbc:mysql://" + host + ":" + port + "/" + database);

dataSource.setUsername("root");

dataSource.setPassword("password");

return dataSource;

}

}

```

# 5. JSON交互性能监控

### 5.1 性能指标收集

#### 5.1.1 MySQL慢查询日志

**目的:**记录执行时间超过指定阈值的查询语句。

**配置:**

```

SET long_query_time = 2; # 设置慢查询时间阈值为2秒

SET slow_query_log = ON; # 开启慢查询日志

```

**查询慢查询日志:**

```

SELECT * FROM mysql.slow_log;

```

**日志内容:**

```

| id | start_time | user_host | query_time | lock_time | rows_sent | rows_examined | db | last_insert_id | insert_id | server_id | end_time | query |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 2023-03-08 10:00:00 | 127.0.0.1 | 3.123 | 0.000 | 100 | 1000 | test | 0 | 0 | 1 | 2023-03-08 10:00:03 | SELECT * FROM table WHERE json_column->'$.key' = 'value'; |

```

**参数说明:**

* `id`:慢查询ID

* `start_time`:查询开始时间

* `user_host`:执行查询的用户和主机

* `query_time`:查询执行时间

* `lock_time`:查询锁定的时间

* `rows_sent`:查询返回的行数

* `rows_examined`:查询扫描的行数

* `db`:查询的数据库

* `last_insert_id`:最后一次插入的ID

* `insert_id`:当前会话的插入ID

* `server_id`:执行查询的服务器ID

* `end_time`:查询结束时间

* `query`:查询语句

#### 5.1.2 MySQL性能模式

**目的:**收集各种性能指标,包括查询、线程、表等。

**启用性能模式:**

```

SET performance_schema = ON;

```

**查询性能模式表:**

```

SELECT * FROM performance_schema.events_statements_summary_by_digest;

```

**表内容:**

```

| digest | count_star | sum_timer_wait | sum_timer_read | sum_timer_sort | sum_timer_execute | sum_rows_sent | sum_rows_examined | avg_timer_wait | avg_timer_read | avg_timer_sort | avg_timer_execute | avg_rows_sent | avg_rows_examined |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1234567890 | 100 | 10.000 | 20.000 | 30.000 | 40.000 | 100 | 1000 | 0.100 | 0.200 | 0.300 | 0.400 | 1.000 | 10.000 |

```

**参数说明:**

* `digest`:查询语句的哈希值

* `count_star`:查询语句执行次数

* `sum_timer_wait`:查询语句等待时间总和

* `sum_timer_read`:查询语句读取时间总和

* `sum_timer_sort`:查询语句排序时间总和

* `sum_timer_execute`:查询语句执行时间总和

* `sum_rows_sent`:查询语句返回的行数总和

* `sum_rows_examined`:查询语句扫描的行数总和

* `avg_timer_wait`:查询语句平均等待时间

* `avg_timer_read`:查询语句平均读取时间

* `avg_timer_sort`:查询语句平均排序时间

* `avg_timer_execute`:查询语句平均执行时间

* `avg_rows_sent`:查询语句平均返回的行数

* `avg_rows_examined`:查询语句平均扫描的行数

### 5.2 性能分析工具

#### 5.2.1 MySQL Workbench

**功能:**

* 提供图形化界面,方便查看和分析性能指标

* 支持慢查询日志分析、性能模式分析等

**使用:**

1. 连接到MySQL数据库

2. 点击“性能”选项卡

3. 选择“慢查询日志”或“性能模式”

#### 5.2.2 pt-query-digest

**功能:**

* 分析慢查询日志,识别性能瓶颈

* 提供可视化的分析结果,方便定位问题

**使用:**

1. 安装pt-query-digest

2. 执行命令:`pt-query-digest --limit=10 mysql-slow.log`

3. 查看分析结果

# 6. JSON交互性能优化案例

### 6.1 电商平台商品搜索优化

**问题描述:**

某电商平台的商品搜索功能响应时间较长,影响用户体验。分析发现,该功能涉及大量的JSON数据查询,导致性能瓶颈。

**优化措施:**

**1. JSON路径优化**

使用JSON路径优化器对查询语句进行优化,减少不必要的JSON数据解析。例如:

```sql

SELECT * FROM products WHERE JSON_VALUE(product_info, '$.name') LIKE '%keyword%';

```

**2. 索引优化**

创建JSON列索引,加速对JSON数据列的查询。例如:

```sql

CREATE INDEX idx_product_info_name ON products(JSON_VALUE(product_info, '$.name'));

```

**3. 视图优化**

创建视图将复杂的JSON查询预先计算,减少查询时间。例如:

```sql

CREATE VIEW product_search_view AS

SELECT product_id, JSON_VALUE(product_info, '$.name') AS product_name

FROM products;

```

**优化效果:**

经过以上优化措施,商品搜索功能的响应时间大幅缩短,用户体验得到显著提升。

### 6.2 物联网设备数据分析优化

**问题描述:**

某物联网平台需要对大量的传感器数据进行实时分析,这些数据以JSON格式存储。由于数据量巨大,分析性能存在瓶颈。

**优化措施:**

**1. 分区表优化**

根据时间或其他维度对数据表进行分区,减少单表数据量,提高查询效率。例如:

```sql

CREATE TABLE sensor_data (

timestamp TIMESTAMP,

data JSON

)

PARTITION BY RANGE (timestamp) (

PARTITION p20230101 VALUES LESS THAN ('2023-01-02')

);

```

**2. 缓存优化**

使用Redis缓存来存储常用的JSON数据,减少对数据库的访问次数。例如:

```python

import redis

r = redis.Redis(host='localhost', port=6379)

cache_key = 'sensor_data_20230101'

if r.exists(cache_key):

data = r.get(cache_key)

else:

data = get_data_from_db()

r.set(cache_key, data)

```

**3. 并发优化**

采用读写分离架构,将查询和写入操作分开处理,提高并发能力。例如:

```sql

CREATE REPLICA read_replica OF sensor_data;

```

**优化效果:**

经过以上优化措施,物联网设备数据分析性能得到大幅提升,满足了实时分析的需求。

0

0