【大数据开源技术栈面试深入理解】:开源工具与框架,构建你的技术自信

发布时间: 2024-12-17 18:51:37 阅读量: 8 订阅数: 6

参考资源链接:[尚硅谷大数据技术高频面试题精华汇总V9.0.5](https://wenku.csdn.net/doc/4tg66j98op?spm=1055.2635.3001.10343)

# 1. 大数据开源技术概览

## 1.1 大数据技术的兴起与定义

大数据技术是处理和分析海量数据集以揭示隐藏模式、未知相关性和其它有用信息的方法论。随着数据量的爆发性增长,大数据技术成为挖掘业务价值、提高竞争力的必备工具。

## 1.2 开源技术在大数据中的角色

开源技术提供了灵活、成本效益高的解决方案,推动了大数据的普及。它鼓励社区协作,不断优化和创新,为大数据生态系统贡献了大量关键组件。

## 1.3 大数据开源技术的分类

大数据开源技术可以分为数据存储、数据处理、数据计算、数据管理和数据分析等类别。这些技术相互配合,共同构建了一个高效的大数据处理平台。

- 数据存储技术如HDFS、Cassandra等,支持可靠的数据存储与快速访问。

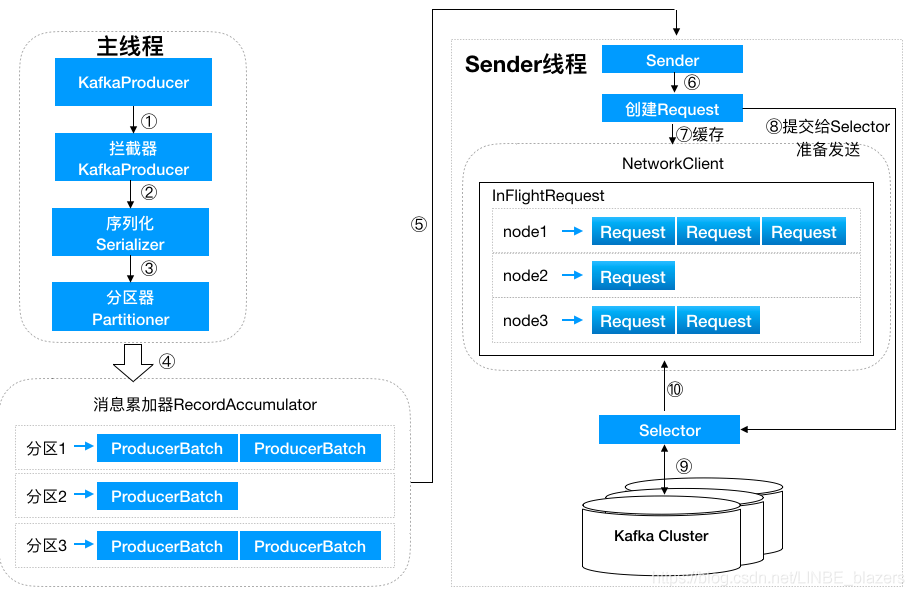

- 数据处理技术涉及数据转换、清洗和预处理,常用的工具包括Apache Kafka和Apache Spark。

- 数据计算技术像Hadoop MapReduce、Apache Flink提供了强大的数据处理能力。

- 数据管理技术如Apache Hive和Delta Lake优化数据查询和分析。

- 数据分析技术则涉及使用机器学习库进行数据洞察,如Spark MLlib。

本章将为读者提供一个全面的大数据开源技术概览,为深入探讨各种技术框架奠定基础。

# 2. ```

# 第二章:分布式计算框架深入剖析

在第一章中,我们对大数据的开源技术进行了概览,本章将深入分析分布式计算框架,探讨其核心组件、架构原理以及在实际应用中的优化方法。分布式计算框架是大数据处理不可或缺的技术基础,为数据存储、计算和分析提供了强大的支持。

## 2.1 Hadoop生态系统

Hadoop作为大数据领域的重要生态系统,其核心组件HDFS和MapReduce为海量数据的存储和处理提供了可能。

### 2.1.1 Hadoop核心组件解析

Hadoop的核心组件包括HDFS(Hadoop Distributed File System)和MapReduce。

- **HDFS(Hadoop Distributed File System)**

HDFS是Hadoop的主要存储系统。它被设计为能够存储大量数据,并能在廉价的硬件上运行。它将大文件分割成固定大小的块,并将这些块分散存储在集群中的不同节点上,从而提供高吞吐量的数据访问。

- **MapReduce**

MapReduce是一种编程模型,用于处理和生成大数据集的并行算法。它将应用程序分成两个阶段:Map阶段和Reduce阶段。Map阶段处理输入数据,生成中间键值对。Reduce阶段则将这些键值对按键进行合并。

### 2.1.2 MapReduce编程模型详解

MapReduce编程模型的设计目的是简化大规模数据集的并行运算。在MapReduce中,程序员只需关注编写Map和Reduce两个函数,框架负责处理作业调度、数据分配和错误恢复等复杂任务。

- **Map函数**

Map函数接收输入数据,并将它们转换成键值对。Map函数处理数据的逻辑是编写MapReduce程序的关键部分。

```java

// 示例:Map函数

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

```

- **Reduce函数**

Reduce函数接收Map函数的输出作为输入,并进一步处理这些数据。它将相同键的所有值组合起来进行合并处理。

```java

// 示例:Reduce函数

reduce(String key, Iterator values):

// key: a word

// values: a list of counts

int result = 0;

for each val in values:

result += ParseInt(val);

Emit(key, String(result));

```

## 2.2 Spark的内存计算优势

Spark作为Hadoop生态系统中的后起之秀,其突出的内存计算能力,大大提升了大数据处理的效率。

### 2.2.1 Spark架构与组件

Apache Spark的主要组件包括Spark Core、Spark SQL、Spark Streaming、MLlib和GraphX。

- **Spark Core**

Spark Core是Spark的基石,提供了任务调度、内存管理和基本的I/O功能。

- **Spark SQL**

Spark SQL支持结构化数据查询和处理,提供了DataFrame和DataSet API,使得SQL操作与Spark程序紧密集成。

- **Spark Streaming**

Spark Streaming支持实时数据流处理,能够将流数据作为一系列小批次处理。

- **MLlib**

MLlib是Spark提供的机器学习库,为常见的机器学习任务提供了算法和工具。

- **GraphX**

GraphX是Spark上的图处理库,用于进行大规模图计算和分析。

### 2.2.2 RDD的原理与操作

弹性分布式数据集(RDD)是Spark的核心抽象,它是一个不可变、分布式的数据集合,可以进行并行操作。

- **RDD的创建**

用户可以通过读取外部数据集或在内存数据集上使用转换操作来创建RDD。

```python

# 示例:RDD的创建

rdd = sc.parallelize([1, 2, 3, 4])

```

- **RDD的操作**

RDD支持两种类型的操作:转换(Transformation)和行动(Action)。转换操作返回一个新的RDD,而行动操作则触发计算并返回结果。

```python

# 示例:RDD转换操作

rdd_squared = rdd.map(lambda x: x * x)

# 示例:RDD行动操作

result = rdd_squared.collect()

```

## 2.3 Flink的流处理能力

Flink是当前快速发展的分布式流处理框架,其特点在于处理速度快,且支持高吞吐、低延迟的数据处理。

### 2.3.1 Flink架构特点

Flink拥有独特的事件驱动和时间控制的架构特点。其运行时架构包括JobManager和TaskManager。

- **JobManager**

JobManager负责整个Flink作业的调度和资源分配。

- **TaskManager**

TaskManager负责实际执行数据处理任务。每个TaskManager拥有多个任务槽(task slots),用于并行处理数据。

### 2.3.2 Flink的时间窗口与事件处理

Flink支持灵活的时间窗口操作,如滚动窗口、滑动窗口和会话窗口,这对于流处理场景来说非常关键。

- **时间窗口**

时间窗口可以将无界流划分成有限大小的块,以便于并行计算和分批处理。

```java

// 示例:Flink时间窗口

stream

.keyBy(<key selector>)

.window(<window assigner>)

.reduce(<window function>);

```

- **事件处理**

Flink提供了丰富的事件处理操作,例如Watermark(水位线)来处理乱序事件,以及Allowed Lateness和side outputs处理延迟数据。

在本章节的深入剖析中,我们可以看到,每个分布式计算框架都致力于解决大数据领域的不同挑战。Hadoop通过HDFS和MapReduce提供了一种可靠、扩展性强的计算方式;Spark通过RDD模型优化了数据处理的效率;而Flink则以其流处理能力,成为实时数据分析的首选工具。在后续的章节中,我们将继续探讨数据存储与管理框架,以及数据处理与分析的实践技巧。

```

# 3. 数据存储与管理框架探究

## 3.1 NoSQL数据库的选择与应用

### 3.1.1 MongoDB的文档存储特性

MongoDB是一种流行的NoSQL数据库,它采用面向文档的方式存储数据,提供了灵活的数据模型。这种文档存储方式与传统的关系型数据库相比,有以下几个特点:

- **动态模式**:不需要预定义数据模型,可以在数据结构变化时进行轻松的扩展。

- **灵活的数据表示**:可以存储层次化的文档,支持数组和其他复杂的数据结构。

- **高性能**:由于其基于内存的设计和优化,对于读写频繁的操作,MongoDB表现得很好。

- **全文搜索与地理空间索引**:MongoDB支持全文搜索和地理空间索引,便于开发需要高级查询的应用程序。

在实际应用中,MongoDB通常用于以下场景:

- **内容管理**:存储不同类型的数据,如博客文章、评论和标签等。

- **用户数据管理**:存储用户个人资料、会话信息等。

- **数据分析**:存储日志数据、事件数据等,便于进行实时分析。

MongoDB的查询语言功能强大,支持聚合框架,可以执行复杂的数据处理任务。例如,下面的MongoDB查询语句可以获取所有年龄在30岁以上的用户:

```javascript

db.users.find({ "age": { "$gt": 30 }})

```

### 3.1.2 Cassandra的分布式架构

Apache Cassandra是一个开源的分布式NoSQL数据库管理系统,它专为高可用性、可扩展性和灵活的数据分布设计。以下是Cassandra的一些核心特性:

- **高可用性和容错性**:Cassandra采用了去中心化的分布式架构,不存在单点故障。

- **无单点瓶颈**:数据均匀分布在多个节点上,保证了系统的高吞吐量。

- **灵活的数据模型**:支持多模型数据,如键值、列族和宽列存储。

- **可扩展性**:增加新节点可以水平扩展,不影响现有服务的运行。

在构建可扩展的应用程序时,Cassandra提供了基于规则的复制策略,可以优化数据分布,以适应不断变化的工作负载。例如,可以根据地理位置分布数据副本,以减少数据访问延迟。

```bash

CREATE KEYSPACE IF NOT EXISTS my_keyspace WITH replication = {'class': 'SimpleStrategy', 'replication_factor': '3'};

```

## 3.2 数据仓库与OLAP工具

### 3.2.1 Apache Hive的数据仓库功能

Apache Hive是一个数据仓库基础架构,建立在Hadoop之上,提供数据摘要、查询和分析。Hive定义了类SQL语言HiveQL,允许熟悉SQL的用户查询和管理大规模数据集。下面是Hive的几个关键特性:

- **SQL-like查询语言**:HiveQL是一种类SQL语言,允许用户以SQL的习惯来操作Hadoop数据。

- **元数据管理**:Hive提供了元数据存储,能够跟踪数据的位置、格式和结构。

- **可扩展性**:能够处理PB级别的数据,并且通过增加节点能够提升查询性能。

通过HiveQL,可以创建表、加载数据、执行查询等操作。例如,下面的HiveQL语句展示了如何创建一个外部表并查询数据:

```sql

CREATE EXTERNAL TABLE IF NOT EXISTS employees (

id int,

name string,

age int,

department string

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE

LOCATION '/data/employees';

SELECT * FROM employees WHERE department = 'engineering';

```

### 3.2.2 Druid的实时分析能力

Druid是一个开源的分布式数据存储和分析系统,特别适合于需要即时查询和分析大量数据的场景。它的关键特性包括:

- **实时数据加载**:支持实时数据摄取,数据几乎可以立即被查询。

- **近实时分析**:数据在摄取后会进行聚合,以支持快速查询。

- **水平可扩展**:系统设计允许通过增加节点来提高吞吐量和存储能力。

- **鲁棒性**:数据存储在多副本上,确保高可用性和容错性。

Druid通过其独特的数据结构,结合索引和段的分层设计,使得它在处理时间序列数据方面非常高效。Druid不仅可以处理常规的查询,还支持复杂的多维聚合查询和JSON数据查询。

```json

{

"queryType": "groupBy",

"dataSource": "sample_data",

"dimensions": ["userId"],

"granularity": "day",

"aggregations": [

{

"type": "count",

"name": "count"

}

],

"intervals": ["2021-01-01T00/2021-01-03T00"]

}

```

## 3.3 数据湖技术与实践

### 3.3.1 Hadoop HDFS在数据湖中的应用

Hadoop分布式文件系统(HDFS)是构建数据湖的基础。HDFS能够存储大量的非结构化和半结构化数据,为数据湖提供了一种可靠且扩展性强的存储解决方案。HDFS的关键特性包括:

- **高容错性**:通过数据冗余在多个节点上存储数据副本。

- **高吞吐量**:优化设计能够支持大规模数据集的快速读写操作。

- **横向扩展能力**:随着集群规模的增长,其存储和计算能力线性增加。

HDFS广泛应用于数据湖的底层存储架构中,使得企业能够收集和保存所有原始数据,而无需担心数据的格式或结构。下面是一个HDFS的基本使用案例:

```shell

hadoop fs -mkdir /data-lake

hadoop fs -put sample_data /data-lake

```

### 3.3.2 Delta Lake的数据管理优化

Delta Lake是建立在HDFS之上的开源存储层,它为数据湖提供了事务性的能力,解决了数据湖中常见的脏数据问题。Delta Lake的特性包括:

- **ACID事务**:提供了完整的事务支持,确保数据的一致性和准确性。

- **数据版本控制**:可以跟踪数据的历史版本,便于进行数据回滚或时间旅行查询。

- **元数据管理**:集成元数据和数据管理功能,简化了数据湖的治理。

- **扩展性**:与大数据处理引擎(如Apache Spark)无缝集成,保证了处理能力。

通过Delta Lake,用户可以轻松构建一个既可靠又高效的数据湖。下面是一个使用Delta Lake进行数据写入和读取操作的示例:

```python

from delta import *

df = spark.read.format("csv").load("data.csv")

# 创建一个Delta Lake表

df.write.format("delta").save("/data-lake/delta-table")

# 读取并查询Delta Lake表

df = spark.read.format("delta").load("/data-lake/delta-table")

display(df)

```

通过对数据湖技术的探究,我们可以看到,Hadoop HDFS作为数据湖的底层存储,提供了大规模数据存储的能力。而Delta Lake作为数据湖的上层,提供了数据管理的优化,使得在数据湖中的数据操作更加高效和可靠。

通过本章的深入探讨,我们揭示了NoSQL数据库、数据仓库、OLAP工具以及数据湖技术在数据存储与管理中的关键角色。每一项技术都有其独特的应用场景和优势,企业可以根据自身的数据处理需求,选择合适的工具和框架,以实现高效的数据存储与管理。在下一章中,我们将深入数据分析与处理的实践环节,探讨如何将这些存储和管理技术应用于实际的数据分析场景中。

# 4. 数据处理与分析实践

在本章,我们将深入探讨数据处理与分析的具体实践方法,了解如何将理论知识应用于真实世界的场景,以及如何解决实际问题。

## 4.1 数据清洗与预处理技术

数据清洗和预处理是数据处理中的关键步骤,目的是提高数据质量,保证分析结果的准确性。

### 4.1.1 ETL工具与流程设计

ETL(Extract, Transform, Load)是数据仓库领域中的一个重要概念,它代表了从各种不同的数据源中提取数据,清洗转换数据,然后加载到数据仓库中去的整个过程。

#### ETL 工具的选择

在众多的ETL工具中,有开源的也有商业的。对于大数据的处理,一些流行的开源ETL工具如Apache NiFi,Kettle(Pentaho Data Integration),和Talend等。

**Apache NiFi**

Apache NiFi是为易用性、可靠性和扩展性而设计的系统,它允许用户轻松地设计、执行和监控ETL流程。NiFi采用了基于Web的用户界面以及强大的数据流控制和内置的多线程处理。

**代码示例:**

```xml

# Apache NiFi Processor XML配置片段

<flow>

<processor class="org.apache.nifi.processors.standard.FetchHttp">

<property name="URL">http://example.com/data.json</property>

<property name="Destination">file:///path/to/local/file</property>

</processor>

<processor class="org.apache.nifi.processors.standard.JSONPathReader">

<property name="JSON Path Expression">$.data[*]</property>

</processor>

</flow>

```

在这个示例中,我们使用了NiFi的FetchHttp处理器来从URL获取数据,并将其保存到本地文件系统。随后,使用JSONPathReader处理器来解析JSON数据。

**Pentaho Kettle**

Pentaho Kettle,又名PDI,提供了一种图形化的环境,用于设计ETL流程,并支持从各种数据源导入数据并将其存储到不同的目的地。

**代码示例:**

```java

// Kettle Transformation的示例代码片段

import org.pentaho.di.core.database.DatabaseMeta;

import org.pentaho.di.core.row.RowMeta;

import org.pentaho.di.core.row.ValueMeta;

import org.pentaho.di.trans.TransMeta;

import org.pentaho.di.trans.step.StepMeta;

import org.pentaho.di.trans.step.StepMetaInterface;

// 创建转换元数据对象

TransMeta transMeta = new TransMeta();

// 创建输入和输出步骤

StepMeta inputStep = new StepMeta("input", "Input", null);

transMeta.addStep(inputStep);

StepMeta outputStep = new StepMeta("output", "Output", null);

transMeta.addStep(outputStep);

// 指定输入输出步骤的数据库连接

DatabaseMeta dbMeta = new DatabaseMeta("localhost", "JDBC", "MySQL", "database", "user", "password");

inputStep.getStepMetaInterface().setDatabaseMeta(dbMeta);

outputStep.getStepMetaInterface().setDatabaseMeta(dbMeta);

// 添加步骤到转换

transMeta.addStep(inputStep);

transMeta.addStep(outputStep);

// 执行转换

transMeta.execute(null, null);

```

#### 数据清洗与转换技巧

数据清洗通常涉及识别和处理缺失值、重复记录、异常值以及不一致的数据。数据转换则可能包括归一化、标准化、编码转换等。

**表格展示常见数据清洗策略:**

| 策略 | 描述 |

| ------------------ | ------------------------------------------------------------ |

| 缺失值处理 | 例如,用平均值、中位数或众数替代缺失值,或者删除包含缺失值的记录 |

| 异常值识别与处理 | 采用统计方法识别异常值,如IQR(四分位数间距),处理方式包括修正或删除 |

| 数据规范化 | 将数据按照特定规则转换,例如将文本大小写统一或时间标准化 |

| 字段合并与拆分 | 合并多个字段以创建新的特征,或拆分字段以增加细节 |

| 类别数据编码 | 将非数值类别数据转换为数值形式,例如使用独热编码(One-Hot Encoding)或标签编码 |

| 离散化 | 将连续的数值特征分解为离散区间 |

### 4.1.2 数据质量与一致性保证

数据质量与一致性保证是通过一系列方法和工具来确保数据的质量和准确性,这在数据分析和机器学习应用中尤为关键。

**数据质量检查**

检查数据质量可以从多个维度入手,包括但不限于完整性、准确性、一致性、时效性和唯一性。

- **完整性**:指数据集中的记录是否完整,字段值是否全面;

- **准确性**:指数据是否准确反映了所要描述的实体和事实;

- **一致性**:指数据在各个系统或文件中是否保持一致;

- **时效性**:指数据是否是最新的,能够反映当前情况;

- **唯一性**:指数据集中没有重复的记录。

**数据一致性检查**

数据一致性检查通常涉及到对照业务规则或数据间关系进行数据校验。例如,参照数据库的外键约束、数据依赖性关系等。

## 4.2 机器学习与大数据的结合

机器学习是人工智能的一个分支,它的目标是使计算机能够从数据中学习,无需经过明确的编程。

### 4.2.1 大数据中的特征工程

在机器学习模型中,特征工程是提高模型表现的关键。它涉及到从原始数据中提取和转换特征,以使这些特征对于模型来说更加有用。

**特征选择**

特征选择是选择数据集中最有信息量的特征的过程。这可以减少模型的复杂度,防止过拟合,并提高模型的准确率。

**代码示例:**

```python

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

# 假设 X 是输入特征数据,y 是目标变量

selector = SelectKBest(chi2, k=10)

X_new = selector.fit_transform(X, y)

# 查看被选中的特征的索引

selected_features = selector.get_support(indices=True)

```

在上述例子中,我们使用卡方检验(chi2)作为特征选择方法,选择前10个最重要的特征。

**特征提取**

特征提取是利用转换方法从原始特征中创建新特征的过程。在大数据场景下,通常借助如主成分分析(PCA)、t分布随机邻域嵌入(t-SNE)等降维技术。

**代码示例:**

```python

from sklearn.decomposition import PCA

# 假设 X 是输入特征数据

pca = PCA(n_components=0.95)

X_pca = pca.fit_transform(X)

# 查看主成分的解释方差

print(pca.explained_variance_ratio_)

```

在此代码示例中,我们使用PCA对数据进行降维处理,以保留95%的方差。

### 4.2.2 Spark MLlib在机器学习中的应用

Spark MLlib是Apache Spark中用于机器学习的库。它提供了多个分布式算法和工具,用于分类、回归、聚类、协同过滤等。

**Spark MLlib 的使用**

Spark MLlib支持管道操作,这使得特征工程、模型训练和评估等过程能够在一个统一的API下完成,极大地简化了大数据下的机器学习应用。

**代码示例:**

```python

from pyspark.sql import SparkSession

from pyspark.ml import Pipeline

from pyspark.ml.feature import StringIndexer

from pyspark.ml.classification import LogisticRegression

# 初始化Spark会话

spark = SparkSession.builder.appName("MachineLearningExample").getOrCreate()

# 加载数据

data = spark.read.format("libsvm").load("data/mllib/sample_libsvm_data.txt")

# 索引器将标签列转换为标签索引

indexer = StringIndexer(inputCol="label", outputCol="indexedLabel").fit(data)

# 创建逻辑回归模型

lr = LogisticRegression(maxIter=10, regParam=0.3, elasticNetParam=0.8, labelCol="indexedLabel")

# 定义管道模型

pipeline = Pipeline(stages=[indexer, lr])

# 训练模型

model = pipeline.fit(data)

# 保存模型

model.save("mllib机器学习模型")

```

通过这个示例,我们创建了一个包含字符串索引器和逻辑回归的管道模型,并使用该管道模型来拟合数据。最终,我们将训练好的模型保存到文件系统中。

## 4.3 大数据分析案例研究

### 4.3.1 实时数据分析流程

实时数据分析是大数据分析的一个重要领域,它关注于如何快速地从大量数据流中提取有价值的信息。

**实时数据处理技术**

- 流处理框架如Apache Storm,Apache Flink和Apache Kafka Streams;

- 实时分析工具有Apache Spark Streaming,Kafka,Confluent等;

- 用于实时交互查询的工具例如Druid和Apache Impala。

**案例:使用Apache Kafka和Apache Flink进行实时数据分析**

在本案例中,我们通过Apache Kafka作为消息队列来收集实时数据流,然后使用Apache Flink来处理这些数据流。

```mermaid

graph LR

A[数据源] -->|消息| B(Kafka)

B -->|实时数据流| C(Flink)

C -->|分析结果| D[数据存储]

```

通过这个流程图,我们可以看到数据是如何从数据源通过Kafka进入Flink进行实时分析,并最终存储至数据存储系统。

### 4.3.2 大数据在业务决策中的作用

大数据技术被广泛应用于业务决策中,帮助企业更好地了解市场趋势,优化运营流程,预测业务发展等。

**大数据分析应用示例**

- **客户细分**:通过客户的购买历史、点击流数据等,对客户进行细分,以便更精准地进行市场推广;

- **需求预测**:利用历史销售数据、市场趋势和季节性因素等进行需求预测;

- **欺诈检测**:实时分析交易数据,快速发现并防止欺诈行为;

- **供应链优化**:分析历史供应数据、库存水平和需求模式,优化库存管理。

大数据在业务决策中的应用是一个复杂且动态的过程,需要结合业务目标、数据特性和分析工具来定制解决方案。

以上是本章对数据处理与分析实践的深入探讨。从数据清洗、预处理到机器学习模型的构建,再到实时数据分析的实施,每一部分都展现了如何将理论应用于实际的复杂场景中。随着大数据和机器学习技术的不断进步,将会有更多创新的解决方案被开发出来,以满足不断增长的数据处理需求。

# 5. 开源技术栈在面试中的应用

在IT行业中,面试是一个技术人才必须经历的阶段。本章节将深入探讨开源技术栈在面试中的应用,重点涉及面试题型与解题技巧、实战技巧与经验分享、以及持续学习与职业发展。

## 5.1 面试题型与解题技巧

### 5.1.1 常见的面试题类型

面试题型可以分为技术理论题、算法题、项目经验题和系统设计题。在考察理论知识时,面试官可能会问及大数据生态系统中各个组件的工作原理,比如Hadoop的HDFS如何保证数据的高可用性。算法题目则可能涉及到数据结构、排序算法等,重点考察候选人解决问题的能力。项目经验题则侧重于候选人过往项目中的实际应用和遇到的挑战。系统设计题则要求候选人根据给定的需求设计一个系统架构,考察候选人的架构能力和对开源技术栈的理解。

### 5.1.2 面试中的技术问答策略

在技术问答中,首先应快速理解问题,确认问题的具体要求。随后,可以从问题的背景开始,逐步阐述解决问题的思路和方法。在解释过程中,适当使用专业术语,并且尽量用简单的语言表达复杂的概念。如果面试题目中包含代码编写,应确保代码的清晰、简洁和高效。最后,结合实际经验,分享在项目中应用相同技术栈时的心得体会。

## 5.2 实战技巧与经验分享

### 5.2.1 真实面试经验回顾

候选人应该回顾自己在以往面试中的经历,从成功和失败中吸取经验。在成功案例中,分析哪些因素导致了面试官的正面评价,如清晰的思路、有效的沟通等。在失败的案例中,总结教训,如准备不足、技术知识的盲区、沟通表达的不清晰等,并针对性地进行改进。此外,模拟面试是一个非常好的准备方式,可以通过与同行的互相练习,提高应对真实面试的能力。

### 5.2.2 技术简历的编写与优化

技术简历是面试的第一印象。编写简历时应突出重点,清晰展示自己的技术栈和项目经验。可以使用清晰的项目名称,简洁的项目描述和明确的技术关键词。使用表格来列出关键技能和掌握的程度也是一个不错的选择。同时,简历中还应包括相关证书、参与的开源项目、技术博客或论文等,以展示自己的专业度和对技术的热情。

## 5.3 持续学习与职业发展

### 5.3.1 开源社区的参与与贡献

持续的技术学习和成长对于IT专业人员至关重要。参与开源社区,不仅可以学习到前沿的技术,还能够提升个人影响力。可以通过阅读开源项目的代码、提问题、参加线上或线下的开源活动、甚至提交代码补丁来贡献社区。这些活动不仅可以增进个人的技术能力,还有助于建立一个有价值的个人网络。

### 5.3.2 长期职业规划与技术更新

合理的职业规划是职业发展的关键。应根据自身兴趣和市场趋势,设定短期和长期的职业目标。同时,不断关注技术动态和行业趋势,及时更新自己的技术栈。可以利用在线课程、技术会议、专业书籍等资源来学习新知识。此外,建立一个个人学习计划,定期进行技术复盘和总结,对于保持技术竞争力同样重要。

以上便是本章节的核心内容,涵盖了面试题型与解题技巧、实战技巧与经验分享、以及持续学习与职业发展等多个方面,旨在帮助IT行业的技术人才在面试中脱颖而出,并在职业生涯中不断前行。

0

0