MySQL去重与大数据:应对海量数据去重挑战,大数据去重实战指南

发布时间: 2024-07-27 18:28:31 阅读量: 49 订阅数: 22

# 1. MySQL去重基础**

MySQL去重是指从数据集中去除重复的记录,确保数据的唯一性和完整性。在数据分析、数据处理和数据管理中,去重是一个重要的操作。MySQL提供了多种去重技术,包括基于索引、聚合函数和窗口函数的方法。这些技术各有优缺点,适用于不同的场景和数据类型。

# 2. MySQL去重技术

MySQL提供了多种去重技术,可根据不同的场景和需求选择使用。本章节将详细介绍基于索引、聚合函数和窗口函数的去重技术。

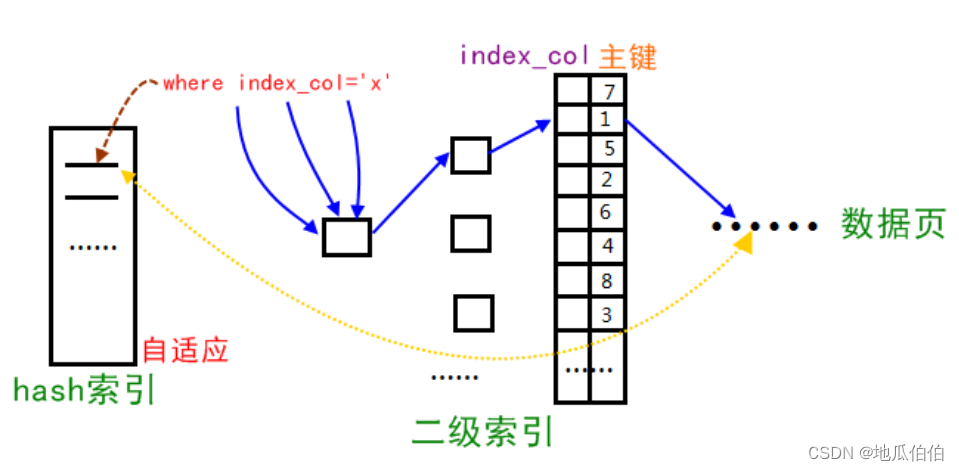

### 2.1 基于索引的去重

基于索引的去重是利用索引的唯一性来实现去重的。索引可以保证表中每一行数据的唯一性,因此可以通过索引来快速找出并删除重复数据。

#### 2.1.1 唯一索引

唯一索引是保证表中每一行数据的唯一性的索引。当在表中创建唯一索引时,MySQL会自动拒绝插入重复数据。唯一索引的去重效率非常高,但只适用于需要保证数据唯一性的场景。

**代码块:**

```sql

CREATE UNIQUE INDEX idx_name ON table_name (column_name);

```

**逻辑分析:**

该语句创建了一个名为`idx_name`的唯一索引,用于保证`table_name`表中`column_name`列数据的唯一性。

**参数说明:**

* `idx_name`:索引名称

* `table_name`:表名称

* `column_name`:需要创建唯一索引的列名称

#### 2.1.2 联合唯一索引

联合唯一索引是利用多个列的组合来保证表中每一行数据的唯一性。当在表中创建联合唯一索引时,MySQL会自动拒绝插入重复数据。联合唯一索引的去重效率也较高,但只适用于需要保证多个列组合唯一性的场景。

**代码块:**

```sql

CREATE UNIQUE INDEX idx_name ON table_name (column_name1, column_name2);

```

**逻辑分析:**

该语句创建了一个名为`idx_name`的联合唯一索引,用于保证`table_name`表中`column_name1`和`column_name2`列组合数据的唯一性。

**参数说明:**

* `idx_name`:索引名称

* `table_name`:表名称

* `column_name1`和`column_name2`:需要创建联合唯一索引的列名称

### 2.2 基于聚合函数的去重

基于聚合函数的去重是利用聚合函数来实现去重的。聚合函数可以对表中的数据进行分组和聚合,从而找出重复数据。

#### 2.2.1 DISTINCT

`DISTINCT`聚合函数可以去除重复值,只保留唯一值。`DISTINCT`可以应用于任何列,但通常用于数值型或字符串型列。

**代码块:**

```sql

SELECT DISTINCT column_name FROM table_name;

```

**逻辑分析:**

该语句使用`DISTINCT`聚合函数去除`table_name`表中`column_name`列的重复值,只保留唯一值。

**参数说明:**

* `column_name`:需要去重的列名称

#### 2.2.2 GROUP BY

`GROUP BY`聚合函数可以将表中的数据按指定列分组,并对每一组数据进行聚合操作。`GROUP BY`可以用于去重,通过对分组后的数据进行计数,找出重复数据。

**代码块:**

```sql

SELECT column_name, COUNT(*) AS count FROM table_name GROUP BY column_name HAVING COUNT(*) > 1;

```

**逻辑分析:**

该语句使用`GROUP BY`聚合函数将`table_name`表中`column_name`列的数据分组,并对每一组数据进行计数。`HAVING COUNT(*) > 1`条件用于找出重复数据,即计数大于1的数据。

**参数说明:**

* `column_name`:需要分组的列名称

* `COUNT(*)`:对每一组数据进行计数

* `HAVING COUNT(*) > 1`:找出重复数据的条件

### 2.3 基于窗口函数的去重

基于窗口函数的去重是利用窗口函数来实现去重的。窗口函数可以对表中的数据进行分组和聚合,并对每一组数据进行排序或排名。

#### 2.3.1 ROW_NUMBER()

`ROW_NUMBER()`窗口函数可以对表中的数据进行排序,并为每一行数据分配一个唯一的行号。通过`ROW_NUMBER()`窗口函数,可以找出重复数据,即行号相同的

# 3. 大数据去重实战

### 3.1 MapReduce去重

MapReduce是一种分布式计算框架,用于处理大规模数据集。它将数据分解成较小的块,并将这些块分配给集群中的多个节点进行处理。MapReduce去重通过以下步骤实现:

- **Map阶段:**将输入数据映射到键值对,其中键是需要去重的字段,值是该字段对应的行。

- **Shuffle和Sort阶段:**对键值对进行洗牌和排序,将具有相同键的键值对分组在一起。

- **Reduce阶段:**对每个分组的键值对进行规约,只保留一个唯一的值。

**3.1.1 Hadoop MapReduce**

Hadoop MapReduce是MapReduce框架的开源实现。它使用Java编写,并提供了用于去重的内置函数:

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import

```

0

0