从原理到实践:本地化召回精度(LRP)的深入探索

发布时间: 2025-01-03 11:59:51 阅读量: 19 订阅数: 19

matlab精度检验代码-LRP:带有Python和MATLAB实现的PASCAL-VOC,COCO数据集的本地化召回PrecisionPer

# 摘要

本地化召回精度(LRP)是推荐系统和搜索技术中的一个重要概念,它直接影响到信息检索的效率和用户体验的质量。本文首先概述了LRP的定义和重要性,并详细介绍了其理论基础,包括LRP的算法原理和数学模型。随后,文章通过多个实际应用案例深入探讨了LRP在搜索引擎、电商平台商品推荐以及内容分发网络中的应用情况。进阶技术与挑战章节分析了LRP的技术优化策略和当前面临的挑战,并展望了LRP的未来发展趋势。最后,通过综合实验与分析,验证了LRP的有效性,并提供了深入的见解和实际应用中的案例分享。

# 关键字

本地化召回精度;推荐系统;信息检索;算法原理;数学模型;深度学习;数据隐私;算法优化

参考资源链接:[LRP:新目标检测指标,评估边界框定位与召回精度](https://wenku.csdn.net/doc/1t7w44ufaf?spm=1055.2635.3001.10343)

# 1. 本地化召回精度(LRP)概述

在当今的信息时代,随着互联网用户数量的剧增,以及用户行为和需求的多样化,如何高效准确地在海量信息中找到用户最关心的内容成为了一个亟待解决的问题。本地化召回精度(Local Relevance Precision,LRP)便是解决这一问题的关键技术之一。

## 1.1 本地化召回精度(LRP)的定义与重要性

### 1.1.1 本地化召回精度的理论定义

LRP作为信息检索领域的一个重要概念,它衡量的是系统在特定情境下成功检索出与用户查询相关的信息的能力。更精确地说,LRP反映了推荐系统或搜索引擎在某一局部数据集上,向用户展示的相关结果的比例。

### 1.1.2 LRP在信息系统中的作用

LRP直接关联到用户体验的质量。一个高的LRP值表示系统能够更精准地理解用户的意图,并提供满足其需求的信息。在商业应用中,提升LRP意味着更高的用户满意度,进而可能提高用户留存率和潜在的经济效益。

# 2. LRP的理论基础

## 2.1 本地化召回精度的定义与重要性

### 2.1.1 本地化召回精度的理论定义

本地化召回精度(Local Relevance Precision,LRP)是在信息检索和推荐系统领域中评价系统性能的一个重要指标。它衡量的是系统在特定用户上下文中,推荐给用户的项目集合中相关项目的比例。具体来说,LRP关注的是用户在特定地点、时间或情境下对于系统推荐内容的满意度。这种评价方式比传统的精确度(Precision)更进一步,因为它在计算相关项目时考虑了用户的具体上下文。

LRP的计算公式如下:

```

LRP = (相关推荐项目数量 / 推荐项目总数量)

```

这里的“相关推荐项目数量”是指在推荐的项目集合中,与用户当前上下文实际相关的项目数目。例如,在电商平台中,对于一个正在搜索“运动鞋”的用户,如果系统不仅推荐了运动鞋,还根据用户当前的地理位置推荐了附近的运动鞋店铺信息,则这两者都应当计入相关推荐项目数量中。

### 2.1.2 LRP在信息系统中的作用

在信息系统中,LRP的引入具有以下几个作用:

1. **增强用户体验**:通过考虑用户的具体上下文,LRP能够更加准确地反映用户的实际需求,从而提供更加个性化的推荐,提升用户的满意度和体验。

2. **优化推荐系统**:LRP提供了一个衡量推荐系统本地化能力的量化指标,便于开发者对推荐算法进行优化和调整,以适应多样化的用户场景。

3. **增强系统的商业价值**:在电商、广告等行业,高LRP能够直接转化成更高的点击率和成交量,从而提高企业的收益。

### 2.2 LRP的算法原理

#### 2.2.1 推荐系统的背景知识

在详细讨论LRP算法之前,我们先简要回顾一下推荐系统的基本概念。推荐系统是一种信息系统,其目的是向用户推荐可能感兴趣的商品、内容或其他类型的项目。这种系统主要分为两类:

- **基于内容的推荐**(Content-Based Recommendation):根据用户的历史行为和偏好,推荐与用户以往喜欢的项目相似的项目。

- **协同过滤推荐**(Collaborative Filtering Recommendation):通过分析用户之间的相似性,利用群体智慧来发现用户可能感兴趣的项目。

#### 2.2.2 LRP算法的工作机制

LRP算法通常在推荐系统中结合上下文信息来工作。它通过分析用户的历史行为数据以及当前的上下文信息,来优化推荐列表。这种算法考虑的上下文信息可以包括但不限于:

- **地理位置**:用户所在的区域或城市。

- **时间因素**:推荐项目应当和用户查询或活动的时间相匹配。

- **设备信息**:用户使用的设备类型可能影响推荐内容的格式。

算法的工作流程可以总结为以下步骤:

1. 收集用户的上下文信息。

2. 分析用户的以往行为和偏好。

3. 结合上下文信息和行为数据,利用机器学习算法生成推荐列表。

4. 根据LRP定义计算推荐列表的本地化召回精度。

#### 2.2.3 相关算法的比较分析

在目前的推荐系统领域,除了LRP算法之外,还有其他多种推荐算法,如矩阵分解、深度学习等。与它们相比,LRP算法具有以下特点:

- **上下文敏感性**:LRP特别强调上下文信息的利用,这是它与传统推荐算法的主要区别。

- **性能提升**:在许多情况下,结合上下文信息可以显著提高推荐的准确性和用户的满意度。

- **适用范围**:LRP更适用于那些上下文因素对用户需求影响较大的场景。

## 2.3 LRP的数学模型

### 2.3.1 概率模型基础

为了深入理解LRP,我们需要了解概率模型的基础知识。概率模型在推荐系统中的应用非常广泛,它为推荐系统的实现提供了数学上的支持。在这种模型中,通常会假定用户和项目之间存在某种概率分布,推荐的过程就是在尝试估计这个分布。

为了计算LRP,我们需要定义一个条件概率模型 P(item|context),表示在给定上下文条件下,用户对某个项目感兴趣的概率。LRP算法的核心工作就是估计这个条件概率,并根据概率值来生成推荐列表。

### 2.3.2 优化目标和损失函数

在训练推荐系统模型时,通常需要定义一个优化目标,最常用的优化目标是最大似然估计(Maximum Likelihood Estimation,MLE)。通过优化目标,我们可以得到一个概率模型,它能够最大化在给定训练数据下的似然函数。

为了实现这个目标,需要定义一个损失函数,它是用来衡量模型预测值与实际值之间的差异。一个常用的损失函数是交叉熵损失(Cross-Entropy Loss),用于衡量两个概率分布之间的差异。在上下文敏感推荐系统中,损失函数需要同时考虑项目相关性和上下文因素。

### 2.3.3 模型评估标准

对于任何推荐系统而言,评估模型的性能至关重要。在LRP的背景下,模型评估通常使用以下标准:

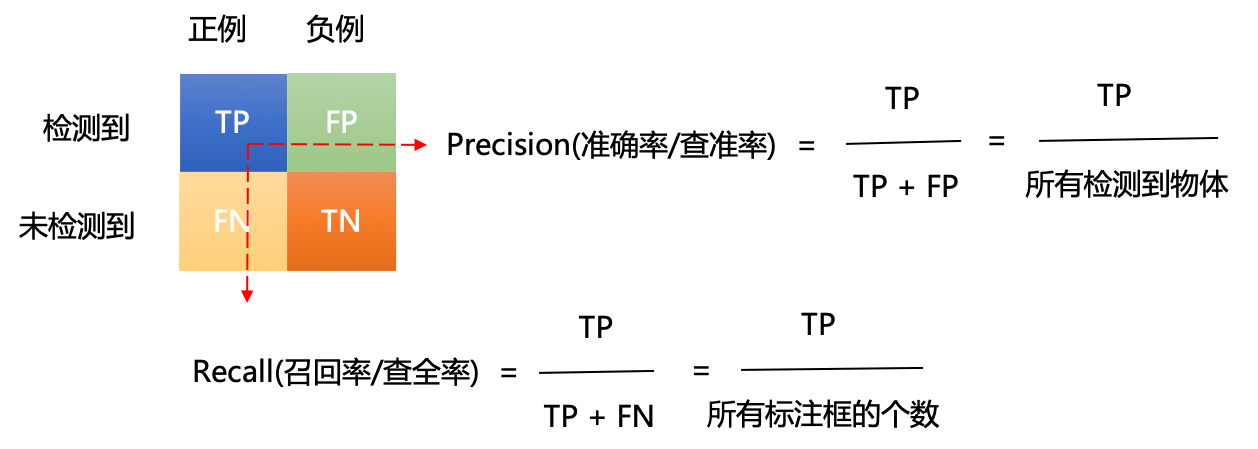

- **准确率**(Precision):推荐列表中相关项目的比例。

- **召回率**(Recall):推荐系统能够覆盖的用户感兴趣项目的比例。

- **F1分数**:准确率和召回率的调和平均数,它能够平衡两者的影响。

在本地化场景下,我们更关注的是 LR P,它将上下文因素考虑在内。因此,对于LRP,我们还会使用一些特别的指标,例如上下文适应度(Context Adaptability),它衡量的是推荐系统在适应不同上下文条件时的表现。

这一节已经介绍了LRP的理论基础,下面的章节将讨论LRP的实际应用案例,看看它在不同业务场景中的具体实现与效果。

# 3.1 LRP在搜索引擎中的应用

搜索引擎是互联网上信息检索的重要工具,它使得用户能够在海量的数据中迅速找到自己所需的内容。本地化召回精度(LRP)在搜索引擎中的应用能够显

0

0