Stata文本分析秘籍:7步掌握数据预处理与分析技巧

摘要

本文详细介绍了Stata软件在文本分析中的应用方法和技巧。从数据导入与预处理开始,涵盖了从各种来源导入数据、处理缺失值、清洗和标准化数据集等基础操作。进一步探讨了数据预处理的高级操作,如合并数据集、变量操作和抽样分组等。在文本分析核心技巧部分,介绍了字符串处理、正则表达式的应用、文本数据的编码转换以及文本分析的统计方法。文章还涉及了数据可视化和结果解释,包括图形创建、高级数据可视化技术以及结果解读与报告撰写。最后一章通过综合应用案例分析,讨论了复杂数据处理、结合机器学习的数据预处理策略以及Stata与其他工具的集成应用。本文旨在为读者提供一套完整的Stata文本分析解决方案,以提高数据分析的效率和准确性。

关键字

Stata;文本分析;数据预处理;数据可视化;机器学习;统计方法;数据分析结果解释

参考资源链接:Stata文本分析实战:分词与情感分析

1. Stata文本分析概览

1.1 文本分析在Stata中的重要性

在数据科学领域,文本分析逐渐成为一项重要的技能,它涉及到从文本数据中提取信息、发现模式和趋势。Stata不仅支持统计分析,还在文本分析方面提供了强大的工具集,方便用户处理从简单的文本字段到复杂的数据集。文本分析的流程通常包括数据导入、预处理、核心分析和结果解释等步骤。

1.2 文本分析的应用场景

文本分析在多种领域都有广泛的应用,如社会科学、市场研究、公共卫生和金融分析等。这些领域常常需要从文本数据如调查问卷、社交媒体内容、新闻报道等非结构化数据中提取有价值的信息。例如,在社会学研究中,文本分析可以帮助研究者了解公众对于某一政策的看法;在市场研究中,可以通过分析消费者评论来评估产品的市场接受度。

1.3 Stata在文本分析中的优势

Stata作为一个统计软件,具备高度的用户友好性和灵活性,它允许用户直接在软件中执行各种文本分析任务。无论是基础的文本预处理,还是复杂的文本挖掘技术,Stata都能提供一系列内置命令来处理。此外,Stata还支持编写自定义程序和函数,为高级用户提供强大的定制能力。通过Stata,用户可以高效地进行数据清洗、转换、文本挖掘、模型建立等操作,最终得到精准的数据分析结果。

2. 数据导入与预处理技巧

在数据分析的起始阶段,数据导入和预处理是至关重要的步骤。这个阶段确保了后续分析的准确性和有效性。本章节将细致地探讨在Stata中进行数据导入的多种方法、缺失值的处理方式以及数据清洗的实践操作。

2.1 数据导入方法

数据来源的多样性决定了导入方法的多变性。Stata提供了强大的命令来从不同格式的文件中导入数据,同时也支持从其他统计软件中导入数据。

2.1.1 从文本文件导入

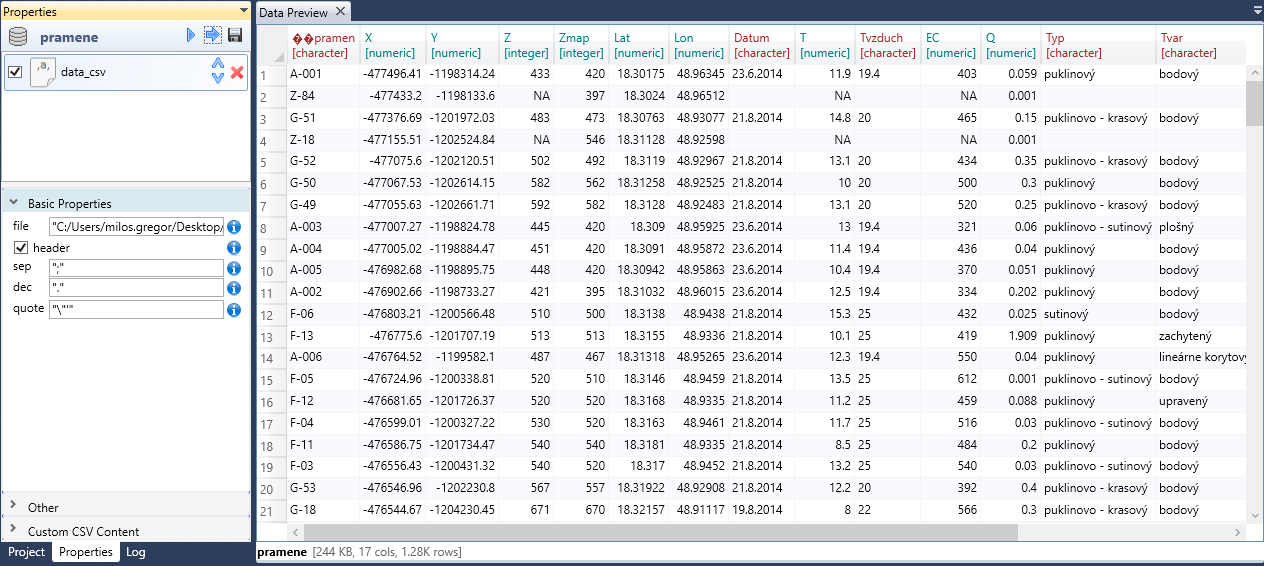

Stata支持从多种文本文件格式导入数据,包括CSV(逗号分隔值)、TXT(文本文件)以及TSV(制表符分隔值)等。

- import delimited "path/to/data.csv", clear

在上述命令中,import delimited是导入分隔数据的命令,"path/to/data.csv"指的是数据文件的路径。clear选项的作用是导入数据前清空内存中的数据,避免数据重复累加。

Stata会自动识别并处理常见的分隔符(如逗号、分号、制表符等)。如果文件中的数据包含标题行,Stata会默认将其作为变量名称。如果有特殊需求,例如指定分隔符或跳过文件开头的非数据行,Stata也提供了相应的选项。

2.1.2 从其他统计软件导入

Stata能够从SPSS、SAS、Excel等其他统计软件中导入数据,但需要使用各自的特定命令。

以SPSS文件为例,Stata提供import spss命令来处理:

- import spss "path/to/data.sav", clear

该命令将SPSS的.sav文件导入Stata。对于SAS文件,使用import sas命令,Excel文件则使用import excel命令。

2.2 缺失值的处理

在实际数据集中,缺失值是常遇到的问题。正确处理缺失值对于保证数据分析质量有着决定性的影响。

2.2.1 缺失值的识别

在Stata中,缺失值通常有几种表示方式:.、.a到.z、.a0到.z0等。Stata中可以使用misstable命令来查看和分析数据中的缺失值:

- misstable summarize, detail

上述命令会展示数据集中每个变量的缺失值分布情况。细节信息中可以查看缺失值的类型和数量。

2.2.2 缺失值的填充与删除

处理缺失值的一种常见方法是填充(imputation)。可以使用均值、中位数、众数或特定值来填充缺失值。另一种方法是删除含有缺失值的观测值。

在Stata中,可以使用replace命令来填充特定值:

- replace var1 = .a if missing(var1)

在该命令中,var1是需要填充的变量名,.a是用于填充的值。若想删除含有缺失值的观测值,可以使用drop if命令:

- drop if missing(var1)

2.3 数据清洗实践

数据清洗是预处理阶段的重要组成部分,它涉及到标准化数据格式、清除无意义的数据以及识别和处理异常值。

2.3.1 标准化数据格式

数据标准化的目标是确保数据的一致性和准确性,使得后续分析可以在同一标准下进行。

以日期格式为例,如果数据中日期字段格式不统一,可以使用format命令和destring命令进行转换:

- format var1 %td

- destring var1, replace

这里var1是日期字段,%td是日期格式的表示形式。destring命令将字符串转换成日期格式。

2.3.2 清除无意义的数据和异常值

无意义的数据和异常值可能会对分析结果造成负面影响。识别这些数据通常需要一定的业务知识或通过统计分析方法进行检测。

一个常见的方法是使用tabulate命令查看数据分布,以找出异常值:

- tabulate var1

tabulate命令会展示var1变量中各个值出现的频率。通过频率分布,可以识别出极值或异常值,并进一步处理。

为了进一步深入处理,Stata提供了egen命令来生成新变量,这在处理异常值时特别有用。例如,可以通过egen命令找出某变量的平均值加减2倍标准差范围之外的观测值:

- egen mean_val = mean(var1)

- egen std_val = std(var1)

- drop if var1 < (mean_val - 2 * std_val) | var1 > (mean_val + 2 * std_val)

- drop mean_val std_val

上述代码块中,首先计算了var1的平均值和标准差,并存储在mean_val和std_val中。之后,删除了不在平均值加减两倍标准差范围内的观测值,并最后删除辅助变量。

通过以上步骤,数据导入和预处理环节就得以完成,为后续的数据分析打下了坚实的基础。在下一章节中,我们将讨论数据预处理的高级操作,进一步提升数据处理能力。

3. 数据预处理高级操作

数据预处理是数据分析过程中不可或缺的一环,它对数据质量有着决定性的影响。在第二章中,我们已经讨论了数据导入、缺失值处理以及数据清洗的基础实践。现在,我们将进一步探索数据预处理的高级操作,帮助您更有效地处理复杂数据集,为分析和模型训练做好准备。

3.1 数据合并与重塑

数据合并与重塑是数据预处理中常见的高级操作。它们涉及将多个数据集组织成一个便于分析的格式。

3.1.1 合并数据集

合并数据集允许我们根据一个或多个共同变量将不同的数据集整合到一起。Stata 提供了多种合并命令,其中最常用的是 merge 命令。

- * 假设我们有两个数据集,一个是员工的个人信息(personnel.dta),另一个是员工的薪酬数据(salary.dta)

- use personnel.dta, clear

- merge 1:1 employee_id using salary.dta

这段代码首先加载了包含员工个人信息的数据集,然后使用 merge 命令根据 employee_id 将薪酬数据集合并进来。1:1 指的是两个数据集中的 employee_id 都是唯一的。

3.1.2 数据集的长宽转换

数据集的长宽转换是将数据从长格式转换为宽格式,或者从宽格式转换为长格式。这在处理时间序列数据、面板数据等复杂数据结构时非常有用。

- * 假设我们有一个长格式的年度销售数据集(sales_long.dta)

- use sales_long.dta, clear

- reshape wide sales, i(employee_id) j(year)

reshape 命令用于长宽转换,wide 指定从长格式转换为宽格式。在这个例子中,我们以 employee_id 为标识变量,将年度销售数据转换为宽格式,每个年份的销售数据将形成一个新的变量。

3.2 创建和修改变量

创建和修改变量是数据预处理的另一个关键部分,涉及到变量的生成、赋值、重编码和分类。

3.2.1 变量的生成与赋值

在数据预处理过程中,我们经常会遇到需要生成新变量或者修改现有变量的情况。Stata 提供了丰富的命令来实现这一点。

- * 假设我们正在处理一个学生考试成绩的数据集(grades.dta)

- use grades.dta, clear

- gen total_score = score_math + score_english

这里,gen 命令用于生成新变量,我们将数学和英语两个科目的成绩相加,创建了一个新的变量 total_score。

3.2.2 变量的重编码与分类

重编码与分类是指根据特定条件修改变量的值或将其分类。这在处理定性数据时尤其有用。

- * 假设我们有一个性别变量,其原始编码为1表示男性,2表示女性

- use gender.dta, clear

- recode gender (1=0 "Male") (2=1 "Female"), generate(new_gender)

recode 命令用于重编码变量。在这个例子中,我们将 gender 变量中的1和2的值分别转换为0和1,并生成了新的变量 new_gender。

3.3 数据集的抽样与分组

抽样和分组是数据分析和建模前的预处理步骤,它们帮助我们对数据集进行合理的子集划分和分组。

3.3.1 抽样方法与实践

合理的抽样能够确保分析结果的代表性。Stata 提供了多种抽样命令,最常用的包括简单随机抽样和分层抽样。

- * 从一个包含顾客信息的数据集中随机抽取20%的样本

- use customer.dta, clear

- sample 20

sample 命令用于随机抽样,这里我们抽取了20%的数据作为样本。

3.3.2 分组统计与报告

分组是根据某一分类变量将数据集拆分为多个子集。每个子集通常会用于计算分组统计量或进行进一步分析。

- * 假设我们想根据年收入将顾客分为不同的收入组,并计算每组的平均年龄

- use customer.dta, clear

- egen income_group = cut(income), at(0, 20000, 40000, 60000, 80000)

- by income_group, sort: summarize age

egen 命令用于生成新变量,这里我们使用 cut 选项根据收入值将顾客分为不同的收入组。然后使用 by 命令分组计算每个组的平均年龄。

以上就是本章节的内容,详细介绍了数据预处理高级操作中的数据合并与重塑、变量的创建与修改、以及数据集的抽样与分组。理解并掌握这些技能对于进行深入的数据分析至关重要。在下一章节中,我们将深入探讨文本分析的核心技巧,这将帮助我们从文本数据中提取有价值的信息。

4. ```

第四章:文本分析核心技巧

4.1 文本处理基础

字符串处理函数

字符串处理是文本分析中最基础的部分。在Stata中,可以使用一系列的内置函数来操作字符串,例如substr()函数用于截取子字符串,length()用于获取字符串长度等。以substr()函数为例,假设我们有一个文本数据集,包含了书籍的标题和作者信息,我们可能需要提取出作者名字部分。

- * 假设变量 'book_info' 包含了书籍的标题和作者信息,格式为 'Title - Author'

- gen author = substr(book_info, indexof(book_info, "-") + 1, .)

- replace author = trim(author)

在这段代码中,indexof() 函数首先找到字符串中"-“的位置,然后 substr() 函数从”-"之后的第一个字符开始截取直到字符串的末尾。trim() 函数用于去除字符串前后的空格。

正则表达式在文本处理中的应用

正则表达式(Regular Expression)是一种强大的文本处理工具,Stata通过regexm() 和 regexr() 函数支持正则表达式。例如,当我们需要从文本中匹配模式时,可以使用正则表达式。下面的例子展示了如何使用正则表达式来检测一个变量是否包含有效电子邮件地址格式。

- * 检查变量 'email' 是否符合电子邮件格式

- gen valid_email = regexm(email, "[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Za-z]{2,}")

正则表达式 [A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Za-z]{2,} 定义了电子邮件地址的模式。这使得我们可以进行简单的格式验证,以确保数据的准确性和一致性。

4.2 文本数据的编码与转换

文本到数字的编码过程

在进行统计分析之前,经常需要将文本数据转换为数值数据。Stata 提供了 encode 命令来将文本变量转换成数值编码。

- * 将文本变量 'category' 转换为数值编码

- encode category, generate(category_code)

在这个例子中,encode 命令把文本变量 category 转换为一个新的数值变量 category_code。这样做有助于在统计模型中使用分类变量。

文本数据的类型转换技巧

除了将文本转换为数值编码,有时我们也需要将文本数据转换为日期格式。Stata 的 mdy()、dmy()、ymd() 等函数允许我们指定日期格式并转换文本字符串。

- * 将文本变量 'date_text' 转换为日期变量 'date'

- gen date = mdy(3, 14, 2021) if date_text == "March 14, 2021"

这里我们使用了 mdy() 函数,它把文本 "March 14, 2021" 转换成了日期格式。注意,这些函数要求提供的参数必须与文本格式一致,否则转换会失败。

4.3 文本分析的统计方法

文本频率分析

文本频率分析是识别和总结文本数据中最常出现的词语或短语的过程。Stata 通过 tabulate 命令提供了一种基础的频率分析方法。

- * 进行文本频率分析

- tabulate word_frequency

若要分析包含多个单词的短语,可以使用 tab 命令配合 egen 函数。

- * 创建短语频率分析的示例数据

- egen phrase_frequency = rowtotal(word1 word2 word3)

- tabulate phrase_frequency

egen 的 rowtotal 函数计算指定变量的行总和,从而创建一个新的包含短语频率的变量。

文本相似度计算与应用

文本相似度计算在比较文档、检测抄袭、分析内容相似性等方面非常有用。Stata 提供了多种方法来进行相似度计算,其中一个常用的方法是 Jaccard 相似系数。

- * 计算两段文本的 Jaccard 相似系数

- egen jaccard_similarity = jaccard(text1, text2)

jaccard() 函数计算两段文本的 Jaccard 相似系数,这是一种集合相似度度量函数,用于比较两个集合的相似性。

请注意,进行这些高级文本分析之前,需要对数据进行适当的预处理,如分词、去除停用词等,以确保分析的准确性和效率。

- # 5. ```

- # 第五章:数据可视化与结果解释

- 数据可视化是将数据以图形的形式展示出来,以便更直观地揭示数据的结构和关系。在Stata中,从基础的条形图、散点图到高级的动态图形和交互式可视化,Stata提供了一系列强大的工具来帮助用户探索和展示数据。

- ## 5.1 Stata数据可视化基础

- ### 5.1.1 图形的创建与编辑

- 创建图形是数据可视化的起点。在Stata中,我们可以使用多种命令来创建不同类型的图形。最基本的图形命令之一是`graph twoway`,它允许用户绘制散点图、线图、条形图等。以下是一个创建散点图的基本示例:

- ```stata

- sysuse auto, clear // 导入示例数据集

- graph twoway scatter mpg weight, title("散点图示例") // 创建散点图

在上面的代码中,scatter是用于绘制散点图的子命令,mpg代表汽车的每加仑英里数,weight代表汽车的重量。title选项用于为图形添加标题。

5.1.2 常见图形类型及应用实例

Stata提供了多种图形类型来满足不同的数据可视化需求。常见的图形类型包括:

- 条形图(

bar命令):适合展示分类数据的频数或百分比。 - 线图(

line命令):用于展示趋势或时间序列数据。 - 柱状图(

hist命令):用于展示数据的分布情况。

以条形图为例,绘制不同汽车品牌平均维修费用的图形:

- sysuse auto, clear

- graph bar (mean) price, over(foreign) title("不同品牌汽车平均维修费用")

这里使用了bar命令,并通过(mean)选项计算了平均价格,over(foreign)选项按汽车品牌进行分组,生成了一个分组条形图。

5.2 高级数据可视化技术

5.2.1 多变量数据的图形表示

在实际分析中,我们经常需要展示多个变量之间的关系。Stata支持通过组合不同的图形元素来展示多变量数据。例如,使用graph matrix命令创建一个散点图矩阵:

- sysuse auto, clear

- graph matrix mpg weight length, half title("汽车数据散点图矩阵")

在这个例子中,matrix命令生成了一个散点图矩阵,其中mpg、weight和length三个变量两两之间都生成了散点图。

5.2.2 动态图形与交互式可视化

Stata通过graph命令的by()选项支持动态图形的创建,可以将图形按照某个或某些分类变量进行分组展示。对于更高级的动态图形和交互式可视化,Stata可以与外部软件如JavaScript或Python库(如D3.js或Plotly)集成来实现。

5.3 结果解读与报告撰写

5.3.1 数据分析结果的解读

数据分析的结果需要根据实际的研究背景和假设来解读。解读时应该考虑数据的趋势、模式、异常值、统计显著性等因素。重要的是,解读应该结合业务知识,提供对数据的深入见解。

5.3.2 报告撰写技巧与模板

撰写报告是数据分析的最后一步,也是向非技术人员传达分析结果的重要环节。报告应包括以下部分:

- 引言:介绍分析的背景和目的。

- 方法:描述使用的方法、数据来源和预处理步骤。

- 结果:展示关键的统计结果和图形。

- 讨论:解释分析结果的含义和业务影响。

- 结论:总结分析的发现,并提出建议。

使用Stata内置的outreg2命令可以帮助我们自动将回归等分析结果输出到Word文档,极大地提高了撰写报告的效率。

以上章节展示了Stata在数据可视化和结果解释方面的功能。通过实践中的具体案例和操作,数据分析师可以有效地将数据分析的洞察转化为有价值的业务决策支持。

- 在这一章节中,我们通过介绍数据可视化的基本操作,详细讲解了如何使用Stata创建和编辑图形,以及如何利用Stata的高级功能来展示多变量数据和创建动态图形。我们还讨论了如何解读数据分析结果,并给出撰写报告的技巧和模板。这一系列的内容旨在帮助读者掌握在Stata中进行数据可视化和结果解释的实用技能。

- # 6. 综合应用案例分析

- 在数据科学的世界里,实践案例能够为理论知识提供支持和验证,同时帮助我们更好地理解如何在实际工作中应用这些知识。Stata作为一款功能强大的统计软件,在处理和分析数据方面具有独特的优势。在这一章节中,我们将探讨几个实际案例,从数据处理到机器学习模型的构建,再到与其他数据分析工具的集成,深刻理解Stata在综合应用中的灵活性和强大功能。

- ## 6.1 复杂数据的处理案例

- ### 6.1.1 大规模数据集的处理策略

- 在进行大规模数据集的处理时,我们经常面临数据加载缓慢、内存不足以及计算效率低下的问题。Stata提供了一些策略来应对这些挑战。

- 1. **内存管理:** Stata允许用户通过命令`set memory`设置最大内存使用量,并通过`set maxvar`设置最大的变量数量。

- 2. **数据压缩:** 使用`compress`命令可以减少数据集大小,从而节省内存空间。

- 3. **数据抽样:** 在数据集非常大时,使用`sample`命令进行数据抽样,以简化分析过程。

- 4. **分块处理:** 如果数据集无法一次性加载到内存,可以使用`use in`命令分块读取数据。

- ### 6.1.2 高级文本分析案例研究

- 文本分析是Stata的一个重要应用领域。在大规模文本数据处理时,Stata可以运用其丰富的字符串处理功能和正则表达式进行高效的数据清洗和信息提取。

- 一个案例是处理和分析社交媒体数据:

- 1. **数据导入:** 使用`insheet`或`import delimited`命令导入CSV格式的社交媒体数据。

- 2. **文本预处理:**

- - 清洗文本,移除链接、特殊字符等。

- - 将文本转换为小写,以便于处理。

- 3. **信息提取:**

- - 使用正则表达式提取用户提及、话题标签等。

- - 利用`egen`命令生成关键词频率表。

- 4. **情感分析:** 运用Stata的字符串处理功能和自定义算法进行情感倾向性分析。

- ## 6.2 结合机器学习的数据预处理

- ### 6.2.1 机器学习数据准备流程

- 在机器学习项目中,数据预处理是至关重要的一步,它直接影响到最终模型的性能。Stata可以作为数据预处理的一个环节,为后续的机器学习算法提供干净、结构化的数据。

- 1. **数据清理:** 针对数据缺失、异常值进行处理。

- 2. **特征生成:** 使用Stata的`gen`命令生成新的特征,如多项式特征或交互项。

- 3. **标准化和归一化:** 通过`center`和`scale`命令对数据进行标准化处理。

- 4. **变量选择:** 运用Stata的`stepwise`命令进行变量选择。

- ### 6.2.2 特征工程与模型评估

- 特征工程是机器学习中的核心概念,指的是从原始数据中创建特征的过程。Stata可以在此过程中发挥作用。

- 1. **特征转换:** 如对分类变量进行独热编码(one-hot encoding)。

- 2. **模型训练:** 使用Stata内置的机器学习命令,如`logit`(逻辑回归)进行模型训练。

- 3. **模型评估:** 利用`estat clas`、`predict`等命令进行模型评估。

- ## 6.3 Stata与其他工具的集成

- ### 6.3.1 Stata与Python/R的互操作

- Stata与其他数据分析工具,如Python和R,的集成可以发挥各自的优势,提高分析效率。

- 1. **从Stata导出数据到Python/R:**

- - 使用`putexcel`命令将数据导出到Excel,然后在Python/R中读取。

- 2. **从Python/R导入数据到Stata:**

- - 利用Python的`pandas`库或R的`foreign`包等工具从Stata导出的数据中读取数据。

- 3. **混合编程:**

- - 在Stata中使用`shell`命令调用Python/R脚本,进行特定的数据处理或模型训练,然后再将结果导入Stata进行进一步分析。

- ### 6.3.2 全流程数据分析案例展示

- 为了展示Stata与其他工具集成后的全流程数据分析,我们可以举一个例子:

- 1. **数据预处理:**

- - 在Stata中对数据集进行预处理,如数据清洗、缺失值处理等。

- 2. **特征工程:**

- - 使用R进行更高级的特征工程,例如使用R语言包`dplyr`进行数据透视、分组和统计。

- 3. **模型构建与评估:**

- - 将经过Stata和R处理后的数据导入Python,使用`scikit-learn`进行机器学习模型的训练和评估。

- 4. **结果整合:**

- - 将模型评估结果导入Stata,并使用Stata的绘图和报告功能展示分析结果。

- Stata的灵活性以及与其他工具良好的集成能力,使其在数据预处理、模型建立和结果展示等各个环节都发挥着重要作用。这些案例展示了Stata在综合应用中的多面性和强大功能。