【CSV文件处理入门】:数字列转换基本操作指南

发布时间: 2024-12-04 10:45:17 阅读量: 8 订阅数: 15

参考资源链接:[CSV文件中数字列转文本列的解决方案](https://wenku.csdn.net/doc/26fe1itze5?spm=1055.2635.3001.10343)

# 1. CSV文件处理基础知识

CSV(Comma-Separated Values,逗号分隔值)文件是一种简单的文件格式,用于存储表格数据,包括数字和文本。其广泛应用在数据交换中,因为它简单、通用且易于创建和编辑。CSV文件以纯文本形式存储数据,每一行代表一个数据记录,记录的字段通常使用逗号分隔。

CSV文件的优点包括:

- **兼容性**:几乎所有的表格处理软件和编程语言都能处理CSV文件。

- **简单性**:CSV文件的结构简单,易于人工阅读和编写。

- **灵活性**:CSV文件没有固定的结构定义,字段可以是任意类型。

处理CSV文件时,你可能会遇到不同字符编码(如UTF-8、ISO-8859-1)以及不同操作系统下的换行符差异(如Windows下的CR+LF和Unix/Linux下的LF)。理解这些基础知识有助于在接下来的章节中深入探讨如何有效地读取、解析和转换CSV文件数据。

# 2. CSV文件的读取与解析技巧

## 2.1 CSV文件结构理解

### 2.1.1 CSV文件的组成和特点

CSV(Comma-Separated Values,逗号分隔值)文件是一种常用的数据格式,用于存储表格数据,如电子表格或数据库。其特点包括:

- 由纯文本组成,包含数值和文本数据。

- 数据项通常用逗号分隔,但有时也会使用其他分隔符,如制表符、分号等。

- 每一行代表一个数据记录,通常包含多个字段,字段间由分隔符分隔。

- 不记录数据类型信息,所有内容默认为字符串。

CSV文件的这些特点使它成为不同应用程序和平台间交换数据的理想选择。由于其简单性,CSV文件也被广泛用于备份和迁移数据。

### 2.1.2 如何正确打开和查看CSV文件

查看CSV文件不需要特殊的软件,因为它是一种通用的文本格式。以下是一些打开和查看CSV文件的常见方法:

- **文本编辑器**:任何标准的文本编辑器(如Notepad、Sublime Text或VS Code)均可用来打开CSV文件。这种方式便于查看文件格式和内容,但不适合处理大型文件。

- **电子表格软件**:Microsoft Excel、Google Sheets和LibreOffice等电子表格软件可以打开CSV文件,并且自动按照逗号分隔符将数据分列到不同的单元格中。

- **编程编辑器**:如Visual Studio Code配合相应的CSV插件,可以帮助开发者以表格形式更直观地查看CSV文件。

## 2.2 CSV文件内容解析方法

### 2.2.1 分割字段和处理引号、逗号

CSV文件中的字段可能包含分隔符(如逗号)或引号。这些情况需要特别处理以确保数据的准确性:

- **引号内的逗号**:当字段内包含逗号时,该字段应被引号包围。例如:"Hello, World!" 应被读取为一个字段。

- **引号内的引号**:如果字段内包含引号,通常需要使用两个引号来表示一个引号。例如:"He said, ""Hello, World!""" 应被解析为 "He said, "Hello, World!""。

### 2.2.2 编码格式和换行符处理

处理CSV文件时,常见的问题还涉及编码和换行符:

- **编码格式**:CSV文件通常采用UTF-8编码。如果遇到编码不一致的问题,可能导致乱码或读取错误。正确设置读取工具的编码格式是解决这一问题的关键。

- **换行符**:不同操作系统可能会使用不同的换行符(如Windows使用CR+LF,而Unix/Linux使用LF)。在解析时,应当将所有换行符统一为一种标准格式,以避免数据读取错误。

## 2.3 利用编程语言进行CSV读取

### 2.3.1 Python中的csv模块使用

Python的`csv`模块是处理CSV文件的强大工具。以下是使用Python的`csv`模块读取CSV文件的示例代码:

```python

import csv

# 打开CSV文件

with open('data.csv', mode='r', encoding='utf-8') as file:

# 创建csv.reader对象

csv_reader = csv.reader(file)

# 逐行读取CSV文件内容

for row in csv_reader:

print(row)

```

在此段代码中,我们首先导入了Python的`csv`模块,然后使用`open`函数以读取模式打开一个CSV文件。我们使用`csv.reader`对象来读取文件,这样可以正确处理逗号分隔的字段和引号内的逗号。

### 2.3.2 JavaScript中csv解析库的使用

JavaScript中,我们可以使用第三方库如`papaparse`来解析CSV文件。以下是使用`papaparse`解析CSV文件的示例代码:

```javascript

import { parse } from 'papaparse';

const csvData = "Name,Age\nJohn Doe,30\nJane Smith,25";

const result = parse(csvData, {

header: true,

complete: function(result) {

console.log('CSV文件解析成功!');

console.log(result.data); // 输出解析后的数据

},

error: function(error) {

console.log('解析CSV文件时发生错误!');

console.error(error);

}

});

```

在这段代码中,我们首先引入了`papaparse`库,然后用一个简单的CSV字符串作为示例。调用`parse`函数时,我们指定了几个参数:`header`设置为`true`表示CSV文件包含标题行,`complete`和`error`回调函数分别用来处理解析完成和出错的情况。

通过这些例子,我们可以看到编程语言中处理CSV文件的灵活性和强大功能,允许开发者通过简单的API调用实现复杂的CSV文件处理。

# 3. 数字列转换操作实践

## 3.1 数字列转换的必要性

在处理CSV文件时,经常会遇到数据格式不一致的情况,尤其是数字列。数字列可能包含前导或尾随的空格、逗号或其他非数字字符,这会导致数据分析和处理前的预处理变得复杂。

### 3.1.1 数据格式不一致问题

数据格式不一致会影响数据的整洁性和准确性。例如,一个数字列中可能包含整数、浮点数,以及一些带有货币符号或其他非数字字符的值。这些不一致的格式必须被统一,才能进行有效分析。处理不一致的数据格式是数据预处理的一个重要步骤,它确保数据的质量,减少后续分析过程中可能发生的错误。

### 3.1.2 数据分析和处理前的预处理

预处理步骤涉及检查数据集的完整性,包括处理缺失值、异常值和数据类型转换。数字列转换是预处理的一个关键部分,它将确保在进行数学运算、统计分析或机器学习建模时数据的一致性和准确性。如果数字列包含文本值或格式错误,可能会导致分析工具出现错误或异常行为。

## 3.2 CSV中数字列的基本转换操作

数字列的基本转换操作涉及将非数字格式转换为可被分析工具识别和处理的格式。

### 3.2.1 去除数字列中的非数字字符

非数字字符包括逗号、引号、美元符号等,这些字符在数字列中通常是不需要的。它们可能是由于CSV文件的错误导出或手动输入错误而产生的。下面是一个使用Python进行去除非数字字符的例子。

```python

import csv

# 读取CSV文件

with open('data.csv', mode='r', encoding='utf-8') as file:

reader = csv.reader(file)

header = next(reader) # 读取表头

data = list(reader)

# 转换数据中的数字列

for i, row in enumerate(data):

for j, value in enumerate(row):

if j in numeric_columns: # numeric_columns是包含数字列索引的列表

row[j] = ''.join(char for char in value if char.isdigit() or char in ['.', '-'])

# 将转换后的数据写回CSV

with open('transformed_data.csv', mode='w', encoding='utf-8', newline='') as file:

writer = csv.writer(file)

writer.writerow(header)

writer.writerows(data)

```

### 3.2.2 将字符串转换为数字

一旦非数字字符被去除,我们就可以将剩余的字符串转换为数字。在Python中,可以使用内置的`int()`和`float()`函数来完成这一转换。

```python

# 假设我们已经有了清洗后的数据

transformed_data = [

# ... 清洗后的数据 ...

]

# 将字符串转换为数字

for row in transformed_data:

for j, value in enumerate(row):

try:

# 尝试将字符串转换为整数或浮点数

row[j] = float(value) if '.' in value else int(value)

except ValueError:

# 如果转换失败,可能是因为值为空或者包含无法转换为数字的字符

row[j] = None

# 写回CSV文件

# ... 与上面类似的过程 ...

```

## 3.3 复杂数字列转换策略

对于一些复杂的数字列转换,比如日期和时间格式的解析,以及将数字字符串转换为浮点数,我们需要采用更为复杂的策略。

### 3.3.1 解析日期和时间格式

日期和时间在CSV文件中可能以多种格式出现。要正确解析这些值,我们需要知道它们的确切格式,并使用适当的解析方法。

```python

import datetime

def parse_date(date_str):

# 假设日期格式为 YYYY-MM-DD

try:

return datetime.datetime.strptime(date_str, '%Y-%m-%d').date()

except ValueError:

return None

# 假设我们有一列包含日期数据的字符串

dates = ['2023-01-01', '2023-02-28', 'invalid-date']

# 解析日期

parsed_dates = [parse_date(date) for date in dates]

# 转换后的日期列表将包含datetime.date对象或None值

```

### 3.3.2 将数字字符串转换为浮点数

如果CSV文件中的数字列包含千位分隔符或货币符号,我们需要额外的处理步骤来提取实际的数值。

```python

def parse_float(float_str):

# 去除数字中的逗号(千位分隔符)

clean_str = float_str.replace(',', '')

try:

return float(clean_str)

except ValueError:

return None

# 假设我们有一列包含千位分隔符的数字字符串

numbers_with_commas = ['1,000', '2,345.67', 'invalid-number']

# 转换数字字符串为浮点数

parsed_floats = [parse_float(num) for num in numbers_with_commas]

# 转换后的列表将包含浮点数或None值

```

在进行这些转换时,确保在处理数据时考虑到数据的完整性和准确性,尤其是在涉及到非标准或复杂的数字格式时。同时,使用异常处理机制,如`try-except`语句,来处理可能出现的错误,确保程序的鲁棒性。

# 4. 使用工具进行数字列转换

## 4.1 图形界面工具的基本操作

图形界面工具由于其直观和易操作性,在数据转换领域中占有重要地位。让我们深入了解如何使用Excel和OpenRefine这两种流行的工具来进行数字列的转换。

### 4.1.1 Excel中的数据转换功能

Microsoft Excel是处理和转换数据的强大工具。它提供了一系列数据格式转换的功能,可以直接在用户界面中操作,非常适合手动或小规模的数据转换。

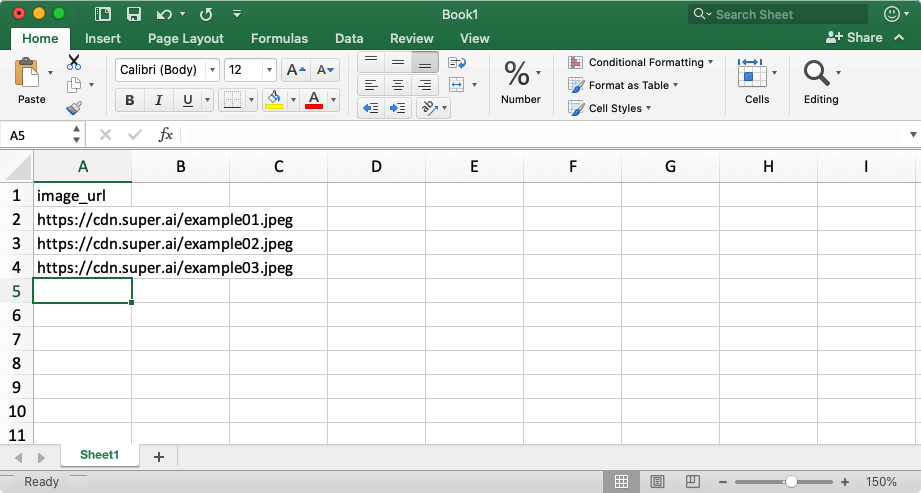

#### 步骤一:打开Excel并加载CSV文件

首先,打开Excel程序,然后点击“打开”按钮,选择需要转换的CSV文件。

#### 步骤二:数据导入向导

在文件打开后,Excel会启动数据导入向导。在这个向导中,你可以指定字段的分隔符,选择文本分隔符,以及确定数据的格式。

```mermaid

flowchart LR

A[开始] --> B[打开Excel]

B --> C[选择打开CSV]

C --> D[启动数据导入向导]

D --> E[指定分隔符]

E --> F[选择文本分隔符]

F --> G[确定数据格式]

G --> H[完成导入]

```

#### 步骤三:使用Excel内置函数进行转换

导入数据后,你可以使用Excel的内置函数来转换数据。例如,使用 `VALUE` 函数将文本转换为数字,或者使用 `DATEVALUE` 将日期字符串转换为Excel的日期格式。

```excel

=VALUE(A1)

```

上述公式会将A1单元格中的文本转换为数字。同样,`DATEVALUE` 函数可以将日期格式的文本转换为Excel的日期数值:

```excel

=DATEVALUE("2023/01/01")

```

#### 步骤四:格式设置

在Excel中,你还可以通过修改单元格的格式来控制数据的显示。例如,通过设置“数字”格式来控制数字的显示方式,或者设置“日期”格式来控制日期的显示。

### 4.1.2 OpenRefine的数据清洗能力

OpenRefine是一个开源的数据清洗工具,非常适合处理大规模数据集,特别是那些包含不一致或脏数据的集。

#### 步骤一:导入数据

下载并安装OpenRefine后,启动程序并导入CSV文件。

```mermaid

flowchart LR

A[开始] --> B[启动OpenRefine]

B --> C[选择导入CSV文件]

C --> D[设置分隔符]

D --> E[预览数据]

E --> F[完成导入]

```

#### 步骤二:探索性数据操作

在OpenRefine中,你可以通过多种方式来探索和清洗数据。使用“剪切”、“粘贴”功能来处理特定的列。

#### 步骤三:转换数字和日期格式

对于需要转换的数字或日期列,使用“编辑列”功能,然后选择“通过公式创建新列”。在这里,你可以使用GREL(General Refine Expression Language)来定义转换逻辑。

例如,要将文本转换为数字:

```grel

value.toNumber()

```

要将日期转换为特定格式:

```grel

value.toString("yyyy-MM-dd")

```

## 4.2 命令行工具的高级应用

虽然命令行工具可能不如图形界面直观,但在处理大量数据或需要自动化转换时,它们是非常强大的工具。让我们探索如何使用Awk和sed以及Perl脚本来转换数字列。

### 4.2.1 Awk和sed工具的组合使用

Awk和sed是Unix和类Unix系统中强大的文本处理工具。它们可以通过简单但强大的命令行指令来处理文本文件。

#### 示例:使用Awk和sed转换数字

假设我们有一个CSV文件 `data.csv`,需要将第一列中的文本转换为数字。我们可以使用以下命令:

```bash

sed 's/[^0-9]//g' data.csv | awk -F, 'BEGIN{OFS=","}{for(i=1;i<=NF;i++){if(i==1){$i=$i+0}} print $0}'

```

这段命令的工作流程:

1. `sed 's/[^0-9]//g'`:使用sed删除所有非数字字符。

2. `awk -F, 'BEGIN{OFS=","}{...} print $0'`:使用awk处理每一行,将第一列(`$i` 当 `i` 等于 1 时)转换为数字。

### 4.2.2 Perl脚本进行复杂数据转换

Perl是一个通用的编程语言,非常适合处理文本和正则表达式。它可以在命令行中执行,也可以编写为脚本使用。

#### 示例:使用Perl脚本解析日期格式

假设我们需要将日期从 `dd/mm/yyyy` 格式转换为 `yyyy-mm-dd` 格式,我们可以使用以下Perl脚本:

```perl

perl -pe 's/(\d{2})\/(\d{2})\/(\d{4})/$3-$1-$2/' data.csv

```

这段代码的逻辑解释:

1. `-pe`:告诉Perl在输入行上执行后面的正则表达式。

2. `s/.../.../`:正则表达式的替换操作。

3. `(\d{2})\/(\d{2})\/(\d{4})`:匹配日期格式并将其分组。

4. `$3-$1-$2`:将捕获的分组重新排列为新的日期格式。

## 4.3 编程语言中的数据转换库

### 4.3.1 Python中的pandas库应用

Python是一种流行的数据科学编程语言,具有非常强大的数据处理库——pandas。pandas库提供了非常方便的函数来处理CSV文件,并进行数据转换。

#### 示例:使用pandas进行数字列转换

假设我们有一个CSV文件 `data.csv`,我们想将名为 `column_name` 的列从字符串转换为浮点数,可以使用以下Python脚本:

```python

import pandas as pd

# 读取CSV文件

df = pd.read_csv('data.csv')

# 转换指定列

df['column_name'] = pd.to_numeric(df['column_name'], errors='coerce')

# 输出转换后的数据

print(df)

```

在这段代码中:

1. `pd.read_csv('data.csv')`:使用pandas读取CSV文件。

2. `pd.to_numeric(df['column_name'], errors='coerce')`:将指定列转换为数字,无法转换的将变为NaN(不是数字)。

### 4.3.2 R语言的数据处理技巧

R语言是另一种用于统计分析和图形表示的编程语言。它提供了专门的包来处理CSV文件,如`readr`包。

#### 示例:使用R语言的readr包进行转换

假设我们有一个CSV文件 `data.csv`,并想将名为 `column_name` 的列转换为数值类型,可以使用以下R代码:

```r

library(readr)

library(dplyr)

# 读取CSV文件

df <- read_csv("data.csv")

# 转换指定列

df <- df %>% mutate(column_name = as.numeric(as.character(column_name)))

# 输出转换后的数据

print(df)

```

在这段代码中:

1. `library(readr)` 和 `library(dplyr)`:加载用于读取和数据处理的包。

2. `read_csv("data.csv")`:使用readr包读取CSV文件。

3. `mutate(column_name = as.numeric(as.character(column_name)))`:将指定列转换为数值类型。

以上所述,无论是使用图形界面工具还是命令行工具,或是采用编程语言进行数据转换,掌握每种工具的使用技巧都是数据处理不可或缺的一部分。在实际应用中,根据不同的需求和场景,选择最合适的工具来进行数据转换操作,能够显著提升工作效率。

# 5. CSV文件转换的常见问题与解决方案

## 5.1 数据丢失和转换错误的常见原因

### 5.1.1 编码问题导致的数据损坏

当我们在处理CSV文件时,编码问题是最常见的问题之一,尤其是在涉及到多语言或特殊字符时。CSV文件通常使用UTF-8或特定语言编码如GBK或Big5。如果源数据使用的编码与处理时使用的编码不一致,可能导致数据损坏。

以Python为例,如果源数据是以GBK编码存储,而程序使用默认的UTF-8编码来读取,就可能出现乱码。解决这类问题,我们可以通过指定正确的编码格式来读取数据,如下:

```python

import csv

# 假设源CSV文件使用GBK编码

with open('example.csv', 'r', encoding='GBK') as csvfile:

reader = csv.reader(csvfile)

for row in reader:

print(row)

```

在上述代码中,`encoding='GBK'`参数确保了文件按照正确的编码被读取。在处理数据转换时,确保编码一致性是防止数据损坏的关键步骤。

### 5.1.2 不规范的CSV格式问题

不规范的CSV格式,如缺失的逗号、不一致的引号使用等,都会导致解析错误。这类问题常出现在数据导出不规范时,例如手动编辑或不同系统导出时。

为解决不规范的CSV格式问题,我们可以先对数据进行预处理,确保格式符合规范,再进行转换。例如,对于缺失的逗号,我们可以编写一个简单的脚本来插入缺失的逗号:

```python

import re

def fix_inconsistent_csv(input_str):

# 用正则表达式匹配并修复缺失的逗号

return re.sub(r'([^,\n])([\n])', r'\1,\2', input_str)

csv_content = "1234\n5678,9012\n2345"

fixed_content = fix_inconsistent_csv(csv_content)

print(fixed_content)

```

上述代码段会将输入的字符串修复,确保每行末尾有逗号(除非是最后一行)。在实际操作中,可能还需要处理引号、换行符等问题,因此编写一个健壮的预处理脚本非常关键。

## 5.2 转换过程中数据类型不匹配的问题

### 5.2.1 数字和字符串之间转换的注意事项

在CSV数据转换过程中,数字和字符串之间的转换是一个常见的步骤。由于格式问题或数据本身特性,这个过程可能出现错误,例如字符串前导零的丢失或科学计数法格式的数字转换。

在Python中,我们可以使用`int()`和`float()`函数进行转换,同时注意捕获可能出现的异常:

```python

def convert_string_to_number(s):

# 尝试将字符串转换为整数

try:

return int(s)

except ValueError:

# 如果失败,尝试转换为浮点数

try:

return float(s)

except ValueError as e:

# 如果还是失败,返回原始字符串

print(f"Cannot convert string to number: {e}")

return s

# 示例字符串

str_number = "00123"

num = convert_string_to_number(str_number)

print(type(num), num)

```

在上述代码中,如果字符串`str_number`表示的数字在转换为整数时失败(例如,由于前导零导致的错误),则尝试将其转换为浮点数。这种类型检查和异常处理机制确保了类型转换过程的健壮性。

### 5.2.2 解决数据类型不匹配的策略

解决数据类型不匹配的策略包括预定义转换规则、异常处理和数据验证。这要求我们对数据的预期格式有充分的了解,并能够对可能出现的异常情况做出响应。

考虑以下的例子,其中我们定义了几个转换规则:

```python

def safe_convert(value, conversion_type):

try:

if conversion_type == 'int':

return int(value)

elif conversion_type == 'float':

return float(value)

else:

raise ValueError("Unsupported conversion type")

except ValueError as e:

print(f"Conversion error: {e}")

return value

# 示例数据和转换类型

data = ['123', '456.78', 'not a number']

conversion_types = ['int', 'float', 'int']

for item, conversion in zip(data, conversion_types):

result = safe_convert(item, conversion)

print(result)

```

在这个例子中,我们定义了一个`safe_convert`函数,它尝试根据指定的类型将值转换为数字。如果转换失败,它将捕获异常并返回原始值。这使得我们的数据转换过程更加健壮,能够适应各种数据输入。

通过上述的处理和转换方法,我们可以有效地解决数据类型不匹配的问题,并提高数据处理的灵活性和准确性。在后续章节,我们将继续探讨更为复杂的CSV处理技巧和实践。

# 6. 进阶的CSV数据转换和处理技巧

## 6.1 数据验证和校验规则

在处理CSV文件时,数据验证和校验规则是保障数据质量的关键步骤。正确地验证数据可以防止错误数据进入我们的分析或应用。

### 6.1.1 利用正则表达式验证数据

正则表达式是一种强大的文本处理工具,可以帮助我们匹配特定的模式。使用正则表达式对CSV数据进行校验是常见的实践,特别是在处理具有特定格式要求的数据列(例如电话号码、电子邮件地址、日期等)时。

```python

import re

# 示例:验证电子邮件地址

def validate_email(email):

pattern = r"(^[a-zA-Z0-9_.+-]+@[a-zA-Z0-9-]+\.[a-zA-Z0-9-.]+$)"

if re.match(pattern, email):

return True

else:

return False

emails = ["user@example.com", "user_at_example.com", "user@example"]

for email in emails:

print(f"{email}: {'Valid' if validate_email(email) else 'Invalid'}")

```

以上代码定义了一个函数`validate_email`用于校验电子邮件地址。我们使用了正则表达式来匹配电子邮件的标准格式,并在一组电子邮件地址中应用该函数,打印出每封邮件地址的验证结果。

### 6.1.2 编写自定义数据校验函数

有时候标准的校验规则不能完全满足我们的需求,这时我们可以编写自定义的校验函数来处理更复杂的数据验证场景。

```python

def validate_custom(data):

# 假设我们需要验证一个数字列是否在1到100之间

if data.isdigit():

num = int(data)

return 1 <= num <= 100

return False

# 示例数据

data_samples = ["101", "50", "abc", "-10"]

for sample in data_samples:

print(f"{sample}: {'Valid' if validate_custom(sample) else 'Invalid'}")

```

在这段代码中,我们编写了一个自定义校验函数`validate_custom`来检查字符串是否代表一个介于1到100之间的数字。我们测试了几个不同的样本数据来演示函数的用法。

## 6.2 大规模CSV文件的高效处理

当面对大规模的CSV文件时,传统的处理方法可能会变得缓慢和低效。我们需要采用更高效的策略来处理这些数据。

### 6.2.1 分块处理和内存优化

分块处理CSV文件是指每次只加载文件的一部分到内存中进行处理。这种方法特别适用于内存有限的情况。

```python

import pandas as pd

def process_chunk(df_chunk):

# 对数据块进行一些操作,例如数据清洗等

cleaned_chunk = df_chunk.dropna()

return cleaned_chunk

# 打开CSV文件

with open('large_dataset.csv', 'r') as file:

# 使用pandas逐块读取

chunk_size = 10000 # 定义每块的数据行数

for chunk in pd.read_csv(file, chunksize=chunk_size):

# 处理每一块数据

processed_chunk = process_chunk(chunk)

# 处理完毕的数据块可以进一步写入新的CSV或者进行别的操作

```

这里使用了Pandas库的`read_csv`函数,通过`chunksize`参数来实现分块读取CSV文件。然后对每一块数据执行自定义的`process_chunk`函数进行处理。

### 6.2.2 利用数据库进行数据转换和分析

有时候,将CSV数据导入到数据库中进行转换和分析可以极大提高处理速度,特别是当涉及到复杂查询和关联操作时。

```sql

-- 示例:使用SQL对CSV数据进行处理

CREATE TABLE csv_table (id INT, name VARCHAR(100), price DECIMAL);

-- 假设已经将CSV数据导入到了csv_table表中

-- 现在进行数据转换操作,更新价格列,假设价格需要乘以1.05

UPDATE csv_table SET price = price * 1.05;

```

这是一个SQL示例,演示了如何对数据库中的一张表(假设该表是从CSV导入的)进行更新操作,以改变价格数据。数据库通常优化得非常高效,能够处理大量数据的复杂操作。

## 6.3 跨平台数据处理和转换

不同操作系统间可能会有文件格式和编码的差异,导致数据处理时出现兼容性问题。此外,利用云服务和API可以更灵活地进行数据转换和处理。

### 6.3.1 不同操作系统间的CSV处理差异

在不同的操作系统之间处理CSV文件时,需要注意文件的换行符和编码格式的差异。例如,Windows系统通常使用`\r\n`作为换行符,而Linux和macOS使用`\n`。

### 6.3.2 利用云服务和API进行数据转换

云服务提供了各种API来帮助我们处理和转换数据,我们可以编写脚本来调用这些API,实现数据的自动化处理。

```python

import requests

def transform_data_with_api(api_url, data):

headers = {'Content-Type': 'application/json'}

response = requests.post(api_url, json=data, headers=headers)

if response.status_code == 200:

return response.json()

else:

raise Exception(f"API Error: {response.status_code}")

# 假设有一个在线服务可以转换日期格式

api_url = "http://example.com/transform/date"

data = {"date": "01/01/2023"}

converted_date = transform_data_with_api(api_url, data)

print(f"Converted date: {converted_date}")

```

上述代码片段演示了如何使用`requests`库向一个在线API发送数据,该API负责对日期格式进行转换。我们构造了一个JSON格式的请求体,并发送POST请求到API,处理返回的数据或错误。

在进行跨平台数据处理时,我们还可以利用容器化技术(如Docker)和虚拟机来确保开发环境与生产环境的一致性,这样可以避免因系统差异导致的问题。通过这些策略,我们能够确保在不同环境下处理CSV数据时,具有一致性和可靠性。

0

0