软件设计并发处理手册:精通多线程与同步机制的秘诀

发布时间: 2025-01-03 02:40:44 阅读量: 8 订阅数: 15

C语言多线程编程:线程控制与同步机制详解

# 摘要

并发处理是现代软件系统中用于提高效率和响应性的关键技术。本文首先介绍了并发处理的基础理论,然后深入探讨了多线程编程的基础知识、线程同步机制以及线程安全的数据结构。文章接着转向高级并发模型,讨论了并发任务的分解与并行执行、锁无关的编程技术和并发设计模式。在同步机制的高级应用部分,本文涵盖了优化并发性能、高级同步机制以及错误处理与调试。最后,通过实践案例分析,本文展示了多线程在服务器端的应用、并发编程的实战演练和性能基准测试与优化。本文旨在为读者提供一套完整的并发编程知识体系和实用的优化技巧,以应对现代软件开发中的并发挑战。

# 关键字

并发处理;多线程编程;线程同步;线程安全;并行执行;性能优化

参考资源链接:[软考中级《软件设计师》备考笔记精华要点](https://wenku.csdn.net/doc/1zc6zno4c5?spm=1055.2635.3001.10343)

# 1. 并发处理的基础理论

## 1.1 理解并发与并行的区别

并发(Concurrency)和并行(Parallelism)是并发处理中的两个基本概念,但它们并不相同。并发指的是多个任务在宏观上同时进行,但在微观上可能交替执行,尤其适用于单核处理器通过时间分片技术实现多个任务的快速切换。并行则指的是在多核处理器上,多个任务真正的同时执行,这要求硬件支持。

## 1.2 并发处理的目的

并发处理的主要目的包括:提高系统的吞吐量,通过并发执行多个任务来最大化CPU的利用率;提升资源利用率,允许多个进程或线程共享计算资源;改善用户体验,通过并发操作减少任务完成时间,使用户感受到更快的响应速度。

## 1.3 并发处理中的挑战

并发处理也带来了挑战,例如线程安全问题、资源竞争和死锁、性能瓶颈等。开发者需要合理设计并发程序的架构,使用同步机制确保数据的一致性,同时需要精心安排任务调度,以最小化冲突和最大化效率。

## 1.4 并发的理论模型

在并发处理的理论模型中,常见的有冯·诺伊曼模型(Von Neumann architecture)和基于消息传递的模型。理解这些模型有助于设计更高效的并发算法和应用,确保并发程序的正确性和性能。

## 1.5 小结

本章介绍了并发处理的一些基础概念和理论,为后续章节深入探讨多线程编程和并发模型奠定了基础。在下一章,我们将详细探讨多线程编程的基础,包括线程的创建、管理和同步机制。

# 2. 多线程编程基础

### 2.1 线程的基本概念与创建

#### 2.1.1 理解进程与线程

在计算机科学中,进程和线程是并发执行的基本单位。进程是系统进行资源分配和调度的一个独立单位,拥有独立的地址空间和系统资源,例如内存和文件句柄。进程之间通信较为复杂,通常需要借助于操作系统提供的进程间通信IPC机制。

线程是进程中的一个执行单元,是CPU调度和分派的基本单位,它被包含在进程之中,是进程中的实际运作单位。线程也拥有自己的栈、程序计数器和寄存器等上下文信息,但与进程不同的是,线程之间的资源是共享的。在现代操作系统中,线程是程序进行并发执行的基本形式。

从概念上来讲,进程可以看做是一个工厂,而线程则是工厂中的工人。一个工厂可以有很多工人,这些工人协同完成工作。如果一个工人(线程)的工作出现了问题,不会影响到其他工人(其他线程),但可能会影响到整个工厂(进程)的生产效率。

#### 2.1.2 创建和管理线程的API

在多线程编程中,需要通过特定的API来创建和管理线程。不同编程语言提供了不同的API集。以Java和Python为例,介绍创建线程的常用API。

在Java中,可以创建一个继承自`Thread`类的子类,并重写`run`方法来定义线程的任务。然后,创建该类的实例并调用`start`方法启动线程。

```java

class MyThread extends Thread {

@Override

public void run() {

// 线程需要执行的任务

}

}

// 创建线程实例并启动

MyThread thread = new MyThread();

thread.start();

```

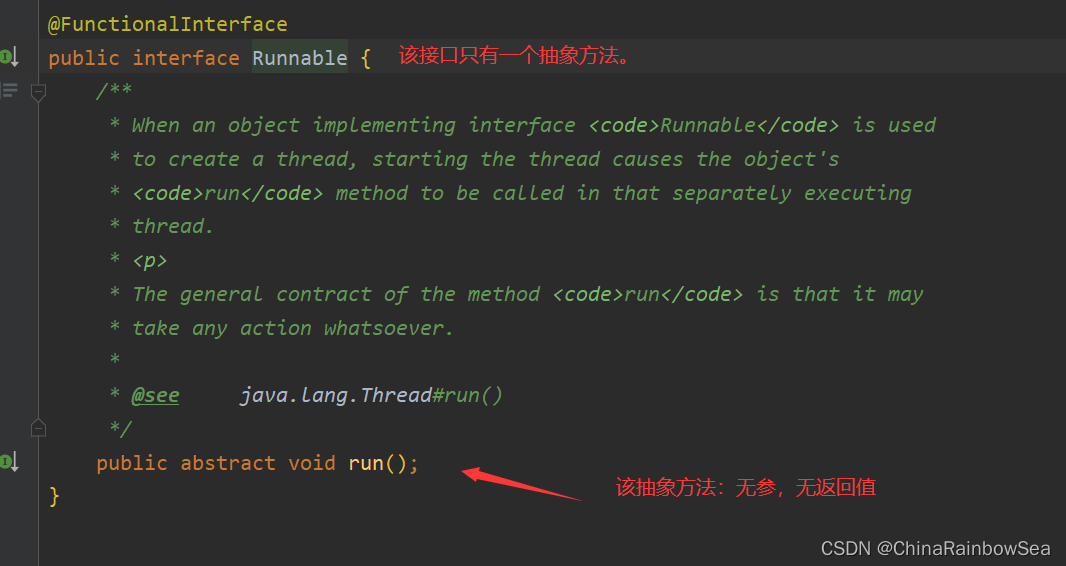

另外,Java还提供了一个`Runnable`接口,可以实现该接口来定义任务,然后将其实例传递给`Thread`类的构造函数。这种方式更加灵活,因为`Runnable`可以被多线程共享。

```java

class MyRunnable implements Runnable {

@Override

public void run() {

// 线程需要执行的任务

}

}

// 创建线程实例并启动

Thread thread = new Thread(new MyRunnable());

thread.start();

```

在Python中,可以使用`threading`模块创建和管理线程。首先需要定义一个继承自`Thread`的类,并重写`run`方法。然后创建该类的实例,并调用`start`方法启动线程。

```python

import threading

class MyThread(threading.Thread):

def run(self):

# 线程需要执行的任务

# 创建线程实例并启动

thread = MyThread()

thread.start()

```

管理线程通常涉及到启动、停止、等待线程执行完成以及获取线程状态等操作。在多线程编程中,要特别注意线程同步和数据共享的问题,以防止竞态条件和数据不一致的情况发生。

### 2.2 线程同步机制

#### 2.2.1 互斥锁(Mutex)

互斥锁(Mutual Exclusion Lock,简称Mutex)是一种用于多线程编程的同步机制。它的主要目的是保证在任何时刻,只有一个线程可以执行关键代码段(临界区)。当一个线程获得锁时,其他试图获取锁的线程将被阻塞,直到锁被释放。

互斥锁是一种最简单的锁机制,适用于对共享资源进行排他性访问的场景。下面是一个使用互斥锁的Python示例:

```python

import threading

# 创建锁

lock = threading.Lock()

def my_function():

global shared_resource

lock.acquire() # 尝试获取锁

try:

# 临界区:只有一个线程可以执行此代码

shared_resource += 1

finally:

lock.release() # 释放锁

# 创建线程

threads = []

for i in range(10):

t = threading.Thread(target=my_function)

threads.append(t)

t.start()

# 等待所有线程完成

for t in threads:

t.join()

```

在此代码中,我们创建了一个互斥锁,并在修改共享资源`shared_resource`时获取该锁。这保证了即使多个线程同时访问这个修改操作,也只有一个线程可以执行,从而防止数据竞争。

#### 2.2.2 信号量(Semaphore)

信号量是一种更为通用的同步机制。它可以被看作是一个计数器,用来控制同时访问特定资源的线程数量。当信号量被初始化后,通常只能通过两个操作来改变它的值:wait(或P操作)和signal(或V操作)。

- `wait`操作会减少信号量的值,如果结果小于0,则阻塞当前线程,直到信号量的值非负。

- `signal`操作会增加信号量的值,如果有其他线程因为这个信号量而被阻塞,那么其中的一个会被唤醒。

信号量在很多情况下用于控制并发数,例如限制服务器同时处理的请求数量。

以下是使用信号量控制并发访问资源的Python示例:

```python

import threading

# 初始化信号量,允许最多3个线程同时访问

semaphore = threading.Semaphore(3)

def my_function():

semaphore.acquire() # 减少信号量的值

try:

# 此代码块同一时间最多允许3个线程执行

pass

finally:

semaphore.release() # 增加信号量的值

# 创建并启动线程

# ...

```

在上面的示例中,通过信号量我们可以控制同时访问代码块的线程数量。这在很多情况下很有用,比如限制并发数。

#### 2.2.3 事件(Event)和条件变量(Condition Variable)

事件(Event)和条件变量(Condition Variable)是另一种类型的同步机制,用于线程间的事件通知。它们提供了线程之间更高级的协作手段。

- 事件(Event)允许线程等待某个条件的发生,并由其他线程发出信号。

- 条件变量(Condition Variable)与锁配合使用,允许一个或多个线程等待某个条件为真时再继续执行。

这两种机制是处理复杂同步问题的有力工具。它们可以用来实现复杂的通信模式,比如生产者-消费者模式。

下面是一个使用事件的Python示例:

```python

import t

```

0

0