【Thinkphp数据一致性:批量更新与事务管理的黄金搭档】:确保数据完整性的实践指南

发布时间: 2024-12-22 11:15:51 阅读量: 5 订阅数: 9

Thinkphp批量更新数据的方法汇总

# 摘要

本文对数据一致性概念及其在现代数据库系统中的重要性进行了探讨,并深入分析了批量更新的定义、工作原理及性能优势。文中详细阐述了批量更新中可能遇到的问题和挑战,如数据完整性和并发问题,同时提出了最佳实践策略,包括SQL优化技巧和性能限制。随后,文章转向事务管理的基本概念、实现方法及监控与调试技术,强调了ACID特性和不同隔离级别的作用。结合批量更新与事务管理的应用,讨论了在实际开发中如何使用ThinkPHP框架实现数据一致性的事务控制,以及特定场景下的事务管理案例。文章最后探索了在分布式系统中实现数据一致性的高级实践技巧和性能调优策略,通过案例研究,分析了大数据量处理策略和异常处理机制,并提出了针对性的性能调优技巧。

# 关键字

数据一致性;批量更新;事务管理;ACID特性;并发控制;性能调优

参考资源链接:[ThinkPHP批量更新数据的三种方法详解](https://wenku.csdn.net/doc/64534c6cea0840391e77945e?spm=1055.2635.3001.10343)

# 1. 数据一致性的概念与重要性

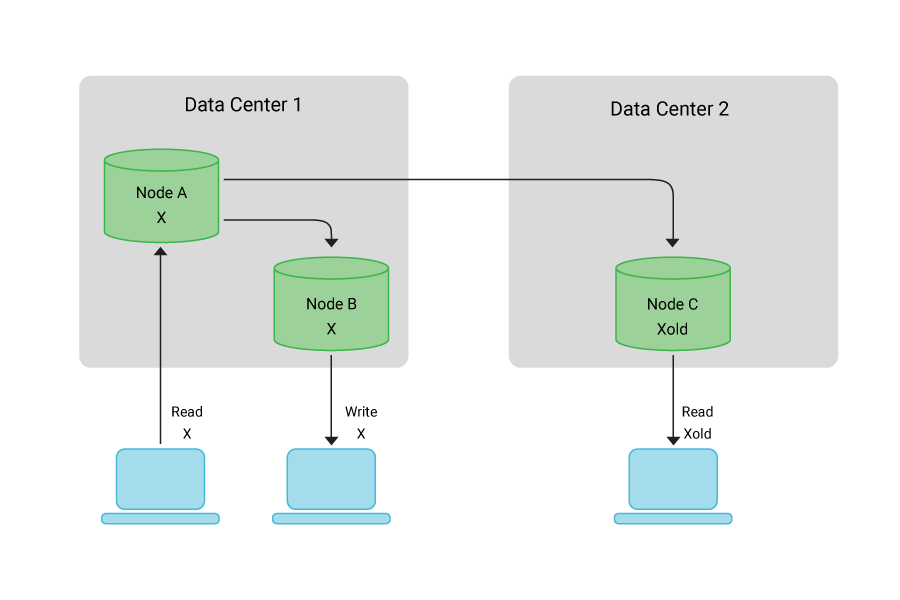

在信息技术领域,数据一致性是指在一系列操作过程中数据状态的正确性和稳定性。无论是在单个数据存储系统还是跨多个系统中,一致性的实现对于确保数据的可靠性、完整性以及准确性和用户信任至关重要。当数据在多个系统间复制或同步时,一致性的维护尤为复杂,因为它涉及到数据一致性协议、数据同步机制以及最终用户对数据完整性的期待。

一致性的缺失可能导致数据的不一致,这会直接影响到业务决策和操作的准确性。例如,在银行系统中,数据一致性保证了账户余额的准确性,如果出现不一致可能会导致财务损失或用户信任度下降。因此,无论数据大小和系统复杂度如何,维护数据一致性是整个IT行业的基础需求。在后续章节中,我们将探讨如何通过批量更新和事务管理等技术手段,来有效地实现和优化数据一致性。

# 2. 理解批量更新

在数据库管理中,批量更新是提升操作效率和减少I/O操作次数的重要手段。随着数据量的增大,使用批量更新不仅可以提高操作效率,还能在某种程度上提高数据操作的吞吐量。本章将详细探讨批量更新的定义、工作原理、遇到的问题和挑战,以及最佳实践。

## 2.1 批量更新的定义及其工作原理

### 2.1.1 批量更新与单条记录更新的区别

批量更新,顾名思义,是在数据库操作中一次性更新多条记录的方法。这与传统的单条记录更新方式有着明显的区别。

单条记录更新在每次操作中只处理一条数据,对数据库进行一次写入。这种方法的优点是简单直接,适用于对数据完整性要求极高的场景。但是,频繁的单条记录更新会导致大量的磁盘I/O操作,影响数据库的性能。

而批量更新则将多条更新操作合并,通过减少磁盘I/O操作次数来提高性能。在执行批量更新时,数据库管理系统的内部缓冲区被多个更新语句填满,这些更新语句随后被批量处理,大大减少了I/O操作的次数。这使得批量更新尤其适用于处理大量数据的情况。

### 2.1.2 批量更新在性能上的优势

批量更新在性能上的优势主要体现在减少磁盘I/O次数和提高数据库写入效率上。由于数据更新操作是累积在内存中,并在达到一定数量后一次性执行,因此可以显著减少磁盘I/O的次数。在数据库操作中,I/O操作往往是性能瓶颈,因此减少I/O次数可以带来性能上的大幅跃升。

除了减少I/O操作次数外,批量更新还能提高数据库的写入效率。由于一次性处理多条记录,减少了数据处理的时间开销。此外,批量更新还可以降低锁竞争,减少了在并发操作时的事务冲突。

## 2.2 批量更新操作中的问题与挑战

### 2.2.1 数据完整性和错误处理

尽管批量更新带来了性能上的优势,但其也带来了数据完整性和错误处理方面的问题。在批量更新过程中,一旦遇到错误,需要能够准确地回滚整个批量操作,以保证数据的一致性。

为了处理这些潜在的错误,开发者通常需要为批量更新操作实现详细的异常处理逻辑。在发生错误时,应确保能够捕获到这些异常,并将数据库恢复到执行批量更新之前的状态。

### 2.2.2 脏读、不可重复读和幻读问题

在进行批量更新操作时,可能遇到脏读、不可重复读和幻读等事务隔离问题。这些问题可能会导致数据的不一致性。

脏读是指一个事务读取了另一个事务未提交的数据。在批量更新的场景下,如果一个事务中的更新操作还未提交,另一个事务就读取了这些未提交的数据,那么就发生了脏读。

不可重复读是指一个事务多次读取同一数据,由于其他事务的更新操作,导致读取结果不一致。批量更新中,如果一个事务在多次读取过程中,其他事务执行了更新操作,就会造成不可重复读。

幻读是指当一个事务重新读取先前读过的范围时,由于其他事务插入了新的记录,导致读取结果包含新的“幻影”记录。

为了解决这些问题,开发者需要了解数据库的事务隔离级别,并根据业务需求选择合适的隔离级别来避免事务隔离带来的问题。

## 2.3 批量更新的最佳实践

### 2.3.1 SQL优化技巧

在进行批量更新时,适当的SQL优化可以提高操作的效率和性能。以下是一些SQL优化的技巧:

1. 使用合适的索引:对需要更新的列使用索引可以加快查询速度,特别是当使用WHERE子句来限定更新范围时。

2. 减少数据的移动:更新操作中尽量避免数据列的移动,这可以降低磁盘I/O的负担。

3. 调整批量大小:合理的批量大小可以平衡内存使用和性能提升,需要根据实际的硬件环境进行调整。

### 2.3.2 批量更新的极限和性能限制

尽管批量更新能够显著提高性能,但其也存在极限和性能限制。一方面,内存和缓冲区的大小会限制批量操作的规模。另一方面,过大的批量更新可能会导致数据库的锁竞争,从而降低并发性能。

开发者需要根据实际的应用场景和数据库的性能指标,测试并确定适合的批量操作的极限。在超过这一极限时,就需要考虑将数据分批处理或者改用其他的数据处理策略。

以上内容为第二章:理解批量更新的详细介绍。在下一章中,我们将深入探讨事务管理,了解其基本概念、实现方法,以及监控与调试的相关内容。

# 3. 深入事务管理

## 3.1 事务的基本概念

### 3.1.1 事务的ACID特性

事务是数据库管理系统执行过程中的一个逻辑单位,由一组相关的操作组成。事务必须具备四个基本特性,即ACID属性,这是保证事务可靠性的基石。

- **原子性(Atomicity)**:事务是不可分割的工作单位,事务中的所有操作要么全部完成,要么全部不做,不会停留在中间状态。在发生故障的情况下,可以保证所有的操作回滚到事务开始前的状态。

- **一致性(Consistency)**:事务执行的结果必须使数据库从一个一致性状态转移到另一个一致性状态。一致性状态是指数据的完整性约束没有被破坏,比如完整性规则定义了银行账户的金额总和应当保持不变。

- **隔离性(Isolation)**:通常情况下,事务是并发执行的,事务的执行不应受到其他事务的干扰,即一个事务的中间状态对其他事务是不可见的。

- **持久性(Durability)**:一旦事务提交,其结果就是永久性的,即使系统发生故障也不会丢失。

代码示例解释事务的ACID特性:

```sql

-- 假设有一个银行转账操作

START TRANSACTION; -- 开启事务

UPDATE accounts SET balance = balance - 100 WHERE account_id = 'A'; -- 账户A扣款

UPDATE accounts SET balance = balance + 100 WHERE account_id = 'B'; -- 账户B存款

COMMIT; -- 提交事务

```

如果在执行上述操作时系统崩溃或发生其他故障,数据库管理系统必须能够通过回滚机制确保数据的一致性。

### 3.1.2 事务的隔离级别

数据库事务的隔离级别定义了事务与事务之间的隔离程度。在不同的隔离级别下,事务并发执

0

0