INCA ProF脚本数据处理艺术:高效管理测试数据的8大技巧

发布时间: 2024-12-16 07:50:02 阅读量: 4 订阅数: 8

INCA_ProF脚本教程总结.pdf

参考资源链接:[INCA软件ProF脚本教程详解](https://wenku.csdn.net/doc/644b7ff3fcc5391368e5eee9?spm=1055.2635.3001.10343)

# 1. INCA ProF脚本数据处理概述

## 简介

INCA ProF作为一款先进的脚本语言,常用于数据处理与分析任务。本章节将对使用INCA ProF脚本进行数据处理进行概览,为读者展示一个清晰的概貌,并理解其在数据处理中的基础应用。

## 核心要素

在数据处理中,INCA ProF脚本的核心要素包括数据输入输出、变量与数据类型、控制流程以及函数的使用。通过这些元素,用户能够编写出高效且可维护的脚本来执行复杂的任务。

## 数据处理流程

INCA ProF脚本数据处理流程一般包括数据读取、数据转换、数据分析、报告生成和结果导出等步骤。这一流程强调数据在处理过程中的流转效率及准确度,确保最终结果的可靠性和准确性。

这一章节是整个文章的基石,它提供了INCA ProF脚本处理数据的全局视图。在后续章节中,我们将详细探讨每个步骤的具体方法和技巧。

# 2. 基础数据处理技巧

数据处理是任何数据分析任务的第一步,也是至关重要的一步。基础数据处理技巧能够帮助我们清洗原始数据,确保分析工作的准确性。本章将从数据采集与导入、数据清洗与预处理、数据格式化与标准化三个方面展开详细探讨。

### 2.1 数据采集与导入

在数据处理的初期阶段,我们需要从各种数据源采集信息,并将这些信息导入到我们的数据集中,为后续的数据清洗和分析做准备。

#### 2.1.1 数据采集方法概览

数据采集可以分为被动采集和主动采集。被动采集通常指通过日志收集、网络爬虫、传感器等方式自动收集数据。而主动采集则需要手动设计问卷、安排访谈或实验等方法来获取数据。

##### 代码块示例 - 网络爬虫数据采集

```python

import requests

from bs4 import BeautifulSoup

# 定义一个函数,用于从指定URL中抓取数据

def fetch_data(url):

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 使用BeautifulSoup解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取页面中的所有段落

paragraphs = soup.find_all('p')

data = [p.text for p in paragraphs]

return data

else:

print("网页请求失败")

return []

# 调用函数并打印结果

url = "http://example.com"

data = fetch_data(url)

print(data)

```

在上述代码中,我们使用Python的`requests`库和`BeautifulSoup`库从网页中抓取所有段落文字。每次请求都检查HTTP状态码以确保请求成功,返回的数据可以用于进一步分析或存储。

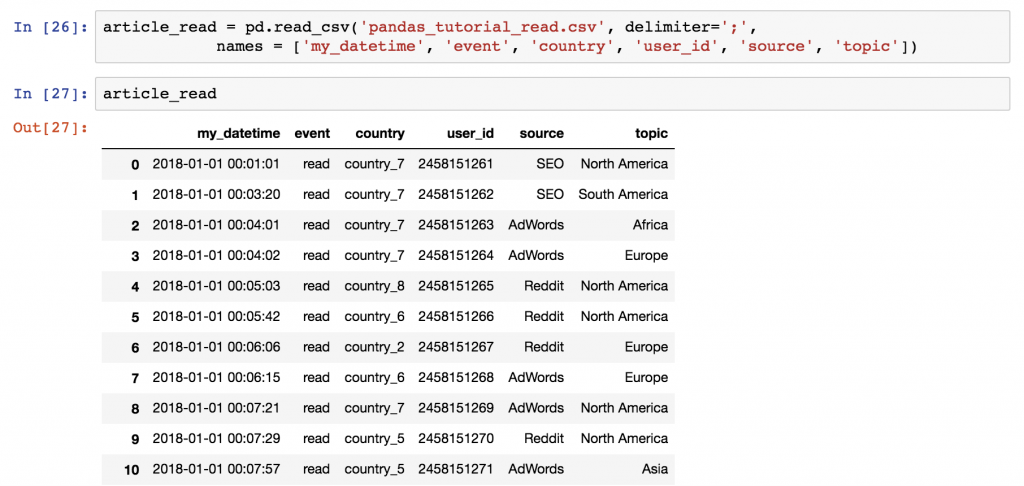

#### 2.1.2 数据导入的策略与实践

采集到的数据需要导入到数据集中,这通常涉及到数据格式转换和数据导入工具的使用。在导入过程中,我们需要保证数据的准确性和完整性。

##### 表格 - 数据导入策略

| 策略 | 说明 | 应用场景 |

| --- | --- | --- |

| 使用数据库导入工具 | 利用数据库提供的导入工具,如MySQL Workbench的导入向导,进行批量数据导入。 | 数据量较大,需要快速导入到数据库的场景。 |

| 编写脚本导入 | 利用编程语言(如Python、SQL)编写数据导入脚本,进行更细粒度的控制。 | 数据源格式多变,需要定制化导入逻辑。 |

| 使用中间件 | 使用如Apache NiFi等中间件,可处理多种数据源的数据传输。 | 数据量大,需要实时或准实时处理的场景。 |

### 2.2 数据清洗与预处理

数据清洗是移除数据集中的无关、错误或重复数据的过程。预处理则涉及转换数据以符合分析工具的要求。

#### 2.2.1 识别和处理缺失值

数据集中常常会存在缺失值,正确处理这些缺失值对于分析结果的准确性至关重要。

##### 代码块示例 - 处理缺失值

```python

import pandas as pd

# 创建一个包含缺失值的DataFrame

data = pd.DataFrame({'A': [1, 2, None, 4]})

# 查找并打印缺失值

print(data.isnull())

# 选择不同的方法处理缺失值

data_filled = data.fillna(data.mean()) # 用平均值填充缺失值

print(data_filled)

```

在上述代码中,我们首先创建一个包含缺失值的DataFrame。使用`fillna`方法将缺失值用该列的平均值进行填充。还可以选择其他填充策略,如使用中位数、众数或者前一个非缺失值等。

#### 2.2.2 异常值的检测与修正

异常值可能影响数据分析的结果,因此需要被特别关注。

##### 代码块示例 - 检测与修正异常值

```python

# 假设我们有一个数据集,需要检测并修正异常值

data = pd.DataFrame({'B': [10, 30, 100, 15, 20]})

# 使用IQR(四分位距)来检测异常值

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 检测数据集中超出上下界的点

outliers = data[(data < lower_bound) | (data > upper_bound)]

print(outliers)

# 修正异常值,这里简单地将其替换为上下界值

data_fixed = data.apply(lambda x: x.clip(lower_bound[x.name], upper_bound[x.name]))

print(data_fixed)

```

在代码示例中,我们通过计算四分位距(IQR)来确定异常值的上下界,然后找出并修正这些异常值。

### 2.3 数据格式化与标准化

数据格式化与标准化确保数据具有一致性和可比性,对于数据处理和分析至关重要。

#### 2.3.1 数据格式转换

数据格式转换是将数据从一种格式变为另一种格式的过程,这是进行数据分析之前常见的步骤。

##### 代码块示例 - 数据格式转换

```python

# 将字符串日期转换为datetime对象

import pandas as pd

data = {'date': ['2021-01-01', '2021-02-01', '2021-03-01']}

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

print(df)

```

在上面的代码中,我们使用Pandas库的`to_datetime`函数将字

0

0