【PyTorch中的ResNet】:在PyTorch中构建和训练高效的Residual Network

深度学习中基于PyTorch的ResNet与动态卷积实现及其应用场景

摘要

本文对ResNet网络架构及其在深度学习中的应用进行了全面介绍。首先,阐述了ResNet的网络原理和PyTorch框架中的深度学习基础知识,包括张量操作、神经网络理论、自动微分和优化器。接着,文章详细介绍了如何在PyTorch中构建ResNet模型,包括残差块的设计、不同版本的ResNet架构、模型的初始化和正则化。在训练和评估方面,本文探讨了数据预处理、训练过程中的损失函数选择和超参数调优,以及如何进行模型评估和测试。最后,文章讨论了ResNet的高级应用和技巧,如迁移学习、模型加速优化以及实际案例研究,为深度学习的研究和应用提供了深入的指导和实用的解决方案。

关键字

ResNet;PyTorch;深度学习;自动微分;模型训练;迁移学习

参考资源链接:深度残差学习:ResNet原理解析

1. ResNet网络架构和原理

1.1 网络背景和创新点

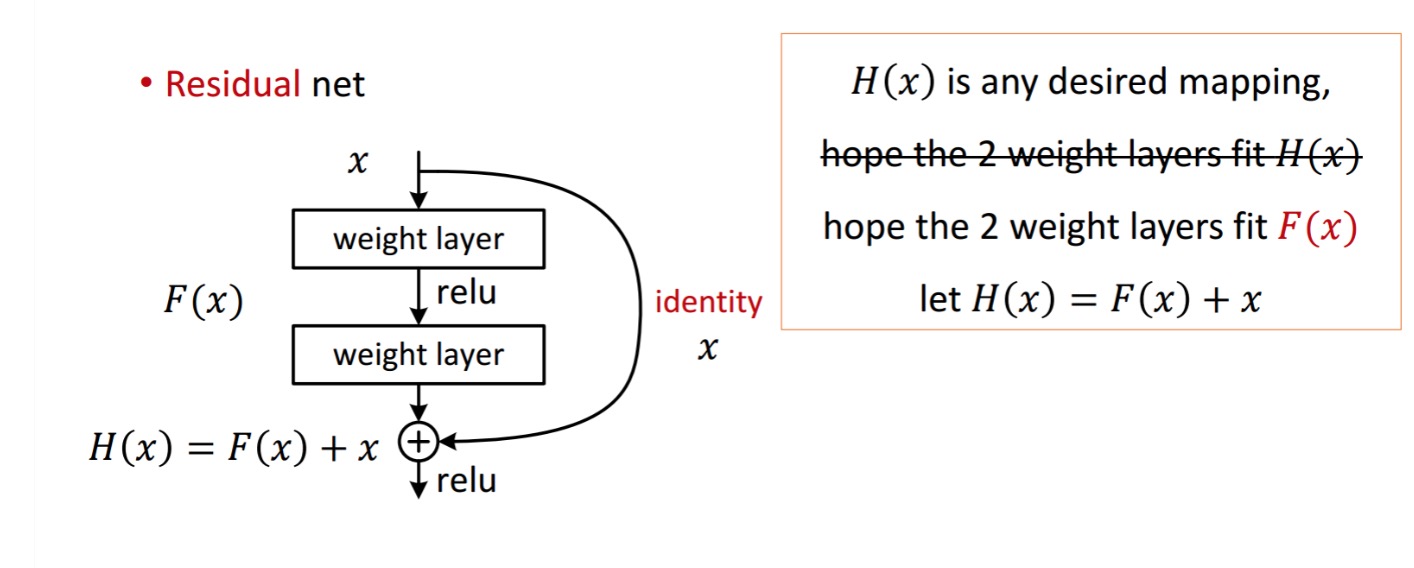

在深度学习领域,Residual Network(ResNet)模型是一次重大突破,解决了深度神经网络训练中的梯度消失问题。ResNet通过引入“残差块”,允许网络层次更深,同时训练效果更佳。其核心创新在于通过捷径连接直接将输入加到后面某层的输出上,从而让网络学习残差映射,简化了学习过程,使得网络能够在更深的层上有效训练。

1.2 架构深度解析

ResNet网络的结构可以分解为多个残差学习模块,每个模块包含一系列的卷积层和非线性激活函数。在一个残差块内,输入数据可以通过捷径直接传递到后面的层,这样的设计有效地缓解了梯度消失或爆炸的问题。通过堆叠多个这样的残差块,可以构建出具有百层或更多层的ResNet模型,极大地扩展了深度网络的深度与性能。

1.3 应用和效果

ResNet的引入使得深度网络在图像识别、目标检测和图像分割等任务中取得了显著的进展。它不仅仅加深了网络层次,而且提高了训练效率和模型的准确性。该架构的成功为后续网络设计提供了重要的思路,如引入更深层的网络结构、更高效的捷径连接方法等,对深度学习模型的发展产生了深远的影响。

2. PyTorch中的深度学习基础知识

深度学习已经成为机器学习领域的一股不可忽视的力量,而PyTorch则是这一领域中最流行的框架之一。在本章节中,我们将深入了解PyTorch的核心组件,包括其对张量的操作,神经网络基础理论,以及PyTorch的自动微分和优化器机制。

2.1 PyTorch框架概述

2.1.1 PyTorch的核心组件

PyTorch由几个核心组件组成,它们协同工作以实现深度学习的各种功能。

- 张量(Tensor): 类似于NumPy中的ndarray,但可以在GPU上运行。它们是PyTorch中的基本数据结构。

- 自动微分引擎(autograd engine): 允许开发者定义和自动计算微分。

- 神经网络模块(nn.module): 提供构建复杂网络的构建块。

- 优化器(optimizer): 实现多种优化算法以提高网络训练效率。

2.1.2 张量操作基础

张量操作是PyTorch实现各种数据处理的基础。让我们来看几个常用的操作:

- import torch

- # 创建一个3x3的张量

- t = torch.tensor([[1., 2., 3.], [4., 5., 6.], [7., 8., 9.]])

- # 张量形状查看

- print(t.shape) # 输出张量形状

- # 张量的转置

- t_transposed = t.t()

- # 张量维度变换

- t_reshaped = t.view(9)

在上述代码中,我们首先创建了一个3x3的张量,然后查看了其形状,接着对其进行了转置和形状变换操作。这些操作在深度学习的数据预处理阶段非常常见,有助于我们对数据进行更加高效的处理。

2.2 深度学习基础理论

2.2.1 神经网络基础

神经网络是由节点或“神经元”组成的大规模并行连接网络,它们相互连接,形成层次结构。每个神经元接受输入信号,处理这些信号并产生输出信号。

- import torch.nn as nn

- # 定义一个简单的神经网络

- class SimpleNet(nn.Module):

- def __init__(self):

- super(SimpleNet, self).__init__()

- self.fc = nn.Linear(in_features=10, out_features=3)

- def forward(self, x):

- x = self.fc(x)

- return x

- # 实例化模型

- net = SimpleNet()

这段代码展示了一个非常基础的神经网络定义,其中nn.Linear模块用来实现线性变换(即全连接层)。实际应用中,神经网络结构会复杂得多。

2.2.2 反向传播和梯度下降

深度学习模型训练过程中一个核心的概念是反向传播算法,用于计算梯度并更新权重。梯度下降是用于最小化损失函数的一种优化算法,其通过更新权重向减小损失函数值的方向进行。

- # 假设y_pred是模型预测结果,y_true是实际标签,loss是损失函数

- loss = criterion(y_pred, y_true)

- # 反向传播,计算loss对每个参数的梯度

- net.zero_grad() # 清空之前的梯度

- loss.backward() # 反向传播计算梯度

- # 更新参数

- optimizer.step() # 优化器进行参数更新

在此代码段中,criterion代表损失函数,optimizer是预定义的优化器。当损失函数定义后,backward()方法会计算损失函数关于权重的梯度,随后使用optimizer.step()来更新权重。

2.3 PyTorch中的自动微分和优化器

2.3.1 自动微分机制

PyTorch的自动微分引擎极大地简化了梯度计算过程。它能够记录对张量进行的所有操作,一旦完成前向传播,就可以通过调用backward()方法来自动计算梯度。

- # 创建张量并设置requires_grad为True以记录梯度

- x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

- y = x * 2

- z = y * y

- # 计算z关于x的导数

- z.backward()

- # 打印梯度

- print(x.grad) # 输出: tensor([2., 4., 6.])

这个例子中,我们首先创建了一个需要梯度的张量x,然后进行了两次操作得到z。调用backward()之后,我们可以得到z关于x的梯度,并将其打印出来。

2.3.2 优化器的选择和配置

在深度学习训练过程中,选择合适的优化器对于模型的收敛速度和性能至关重要。常见的优化器包括SGD、Adam、Adagrad等。

- # 创建一个优化器实例,这里以SGD为例

- optimizer = torch.optim.SGD(net.parameters(), lr=0.01, momentum=0.9)

- # 在训练循环中使用优化器更新权重

- # ...

- # 预测和计算损失

- # optimizer.zero_grad() # 清除之前的梯度信息

- # loss.backward()

- # optimizer.step() # 更新权重

在上面的代码中,我们创建了一个SGD优化器,并在训练循环中调用其step()方法来更新网络权重。lr(学习率)和momentum(动量)是优化器的重要参数,它们影响着训练过程中的权重更新速率和方向。

通过本章节的介绍,您应已经掌握了PyTorch的初步使用和深度学习的基础理论。接下来的章节将会深入到如何构建ResNet模型以及如何训练和评估它们。随着学习的深入,我们会不断应用这里学习到的知识来构建和优化我们的深度学习模型。

3. ```

第三章:构建ResNet模型

在深入研究了ResNet网络架构和原理之后,我们现在将转向利用PyTorch框架实现这一强大的网络。ResNet模型在解决深度神经网络训练中的退化问题方面取得了巨大成功。本章将详细介绍如何在PyTorch中构建ResNet模型,从基本残差块的设计到整个网络模型的初始化和正则化技术的应用。

3.1 ResNet模型结构细节

3.1.1 基本残差块的设计

残差块是ResNet的基础构件,它们允许输入直接通过短路径传输,以解决梯度消失或爆炸的问题。在PyTorch中,基本残差块通常由两层或三层卷积组成,后接一个跳跃连接,允许输入在卷积层之后直接加到输出上。

- import torch

- import torch.nn as nn

- class BasicBlock(nn.Module):

- expansion = 1

- def __init__(self, in_channels, out_channels, stride=1):

- super(BasicBlock, self).__init__()

- # ... (省略了部分初始化代码)

- self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1, bias=False)

- self.bn1 = nn.BatchNorm2d(out_channels)

- # ... (省略了部分初始化代码)

- self.shortcut = nn.Sequential()