【最优化算法收敛性分析】:掌握3大方法确保算法的稳定性

发布时间: 2025-01-05 18:02:03 阅读量: 30 订阅数: 16

# 摘要

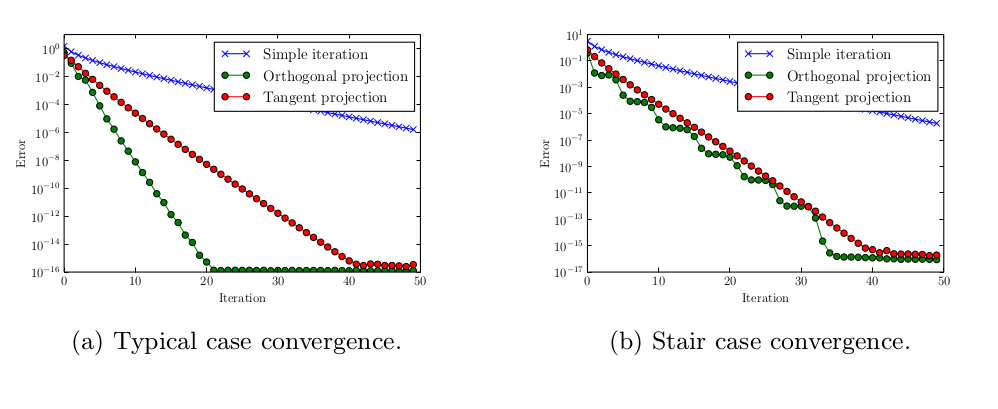

本文深入探讨了最优化算法的基本概念、分类及其收敛性理论,重点分析了迭代算法的收敛速度和稳定性,并提出了保障最优化算法收敛性的多种方法。通过数学基础、收敛性定义与判据的详细讨论,本文为理解算法中的点收敛与一致收敛、线性收敛与超线性收敛等提供了清晰的理论支持。进一步地,通过参数调整、终止条件设定和算法组合与改进的实践,本文展示了如何实现算法的稳定收敛,并通过案例分析验证了算法实现的有效性及其在解决实际问题中的应用前景。本文旨在为最优化算法的研究者和工程师提供一个系统的理论和实践指导。

# 关键字

最优化算法;收敛性理论;迭代法;算法稳定性;参数调整;收敛速度

参考资源链接:[马昌凤《最优化方法》MATLAB课后习题详解与算法应用](https://wenku.csdn.net/doc/2070sjuz0y?spm=1055.2635.3001.10343)

# 1. 最优化算法的基本概念和分类

在开始深入了解最优化算法的世界之前,让我们先定义一下最优化问题及其所使用算法的基本概念。**最优化问题**是指在给定条件的约束下,寻找一组参数的最优解的问题。例如,最小化成本或最大化收益。最优化算法是解决这些问题的数学方法和计算过程,它们在工程设计、数据分析、机器学习等领域都有广泛应用。

最优化算法可以按多种方式分类,但是最基本的分类是根据它们解决问题的性质来分。我们通常将算法分为两类:

- **确定性算法**:这类算法遵循预定义的规则来迭代搜索最优解,例如梯度下降法(Gradient Descent)、牛顿法(Newton's Method)等。

- **随机性算法**:这类算法在搜索最优解的过程中引入随机性,这使得它们在处理大规模或复杂问题时特别有用。随机梯度下降(Stochastic Gradient Descent)和遗传算法(Genetic Algorithms)是这种类型的例子。

在接下来的章节中,我们将深入探讨收敛性理论、迭代算法及其收敛性、以及最优化算法中收敛性保障方法等关键主题。我们将分析这些算法的数学基础,并提供实际案例来说明如何应用这些理论知识。

# 2. 收敛性理论分析

收敛性是优化算法中的核心概念,它决定了算法能否找到问题的最优解,以及找到最优解的效率。在这一章节中,我们将从数学基础入手,深入探讨收敛性的定义、重要性以及判据。

## 2.1 数学基础

### 2.1.1 极限与连续性

在最优化问题中,极限的概念是基础性的数学工具。极限定义了一个函数或数列趋向于某一值的行为。对于一个函数f(x),当x趋近于某个值a时,如果f(x)趋近于L,那么我们可以说f(x)在a处的极限是L,记作lim (x→a) f(x) = L。

连续性是极限的一个直接应用,如果一个函数在某个区间内每一点的极限都等于函数值,那么这个函数在该区间内是连续的。连续性对于保证优化算法的稳定性和准确性至关重要,因为不连续的函数可能会导致算法无法正确收敛到局部或全局最优解。

### 2.1.2 导数和微分

导数衡量的是函数在某一点处的变化率,它描述了函数输出值对输入值变化的敏感程度。如果函数f(x)在点x处可导,那么f(x)在x处的导数记作f'(x)或df/dx。

微分则是导数的一种推广,它可以看作是函数在某一点的局部线性近似。对于函数f(x),在点x处的微分记作dx,那么f(x)在x处的微分形式可以表示为df = f'(x)dx。

导数和微分在优化算法中用来确定搜索方向和步长,是很多迭代算法如梯度下降法和牛顿法的基础。

## 2.2 收敛性定义及其重要性

### 2.2.1 点收敛与一致收敛

点收敛是指数列或函数序列中每一单独元素的极限行为。如果数列{an}中每一个元素都趋近于L,那么我们说这个数列点收敛到L。

一致收敛则描述了一个函数序列中所有函数在定义域内同时趋近于某一极限函数的性质。如果对于任何ε>0,存在N,使得对于所有的n>N和所有的x,有|f_n(x) - f(x)| < ε,那么我们说函数序列{f_n(x)}一致收敛于f(x)。

一致收敛对于保证算法的鲁棒性具有重要意义,它确保了算法在不同初始条件下都能以一致的速度收敛。

### 2.2.2 收敛序列和函数的性质

收敛序列和函数通常具有一些基本性质,例如唯一性、有界性、保号性和极限运算的交换性。这些性质在理论上指导我们如何处理最优化问题,并提供了解决问题的基本工具。

唯一性意味着如果数列收敛,那么它的极限是唯一的。有界性则表明收敛数列是有界的,它有助于我们在算法中设置合理的边界值。保号性说明了正数序列保持正数性质,负数序列保持负数性质,这对于最优化问题的解空间探索至关重要。极限运算的交换性允许我们在求解过程中先进行求导运算再取极限,或者先取极限再求导,这对于算法中的数学推导和证明有着重要的帮助。

## 2.3 收敛性判据

### 2.3.1 充分条件与必要条件

充分条件与必要条件是判断收敛性的逻辑基础。如果条件A是条件B的充分条件,那么A发生时B必然发生;如果条件A是条件B的必要条件,那么B发生时A必然发生。在最优化问题中,这些条件帮助我们判断算法中的某些性质是否能保证收敛性。

例如,在梯度下降法中,学习率的选择对于保证算法的收敛至关重要。一个小的学习率能够保证算法的稳定收敛,但可能需要更多的迭代次数;而一个大的学习率有可能加速算法的收敛,但过大的学习率可能导致算法不收敛。

### 2.3.2 常见的收敛性判据方法

常见的收敛性判据方法包括单调有界判据、柯西判据、函数序列的Dini定理等。单调有界判据指出,如果一个数列单调递增或递减,并且有上界或下界,那么这个数列是收敛的。柯西判据则指出,数列{an}收敛当且仅当对于任意的ε>0,存在N,使得对于所有的m, n>N,有|a_m - a_n| < ε。Dini定理是函数序列收敛性的一个重要判据,它指出如果一个函数序列在闭区间上单调递增(或递减)且收敛于连续函数,则这个序列一致收敛。

这些判据在算法设计和分析中提供了一种理论保障,帮助我们构建稳定且高效的最优化算法。了解和运用这些判据,能够让我们更加科学地预测和改进算法的行为。

在下一章节中,我们将深入探讨迭代算法的收敛性分析,包括迭代算法概述、迭代法的收敛速度和稳定性分析。

# 3. 迭代算法的收敛性分析

## 3.1 迭代算法概述

迭代算法是一种通过重复使用某个公式或过程来逼近问题解的方法。它在工程和科学领域有着广泛的应用,尤其在处理非线性问题和最优化问题时表现突出。

### 3.1.1 迭代算法的原理

迭代算法的基本思想是将复杂的求解过程转化为一个或多个简单的重复计算过程。在每次迭代中,算法使用当前的状态或估计值来生成下一个状态或估计值,以此类推,直到满足停止条件。

例如,考虑求解方程 \( f(x) = 0 \) 的问题。牛顿迭代法的迭代公式为:

```math

x_{n+1} = x_n - \frac{f(x_n)}{f'(x_n)}

```

在这个公式中,\( f'(x) \) 表示 \( f(x) \

0

0