【MATLAB机器人视觉开发】:工具箱与ROS的无缝集成

发布时间: 2024-12-10 02:31:01 阅读量: 18 订阅数: 11

MATLAB机器人工具箱.zip

# 1. MATLAB与机器人视觉基础

## 简介

机器人视觉是当今自动化和机器人技术领域中的一个关键组成部分。它赋予机器人“看到”并理解周围环境的能力,这对于执行复杂任务至关重要。MATLAB作为一种高效的数值计算和可视化工具,在机器人视觉领域中拥有广泛的应用,尤其是在算法开发、仿真和数据处理等方面。

## MATLAB的基本应用

MATLAB为机器人视觉提供了强大的编程环境。它不仅简化了数学计算和数据可视化的过程,而且还集成了多种专门的工具箱,如Image Processing Toolbox和Computer Vision Toolbox,这些工具箱对图像和视频进行处理、分析和理解提供了专门的功能。

## 机器人视觉的构成

机器人视觉系统通常包括图像采集、处理、分析和理解等环节。通过使用MATLAB及其工具箱,可以实现从图像捕获到目标检测、跟踪、场景解释以及三维重建等一系列复杂的视觉任务。下一章节将深入探讨MATLAB在这些任务中的具体应用。

# 2. MATLAB机器人视觉工具箱详解

## 2.1 工具箱中的图像处理功能

### 2.1.1 图像采集与显示

MATLAB的机器人视觉工具箱提供了一系列功能,可以方便地进行图像的采集与显示。这些功能涉及到与相机硬件的接口,如IP相机、USB相机以及其他工业标准相机接口,以及图像处理过程中基本的操作,如读取、显示、保存图像数据等。

```matlab

% 示例:图像的采集与显示

img = imread('sample_image.jpg'); % 读取图像文件

imshow(img); % 显示图像

```

在上述代码中,`imread` 函数用于读取指定路径的图像文件,而 `imshow` 函数则将读取的图像数据在MATLAB的图像窗口中显示出来。这些基础功能是后续图像处理和分析操作的前提条件。

### 2.1.2 图像增强与特征提取

图像增强通常是为了改善图像的视觉效果,提高图像质量以便于后续处理,或者提取特定的图像特征。在MATLAB中,我们可以通过调整对比度、亮度、应用滤波器等多种手段进行图像增强。

```matlab

% 示例:调整图像亮度和对比度

img_enhanced = imadjust(img, stretchlim(img), []);

% 示例:应用高斯滤波去除噪声

img_filtered = imgaussfilt(img, 2);

% 示例:边缘检测

edges = edge(img, 'Canny');

imshow(edges);

```

以上代码中,`imadjust`函数用于调整图像的亮度和对比度。`imgaussfilt`函数通过高斯滤波去除噪声。`edge` 函数则用于检测图像边缘,这里使用的是Canny算法,它是一种广泛使用的边缘检测算法。图像增强和特征提取是机器人视觉中不可或缺的步骤,直接影响到目标检测和识别的准确性。

## 2.2 工具箱中的目标跟踪与分析

### 2.2.1 目标检测方法

目标检测是机器人视觉的一个核心任务,其目的是在图像中找到感兴趣对象的位置。MATLAB提供了许多目标检测算法,包括基于传统图像处理的方法和基于深度学习的方法。

```matlab

% 示例:使用HOG特征进行目标检测

detector = vision.CascadeObjectDetector();

bbox = step(detector, img);

imshow(img);

hold on;

showShape('rectangle', bbox, 'Color', 'red');

```

在这段代码中,使用了级联对象检测器(`vision.CascadeObjectDetector`),它基于Haar特征和级联分类器进行目标检测。检测器在读取的图像 `img` 中识别出目标,并返回边界框 `bbox`。最后,使用 `showShape` 函数将识别出的目标用红色矩形框标出。

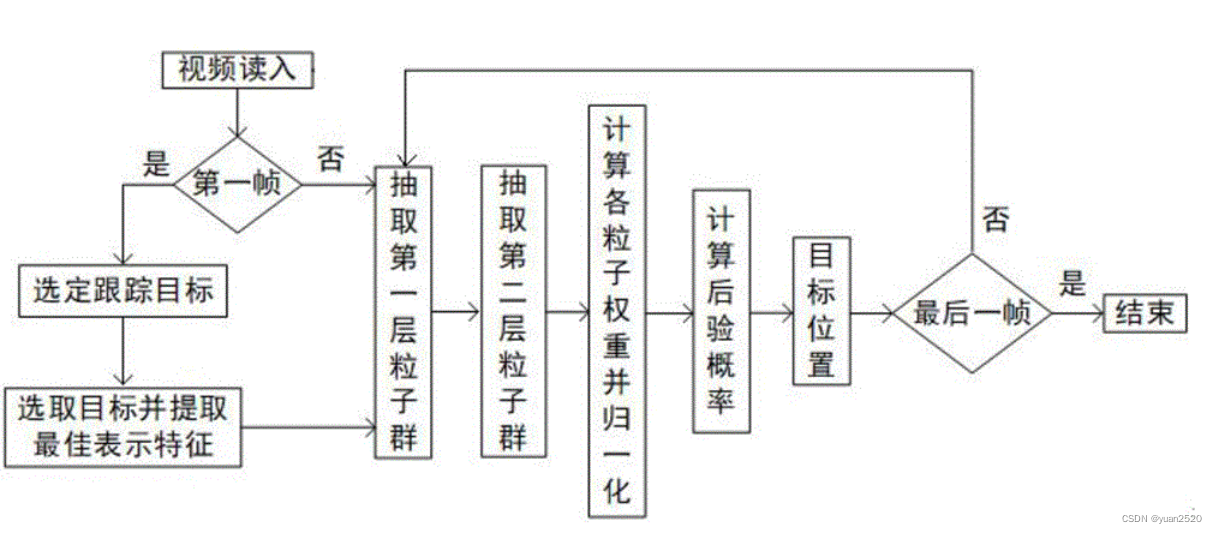

### 2.2.2 跟踪算法与评估

目标跟踪是在连续的帧中追踪一个或多个目标的位置。MATLAB提供多种跟踪算法,从基本的颜色跟踪、模板匹配到更高级的卡尔曼滤波器和深度学习跟踪器。

```matlab

% 示例:使用卡尔曼滤波器进行目标跟踪

tracker = vision.PointTracker();

initialize(tracker, pointLocation, img);

while hasFrame(inputVideo)

frame = readFrame(inputVideo);

[points, isFound] = step(tracker, frame);

if isFound

plot(points, 'ro');

tracker.OutputPoints = points;

end

drawnow;

end

```

在这段代码中,`vision.PointTracker` 用于追踪关键点。首先使用 `initialize` 函数初始化追踪器,设定初始点位置,然后在每帧视频中使用 `step` 函数更新目标位置并绘出。这里的 `plot` 函数用于绘制追踪点的位置。

## 2.3 工具箱的3D视觉与重建

### 2.3.1 立体视觉基础

立体视觉是通过两个或多个视角的图像恢复出场景的三维结构。MATLAB提供了一系列立体视觉工具箱函数来完成这个任务。

```matlab

% 示例:使用立体视觉进行深度图计算

stereoParams = estimateFundamentalMatrix(...); % 估计基础矩阵

[disparity, validity] = disparitySGM(...); % 使用半全局匹配算法计算视差图

depthMap = 1./disparity; % 计算深度图

```

在这段代码中,`estimateFundamentalMatrix` 函数用于估计立体图像对之间的基础矩阵,这是进行立体匹配的关键步骤。`disparitySGM` 函数则采用半全局匹配算法(SGM)计算视差图,即同一场景点在两个视角中的水平偏移量。最后,通过视差图计算出深度图。

### 2.3.2 点云处理与三维模型构建

点云是从现实世界场景中获取的大量点的集合,这些点位于三维空间中,用x、y、z坐标表示。处理这些点云数据,可以构建场景或物体的三维模型。

```matlab

% 示例:从深度图创建点云

ptCloud = pointCloud(depthMap);

pcd = pointCloud2(pCloud, 'Color', rgb2xyz(img));

```

在这段代码中,首先将深度图 `depthMap` 转换为点云 `ptCloud`。然后,`pointCloud2` 函数可以将图像的RGB数据转换为点云的颜色属性,这样就能够获得具有色彩信息的三维点云数据。

使用这些功能,可以完成从立体图像对中提取深度信息并重建三维场景的整个流程。这对于机器人导航、场景理解以及三维空间中的目标识别和抓取等应用至关重要。

# 3. ROS基础与MATLAB集成方法

## 3.1 ROS架构与理念

### 3.1.1 ROS核心组件

机器人操作系统(ROS)是一个用于机器人软件开发的灵活框架,它

0

0