Python日志分析与监控大揭秘:集成ELK与优化性能的绝招

发布时间: 2024-10-17 10:31:38 阅读量: 46 订阅数: 17

# 1. Python日志分析与监控概述

## 1.1 日志分析的重要性

在当今的IT行业中,日志数据被视为系统的“生命线”。它们记录了软件运行的每一个细节,从应用程序的正常操作到系统故障的异常情况。Python作为一种流行的编程语言,其日志分析和监控对于确保应用性能、排错和安全至关重要。日志不仅可以帮助我们了解应用程序的行为模式,还可以用于业务智能分析、合规性审计以及用户体验优化。

## 1.2 日志监控的作用

日志监控是实时跟踪和分析日志数据的过程,它可以帮助我们及时发现系统问题并快速响应。例如,通过对服务器的访问日志进行监控,我们可以及时发现潜在的安全威胁,如未经授权的登录尝试。通过应用日志监控,我们可以跟踪软件的性能问题,如缓慢的响应时间和高错误率,从而在问题扩散之前进行干预。

## 1.3 日志分析与监控的挑战

尽管日志分析和监控具有极高的价值,但它们也带来了一系列的挑战。首先,日志数据量巨大,增长速度快,传统的日志分析方法可能无法高效处理。其次,日志格式不统一,不同来源和类型的日志需要不同的处理方式。此外,日志数据的隐私和安全也是不可忽视的问题,如何在分析的同时保护敏感信息是一大挑战。在接下来的章节中,我们将探讨如何使用Python和ELK栈来应对这些挑战。

# 2. ELK栈基础与集成

在本章节中,我们将深入探讨ELK栈的基础知识、集成实践以及性能调优。ELK栈是由Elasticsearch、Logstash和Kibana三个组件组成的日志分析解决方案,它能够实现大规模日志的存储、搜索、分析和可视化。我们将从每个组件的原理和应用开始,逐步深入到集成实践和性能优化的策略。

### 2.1 ELK栈组件介绍

#### 2.1.1 Elasticsearch的原理与应用

Elasticsearch是一个基于Lucene构建的分布式、RESTful搜索引擎。它能够快速、可靠地存储、搜索和分析大量的日志数据。Elasticsearch的核心是倒排索引,这种数据结构可以实现快速的全文搜索。它还提供了强大的聚合功能,可以对日志数据进行多维度的统计和分析。

在本章节介绍中,我们将通过一个简单的例子来展示Elasticsearch的基本操作和应用。例如,我们可以使用Elasticsearch来存储和查询应用日志,从而快速定位和分析系统故障。

```json

// Elasticsearch索引创建示例

PUT /my_index

{

"mappings": {

"properties": {

"timestamp": { "type": "date" },

"message": { "type": "text" },

"level": { "type": "keyword" }

}

}

}

```

#### 2.1.2 Logstash的数据处理流程

Logstash是一个数据收集引擎,它从多个来源接收数据,对其进行处理,并将其发送到Elasticsearch或其他存储系统。Logstash的处理流程可以分为三个主要阶段:输入(input)、过滤(filter)和输出(output)。

下面是一个Logstash的配置示例,它展示了如何从一个文件中读取日志数据,进行过滤,并最终将处理后的数据发送到Elasticsearch。

```conf

# Logstash配置文件示例

input {

file {

path => "/path/to/your/logs/*.log"

}

}

filter {

grok {

match => { "message" => "%{TIMESTAMP_ISO8601:timestamp} %{WORD:level}: %{GREEDYDATA:message}" }

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "my_index"

}

}

```

#### 2.1.3 Kibana的可视化功能

Kibana是ELK栈的可视化组件,它提供了强大的仪表板和图表功能,使得日志数据的分析和展示变得直观和容易理解。Kibana可以与Elasticsearch紧密集成,利用其聚合和搜索功能来创建复杂的可视化图表。

在本章节中,我们将介绍如何使用Kibana创建一个简单的仪表板,通过图表和地图来展示日志数据的趋势和分布。

### 2.2 ELK集成实践

#### 2.2.1 Python与Logstash的连接方式

Python可以通过多种方式与Logstash集成,最常见的方法是使用Logstash的TCP输入插件。Python程序可以直接发送日志数据到Logstash的TCP端口。这种方式简单且易于实现,适合于快速集成和开发。

下面是一个Python脚本的示例,它使用socket库将日志数据发送到Logstash。

```python

# Python脚本示例:发送日志到Logstash

import socket

host = 'localhost'

port = 5000

msg = '2023-04-01 12:34:56 INFO Some log message'

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

sock.connect((host, port))

sock.send(msg.encode())

sock.close()

```

#### 2.2.2 日志格式标准化

日志格式标准化是集成ELK栈的重要步骤。统一的日志格式可以简化日志的解析和分析过程。常用的日志格式包括JSON格式,因为它易于解析且易于扩展。

下面是一个Python日志记录器的配置示例,它将日志输出为JSON格式。

```python

# Python日志记录器配置示例:输出JSON格式日志

import logging

import json

logger = logging.getLogger('my_logger')

logger.setLevel(***)

formatter = logging.Formatter(json.dumps({

"timestamp": "%(asctime)s",

"level": "%(levelname)s",

"message": "%(message)s"

}))

file_handler = logging.FileHandler('my_logs.log')

file_handler.setFormatter(formatter)

logger.addHandler(file_handler)

***('Example log entry')

```

#### 2.2.3 高级集成策略与案例分析

在本章节介绍中,我们将探讨一些高级的ELK集成策略,并通过案例分析来展示它们的应用。例如,我们可以使用Logstash的自定义过滤插件来处理特定的日志格式,或者使用Elasticsearch的机器学习功能来预测系统故障。

下面是一个Logstash自定义过滤插件的示例,它实现了对日志数据的自定义解析和处理。

```ruby

# Logstash自定义过滤插件示例

# 插件名为 my_filter.rb

require 'logstash/filters/base'

require 'logstash/namespace'

class LogStash::Filters::MyFilter < LogStash::Filters::Base

config_name "my_filter"

# 插件初始化代码

def register

# 你的代码

end

# 过滤方法

public

def filter(event)

# 你的代码

return unless event

# 对事件进行处理

# ...

# 返回处理后的事件

return event

end

end

```

### 2.3 ELK性能调优

#### 2.3.1 Elasticsearch性能优化

Elasticsearch的性能优化可以从多个方面进行,包括索引优化、查询优化和硬件优化。通过合理配置索引的分片和副本数,使用高效的查询语句,以及选择合适的硬件配置,可以显著提高Elasticsearch的性能。

下面是一个Elasticsearch索引优化的配置示例。

```json

// Elasticsearch索引优化配置示例

PUT /my_index

{

"settings": {

"number_of_shards": 5,

"number_of_replicas": 1,

"refresh_interval": "30s",

"index.translog.durability": "request",

"index.translog.sync_interval": "5s"

}

}

```

#### 2.3.2 Logstash性能瓶颈分析

Logstash的性能瓶颈通常出现在数据处理阶段。为了避免性能问题,我们需要合理配置Logstash的过滤器,并确保其线程池的配置得当。此外,我们还需要监控Logstash的性能指标,以便及时发现并解决性能瓶颈。

下面是一个Logstash性能监控的配置示例。

```conf

# Logstash性能监控配置示例

input {

file {

path => "/path/to/logstash/perf.log"

start_position => "beginning"

}

}

filter {

kv {

value_key => "message"

}

}

output {

graphite {

host => "***"

port => 2003

metric => "logstash.perf.%{key}"

}

}

```

#### 2.3.3 Kibana性能提升技巧

Kibana的性能提升可以从多个方面进行,包括仪表板设计优化、索引优化和前端性能优化。通过简化仪表板的设计,优化Elasticsearch的索引结构,以及使用CDN和缓存技术,可以有效提高Kibana的性能。

下面是一个Kibana仪表板优化的示例。

```yaml

# Kibana仪表板优化配置示例

# kibana.yml

server.maxPayloadBytes: *** # 增大请求体大小限制

server.preload: ["dashboard", "visualize", "timelion"]

```

在本章节的介绍中,我们已经详细探讨了ELK栈的基础知识、集成实践和性能调优。通过上述内容的学习,读者应该能够理解ELK栈的工作原理,并掌握其基本的集成和优化方法。接下来,我们将进入第三章,深入探讨Python日志管理与分析实践。

# 3. Python日志管理与分析实践

在本章节中,我们将深入探讨Python日志管理与分析实践的相关知识,包括日志管理策略、日志分析工具与技术以及日志的可视化与监控。这一章节旨在为Python开发者和系统管理员提供一套完整的日志处理解决方案,帮助他们更好地管理和分析日志数据,从而优化系统性能、提升系统稳定性,并及时响应系统中的异常情况。

## 3.1 日志管理策略

### 3.1.1 日志的重要性与管理原则

日志是系统运行的“历史记录”,它记录了系统的运行状态、用户行为、系统错误等关键信息。良好的日志管理策略对于系统的监控、故障排查、性能优化、安全审计等方面至关重要。

在进行日志管理时,我们应当遵循以下原则:

- **完整性**:确保所有重要的系统活动都被记录下来。

- **安全性**:保护日志数据不被未授权访问或篡改。

- **及时性**:日志数据应该及时收集和分析,以便快速响应事件。

- **可维护性**:日志系统应该易于维护和升级。

### 3.1.2 日志级别的选择与应用

Python的`logging`模块提供了多级日志记录机制,包括`DEBUG`、`INFO`、`WARNING`、`ERROR`和`CRITICAL`五个级别。正确选择日志级别对于日志管理和分析至关重要。

- **DEBUG**:最低级别,用于问题诊断时的详细信息输出。

- **INFO**:常规运行情况的信息记录。

- **WARNING**:潜在问题的警告信息。

- **ERROR**:发生错误时的记录,但不影响系统继续运行。

- **CRITICAL**:最严重的错误,表明系统可能无法继续运行。

在实际应用中,我们应当根据日志的用途来选择合适的级别。例如,对于开发调试阶段,我们可能会将日志级别设置为`DEBUG`;而在生产环境中,我们可能会设置为`WARNING`或`ERROR`,以避免日志文件过大。

### 3.1.3 日志的存储与归档

日志数据的存储和归档是日志管理的重要组成部分。我们通常会将日志存储在本地磁盘或远程服务器上,并定期进行归档处理。

- **本地存储**:适用于小型系统,简单易行,但可能存在磁盘空间限制。

- **远程存储**:适用于大型分布式系统,可以实现集中管理,但需要考虑网络传输和存储成本。

日志归档的策略包括:

- **定期归档**:按时间周期(如每日、每周)将旧日志归档。

- **压缩存储**:对归档的日志进行压缩,节省存储空间。

- **备份策略**:对重要日志数据进行备份,以防丢失。

## 3.2 日志分析工具与技术

### 3.2.1 Python内置的日志分析库

Python内置了`logging`模块,提供了基本的日志记录功能。但是,对于更复杂的日志分析任务,我们可能需要使用第三方库,如`logutils`、`logbook`等。

例如,使用`logutils`库进行日志分析的基本步骤如下:

```python

import logging

from logutils import LoggingBuffer

# 配置日志记录器

logger = logging.getLogger('MyLogger')

logger.setLevel(logging.DEBUG)

# 创建日志处理器

stream_handler = logging.StreamHandler()

file_handler = logging.FileHandler('myapp.log')

# 创建日志格式器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

# 绑定格式器到处理器

stream_handler.setFormatter(formatter)

file_handler.setFormatter(formatter)

# 添加处理器到记录器

logger.addHandler(stream_handler)

logger.addHandler(file_handler)

# 记录日志

logger.debug('This is a debug message')

***('This is an info message')

logger.warning('This is a warning message')

logger.error('This is an error message')

logger.critical('This is a critical message')

```

### 3.2.2 日志分析的正则表达式应用

正则表达式是一种强大的文本匹配工具,它可以用于从日志文件中提取特定的信息。例如,我们可以使用正则表达式来匹配所有包含错误信息的日志行:

```python

import re

# 假设日志文件内容存储在log_contents变量中

log_contents = """

2023-01-01 12:00:00 DEBUG This is a debug message

2023-01-01 12:01:00 WARNING This is a warning message

2023-01-01 12:02:00 ERROR This is an error message

# 正则表达式匹配所有包含ERROR的日志行

error_pattern = ***pile(r'ERROR .*')

# 查找匹配的日志行

error_log_lines = error_pattern.findall(log_contents)

# 输出匹配的日志行

for line in error_log_lines:

print(line)

```

### 3.2.3 日志分析案例与实践

为了更深入地理解日志分析的过程,我们来看一个具体的案例。假设我们需要分析一个Web应用的日志文件,以便找出访问量最高的页面。

首先,我们需要读取日志文件,并使用正则表达式提取每个请求的页面路径。然后,我们可以使用Python的`collections.Counter`类来计算每个页面的访问次数。

```python

from collections import Counter

import re

# 假设日志文件内容存储在log_contents变量中

log_contents = """

2023-01-01 12:00:00 INFO Page visit: /home

2023-01-01 12:00:01 INFO Page visit: /about

2023-01-01 12:00:02 INFO Page visit: /contact

2023-01-01 12:00:03 INFO Page visit: /home

# 正则表达式匹配所有页面访问的日志行

page_visit_pattern = ***pile(r'Page visit: (\/\S+)')

# 提取页面路径

page_paths = page_visit_pattern.findall(log_contents)

# 计算每个页面的访问次数

page_visits = Counter(page_paths)

# 输出每个页面的访问次数

for page, count in page_visits.items():

print(f'Page: {page}, Visits: {count}')

```

## 3.3 日志的可视化与监控

### 3.3.1 日志数据的可视化方法

日志数据的可视化可以帮助我们更直观地理解系统的运行状况。常用的日志可视化工具包括Grafana、ELK Stack等。

- **Grafana**:一个开源的数据可视化平台,可以与多种数据源集成,包括Elasticsearch。

- **ELK Stack**:由Elasticsearch、Logstash和Kibana组成的日志分析平台,可以提供强大的日志可视化功能。

### 3.3.2 日志监控系统的构建

构建一个日志监控系统可以帮助我们实时监控系统状态,并在出现问题时及时发出告警。一个基本的日志监控系统通常包括以下组件:

- **日志收集器**:如Fluentd、Logstash等,用于收集和传输日志数据。

- **日志存储**:如Elasticsearch、Apache Solr等,用于存储和索引日志数据。

- **日志分析引擎**:如Kibana、Grafana等,用于分析和可视化日志数据。

- **告警系统**:如Prometheus、Nagios等,用于在检测到异常时发出告警。

### 3.3.3 实时日志监控与告警设置

实时日志监控和告警设置是确保系统稳定运行的关键。我们可以通过配置告警规则来监控特定的日志事件或指标。

例如,如果我们希望在访问量超过一定阈值时收到告警,我们可以在ELK Stack中设置一个告警规则:

```yaml

# 假设使用Elasticsearch作为日志存储和分析引擎

# 在Kibana的Monitoring中创建一个告警规则

# 告警规则配置

alert:

name: High Page Visits Alert

schedule:

interval: 5m

conditions:

- metric: 'page_visits_total'

threshold:

value: 1000

actions:

- email:

to: '***'

```

在这个例子中,我们设置了一个告警规则,当页面访问总量超过1000次时,系统会通过电子邮件发送告警通知。

通过本章节的介绍,我们详细探讨了Python日志管理与分析实践的相关策略和技术。下一章节我们将进一步讨论性能优化与故障排查的相关知识。

# 4. 性能优化与故障排查

## 4.1 Python性能优化

### 4.1.1 Python代码级别的性能优化

在Python中进行性能优化通常首先关注代码级别的优化,因为即使是最优秀的算法,如果代码实现效率低下,也会导致性能瓶颈。本节将介绍一些常见的代码优化技巧。

**代码示例1:避免使用全局变量**

全局变量的读取速度要慢于局部变量,因为全局变量在使用前需要查询全局命名空间。

```python

# 不推荐的做法

global_var = "全局变量"

def func():

print(global_var)

func()

```

```python

# 推荐的做法

def func(local_var):

print(local_var)

func("局部变量")

```

**代码示例2:使用局部变量**

函数内部的局部变量访问速度要快于外部的全局变量。

```python

def func():

a = 100

b = 200

c = a + b # 局部变量的加法运算

return c

print(func())

```

### 4.1.2 Python应用服务器性能调优

Python应用服务器如Flask和Django,可以通过一些配置来提高性能。例如,Gunicorn和uWSGI是常用的WSGI服务器,它们可以通过多进程或多线程的方式来提高并发处理能力。

**代码示例2:Gunicorn配置**

```python

# gunicorn配置示例

gunicorn --bind *.*.*.*:8000 --workers 4 --threads 2 myapp:app

```

**表格1:Gunicorn工作模式对比**

| 工作模式 | 描述 | 适用场景 |

| --- | --- | --- |

| Eventlet | 异步工作模式 | 高并发、长连接 |

| Gevent | 异步工作模式 | 高并发、长连接 |

| sync | 同步工作模式 | 请求响应时间短、CPU密集型 |

### 4.1.3 性能优化案例分析

**案例分析:**

假设我们有一个使用Flask框架的Web应用,该应用需要处理大量的请求,但响应时间较长。通过分析我们可以发现,主要的性能瓶颈在数据库查询和数据处理上。

**优化措施:**

1. **数据库查询优化**:使用更高效的查询语句,减少不必要的数据加载,使用索引来加速查询。

2. **缓存机制**:对频繁访问且不变的数据使用内存缓存,如使用Redis或Memcached。

3. **异步处理**:对于耗时的IO操作,如文件写入和外部API调用,使用异步编程模型来提高并发处理能力。

4. **代码重构**:对耗时的函数进行性能分析,优化算法和逻辑,减少不必要的计算。

通过上述措施,可以显著提高应用的处理能力和响应速度。

## 4.2 日志分析性能优化

### 4.2.1 日志文件的压缩与分片

随着日志量的增加,日志文件会变得非常庞大,这不仅会影响查询效率,还会增加存储成本。因此,对日志文件进行压缩和分片是提高性能的重要手段。

**代码示例3:日志文件压缩**

```shell

gzip access.log

```

**mermaid流程图1:日志分片处理流程**

```mermaid

graph LR

A[生成日志] --> B[日志分片]

B --> C[日志压缩]

C --> D[存储日志分片]

```

### 4.2.2 日志查询优化技巧

日志查询是性能优化的重点,可以通过建立索引、使用查询缓存、优化查询语句等方式来提高查询效率。

**代码示例4:建立Elasticsearch索引**

```json

PUT /my_index

{

"mappings": {

"properties": {

"@timestamp": {"type": "date"},

"message": {"type": "text"},

"log_level": {"type": "keyword"}

}

}

}

```

### 4.2.3 日志分析性能监控与评估

为了确保日志分析系统的性能,需要对系统进行持续的监控和评估。可以使用专门的日志分析工具来监控查询性能、索引效率等指标。

**代码示例5:使用Elasticsearch API监控索引状态**

```shell

curl -XGET 'localhost:9200/_cat/indices?v'

```

**表格2:日志分析性能指标**

| 指标 | 描述 | 优化建议 |

| --- | --- | --- |

| 查询响应时间 | 日志查询返回结果的时间 | 优化查询语句,增加索引 |

| 索引吞吐量 | 索引处理日志的速度 | 增加索引节点,优化日志分片策略 |

| 索引增长率 | 新增日志文件的大小 | 优化日志保留策略 |

## 4.3 故障排查与应急响应

### 4.3.1 日志分析中的常见故障模式

在日志分析系统中,常见的故障模式包括:索引错误、查询失败、日志丢失等。

**代码示例6:日志索引错误处理**

```json

PUT /_cluster/health

{

"index": "my_index",

"level": "indices"

}

```

### 4.3.2 日志驱动的故障排查方法

为了快速定位和解决问题,需要有一套系统的故障排查方法。这通常包括查看系统日志、监控日志分析系统的性能指标、使用调试工具等。

**mermaid流程图2:故障排查流程**

```mermaid

graph LR

A[发现问题] --> B[查看系统日志]

B --> C[监控性能指标]

C --> D[使用调试工具]

D --> E[定位问题]

E --> F[解决问题]

```

### 4.3.3 应急响应策略与最佳实践

在出现故障时,需要有一套完善的应急响应策略。这通常包括故障报警、故障预案、数据备份和恢复机制等。

**代码示例7:故障报警示例**

```python

import smtplib

def send_alert(email, subject, message):

sender = '***'

receivers = email.split(',')

smtp_server = smtplib.SMTP('***')

smtp_server.sendmail(sender, receivers, message)

smtp_server.quit()

email = "***"

subject = "日志分析系统故障"

message = "日志分析系统出现故障,请及时处理!"

send_alert(email, subject, message)

```

通过本章节的介绍,我们可以了解到Python日志分析中性能优化和故障排查的重要性及实施策略。在实际工作中,我们需要结合具体的业务场景和系统环境,灵活运用这些方法和工具,以确保日志分析系统的稳定性和效率。

# 5. Python日志分析的进阶应用

在本章节中,我们将深入探讨Python日志分析的进阶应用,包括自动化与智能化的日志分析流程、大规模分布式日志处理以及日志安全与合规性的重要性。随着技术的发展,日志分析不再局限于简单的数据收集和查询,而是向着更加智能化、自动化的方向发展,同时也面临着安全和合规性的挑战。

## 5.1 日志分析的自动化与智能化

### 5.1.1 自动化日志收集与分析流程

在现代IT环境中,日志数据量庞大且增长迅速,手动收集和分析这些数据已经变得不可行。自动化日志收集与分析流程成为了解决这一问题的关键。自动化流程包括日志数据的自动采集、传输、存储、分析和可视化等环节。

**案例:** 使用Python的`requests`库自动收集Web服务器的日志数据。

```python

import requests

import json

# 日志服务器的API地址

LOG_SERVER_URL = '***'

# 获取Web服务器日志的函数

def fetch_web_logs():

# 发送HTTP请求到日志服务器

response = requests.get(LOG_SERVER_URL)

# 解析响应数据

logs = json.loads(response.text)

return logs

# 主函数,运行日志收集

def main():

logs = fetch_web_logs()

# 这里可以进一步分析或存储日志数据

print(logs)

if __name__ == '__main__':

main()

```

**参数说明:**

- `LOG_SERVER_URL`: 日志服务器的API地址。

- `requests.get()`: 发送GET请求到日志服务器。

- `json.loads()`: 解析JSON格式的响应数据。

**逻辑分析:**

1. 定义日志服务器的API地址。

2. 定义函数`fetch_web_logs()`,使用`requests.get()`发送请求。

3. 从响应中获取JSON数据,并解析成Python对象。

4. 在`main()`函数中调用`fetch_web_logs()`,可以进一步处理或存储日志数据。

### 5.1.2 智能化日志分析技术介绍

智能化日志分析技术通常涉及到机器学习、人工智能等领域的应用,这些技术可以帮助我们从大量日志中识别模式、预测问题并提供决策支持。

**案例:** 使用Python的`scikit-learn`库进行简单的日志分析。

```python

from sklearn.cluster import KMeans

import numpy as np

# 示例日志数据

logs = np.array([

[5.1, 3.5, 1.4, 0.2],

[4.9, 3.0, 1.4, 0.2],

# ... 其他日志数据

])

# KMeans聚类分析

kmeans = KMeans(n_clusters=3)

kmeans.fit(logs)

# 输出聚类结果

print(kmeans.labels_)

```

**参数说明:**

- `KMeans`: KMeans聚类算法。

- `n_clusters`: 聚类的数量。

**逻辑分析:**

1. 导入`KMeans`和`numpy`库。

2. 定义示例日志数据。

3. 使用`KMeans`进行聚类分析。

4. 输出聚类结果,用于进一步的分析或决策。

### 5.1.3 实现智能化日志分析的案例

在实际应用中,智能化日志分析可以帮助我们识别异常行为、预测系统故障等。例如,通过分析Web服务器的日志,我们可以识别出访问模式的异常变化,这可能预示着即将发生的DDoS攻击。

**案例:** 使用日志分析识别DDoS攻击的前兆。

```python

from sklearn.svm import OneClassSVM

import pandas as pd

# 加载日志数据

logs_df = pd.read_csv('web_logs.csv')

# 特征提取,例如:请求频率、IP地址等

features = logs_df[['request_count', 'ip_address']]

# 训练模型

model = OneClassSVM()

model.fit(features)

# 预测新的日志数据

new_logs_df = pd.read_csv('new_web_logs.csv')

new_features = new_logs_df[['request_count', 'ip_address']]

predictions = model.predict(new_features)

# 输出预测结果

print(predictions)

```

**参数说明:**

- `OneClassSVM`: 用于异常检测的支持向量机。

- `request_count`: 请求频率。

- `ip_address`: IP地址。

**逻辑分析:**

1. 导入`OneClassSVM`和`pandas`库。

2. 加载日志数据,并提取特征。

3. 训练一个异常检测模型。

4. 使用模型预测新的日志数据。

5. 输出预测结果,用于识别异常行为。

## 5.2 大规模分布式日志处理

### 5.2.1 分布式日志系统的架构设计

随着分布式系统的普及,日志数据的规模和复杂性也在不断增加。分布式日志系统需要能够处理大规模的日志数据,并提供高性能的查询和分析能力。

**架构设计:**

```mermaid

graph LR

A[日志源] -->|日志数据| B(消息队列)

B --> C[日志收集器]

C -->|日志数据| D[日志存储]

D -->|日志数据| E[日志分析引擎]

E -->|分析结果| F[日志可视化和监控]

```

**说明:**

- **日志源:** 应用程序、服务器等产生日志的地方。

- **消息队列:** 用于缓冲和传输日志数据,如Kafka、RabbitMQ。

- **日志收集器:** 负责从消息队列中获取日志数据,并将其发送到日志存储,如Fluentd、Logstash。

- **日志存储:** 存储日志数据,如Elasticsearch。

- **日志分析引擎:** 对日志数据进行查询和分析,如Elasticsearch的聚合功能。

- **日志可视化和监控:** 将分析结果展示给用户,如Kibana。

### 5.2.2 大数据技术在日志处理中的应用

大数据技术,如Hadoop、Spark等,为日志处理提供了强大的数据处理能力和可扩展性。

**案例:** 使用Spark进行日志分析。

```python

from pyspark import SparkContext

# 初始化SparkContext

sc = SparkContext()

# 加载日志数据

logs_rdd = sc.textFile('hdfs:///logs/')

# 日志解析

parsed_logs_rdd = logs_rdd.map(lambda line: parse_log(line))

# 日志聚合统计

aggregated_logs_rdd = parsed_logs_rdd.map(lambda log: (log['status_code'], 1)) \

.reduceByKey(lambda a, b: a + b)

# 存储结果

aggregated_logs_rdd.saveAsTextFile('hdfs:///logs/output/')

# 关闭SparkContext

sc.stop()

```

**参数说明:**

- `SparkContext`: Spark的主要入口点。

- `textFile()`: 读取HDFS上的日志文件。

- `map()`: 对日志数据进行转换。

- `reduceByKey()`: 对键值对进行聚合。

**逻辑分析:**

1. 初始化SparkContext。

2. 加载HDFS上的日志数据。

3. 使用`map()`解析日志数据。

4. 使用`reduceByKey()`进行聚合统计。

5. 将结果保存到HDFS。

6. 关闭SparkContext。

### 5.2.3 分布式日志分析的挑战与解决方案

分布式日志分析面临着数据一致性、系统复杂性、高可用性等挑战。

**挑战与解决方案:**

| 挑战 | 解决方案 |

| --- | --- |

| 数据一致性 | 分布式事务、最终一致性模型 |

| 系统复杂性 | 容器化、微服务架构 |

| 高可用性 | 多节点部署、故障转移机制 |

## 5.3 日志安全与合规性

### 5.3.1 日志安全的重要性与策略

日志数据包含了大量的敏感信息,如用户行为、系统状态等。保障日志数据的安全性至关重要。

**策略:**

1. **加密存储:** 对存储的日志数据进行加密。

2. **访问控制:** 限制对日志数据的访问权限。

3. **日志审计:** 定期审计日志数据的访问和修改记录。

### 5.3.2 日志合规性标准与实践

合规性标准如GDPR、HIPAA等对日志数据的处理提出了严格的要求。

**实践:**

1. **数据分类:** 对日志数据进行分类,明确哪些是敏感数据。

2. **数据保留:** 遵循法规要求,对日志数据进行合理保留。

3. **数据删除:** 对不再需要的日志数据进行安全删除。

### 5.3.3 日志安全事件的应对策略

在发生日志安全事件时,需要有一套完善的应对策略。

**策略:**

1. **实时监控:** 实时监控日志数据,及时发现异常行为。

2. **事件响应计划:** 制定并实施事件响应计划。

3. **事后分析:** 对安全事件进行详细的分析和总结。

在本章节中,我们介绍了Python日志分析的进阶应用,包括自动化与智能化的日志分析流程、大规模分布式日志处理以及日志安全与合规性的重要性。通过这些高级应用,我们可以更好地利用日志数据,为业务决策提供支持,同时确保数据的安全性和合规性。

# 6. Python日志分析的未来趋势

随着技术的不断进步,Python日志分析领域也在不断发展。在这一章节中,我们将探讨未来趋势,包括云原生技术、日志分析的新技术趋势以及综合案例研究,以帮助读者了解如何利用Python进行高效、先进的日志分析。

## 6.1 云原生日志分析

云原生技术正在改变软件开发和部署的方式,日志分析也不例外。云服务为日志分析带来了新的特点和挑战。

### 6.1.1 云服务中的日志分析特点

云服务中的日志分析与传统环境相比,具有以下特点:

- **高可扩展性**:云环境可以根据需求动态扩展资源,这对于处理大规模日志数据非常有用。

- **按需付费**:云服务通常采用按需付费模式,无需为未使用的资源支付费用。

- **多租户环境**:云服务提供商通常将资源分割给多个用户,这要求日志分析工具能够处理多租户数据。

- **数据安全与合规性**:在云环境中,数据安全和合规性是关键考虑因素。

### 6.1.2 云原生日志解决方案

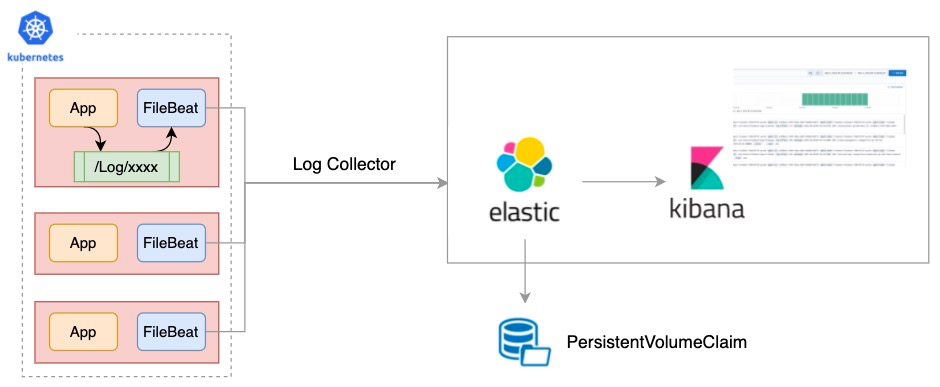

云原生日志分析解决方案通常包括以下组件:

- **集中式日志管理服务**:例如Amazon CloudWatch Logs、Azure Monitor和Google Stackdriver。

- **容器化工具**:如Elasticsearch、Fluentd和Kibana(EFK)可以在Kubernetes环境中运行。

- **无服务器架构**:例如AWS Lambda和Azure Functions,用于处理日志事件。

### 6.1.3 云原生环境下的性能优化

云原生环境下的性能优化关键在于:

- **资源优化**:合理分配和优化资源使用,例如使用Auto Scaling自动调整资源。

- **网络优化**:配置合理的网络策略,以提高数据传输效率。

- **缓存机制**:使用缓存来减少数据访问延迟。

### 6.1.4 云原生日志分析案例

```python

import boto3

# 创建CloudWatch Logs客户端

logs = boto3.client('logs')

# 获取日志组信息

response = logs.describe_log_groups()

# 输出日志组名称

for group in response['logGroups']:

print(group['logGroupName'])

```

以上代码示例展示了如何使用Python和Boto3库来描述AWS CloudWatch Logs中的日志组。

## 6.2 日志分析的新技术趋势

随着新技术的不断涌现,日志分析也呈现出新的趋势。

### 6.2.1 机器学习在日志分析中的应用

机器学习可以用来增强日志分析,例如:

- **异常检测**:使用机器学习模型识别日志中的异常行为。

- **日志聚类**:通过聚类算法对日志进行分组,以便于分析。

### 6.2.2 日志分析的边缘计算

边缘计算将数据处理推向网络边缘,减少延迟并提高效率。

### 6.2.3 日志分析的区块链技术

区块链可以用于日志数据的完整性验证和共享。

## 6.3 综合案例研究

### 6.3.1 日志分析的跨行业案例分析

跨行业案例分析可以揭示日志分析在不同领域的应用情况。

### 6.3.2 日志分析的最佳实践分享

分享最佳实践可以帮助读者避免常见的陷阱并提高分析效率。

### 6.3.3 未来日志分析的展望与挑战

未来日志分析将面临的数据量、安全性和合规性方面的挑战,以及如何利用新技术来应对这些挑战。

0

0