C++多线程编程:同步机制与并发控制的6种核心策略

发布时间: 2024-12-10 01:19:12 阅读量: 29 订阅数: 22

构建高性能C++应用:并发编程与多线程处理-.md

# 1. C++多线程编程简介

随着计算机处理器的核心数量的增加,多线程编程已成为提高软件性能的关键技术。C++作为广泛应用于高性能计算的语言,提供了强大的多线程编程能力。本章将介绍C++多线程编程的基本概念,为后面章节中对线程同步机制、并发控制策略以及C++标准库中并发组件的深入学习打下基础。

在开始之前,我们首先需要了解C++11标准之前,多线程编程主要依赖于操作系统API,如POSIX线程库(pthread),或者平台特定的扩展,如Windows的Win32 API。随着C++11的推出,C++标准库引入了 `<thread>`, `<mutex>`, `<condition_variable>` 等头文件,为多线程编程提供了标准的接口,极大地简化了多线程应用程序的开发。

例如,创建一个简单的线程的代码如下:

```cpp

#include <iostream>

#include <thread>

void thread_function() {

// 执行一些任务

std::cout << "Hello, this is a thread!" << std::endl;

}

int main() {

std::thread my_thread(thread_function);

my_thread.join();

return 0;

}

```

这里,我们创建了一个新的线程执行 `thread_function` 函数,然后在主线程中等待它完成。这只是多线程编程的冰山一角,通过后续的章节我们将探索更多的高级特性,理解如何在实际开发中更高效地使用线程来构建复杂的应用程序。

# 2. 线程同步机制

线程同步机制是多线程编程的核心组成部分,它确保多个线程在访问共享资源时能够有序地进行,防止数据竞争和条件竞争等问题。在本章中,我们将深入探讨互斥锁(Mutex)、读写锁(RWLock)和条件变量(Condition Variables)等同步机制的原理和应用。

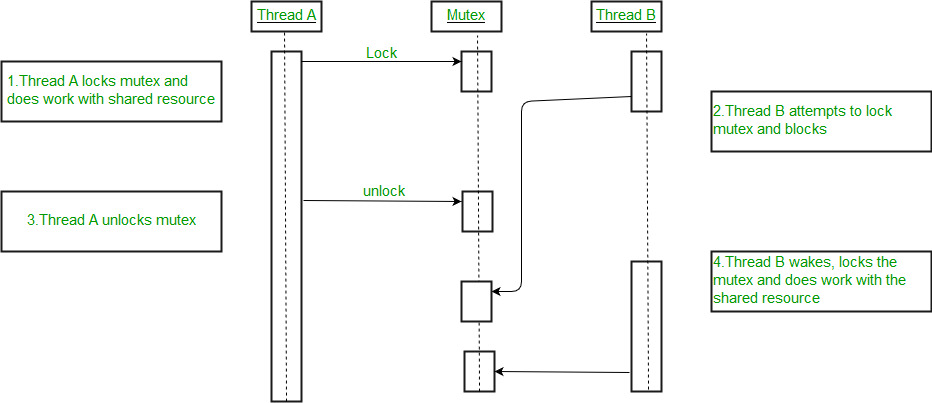

### 2.1 互斥锁(Mutex)的使用

#### 2.1.1 互斥锁的基本概念

互斥锁是一种用于控制多个线程对共享资源互斥访问的同步机制。它确保同一时间只有一个线程可以访问某个资源,当一个线程获得了锁后,其他试图进入该临界区的线程将被阻塞,直到锁被释放。

```cpp

#include <mutex>

std::mutex mtx;

void critical_function() {

mtx.lock();

// 临界区代码

mtx.unlock();

}

int main() {

// 在多线程环境中使用critical_function

return 0;

}

```

在上述代码中,我们创建了一个`std::mutex`对象`mtx`,并在需要保护的代码区前后分别调用了`lock()`和`unlock()`方法。请注意,在实际的多线程程序中,通常会使用`lock_guard`或`unique_lock`等RAII类自动管理锁的生命周期,以避免忘记释放锁带来的问题。

#### 2.1.2 互斥锁的高级特性

互斥锁除了基本的互斥功能外,C++标准库还提供了一些高级特性来管理锁的状态和行为。例如:

- 尝试锁:`try_lock()`方法允许线程尝试获取锁而不阻塞,如果锁已被其他线程占用,则该方法会立即返回。

- 递归锁:虽然C++标准不直接支持递归锁,但可以通过`std::recursive_mutex`实现类似功能。

### 2.2 读写锁(RWLock)的应用

#### 2.2.1 读写锁的定义和原理

读写锁(也称为共享-独占锁,Shared-Exclusive Lock)是针对读多写少场景设计的一种锁。它允许多个线程同时读取共享资源,但在写入时需要独占资源。读写锁通常有三种状态:读模式下加锁、写模式下加锁和未加锁。

```cpp

#include <shared_mutex>

std::shared_mutex rw_mutex;

void read_function() {

rw_mutex.lock_shared();

// 执行读操作

rw_mutex.unlock_shared();

}

void write_function() {

rw_mutex.lock();

// 执行写操作

rw_mutex.unlock();

}

int main() {

// 在多线程环境中使用read_function和write_function

return 0;

}

```

#### 2.2.2 读写锁的实际应用场景

读写锁在数据库管理系统、缓存系统和任何读取操作远多于写入操作的系统中都有广泛的应用。例如,缓存可以允许多个读操作并发进行,但对缓存数据的更新需要串行化以保证数据的一致性。

### 2.3 条件变量(Condition Variables)

#### 2.3.1 条件变量的作用和工作原理

条件变量是一种允许线程等待直到某个条件成立的同步原语。与互斥锁不同,条件变量通常用于线程间的通知机制,一个线程在某个条件尚未满足时可以挂起等待,当其他线程改变状态并通知条件变量时,等待的线程将被唤醒。

```cpp

#include <mutex>

#include <condition_variable>

std::mutex mtx;

std::condition_variable cv;

bool ready = false;

void do准备工作() {

// 执行一些准备工作

{

std::lock_guard<std::mutex> lock(mtx);

ready = true;

}

cv.notify_one(); // 唤醒一个等待的线程

}

void do一些工作() {

std::unique_lock<std::mutex> lock(mtx);

cv.wait(lock, []{ return ready; }); // 等待条件成立

// 执行工作

}

int main() {

std::thread t1(do准备工作);

std::thread t2(do一些工作);

t1.join();

t2.join();

return 0;

}

```

#### 2.3.2 使用条件变量解决实际问题

条件变量特别适用于生产者-消费者模型,其中消费者需要等待生产者生成数据后才能继续执行。另外,条件变量也适用于线程池中任务的等待和执行。通过条件变量,线程池可以避免过多地创建线程,只在任务队列中有任务等待时才唤醒线程进行处理。

在本章节中,我们详细探讨了互斥锁、读写锁和条件变量的使用和原理,为线程间的同步提供了多种有效的工具。在下一章中,我们将继续深入线程间的其他同步机制,如信号量和事件,以及更高级的并发控制策略。

# 3. 线程间的信号量与事件控制

## 3.1 信号量(Semaphores)的使用和原理

信号量是一种广泛使用的同步原语,它可以用于控制对共享资源的访问数量。它由E. W. Dijkstra在1965年提出,并在多个操作系统中实现。在这一节中,我们将深入探讨信号量的基本操作,以及它如何在资源控制中发挥作用。

### 3.1.1 信号量的基本操作

信号量可以被视为一个计数器,用以控制对某些共享资源的访问数量。初始时,信号量被赋予一个非负整数的值,表示资源的可用数量。当一个线程希望访问这些共享资源时,它必须先获取信号量。信号量的操作通常包括两个原子操作:等待(wait)和信号(signal),也被称为P(proberen,意为测试)和V(verhogen,意为增加)。

等待操作用于尝试获取资源,如果信号量的计数大于0,线程将其减1,并继续执行;如果信号量的计数为0,则线程将被阻塞,直到信号量的计数大于0。信号操作则是用来释放资源,它将信号量的计数加1,如果有其他线程因等待该信号量而被阻塞,则其中一个线程将被唤醒。

```c++

// 一个简单的信号量示例

#include <semaphore.h>

sem_t semaphore;

void* worker(void* arg) {

sem_wait(&semaphore); // 等待操作

// 使用共享资源的代码

sem_post(&semaphore); // 信号操作

return NULL;

}

int main() {

sem_init(&semaphore, 0, 1); // 初始化信号量,初始值为1

// 创建和启动线程

sem_destroy(&semaphore); // 清理信号量资源

return 0;

}

```

### 3.1.2 信号量在资源控制中的应用

信号量在控制资源数量方面非常有效,特别是在有限资源的场景中。例如,假设有一个应用需要访问一个最多只能由10个线程同时访问的数据库连接池。通过信号量可以简单地限制同时访问数据库连接池的线程数量不超过10。

以下是信号量在资源控制中的应用示例代码,它描述了如何使用信号量控制对有限资源的并发访问:

```c++

#include <stdio.h>

#include <semaphore.h>

#include <pthread.h>

#include <unistd.h>

#define MAX_THREADS 10

sem_t sem;

void* func(void* arg) {

sem_wait(&sem); // 请求资源,减少信号量计数

printf("Thread %ld is accessing resource\n", (long)arg);

sleep(1); // 模拟资源访问耗时

printf("Thread %ld has finished accessing resource\n", (long)arg);

sem_post(&sem); // 释放资源,增加信号量计数

return NULL;

}

int main() {

pthread_t threads[MAX_THREADS];

int i;

sem_init(&sem, 0, 1); // 初始化信号量,最大资源数为1

for(i = 0; i < MAX_THREADS; i++) {

pthread_create(&threads[i], NULL, func, (void*)i);

}

for(i = 0; i < MAX_THREADS; i++) {

pthread_join(threads[i], NULL);

}

sem_destroy(&sem); // 销毁信号量

return 0;

}

```

信号量并不是没有缺点,例如在高竞争情况下,频繁的上下文切换可能导致效率低下。因此,在某些场景下可能需要使用其他同步机制来优化性能。

## 3.2 事件(Events)的同步作用

事件对象是一种允许一个线程告诉其他线程某个事件已经发生的通知机制。在多线程编程中,事件用于同步线程之间的操作,使得线程能够等待某个信号或条件成立后才继续执行。

### 3.2.1 事件对象的创建和触发机制

事件对象通常有两种状态:未触发(signaled)和已触发(nonsignaled)。当一个事件处于未触发状态时,等待该事件的线程将被挂起,不继续执行。一旦事件被触发(设置为未信号状态),所有等待该事件的线程将被唤醒,并且可以根据事件的状态来决定执行路径。

在Windows系统中,可以使用`CreateEvent`或`CreateEventEx`函数创建一个事件对象。而在POSIX兼容系统中,可以使用`pthread_cond_init`和相关函数来模拟

0

0