优化Python读取大型Excel文件的方法

发布时间: 2024-04-16 22:21:39 阅读量: 115 订阅数: 51

# 1. 理解Excel文件读取的性能瓶颈

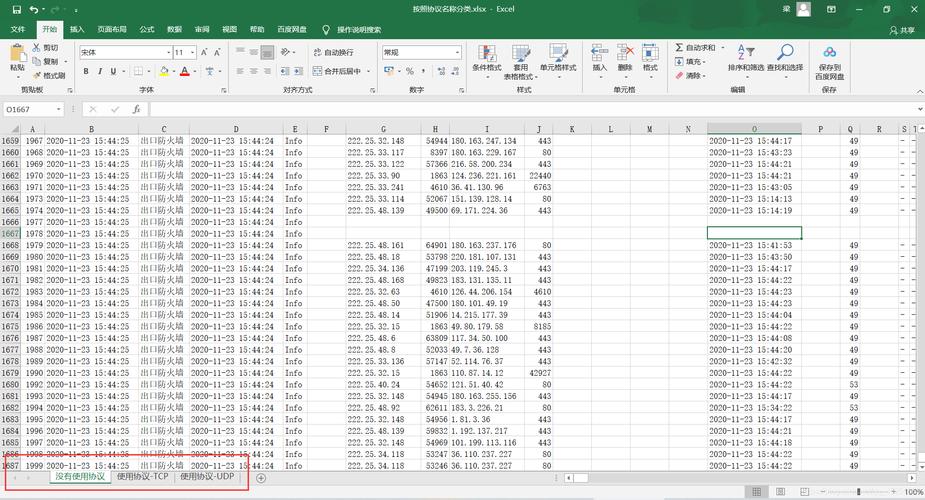

在Excel文件读取中,性能瓶颈通常体现在文件格式和文件结构上。针对文件格式,我们需要了解Excel文件的后缀名含义,比如`.xls`代表Excel 97-2003工作簿,而`.xlsx`代表Excel 2007及以上版本使用的工作簿。对于文件结构,Excel文件采用一种分层存储方式,包含工作表、单元格等元素,导致读取时需要逐个元素解析,影响读取性能。Python读取Excel文件通常使用Pandas库,该库提供了高效的数据结构和数据分析工具,但读取大型文件时会遇到性能挑战,需要采取优化策略。因此,理解Excel文件的性能瓶颈对优化读取过程至关重要。

# 2. 优化Python读取Excel文件的数据处理流程

#### 2.1 选择合适的读取工具

在处理大型Excel文件时,选择合适的读取工具至关重要。常用的读取工具包括Pandas和Openpyxl,它们在性能上有所区别。

##### 2.1.1 比较Pandas和Openpyxl的性能差异

Pandas是一个强大的数据处理库,但对于大型Excel文件的读取速度可能不如专门的Excel处理工具Openpyxl。若Excel文件较大,考虑使用Openpyxl来提升读取性能。

##### 2.1.2 选择合适的工具根据需求

根据实际需求选择读取工具。若需要快速读取与处理数据,Openpyxl可能更适合;若需要进行复杂的数据分析与处理,Pandas则是更佳选择。

#### 2.2 分块读取大型Excel文件

分块读取是处理大型Excel文件的常用技术,可以有效减少内存占用和提升读取效率。

##### 2.2.1 使用Pandas的chunksize参数

Pandas提供了chunksize参数,可以指定每次读取文件的行数,从而实现分块读取大型Excel文件。

```python

import pandas as pd

chunk_size = 1000

for chunk in pd.read_excel('large_file.xlsx', chunksize=chunk_size):

process_chunk(chunk)

```

##### 2.2.2 分块读取数据的实现方法

通过循环迭代每个数据块,可以逐块处理数据,减轻内存压力。

##### 2.2.3 数据处理后的合并策略

处理完每个数据块后,可根据需求选择合并数据的策略,如逐块处理后再合并,或在处理过程中实时合并数据。

#### 2.3 利用多线程/多进程加速数据读取

多线程/多进程技术可提升数据读取速度,在处理大型Excel文件时尤为重要。

##### 2.3.1 多线程/多进程的优势与适用场景

并发处理能充分利用多核处理器资源,加快数据读取速度,尤其适用于大量数据的并行处理。

##### 2.3.2 实例演示:如何利用多线程优化Excel文件读取性能

```python

import concurrent.futures

def process_data(data_chunk):

# 处理数据的逻辑

pass

with concurrent.futures.ThreadPoolExecutor() as executor:

executor.map(process_data, data_chunks)

```

以上是优化Python读取大型

0

0