【MPI编程新手教程】:轻松掌握MPICH2编程模式与核心技巧!

发布时间: 2025-01-09 22:45:03 阅读量: 8 订阅数: 5

cuda.rar_cuda mpi_cuda 教程_cuda 编程 教程

# 摘要

本文旨在为读者提供关于MPI(消息传递接口)并行编程的全面指南,从基础概念到高级应用,覆盖了搭建环境、基本语法、核心通信函数实践、性能优化以及调试技巧等多个方面。通过对MPI编程环境的搭建,介绍了MPICH2软件包的安装和编译环境的配置,随后详细讲解了MPI的基本语法结构,包括程序的入口和出口点、进程和通信域的概念、以及消息传递的基本规则。文章接着深入探讨了点对点通信和集合通信函数的实践应用,还涉及到高级通信模式、性能优化和程序调试的策略。最后,通过实战演练,分析了并行算法设计、实际案例和代码演示,以及MPI在科学计算和现代计算框架中的扩展应用。本文不仅是MPI初学者的入门教材,也为有经验的开发者提供了进一步的实践指导和高级主题探索。

# 关键字

MPI;并行编程;消息传递;性能优化;调试技巧;科学计算

参考资源链接:[MPICH2安装指南:全面配置与迁移教程](https://wenku.csdn.net/doc/51z2220w3n?spm=1055.2635.3001.10343)

# 1. MPI基础知识概述

## 1.1 MPI的定义与发展

MPI(Message Passing Interface)是一种用于并行计算的消息传递通信标准,旨在开发可移植、高效、灵活且易于使用的并行应用程序。自从1990年代初推出以来,MPI已成为高性能计算领域的国际标准,并不断进化,持续为并行程序设计者提供强有力的开发工具。

## 1.2 MPI的核心概念

MPI的核心概念包括进程间的独立性、进程组、通信子以及点对点和集合通信。它通过定义一套丰富的通信函数来支持复杂的并行通信模式。此外,MPI注重程序的可移植性,使得同一套代码可以在多种不同的并行计算机系统上运行。

## 1.3 MPI的应用领域

MPI广泛应用于科学研究、工程计算、数据分析以及任何需要处理大规模数据集和复杂计算的场景。由于其高度的可扩展性和灵活性,使得MPI成为许多高性能计算任务的首选。

通过以上章节,我们对MPI有了初步的认识,接下来我们将深入探讨如何搭建MPI编程环境,并掌握MPI的基本语法。

# 2. MPI编程环境搭建与基本语法

搭建一个高效的MPI编程环境是进行并行计算的第一步。了解基本的MPI语法结构对于编写和理解MPI程序至关重要。本章将分两部分介绍:首先是如何搭建MPI编程环境,其次是MPI的基本语法结构。

### 2.1 MPI编程环境的搭建

#### 2.1.1 安装MPICH2软件包

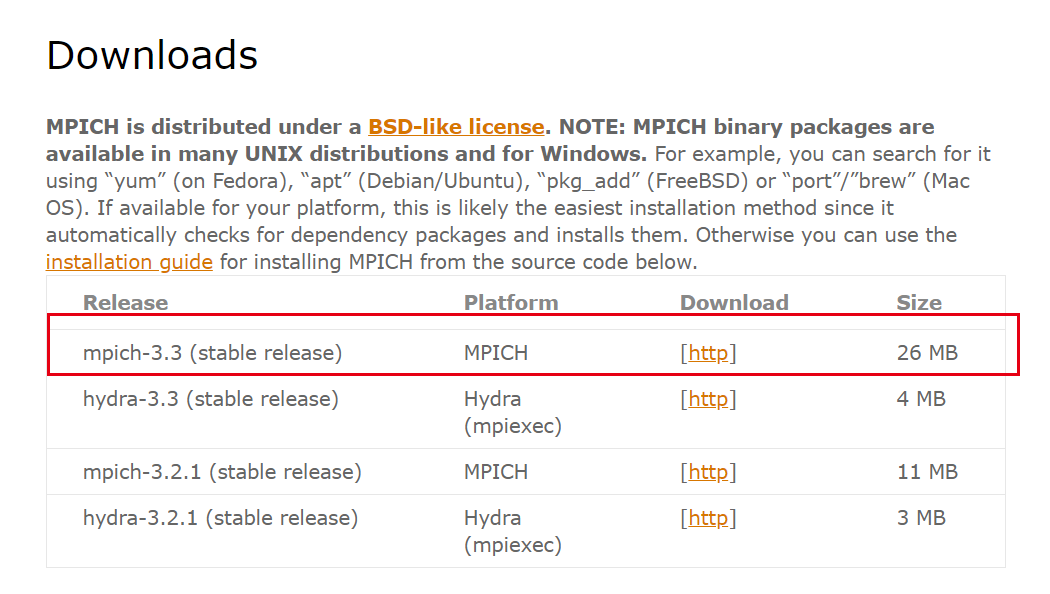

MPICH2是一个开源、高性能的MPI-2实现。它适用于多种操作系统,包括Linux、Windows和Mac OS X。安装MPICH2是一个直接的步骤,可以通过包管理器或从源代码编译来完成。

在Linux环境下,可以使用包管理器快速安装MPICH2。例如,在基于Debian的系统中,可以使用以下命令安装:

```bash

sudo apt-get install mpich2

```

在Windows上,用户可以通过MPICH2提供的Windows安装程序进行安装。

安装完成后,通常需要配置环境变量以确保MPI编译器(如mpicc)和运行时库可以被系统正确识别。

#### 2.1.2 配置MPI编译环境

配置MPI编译环境主要是为了设置好编译命令,使得开发者能够用它们来编译MPI程序。配置环境变量是常见的做法。

以bash shell为例,可以通过以下命令配置环境变量:

```bash

export MPI_HOME=/path/to/mpich2

export PATH=$MPI_HOME/bin:$PATH

export LD_LIBRARY_PATH=$MPI_HOME/lib:$LD_LIBRARY_PATH

```

以上命令将MPICH2的安装路径添加到系统的PATH和LD_LIBRARY_PATH变量中,这样系统就能找到MPI的可执行文件和库文件。

### 2.2 MPI的基本语法结构

MPI程序设计有其特定的语法结构,了解这些结构对于编写和维护MPI代码非常重要。本节将详细介绍MPI程序的基本语法。

#### 2.2.1 MPI程序的入口和出口点

一个MPI程序的入口点总是`main`函数,其基本形式如下:

```c

#include <mpi.h>

int main(int argc, char* argv[]) {

// MPI初始化

MPI_Init(&argc, &argv);

// MPI程序代码

// MPI终止

MPI_Finalize();

return 0;

}

```

在`MPI_Init`和`MPI_Finalize`之间编写MPI的核心代码。`MPI_Init`初始化MPI运行时环境,而`MPI_Finalize`则在程序结束前释放所有资源。

#### 2.2.2 MPI进程和通信域

MPI中,每个独立执行的程序实例被称为一个进程(process)。进程之间通过通信域(communicator)进行通信。最常用的通信域是`MPI_COMM_WORLD`,它包含了所有参与程序执行的进程。

```c

MPI_Comm_size(MPI_COMM_WORLD, &num_processes);

MPI_Comm_rank(MPI_COMM_WORLD, &process_rank);

```

在上面的代码中,`MPI_Comm_size`用于获取通信域内的进程总数,`MPI_Comm_rank`用于获取当前进程的唯一标识(rank)。

#### 2.2.3 MPI消息传递的基本规则

MPI的基本通信机制是消息传递,允许进程间发送和接收数据。消息由三部分组成:发送者、接收者和消息内容。

以下是一个简单的消息发送和接收示例:

```c

int msg = 0;

MPI_Send(&msg, 1, MPI_INT, destination, tag, MPI_COMM_WORLD);

```

```c

int received_msg;

MPI_Recv(&received_msg, 1, MPI_INT, source, tag, MPI_COMM_WORLD, &status);

```

在发送消息时,需要指定发送的起始地址、消息长度、数据类型、目标进程的rank、一个标签(tag)以及使用的通信域。接收消息时,需要指定接收消息的起始地址、消息长度、数据类型、源进程的rank、一个标签以及使用的通信域,并且还需要一个状态对象来记录接收到的消息。

MPI的通信和同步是并行计算领域的重要概念,是实现高效并行算法的基础。通过本节的介绍,我们对MPI的基本语法结构有了初步的了解。在后续章节中,我们将深入探讨如何利用MPI提供的通信函数来构建实用的并行程序。

# 3. MPI核心通信函数的实践应用

## 3.1 点对点通信函数的应用

点对点通信是MPI中最基本也是最直接的通信方式,每个进程可以与另一个进程单独通信。掌握点对点通信对于理解更复杂的通信模式是必要的。

### 3.1.1 MPI_Send和MPI_Recv的基本使用

MPI_Send函数用于发送消息,而MPI_Recv用于接收消息。下面给出基本使用方法,并提供代码示例。

```c

MPI_Send(void* data, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm)

```

`MPI_Send`函数的参数解释如下:

- `void* data`: 指向要发送数据的指针。

- `int count`: 要发送数据的元素个数。

- `MPI_Datatype datatype`: 数据类型。

- `int dest`: 目的进程的标识符。

- `int tag`: 消息标签,用于区分不同的消息。

- `MPI_Comm comm`: 通信器(communicator),通常为`MPI_COMM_WORLD`。

相对应的接收函数`MPI_Recv`的参数有类似的含义。

下面是使用`MPI_Send`和`MPI_Recv`进行点对点通信的示例代码。

```c

#include <stdio.h>

#include "mpi.h"

int main(int argc, char** argv) {

MPI_Init(&argc, &argv);

int rank, size;

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

int value;

if (rank == 0) {

value = 10;

MPI_Send(&value, 1, MPI_INT, 1, 0, MPI_COMM_WORLD);

printf("Process 0 sent value %d\n", value);

} else if (rank == 1) {

MPI_Recv(&value, 1, MPI_INT, 0, 0, MPI_COMM_WORLD, MPI_STATUS_IGNORE);

printf("Process 1 received value %d\n", value);

}

MPI_Finalize();

return 0;

}

```

在这个例子中,进程0发送一个整数值给进程1,进程1接收这个值并打印出来。注意`MPI_Recv`函数中的`MPI_STATUS_IGNORE`参数,它表示接收函数不需要返回状态信息。

### 3.1.2 非阻塞通信和缓冲通信的技巧

非阻塞通信允许多个通信操作重叠执行,这可以减少因等待通信完成而空闲的处理时间,提升程序效率。缓冲通信则通过缓冲区发送或接收数据,可以在不同速度的进程间同步数据。

### 非阻塞通信示例

```c

MPI_Request request;

MPI_Isend(&value, 1, MPI_INT, 1, 0, MPI_CO

```

0

0