【API库性能优化】:揭秘提升Python API库响应速度的终极策略(急迫性、专业性)

发布时间: 2024-10-13 14:33:17 阅读量: 33 订阅数: 28

# 1. API库性能优化概述

在现代软件开发中,API库作为系统与外界交互的重要组件,其性能直接关系到整个应用程序的响应速度和效率。性能优化是确保API库能够高效、稳定运行的关键。本章将概述API库性能优化的重要性,并简要介绍后续章节的内容。

API库的性能优化不仅仅是一个技术问题,它还涉及到系统架构、代码实现、资源管理等多个层面。为了达到最佳的性能,我们需要理解API库的工作原理,识别系统瓶颈,并采用合适的优化策略。性能优化不应该影响API库的功能性,这是一个需要平衡的问题。

本章内容将为读者提供一个API库性能优化的概览,帮助读者建立一个整体的认识,为后续深入探讨打下基础。我们将从理论基础到实际应用,逐步深入,以确保读者能够掌握优化API库所需的全面知识。

# 2. 性能优化的理论基础

## 2.1 性能分析的基本概念

### 2.1.1 响应时间和吞吐量

在本章节中,我们将深入探讨性能优化的基本理论,首先从响应时间和吞吐量这两个核心概念开始。响应时间是指系统对请求做出响应所需的时间,通常包括请求的发送、处理以及响应的接收三个阶段。它是衡量系统即时性能的关键指标,直接影响用户体验。例如,一个在线购物网站的响应时间如果过长,可能会导致用户放弃购物,因此响应时间对于商业系统来说至关重要。

吞吐量则是指单位时间内系统能够处理的请求数量,它体现了系统的处理能力。在高并发场景下,吞吐量是评估系统是否能够高效处理大量请求的重要指标。高吞吐量意味着系统能够在单位时间内完成更多的工作,这对于需要处理大量数据的后台服务尤其重要。

### 2.1.2 系统瓶颈的识别方法

系统瓶颈是影响性能的关键因素,识别和解决这些瓶颈是性能优化的关键步骤。常用的系统瓶颈识别方法包括:

- **性能测试**:通过模拟实际工作负载对系统进行性能测试,以识别瓶颈。

- **资源监控**:监控系统资源使用情况,如CPU、内存、磁盘I/O等,以发现资源使用率高的情况。

- **代码分析**:检查代码执行效率,特别是热点代码路径,以确定是否存在性能瓶颈。

例如,通过监控工具如Prometheus,我们可以收集系统的性能指标,并使用Grafana进行可视化展示,帮助我们识别性能瓶颈。

## 2.2 理解API库的工作原理

### 2.2.1 API库的请求处理流程

API库作为后端服务的重要组成部分,其请求处理流程对性能有着直接影响。API库通常包含以下几个关键步骤:

1. **请求接收**:API库首先接收外部的请求,这可能包括HTTP请求或其他协议的请求。

2. **参数解析**:对请求中的参数进行解析和验证。

3. **请求分发**:根据请求的内容,将其分发到相应的处理函数或服务。

4. **业务处理**:执行业务逻辑,可能涉及数据库操作、文件处理等。

5. **响应返回**:将处理结果封装成响应格式返回给客户端。

下面是一个简化的代码示例,展示了API库请求处理的伪代码:

```python

def handle_request(request):

params = parse_parameters(request) # 参数解析

if not validate_params(params): # 参数验证

return create_error_response()

response = dispatch_request(params) # 请求分发

result = business_logic(response) # 业务处理

return create_response(result) # 响应返回

```

### 2.2.2 API库的并发模型

API库的并发模型决定了其如何同时处理多个请求。常见的并发模型包括:

- **多线程**:每个请求由一个线程处理,适用于IO密集型任务。

- **多进程**:每个请求由一个进程处理,适用于CPU密集型任务。

- **异步编程**:使用异步非阻塞的方式来处理请求,适用于高并发场景。

例如,使用Python的asyncio库,我们可以实现一个简单的异步API库:

```python

import asyncio

async def handle_request(request):

# 异步处理请求

response = await business_logic(request)

return response

async def main():

# 启动事件循环,处理多个请求

await asyncio.gather(handle_request(req1), handle_request(req2), ...)

if __name__ == "__main__":

asyncio.run(main())

```

## 2.3 性能优化的常见误区

### 2.3.1 过度优化的问题

性能优化是一个持续的过程,但在实际操作中,开发者往往会陷入过度优化的误区。过度优化可能会带来以下问题:

- **代码复杂度增加**:为了追求性能,代码可能变得难以理解和维护。

- **资源浪费**:优化后的代码可能消耗更多的系统资源,反而降低了效率。

- **时间成本高昂**:过度优化需要大量时间,可能会延误项目进度。

例如,一个简单的业务逻辑可能只需要O(n)的时间复杂度,但如果开发者过度追求性能,使用了O(n log n)的排序算法,这不仅增加了实现的复杂度,还可能因为额外的排序操作而浪费资源。

### 2.3.2 优化与功能性的平衡

在进行性能优化时,开发者必须平衡优化带来的性能提升和功能性之间的关系。以下是一些关键点:

- **功能完整性**:优化不应损害功能的完整性,功能优先是基本原则。

- **用户体验**:性能优化的最终目标是提升用户体验。

- **可维护性**:优化后的代码应保持良好的可维护性,以便未来进行进一步的优化或调整。

例如,在一个Web应用中,提升页面加载速度是一个常见的性能优化目标。开发者可以通过减少不必要的请求、使用CDN等方式来优化,但这些优化不应影响页面内容的完整性和用户的操作体验。

在本章节中,我们介绍了性能优化的理论基础,包括性能分析的基本概念、API库的工作原理以及性能优化的常见误区。这些知识为后续章节中深入探讨代码层面和系统架构层面的性能优化打下了坚实的基础。

# 3. 代码层面的性能优化

## 3.1 代码优化的最佳实践

### 3.1.1 代码可读性和可维护性

在本章节中,我们将深入探讨如何在优化代码性能的同时,保持代码的可读性和可维护性。代码的可读性是软件开发中的一个重要方面,它直接关系到代码的长期可维护性和团队协作的效率。优化代码性能往往需要引入复杂的算法和数据结构,这可能会牺牲代码的可读性。因此,开发者需要在代码性能和可读性之间找到一个平衡点。

一个常见的做法是使用设计模式和编程原则来指导代码编写。例如,使用单一职责原则可以将复杂的代码分解成更小、更易理解的部分。此外,代码中的注释和文档也是提高代码可读性的关键因素。注释不仅可以解释代码的功能,还可以说明为什么要采取特定的优化措施。

### 3.1.2 循环优化和逻辑简化

循环优化是提高代码性能的有效手段之一。在本章节中,我们将介绍如何通过减少循环中的计算量、优化循环的迭代次数等方式来提升代码性能。例如,通过预先计算循环中的常量值,或者将循环内的条件判断移出循环体外,可以减少每次迭代的计算量。

逻辑简化同样重要。复杂的逻辑判断不仅难以阅读,还可能影响性能。通过使用逻辑运算符的短路特性,可以减少不必要的计算。例如,在条件表达式 `if (a && b)` 中,如果 `a` 为 `false`,那么 `b` 将不会被评估,从而减少计算量。

```python

# 示例代码:逻辑运算符短路特性

def calculate_value(a, b):

if a and b:

return a + b

else:

return 0

# 当 a 为 False 时,b 不会被评估

```

通过上述示例代码,我们可以看到当 `a` 为 `False` 时,`b` 的计算将不会执行,这样就减少了不必要的计算。

## 3.2 高效的数据结构选择

### 3.2.1 标准数据结构的性能影响

选择合适的数据结构对于代码性能至关重要。在本章节中,我们将讨论不同数据结构在不同场景下的性能影响。例如,数组和链表是两种常见的数据结构,它们在插入、删除和访问元素时的性能表现各不相同。数组提供了快速的索引访问,但在尾部之外的位置插入或删除元素时需要移动大量数据。而链表虽然在插入和删除操作上更高效,但访问元素时需要遍历整个链表。

### 3.2.2 特定场景下的数据结构优化

针对特定场景的数据结构优化可以显著提升代码性能。例如,在需要频繁查找元素的场景下,可以使用哈希表来提高查找效率。哈希表通过哈希函数将元素映射到数组的索引位置,从而实现接近常数时间的查找性能。

```python

# 示例代码:使用哈希表提高查找效率

def hash_function(key):

return hash(key) % table_size

# 哈希表的实现

class HashTable:

def __init__(self):

self.table_size = 100

self.table = [[] for _ in range(self.table_size)]

def insert(self, key, value):

index = hash_function(key)

key_exists = False

bucket = self.table[index]

for i, kv in enumerate(bucket):

k, v = kv

if key == k:

key_exists = True

break

if key_exists:

bucket[i] = ((key, value))

else:

bucket.append((key, value))

def lookup(self, key):

index = hash_function(key)

bucket = self.table[index]

for k, v in bucket:

if key == k:

return v

return None

```

在上述示例代码中,我们展示了如何使用哈希函数和哈希表来实现快速的插入和查找操作。哈希表的索引位置是通过哈希函数计算得到的,这样可以将键值对快速定位到对应的存储桶中。

## 3.3 算法效率的提升

### 3.3.1 复杂度分析

复杂度分析是算法效率评估的关键。在本章节中,我们将介绍如何使用大O表示法来描述算法的时间复杂度。大O表示法可以告诉我们算法执行的时间与输入数据规模之间的关系。例如,一个时间复杂度为O(n)的算法意味着其执行时间与输入数据的大小线性相关。

### 3.3.2 常用算法的性能优化

常用算法的性能优化是提升代码性能的重要途径。例如,在排序算法中,快速排序和归并排序都提供了O(n log n)的时间复杂度,但在不同的应用场景下,它们的性能表现可能会有所不同。快速排序在数据分布不均匀时可能退化到O(n^2),而归并排序则在所有情况下都能保证O(n log n)的性能。

```python

# 示例代码:快速排序

def quick_sort(arr):

if len(arr) <= 1:

return arr

pivot = arr[len(arr) // 2]

left = [x for x in arr if x < pivot]

middle = [x for x in arr if x == pivot]

right = [x for x in arr if x > pivot]

return quick_sort(left) + middle + quick_sort(right)

# 示例代码:归并排序

def merge_sort(arr):

if len(arr) <= 1:

return arr

mid = len(arr) // 2

left = merge_sort(arr[:mid])

right = merge_sort(arr[mid:])

return merge(left, right)

def merge(left, right):

result = []

i = j = 0

while i < len(left) and j < len(right):

if left[i] < right[j]:

result.append(left[i])

i += 1

else:

result.append(right[j])

j += 1

result.extend(left[i:])

result.extend(right[j:])

return result

```

在上述示例代码中,我们展示了快速排序和归并排序的实现。快速排序通过选择一个基准值并将其余元素分为两部分,然后递归排序这两部分。归并排序则通过递归地将数组分成两半,对每一半进行排序,然后合并这两个排序好的部分。

通过上述章节内容的详细介绍,我们可以看到代码层面的性能优化不仅需要考虑算法和数据结构的选择,还需要在代码的可读性、可维护性以及逻辑简化上下功夫。通过深入理解标准数据结构的性能影响,以及在特定场景下选择合适的数据结构,我们可以显著提升代码性能。此外,通过复杂度分析和常用算法的性能优化,我们可以构建出更高效、更可靠的代码。

# 4. 系统架构层面的性能优化

在本章节中,我们将深入探讨系统架构层面的性能优化,这是提升API库性能的关键所在。系统架构的优化不仅涉及到并发处理和资源管理,还包括网络层面的优化。我们将逐个探讨这些方面,并分析如何通过优化这些架构层面的因素来提高API库的整体性能。

## 4.1 API库的并发处理

API库的并发处理是影响性能的关键因素之一。在本小节中,我们将讨论多线程与多进程的使用,以及异步编程模型的应用。

### 4.1.1 多线程与多进程

多线程和多进程是实现并发处理的两种主要方式。在多线程中,线程共享进程的内存空间,而多进程则是每个进程拥有独立的内存空间。多线程适合于I/O密集型任务,因为线程切换的开销相对较小;多进程适合于CPU密集型任务,因为它可以避免全局解释器锁(GIL)带来的限制。

#### 线程与进程的选择

在选择使用线程还是进程时,需要考虑任务的性质和资源的可用性。例如,如果API库主要处理大量的网络请求,那么多线程可能是更好的选择,因为网络I/O的等待时间可以通过线程切换来隐藏。相反,如果API库需要进行大量的计算密集型操作,那么多进程可能更合适,因为每个进程都可以独立使用一个CPU核心,不受其他进程的影响。

#### 并发模型的选择

并发模型的选择同样重要。常见的并发模型包括:

- **线程池模型**:通过重用一组固定大小的线程来处理请求,可以减少线程创建和销毁的开销。

- **事件驱动模型**:使用事件循环来处理多个并发的I/O操作,适合于I/O密集型应用。

- **微服务架构**:将系统拆分成多个独立的服务,每个服务处理特定的任务,可以通过分布式部署来提升性能和可靠性。

### 4.1.2 异步编程模型的应用

异步编程模型是一种无需阻塞等待I/O操作完成的编程范式,它可以让程序在等待I/O操作时继续执行其他任务,从而提高资源利用率和吞吐量。

#### 异步编程的优势

异步编程的主要优势在于它可以减少上下文切换和阻塞等待的时间,使得CPU可以更有效地利用。在I/O密集型的应用中,异步编程可以显著提升性能。

#### 异步编程的实现

在Python中,可以使用`asyncio`库来实现异步编程。以下是一个简单的异步HTTP请求示例:

```python

import aiohttp

import asyncio

async def fetch(url):

async with aiohttp.ClientSession() as session:

async with session.get(url) as response:

return await response.text()

async def main():

urls = ['***', '***', '***']

tasks = []

for url in urls:

tasks.append(fetch(url))

responses = await asyncio.gather(*tasks)

for response in responses:

print(response)

asyncio.run(main())

```

在这个例子中,`fetch`函数是一个异步函数,它使用`aiohttp`库来发起异步HTTP请求。`main`函数创建了一个任务列表,然后使用`asyncio.gather`来并发执行这些任务。

#### 异步编程的应用场景

异步编程模型适用于以下场景:

- **Web服务**:处理大量的并发HTTP请求。

- **网络爬虫**:同时抓取多个网页。

- **异步IO操作**:例如数据库访问、文件操作等。

## 4.2 资源管理与负载均衡

资源管理与负载均衡是确保系统稳定运行和高可用性的关键。在本小节中,我们将探讨内存和CPU资源管理,以及负载均衡策略。

### 4.2.1 内存和CPU资源管理

内存和CPU资源的有效管理可以防止系统过载和性能瓶颈的产生。

#### 内存管理

内存泄漏是导致内存使用不断增加的主要原因。要避免内存泄漏,需要:

- **及时释放不再使用的对象**:确保没有循环引用。

- **使用内存分析工具**:定期检查内存使用情况。

- **优化数据结构和算法**:减少不必要的内存分配。

#### CPU资源管理

CPU资源的管理主要涉及到避免过度的CPU使用,导致系统响应变慢。

- **避免不必要的计算**:对重复的计算结果进行缓存。

- **使用多进程或异步编程**:分散计算负载。

- **监控CPU使用率**:使用工具如`top`或`htop`监控CPU使用情况。

### 4.2.2 负载均衡策略

负载均衡是一种提高系统吞吐量和可用性的技术,它将工作负载分散到多个计算资源上。

#### 负载均衡的方法

常见的负载均衡策略包括:

- **轮询(Round Robin)**:依次将请求分配给每个服务器。

- **最小连接(Least Connections)**:将请求分配给当前连接数最少的服务器。

- **加权轮询(Weighted Round Robin)**:根据服务器的权重分配请求。

#### 负载均衡的应用

负载均衡器可以是软件或硬件,常见的软件负载均衡器有:

- **Nginx**:可以作为反向代理服务器,实现负载均衡。

- **HAProxy**:高性能的负载均衡解决方案。

### 4.3 网络层面的优化

网络层面的优化可以显著提升API库的性能,特别是对于分布式系统和云服务来说尤为重要。在本小节中,我们将探讨通信协议的选择与优化,以及数据传输效率的提升。

#### 4.3.1 通信协议的选择与优化

选择合适的通信协议对于网络性能至关重要。

##### 通信协议的选择

- **HTTP/2**:相较于HTTP/1.x,HTTP/2提供了多路复用、头部压缩等优化,可以减少延迟和提高传输效率。

- **gRPC**:基于HTTP/2的协议,提供了一种高效的通信方式,特别适合于微服务架构。

##### 通信协议的优化

- **压缩数据**:使用gzip等压缩算法压缩请求和响应数据。

- **使用CDN**:通过内容分发网络(CDN)缓存静态资源,减少服务器的负载。

#### 4.3.2 数据传输效率提升

数据传输效率的提升可以减少网络延迟和提高吞吐量。

##### 数据传输的优化

- **批量请求**:将多个请求合并为一个请求,减少网络往返次数。

- **数据格式优化**:使用二进制格式(如Protocol Buffers)代替JSON等文本格式进行数据传输。

##### 示例代码

以下是一个使用`requests`库发送HTTP/2请求的示例:

```python

import requests

url = '***'

headers = {'Content-Type': 'application/json'}

data = {'key': 'value'}

response = requests.post(url, headers=headers, data=data, verify=False)

print(response.text)

```

在这个例子中,我们向`***`发送了一个POST请求。通过设置`verify=False`,我们可以禁用SSL证书验证,这对于测试环境很有用。

#### 总结

在本小节中,我们讨论了如何选择和优化通信协议,以及如何提升数据传输效率。通过这些优化措施,可以显著提高API库的网络性能。

在本章节中,我们探讨了系统架构层面的性能优化,包括API库的并发处理、资源管理与负载均衡,以及网络层面的优化。这些优化措施可以显著提升API库的整体性能,使其能够更好地处理高并发请求和大数据量的传输。在下一章节中,我们将介绍性能监控与调优工具,这些工具可以帮助我们更好地理解和优化API库的性能。

# 5. 性能监控与调优工具

在API库性能优化的过程中,监控和调优工具的使用是不可或缺的一环。这些工具不仅可以帮助我们了解API库的运行状况,还可以在出现问题时提供重要的数据支持,以便我们进行针对性的优化。

## 5.1 性能监控工具的介绍

性能监控工具可以分为两类:一类是内置的性能分析模块,另一类是第三方性能监控工具。

### 5.1.1 内置的性能分析模块

许多编程语言和框架都内置了性能分析模块,例如Python的cProfile、Java的JConsole、Node.js的built-in profiler等。这些工具可以帮助我们了解程序的运行状况,包括CPU使用情况、内存消耗、执行时间等。

例如,使用Python的cProfile进行性能分析:

```python

import cProfile

import pstats

def my_function():

# 模拟耗时操作

pass

cProfile.run('my_function()', 'my_stats')

p = pstats.Stats('my_stats')

p.sort_stats('cumulative').print_stats(10)

```

### 5.1.2 第三方性能监控工具

除了内置的性能分析模块,还有许多第三方的性能监控工具,如Prometheus、Grafana、New Relic等。这些工具通常具有更丰富的功能和更强大的数据处理能力。

例如,使用Prometheus进行性能监控:

```yaml

scrape_configs:

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

```

然后,通过Grafana进行数据的可视化:

```sql

SELECT mean(rate(http_requests_total[5m])) as '5m Rate'

FROM http_requests_total

GROUP BY job

```

## 5.2 调优过程中的数据收集

性能调优的过程中,数据收集是关键的一环。通过日志记录和分析,我们可以了解程序的运行状况,找出性能瓶颈。

### 5.2.1 日志记录和分析

日志记录可以帮助我们了解程序的运行情况,包括错误、警告、性能数据等。常用的日志记录库有Python的logging、Java的Log4j等。

例如,使用Python的logging进行日志记录:

```python

import logging

logging.basicConfig(level=***)

logger = logging.getLogger(__name__)

***('Info message')

logger.warning('Warning message')

logger.error('Error message')

```

### 5.2.2 性能数据的可视化

通过性能数据的可视化,我们可以更直观地了解程序的运行状况,找出性能瓶颈。常用的可视化工具如Grafana、Kibana等。

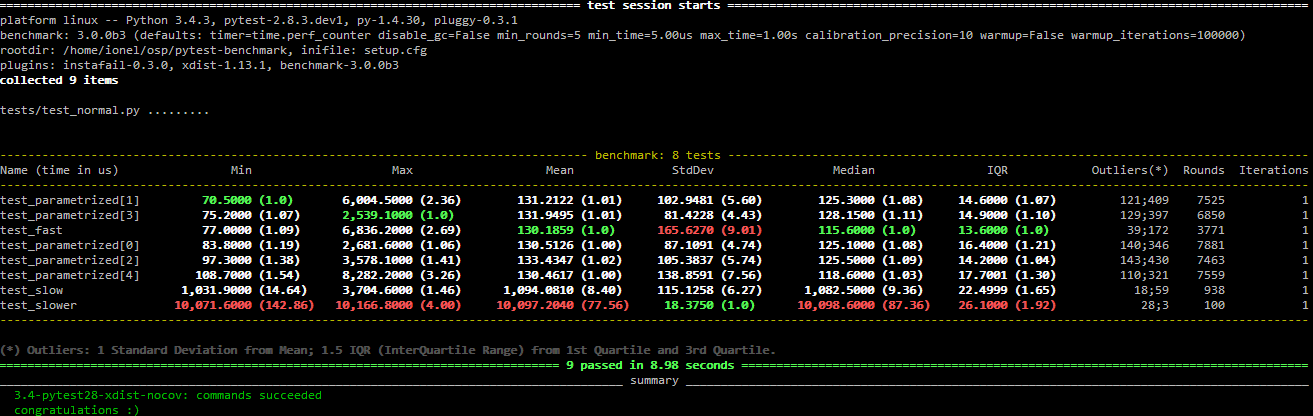

## 5.3 持续集成中的性能测试

在持续集成的过程中,我们需要进行自动化性能测试,以确保每次代码更新后的性能是否达标。

### 5.3.1 自动化性能测试流程

自动化性能测试可以帮助我们及时发现问题,减少人工干预。常用的自动化性能测试工具有JMeter、Gatling等。

例如,使用JMeter进行性能测试:

```plaintext

# JMeter Test Plan

- Thread Group

- HTTP Request

- View Results Tree

```

### 5.3.2 性能回归测试

性能回归测试可以确保代码更新不会引入新的性能问题。通过对比每次测试的结果,我们可以及时发现问题。

通过以上介绍,我们可以看到,性能监控和调优工具在API库性能优化的过程中起着至关重要的作用。

0

0