cut命令在大规模数据处理中的应用:如何应对挑战与优化技巧

发布时间: 2024-12-12 15:09:19 阅读量: 5 订阅数: 19

白色简洁风格的学术交流会议源码下载.zip

# 1. cut命令的基础知识和功能介绍

在信息处理领域,准确而高效的数据提取是确保后续分析与处理准确性的关键。`cut` 命令作为 UNIX 和 Linux 系统中的文本处理工具,它能高效地从文件或标准输入中提取文本列。它是通过指定分隔符来实现的,能够快速处理以特定字符(如逗号、制表符等)分隔的数据。

## 简单使用与功能概述

在简单层面,`cut` 命令的使用非常直观。它主要包含两个关键参数 `-f` 和 `-d`。其中 `-f` 参数用于指定需要提取的字段(Field)编号,而 `-d` 参数则用于指定字段之间的分隔符。例如,如果有一个以逗号分隔的 CSV 文件,想要提取第二列的数据,可以使用以下命令:

```bash

cut -d, -f2 filename.csv

```

在更复杂的应用场景中,`cut` 命令支持对提取范围的精确控制,甚至可以结合正则表达式来处理非标准分隔符的文本数据。

## 实现的细节

尽管 `cut` 命令看似简单,但它在数据预处理中扮演着重要的角色。在处理文本数据时,我们通常会遇到不同的分隔符和格式问题。`cut` 命令通过参数的灵活组合,允许用户准确地定义提取数据的边界,解决了大部分基础的文本处理需求。

对初学者来说,理解 `cut` 命令的基本语法和参数意义是入门文本处理的第一步,而对于有经验的 IT 从业者来说,掌握它在复杂场景下的应用和与其他命令的协同使用,则是优化工作流程和提升效率的关键。

# 2. 大规模数据处理的挑战

在当今的信息时代,数据已成为企业竞争的重要资源。然而,随着数据量的爆炸式增长,处理大规模数据集时会遇到许多挑战。本章将深入探讨这些挑战,并提供相应的分析和解决策略。

## 2.1 数据量大带来的问题

大规模数据处理不仅对存储系统提出了更高的要求,还会显著增加系统资源的消耗,对处理时间也是一大考验。

### 2.1.1 系统资源消耗分析

当数据量达到一定程度时,常规的单机处理方式往往会遇到瓶颈,例如CPU、内存和磁盘I/O的性能限制。数据处理任务可能需要更多的CPU时间来完成计算,而内存消耗可能增加到远远超出单个机器的物理限制。磁盘I/O也可能成为瓶颈,尤其是在频繁读写大数据集时。

**优化策略:**

- 采用分布式计算框架,如Apache Hadoop或Apache Spark,可以将数据集拆分成更小的部分,分散到多台机器上处理,从而减轻单机负载。

- 使用内存映射文件技术,它可以将磁盘上的数据映射到内存地址空间,使得对文件的读写操作转化为内存操作,减少I/O开销。

### 2.1.2 处理时间的挑战

大规模数据集的处理时间往往很长,这在数据密集型的任务中尤其明显。处理时间的增加不仅会导致业务响应变慢,还会影响数据的时效性。

**优化策略:**

- 利用并行处理技术,可以显著缩短数据处理时间。通过在多个CPU核心或多个计算节点上同时运行任务,可以将任务完成时间压缩。

- 对数据处理流程进行优化,比如通过减少不必要的I/O操作,或者改进算法效率来加快处理速度。

## 2.2 数据格式多样性带来的问题

在处理大规模数据时,我们常常会遇到不同格式的数据。不同格式的数据处理方式各异,这增加了数据处理的复杂性。

### 2.2.1 不同数据格式的识别和处理

数据格式包括但不限于CSV、JSON、XML、固定宽度、分隔符分隔等多种类型。不同格式的数据需要不同的解析方法和处理策略。

**优化策略:**

- 预先识别数据格式,并编写相应的解析器。在某些情况下,可以使用现成的库(如Python中的`pandas`或Java中的`Jackson`)来处理特定格式的数据。

- 对于多种格式混杂的数据集,可以开发一个灵活的处理框架,自动检测并应用合适的处理方法。

### 2.2.2 格式统一化处理策略

为了减少处理不同格式数据时的复杂度,通常需要将数据统一化为一种标准格式。例如,可以将各种数据转换为统一的JSON格式进行处理。

**优化策略:**

- 实现数据转换器,用于在数据读取阶段将不同格式统一转换为标准格式。

- 使用数据流处理技术,这样可以在数据传输过程中动态地进行格式转换和处理。

## 2.3 数据质量问题

数据质量直接影响数据分析的准确性和可靠性,处理大规模数据时,数据质量问题尤为突出。

### 2.3.1 数据清洗的重要性

数据清洗是确保数据质量的重要步骤。它涉及识别并处理数据中的不一致性、错误和缺失值。

**优化策略:**

- 在数据加载到处理系统之前进行初步的清洗。这可以通过编写预处理脚本或使用数据清洗工具来实现。

- 利用机器学习技术自动识别和纠正数据错误。例如,可以训练模型识别异常值或填补缺失数据。

### 2.3.2 数据错误的检测与校正

数据错误的检测与校正通常需要结合领域知识和自动化工具,以实现高效率和高质量的处理。

**优化策略:**

- 设计检测算法,可以有效地识别数据中的错误。这些算法可以基于统计分析、规则匹配或模式识别。

- 采用校正机制,以自动化或半自动化的方式对检测到的错误数据进行校正。这可能需要人工审核某些复杂或边缘情况。

在下一章节中,我们将探讨如何利用cut命令应对这些挑战,并进一步发挥其在文本处理方面的潜力。

# 3. cut命令的高级应用技巧

cut命令是一个简单但功能强大的文本处理工具,通过合理使用其高级特性,即便是处理大规模数据流也能达到事半功倍的效果。本章将深入探讨cut命令的高级应用技巧,并展示如何与其他文本处理工具协同工作,以及如何在大规模数据流处理中发挥其独特作用。

## 3.1 命令行参数的深度使用

### 3.1.1 字段指定和范围使用

cut命令的核心功能之一是提取文件或输入流中的特定字段。通过指定字段编号和范围,可以精确地获取所需数据。例如,要从以下内容中提取以逗号分隔的第二和第四列:

```

Name,Address,City,Zip,Phone

John Doe,123 Main St.,Anytown,12345,555-1234

Jane Smith,456 Elm St.,Othertown,67890,555-5678

```

可以使用以下cut命令:

```bash

cut -d, -f2,4 file.csv

```

该命令中`-d,`指定逗号为字段分隔符,`-f2,4`指示cut提取第二和第四字段。

### 3.1.2 复杂文本处理的策略

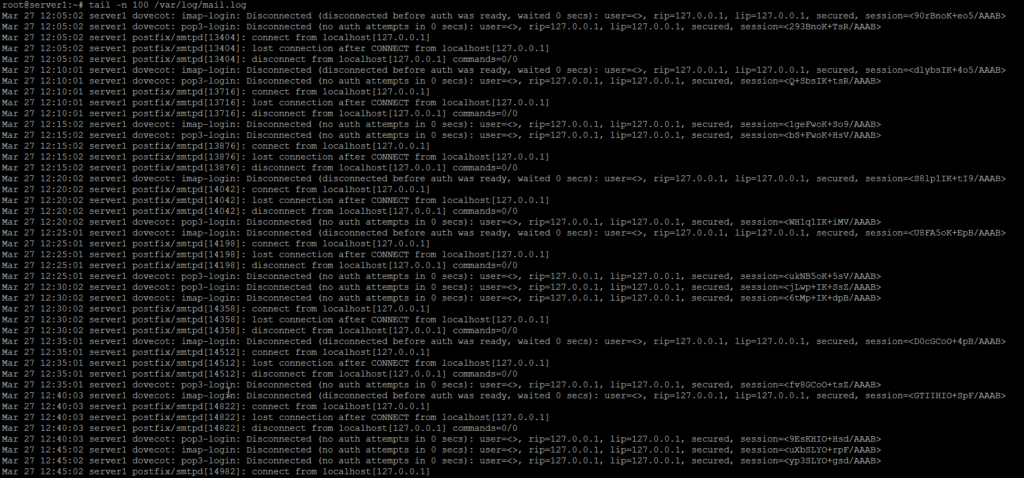

cut命令也适用于更复杂的文本处理场景。如需从日志文件中提取时间戳,可以根据时间戳的格式(例如`YYYY-MM-DD HH:MM:SS`),结合cut和sed命令实现:

```bash

cut -d ' ' -f1 filename.log | sed 's/[][]//g'

```

这里使用了空格作为字段分隔符,提取每行的第一个字段(假设时间戳位于每行的开始)。随后,通过sed移除时间戳字符串中的方括号。

## 3.2 结合其他文本处理工具

### 3.2.1 cut与其他命令的协同工作

cut命令通常与其他文本处理工具配合使用,以实现更强大的数据处理功能。例如,可以将cut、sort和uniq命令组合使用,从一个文本文件中统计词频:

```bash

cut -d ' ' -f1 filename.txt | sort | un

```

0

0