揭秘异常检测的秘密:从原理到实践,全面解析异常检测技术

发布时间: 2024-08-22 08:41:22 阅读量: 68 订阅数: 24

# 1. 异常检测概述**

异常检测是一种识别数据集中与正常模式明显不同的数据点的技术。它在识别欺诈、网络安全威胁、医疗保健异常和许多其他领域中具有广泛的应用。

异常检测算法通常基于统计学、机器学习或其他数学技术,这些技术可以识别与正常数据分布显著不同的数据点。异常检测可以分为三类:统计异常检测、基于距离的异常检测和基于密度的异常检测。

# 2.1 异常检测的定义和分类

### 2.1.1 统计异常检测

统计异常检测基于统计学原理,假设正常数据遵循某种已知的分布,例如正态分布或高斯分布。异常值被定义为偏离正常分布的极端数据点。

**方法:**

- **Z-分数:**计算每个数据点与均值之间的标准差。异常值具有较大的绝对Z分数。

- **概率密度函数:**计算每个数据点在正常分布中的概率密度。异常值具有非常低的概率密度。

**代码块:**

```python

import numpy as np

# 计算 Z-分数

z_scores = np.abs(data - np.mean(data)) / np.std(data)

# 识别异常值

threshold = 3 # 自定义阈值

outliers = data[z_scores > threshold]

```

**逻辑分析:**

- `np.mean(data)` 计算数据的均值。

- `np.std(data)` 计算数据的标准差。

- `np.abs()` 取绝对值,避免负值。

- 阈值 `threshold` 可根据业务需求调整。

### 2.1.2 基于距离的异常检测

基于距离的异常检测将数据点视为多维空间中的点。异常值被定义为与其他数据点距离较远的点。

**方法:**

- **欧几里得距离:**计算数据点与质心或最近邻的距离。异常值具有较大的距离。

- **马氏距离:**考虑数据点的协方差矩阵,更适用于非球形分布。

**代码块:**

```python

import numpy as np

from sklearn.neighbors import NearestNeighbors

# 计算欧几里得距离

distances = np.linalg.norm(data - np.mean(data, axis=0), axis=1)

# 识别异常值

threshold = np.percentile(distances, 95) # 95% 分位数作为阈值

outliers = data[distances > threshold]

```

**逻辑分析:**

- `np.linalg.norm()` 计算欧几里得距离。

- `np.mean(data, axis=0)` 计算每一列的均值,得到质心。

- `np.percentile()` 计算指定百分位的阈值。

### 2.1.3 基于密度的异常检测

基于密度的异常检测假设正常数据点聚集在高密度区域,而异常值位于低密度区域。

**方法:**

- **局部异常因子 (LOF):**计算每个数据点与周围邻居的局部密度之比。异常值具有较高的 LOF 值。

- **DBSCAN:**一种基于密度的聚类算法,可识别密度低的异常值。

**代码块:**

```python

from sklearn.neighbors import LocalOutlierFactor

# 计算局部异常因子

lof = LocalOutlierFactor()

lof.fit(data)

# 识别异常值

outliers = data[lof.negative_outlier_factor_ < -1] # 负值表示异常值

```

**逻辑分析:**

- `LocalOutlierFactor()` 初始化 LOF 对象。

- `lof.fit(data)` 训练 LOF 模型。

- `lof.negative_outlier_factor_` 存储每个数据点的 LOF 值。

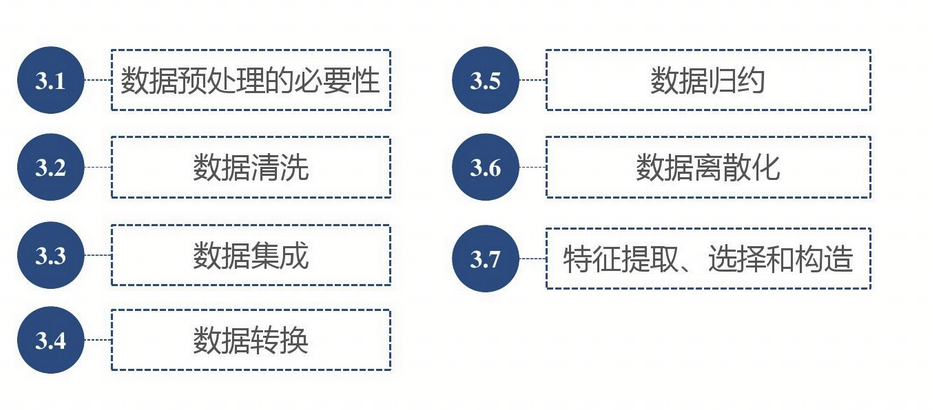

# 3. 异常检测实践方法

### 3.1 数据预处理

数据预处理是异常检测实践中至关重要的一步,它可以提高算法的准确性和效率。数据预处理包括以下步骤:

#### 3.1.1 数据清洗和转换

**数据清洗**涉及去除异常值、缺失值和噪声。异常值是与数据集中其他值明显不同的值,可能是由于数据输入错误或传感器故障造成的。缺失值是缺少数据的点,可能是由于设备故障或数据收集过程中的错误。噪声是随机波动或干扰,会掩盖有意义的数据模式。

**数据转换**涉及将数据转换为适合异常检测算法的格式。这可能包括标准化、归一化或离散化。标准化将数据转换为均值为 0、标准差为 1 的分布。归一化将数据转换为 0 到 1 之间的范围。离散化将连续数据转换为离散类别。

#### 3.1.2 特征工程

**特征工程**是创建和选择用于异常检测算法的特征的过程。特征是数据集中描述每个点的属性。选择有意义的特征对于提高算法的准确性至关重要。

特征工程技术包括:

- **特征选择:**选择最能区分正常数据和异常数据的数据子集。

- **特征提取:**创建新特征,这些特征是原始特征的组合或转换。

- **特征缩放:**调整特征的范围,以确保它们在算法中具有相似的权重。

### 3.2 异常检测算法选择

#### 3.2.1 算法评估指标

在选择异常检测算法时,需要考虑以下评估指标:

- **准确率:**算法正确识别异常值的百分比。

- **召回率:**算法识别所有异常值的百分比。

- **F1 分数:**准确率和召回率的加权平均值。

- **ROC 曲线:**真实正例率与假正例率之间的关系曲线。

- **AUC:**ROC 曲线下的面积,表示算法区分正常数据和异常数据的总体能力。

#### 3.2.2 算法调参和优化

大多数异常检测算法都有可调整的参数,这些参数会影响算法的性能。参数调优涉及调整这些参数以优化评估指标。

参数调优技术包括:

- **网格搜索:**在参数值的网格上系统地评估算法。

- **贝叶斯优化:**一种基于贝叶斯统计的迭代优化方法。

- **进化算法:**一种基于进化论的优化方法。

### 3.3 异常检测结果分析和可视化

#### 3.3.1 异常值识别

一旦异常检测算法运行,就需要识别异常值。这可以通过以下方法实现:

- **阈值方法:**设置一个阈值,高于或低于该阈值的数据点被标记为异常值。

- **聚类方法:**将数据点聚类,异常值将被分配到较小的、孤立的聚类中。

- **分类方法:**使用分类算法将数据点分类为正常或异常。

#### 3.3.2 异常模式分析

除了识别异常值之外,分析异常模式也很重要。异常模式是异常值在数据中的分布或行为。通过分析异常模式,可以获得有关异常发生原因的见解。

异常模式分析技术包括:

- **时间序列分析:**识别异常值随时间变化的模式。

- **空间分析:**识别异常值在空间中的分布模式。

- **关联分析:**识别异常值与其他数据点之间的关联模式。

# 4. 异常检测在不同领域的应用

异常检测在各个领域都有着广泛的应用,以下列举几个典型的应用场景:

### 4.1 欺诈检测

欺诈检测是异常检测的一个重要应用领域。通过识别异常的交易模式,可以有效防止欺诈行为的发生。

**4.1.1 信用卡欺诈检测**

信用卡欺诈是指未经持卡人授权的信用卡交易。异常检测算法可以分析信用卡交易数据,识别出与正常交易模式明显不同的异常交易,从而标记出潜在的欺诈行为。

**代码块:**

```python

import pandas as pd

import numpy as np

from sklearn.preprocessing import StandardScaler

from sklearn.cluster import KMeans

# 加载信用卡交易数据

data = pd.read_csv('credit_card_transactions.csv')

# 标准化数据

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data)

# 聚类

kmeans = KMeans(n_clusters=2)

kmeans.fit(data_scaled)

# 识别异常交易

outliers = kmeans.predict(data_scaled) == 1

```

**逻辑分析:**

该代码块使用 KMeans 聚类算法对信用卡交易数据进行聚类。聚类后,将聚类结果为 1 的交易标记为异常交易。

**4.1.2 身份盗用检测**

身份盗用是指未经他人授权使用其个人信息进行欺诈活动。异常检测算法可以分析个人身份信息,识别出与正常模式明显不同的异常模式,从而标记出潜在的身份盗用行为。

### 4.2 网络安全

异常检测在网络安全领域也发挥着重要作用。通过识别异常的网络流量模式,可以及时发现和应对网络攻击。

**4.2.1 入侵检测**

入侵检测是指识别未经授权的访问或尝试访问计算机系统或网络。异常检测算法可以分析网络流量数据,识别出与正常流量模式明显不同的异常流量,从而标记出潜在的入侵行为。

**代码块:**

```

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

from sklearn.neighbors import LocalOutlierFactor

# 加载网络流量数据

data = pd.read_csv('network_traffic_data.csv')

# 标准化数据

scaler = MinMaxScaler()

data_scaled = scaler.fit_transform(data)

# 局部异常因子算法

lof = LocalOutlierFactor()

lof.fit(data_scaled)

# 识别异常流量

outliers = lof.predict(data_scaled) == -1

```

**逻辑分析:**

该代码块使用局部异常因子算法(LOF)对网络流量数据进行异常检测。LOF 算法计算每个数据点的局部异常因子,并标记出异常因子较高的数据点为异常流量。

**4.2.2 恶意软件检测**

恶意软件是指旨在损害或破坏计算机系统的软件。异常检测算法可以分析计算机系统文件和行为,识别出与正常模式明显不同的异常模式,从而标记出潜在的恶意软件感染。

### 4.3 医疗保健

异常检测在医疗保健领域也有着重要的应用。通过识别异常的患者数据模式,可以及时发现和诊断疾病。

**4.3.1 疾病诊断**

异常检测算法可以分析患者的病历、检查结果和其他医疗数据,识别出与正常模式明显不同的异常模式,从而辅助医生诊断疾病。

**4.3.2 药物副作用检测**

异常检测算法可以分析患者的用药记录和健康数据,识别出与正常模式明显不同的异常模式,从而辅助医生检测药物副作用。

**mermaid流程图:**

```mermaid

graph LR

subgraph 异常检测在不同领域的应用

欺诈检测 --> 信用卡欺诈检测

欺诈检测 --> 身份盗用检测

网络安全 --> 入侵检测

网络安全 --> 恶意软件检测

医疗保健 --> 疾病诊断

医疗保健 --> 药物副作用检测

end

```

# 5. 异常检测的挑战和未来趋势

### 5.1 大数据和高维数据下的异常检测

随着数据量的不断增长和数据维度越来越高,异常检测面临着新的挑战。大数据和高维数据给异常检测算法带来了以下困难:

- **计算复杂度高:**大数据和高维数据会导致计算量急剧增加,使得传统异常检测算法难以处理。

- **维度灾难:**高维数据中,特征之间的相关性复杂,容易出现维度灾难,导致异常检测算法性能下降。

- **稀疏性:**高维数据通常很稀疏,这使得基于距离或密度的异常检测算法难以识别异常值。

为了应对这些挑战,需要开发新的异常检测算法,这些算法能够有效处理大数据和高维数据。例如,基于子空间的异常检测算法和基于流式处理的异常检测算法。

### 5.2 实时异常检测

实时异常检测是指在数据生成的同时进行异常检测。这在许多应用场景中至关重要,例如欺诈检测和网络安全。实时异常检测面临的主要挑战是:

- **数据流的连续性:**数据流是连续的,需要实时处理,这给算法的效率和准确性带来了挑战。

- **概念漂移:**数据流中的数据分布可能会随着时间而变化,这需要算法能够适应概念漂移。

- **低延迟要求:**实时异常检测需要低延迟,以确保及时发现异常情况。

为了应对这些挑战,需要开发新的实时异常检测算法,这些算法能够高效处理数据流,适应概念漂移,并满足低延迟要求。例如,基于在线学习的异常检测算法和基于滑动窗口的异常检测算法。

### 5.3 异常检测的自动化和可解释性

异常检测的自动化和可解释性对于实际应用至关重要。自动化可以减少人工干预,提高异常检测的效率。可解释性可以帮助用户理解异常检测结果,提高对异常检测系统的信任度。

异常检测的自动化和可解释性面临的主要挑战是:

- **算法选择和调参:**异常检测算法众多,选择和调参是一项复杂的任务。自动化算法选择和调参可以提高异常检测系统的效率和准确性。

- **异常值解释:**异常值解释是指识别和解释异常值背后的原因。这有助于用户理解异常检测结果,并采取适当的措施。

- **可视化:**可视化异常检测结果可以帮助用户直观地理解异常情况。

为了应对这些挑战,需要开发新的异常检测算法和技术,这些算法和技术能够自动化算法选择和调参,解释异常值,并提供可视化的异常检测结果。例如,基于机器学习的异常检测算法和基于交互式可视化的异常检测系统。

**总结**

异常检测的挑战和未来趋势主要集中在大数据和高维数据下的异常检测、实时异常检测以及异常检测的自动化和可解释性。这些挑战需要新的异常检测算法和技术的开发,以满足实际应用的需求。

# 6. 异常检测的最佳实践

### 6.1 确定明确的异常检测目标

在实施异常检测系统之前,至关重要的是明确定义异常检测的目标。这将指导算法的选择、数据预处理和结果分析。目标可以包括:

- 识别欺诈交易

- 检测网络入侵

- 诊断疾病

- 发现药物副作用

### 6.2 了解数据和业务背景

对数据和业务背景的深入理解对于成功实施异常检测系统至关重要。这包括了解:

- 数据的分布和特征

- 正常行为的模式

- 潜在异常的类型

- 业务流程和影响

### 6.3 选择合适的算法和参数

没有一刀切的异常检测算法。算法的选择取决于数据类型、异常类型和检测目标。一些常见的算法包括:

- **聚类算法:**将数据点分组为相似组,异常值通常是孤立的点。

- **分类算法:**将数据点分类为正常或异常,使用训练数据集进行训练。

- **孤立森林算法:**通过随机采样和隔离树构建来检测异常值。

算法参数也需要仔细调整以优化检测性能。这可能涉及调整距离阈值、聚类数或分类器超参数。

### 6.4 持续监控和评估异常检测系统

异常检测系统需要持续监控和评估以确保其有效性和准确性。这包括:

- **定期审查异常检测结果:**分析检测到的异常值并验证其真实性。

- **评估算法性能:**使用指标(如准确率、召回率和 F1 分数)评估算法的性能。

- **调整算法和参数:**根据评估结果,根据需要调整算法和参数以提高检测性能。

0

0