Python爬虫高级技巧:解锁并发、分布式、反反爬虫,让爬虫更强大

发布时间: 2024-06-19 11:33:16 阅读量: 115 订阅数: 59

Python常用的爬虫技巧总结

# 1. Python爬虫基础回顾

Python爬虫是利用Python语言编写的自动化网络数据采集工具,它可以模拟浏览器行为,从网页中提取所需的信息。本章将回顾Python爬虫的基础知识,包括:

- **爬虫工作原理:**介绍爬虫的基本工作流程,包括请求发送、响应解析和数据提取。

- **HTTP协议与爬虫:**讲解HTTP协议的基础知识,以及爬虫如何利用HTTP协议与网页交互。

- **网页解析技术:**介绍HTML和XML解析技术,以及如何使用Python库(如BeautifulSoup)解析网页内容。

# 2. Python爬虫并发与分布式

### 2.1 并发爬虫的实现方式

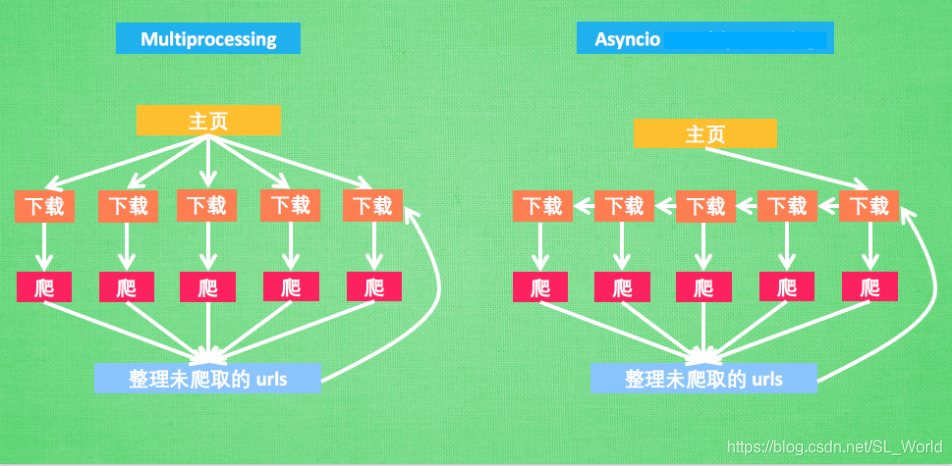

并发爬虫通过同时执行多个任务来提高爬虫效率。它有以下几种实现方式:

#### 2.1.1 多线程爬虫

多线程爬虫使用多线程同时执行多个爬虫任务。每个线程独立运行,共享相同的内存空间。

**代码示例:**

```python

import threading

import requests

def fetch_url(url):

response = requests.get(url)

return response.text

def main():

urls = ['url1', 'url2', 'url3']

threads = []

for url in urls:

thread = threading.Thread(target=fetch_url, args=(url,))

threads.append(thread)

thread.start()

for thread in threads:

thread.join()

if __name__ == '__main__':

main()

```

**逻辑分析:**

* 创建一个`fetch_url`函数来获取URL的内容。

* 在`main`函数中,定义要爬取的URL列表。

* 为每个URL创建一个线程,并将`fetch_url`函数作为目标函数。

* 启动所有线程。

* 等待所有线程完成。

#### 2.1.2 多进程爬虫

多进程爬虫使用多个进程同时执行爬虫任务。每个进程都有自己的内存空间,可以独立运行。

**代码示例:**

```python

import multiprocessing

import requests

def fetch_url(url):

response = requests.get(url)

return response.text

def main():

urls = ['url1', 'url2', 'url3']

processes = []

for url in urls:

process = multiprocessing.Process(target=fetch_url, args=(url,))

processes.append(process)

process.start()

for process in processes:

process.join()

if __name__ == '__main__':

main()

```

**逻辑分析:**

* 创建一个`fetch_url`函数来获取URL的内容。

* 在`main`函数中,定义要爬取的URL列表。

* 为每个URL创建一个进程,并将`fetch_url`函数作为目标函数。

* 启动所有进程。

* 等待所有进程完成。

#### 2.1.3 协程爬虫

协程爬虫使用协程来实现并发。协程是一种轻量级的线程,可以暂停和恢复执行。

**代码示例:**

```python

import asyncio

async def fetch_url(url):

response = await requests.get(url)

return response.text

async def main():

urls = ['url1', 'url2', 'url3']

tasks = []

for url in urls:

task = asyncio.create_task(fetch_url(url))

tasks.append(task)

await asyncio.gather(*tasks)

if __name__ == '__main__':

asyncio.run(main())

```

**逻辑分析:**

* 创建一个`fetch_url`协程函数来获取URL的内容。

* 在`main`协程函数中,定义要爬取的URL列表。

* 为每个URL创建一个协程任务。

* 使用`asyncio.gather`函数同时执行所有协程任务。

* 使用`asyncio.run`函数运行主协程函数。

# 3.1 反爬虫机制分析

反爬虫机制是网站或应用程序用来阻止爬虫访问其内容的技术。这些机制旨在识别和阻止自动化的请求,以保护网站免受恶意活动、数据盗窃和服务器过载的影响。以下是常见的反爬虫机制:

#### 3.1.1 IP地址限制

IP地址限制是一种简单的反爬虫机制,它通过阻止来自特定IP地址或IP地址范围的请求来工作。当爬虫发送大量请求时,网站可以检测到这些请求来自同一IP地址,并将其阻止。

#### 3.1.2 User-Agent伪装检测

User-Agent是一个HTTP头,它标识了发送请求的浏览器或客户端。爬虫通常使用定制的User-Agent来伪装成浏览器,以绕过IP地址限制。然而,网站可以检测到这些定制的User-Agent,并将其阻止。

#### 3.1.3 Cookie反爬虫

Cookie是网站存储在用户浏览器中的小块数据。它们用于跟踪用户会话和偏好。反爬虫机制可以利用Cookie来识别爬虫。当爬虫发送请求时,网站可以检查请求中是否包含Cookie。如果没有Cookie,网站可以将请求识别为来自爬虫,并将其阻止。

### 3.2 反反爬虫技术

反反爬虫技术是爬虫开发者用来绕过反爬虫机制的技术。这些技术旨在让爬虫看起来像合法用户,从而绕过网站的防御措施。以下是常见的反反爬虫技术:

#### 3.2.1 代理池的构建和管理

代理池是一个代理服务器的集合。代理服务器充当爬虫和目标网站之间的中介。通过使用代理池,爬虫可以从不同的IP地址发送请求,从而绕过IP地址限制。

#### 3.2.2 User-Agent池的维护

User-Agent池是一个User-Agent字符串的集合。通过使用User-Agent池,爬虫可以伪装成不同的浏览器或客户端,从而绕过User-Agent伪装检测。

#### 3.2.3 Cookie池的应用

Cookie池是一个Cookie的集合。通过使用Cookie池,爬虫可以伪装成合法用户,从而绕过Cookie反爬虫。

# 4. Python爬虫高级数据处理

### 4.1 数据清洗和预处理

数据清洗和预处理是数据分析和挖掘前的关键步骤,其目的是将原始数据转换为适合分析和建模的格式。

#### 4.1.1 数据类型转换

数据类型转换是指将数据从一种类型转换为另一种类型。例如,将字符串转换为数字、将日期转换为时间戳等。

```python

# 将字符串转换为数字

age = "25"

age_int = int(age)

# 将日期转换为时间戳

import datetime

date_str = "2023-03-08"

date_timestamp = datetime.datetime.strptime(date_str, '%Y-%m-%d').timestamp()

```

#### 4.1.2 数据缺失值处理

数据缺失值是数据清洗中常见的问题。缺失值处理的方法有:

* **删除缺失值:**删除包含缺失值的记录或特征。

* **填充缺失值:**使用平均值、中位数或众数等方法填充缺失值。

* **插补缺失值:**使用线性回归或其他插补算法估计缺失值。

```python

# 删除包含缺失值的记录

df = df.dropna()

# 用平均值填充缺失值

df['age'].fillna(df['age'].mean(), inplace=True)

# 用线性回归插补缺失值

import numpy as np

from sklearn.linear_model import LinearRegression

X = df.drop('age', axis=1)

y = df['age']

model = LinearRegression()

model.fit(X, y)

df['age'] = model.predict(X)

```

#### 4.1.3 数据标准化

数据标准化是指将数据缩放到一个统一的范围内,以消除不同特征之间的量纲差异。常用的标准化方法有:

* **最小-最大标准化:**将数据映射到[0, 1]范围内。

* **均值-标准差标准化:**将数据减去均值并除以标准差。

```python

# 最小-最大标准化

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

df_scaled = scaler.fit_transform(df)

# 均值-标准差标准化

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df)

```

### 4.2 数据分析和挖掘

数据分析和挖掘是利用数据来发现模式、趋势和洞察的过程。

#### 4.2.1 数据可视化

数据可视化是将数据以图形或图表的方式呈现,以帮助人们理解和分析数据。常用的可视化工具有:

* **折线图:**展示数据随时间的变化。

* **条形图:**比较不同类别的数据。

* **散点图:**展示两个变量之间的关系。

```python

# 使用 matplotlib 绘制折线图

import matplotlib.pyplot as plt

plt.plot(df['date'], df['value'])

plt.show()

# 使用 seaborn 绘制条形图

import seaborn as sns

sns.barplot(x='category', y='value', data=df)

plt.show()

# 使用 plotly 绘制散点图

import plotly.express as px

fig = px.scatter(df, x='x', y='y')

fig.show()

```

#### 4.2.2 机器学习算法应用

机器学习算法可以用于从数据中学习模式和预测结果。常用的机器学习算法有:

* **线性回归:**预测连续变量。

* **逻辑回归:**预测二分类变量。

* **决策树:**用于分类和回归。

```python

# 使用 scikit-learn 训练线性回归模型

from sklearn.linear_model import LinearRegression

model = LinearRegression()

model.fit(X, y)

# 使用 scikit-learn 训练逻辑回归模型

from sklearn.linear_model import LogisticRegression

model = LogisticRegression()

model.fit(X, y)

# 使用 scikit-learn 训练决策树模型

from sklearn.tree import DecisionTreeClassifier

model = DecisionTreeClassifier()

model.fit(X, y)

```

#### 4.2.3 自然语言处理技术

自然语言处理技术可以用于分析文本数据,提取关键词、主题和情感。常用的自然语言处理技术有:

* **词频统计:**计算文本中单词出现的频率。

* **文本分类:**将文本分配到预定义的类别。

* **情感分析:**识别文本中的情感倾向。

```python

# 使用 nltk 进行词频统计

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

text = "This is a sample text for natural language processing."

stop_words = set(stopwords.words('english'))

words = [word for word in word_tokenize(text) if word not in stop_words]

freq_dist = nltk.FreqDist(words)

print(freq_dist.most_common(10))

# 使用 scikit-learn 进行文本分类

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

X = ['This is a positive review.', 'This is a negative review.']

y = [1, 0]

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

vectorizer = TfidfVectorizer()

X_train = vectorizer.fit_transform(X_train)

X_test = vectorizer.transform(X_test)

model = LogisticRegression()

model.fit(X_train, y_train)

# 使用 TextBlob 进行情感分析

from textblob import TextBlob

text = "This is a great movie!"

blob = TextBlob(text)

print(blob.sentiment.polarity)

```

# 5. Python爬虫实战案例

### 5.1 电商网站数据爬取

#### 5.1.1 商品信息爬取

**目标:**获取电商网站上指定类目的商品信息,包括商品名称、价格、销量等。

**步骤:**

1. **获取商品列表页URL:**根据目标类目,通过搜索或分类导航获取商品列表页URL。

2. **解析商品列表页:**使用BeautifulSoup或其他解析库解析商品列表页,提取商品详情页URL。

3. **解析商品详情页:**对于每个商品详情页,提取商品名称、价格、销量等信息。

4. **存储数据:**将爬取到的商品信息存储到数据库或其他数据存储中。

**代码示例:**

```python

import requests

from bs4 import BeautifulSoup

# 获取商品列表页URL

url = 'https://www.jd.com/category/670-671-672.html'

# 解析商品列表页

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 提取商品详情页URL

product_urls = [a['href'] for a in soup.find_all('a', class_='p-name')]

# 解析商品详情页

for product_url in product_urls:

response = requests.get(product_url)

soup = BeautifulSoup(response.text, 'html.parser')

# 提取商品信息

product_name = soup.find('h1', class_='product-intro').text

product_price = soup.find('span', class_='price').text

product_sales = soup.find('span', class_='sales').text

# 存储数据

# ...

```

#### 5.1.2 评论信息爬取

**目标:**获取电商网站上指定商品的评论信息,包括评论内容、评分、作者信息等。

**步骤:**

1. **获取商品评论页URL:**根据商品详情页URL,获取商品评论页URL。

2. **解析评论页:**使用BeautifulSoup或其他解析库解析评论页,提取评论内容、评分、作者信息等。

3. **存储数据:**将爬取到的评论信息存储到数据库或其他数据存储中。

**代码示例:**

```python

# 获取商品评论页URL

comment_url = 'https://www.jd.com/comment/product/100008348778.html'

# 解析评论页

response = requests.get(comment_url)

soup = BeautifulSoup(response.text, 'html.parser')

# 提取评论信息

comments = soup.find_all('div', class_='comment-item')

for comment in comments:

comment_content = comment.find('p', class_='comment-con').text

comment_score = comment.find('span', class_='score').text

comment_author = comment.find('a', class_='user-name').text

# 存储数据

# ...

```

0

0