实时数据处理技术:Storm、Kafka与Flink的较量

发布时间: 2024-12-20 14:58:07 阅读量: 10 订阅数: 8

Flink入门:读取Kafka实时数据流,实现WordCount

# 摘要

本文全面分析了实时数据处理技术的发展和实践应用,以Apache Storm、Apache Kafka和Apache Flink为例,探讨了各技术的架构、运行时模型、数据处理机制及容错特性。文中详细解释了实时数据流处理的关键概念,如Spouts与Bolts模型、Kafka Streams、Flink的时间窗口处理,以及集群管理和部署策略。此外,本文对这些技术进行了比较分析,并考虑了它们在不同使用场景下的优势和局限性,同时探讨了集成和生态系统中所扮演的角色。最后,对实时数据处理技术的未来发展趋势进行了展望,包括新兴技术趋势、挑战以及企业级实时数据处理实践案例,旨在为行业提供实时数据处理技术的深入理解和实际应用的参考。

# 关键字

实时数据处理;Apache Storm;Apache Kafka;Apache Flink;集群管理;容错机制

参考资源链接:[(完整word版)大数据技术原理与应用-林子雨版-课后习题答案.doc](https://wenku.csdn.net/doc/6oasmag9vv?spm=1055.2635.3001.10343)

# 1. 实时数据处理技术概览

## 1.1 实时数据处理的重要性

随着互联网技术的飞速发展,数据量的爆炸性增长使得传统批处理模式已无法满足现代业务对数据处理速度的需求。实时数据处理技术应运而生,它能够对数据流进行即时分析和处理,从而快速做出决策。这不仅提升了数据使用效率,还为企业带来了更高的竞争优势。

## 1.2 实时数据处理的挑战

实时数据处理技术在为用户带来便利的同时,也面临着众多挑战。例如,如何保证数据处理的低延迟、高吞吐量,以及如何处理大规模数据的容错性和可扩展性等。这些问题的解决,直接关系到实时数据处理系统的稳定性和效能。

## 1.3 常见实时数据处理技术

目前市场上有多种实时数据处理技术,包括Apache Storm、Apache Kafka和Apache Flink等。它们各自拥有不同的特点和优势,在实时数据处理领域发挥着重要作用。在后续章节中,我们将深入探讨这些技术的理论与实践细节,以及它们在处理实时数据流中的应用。

# 2. Apache Storm的理论与实践

## 2.1 Storm基础架构分析

### 2.1.1 Storm核心组件详解

Apache Storm 是一个开源的实时计算系统,它被设计用于快速可靠地处理大量的数据流。Storm 的核心组件包括 Nimbus, Supervisor, ZooKeeper 和 Task。

- **Nimbus**: 类似于 Hadoop 中的 JobTracker,负责资源分配和任务调度。

- **Supervisor**: 类似于 Hadoop 中的 TaskTracker,负责接受工作并启动/停止工作进程。

- **ZooKeeper**: 一个高可用协调服务,用于管理集群状态。

- **Task**: 在 Worker 进程中执行实际的处理逻辑。

代码块示例和逻辑分析:

```java

// Nimbus 通过 ZooKeeper 管理集群状态

// 以下伪代码展示 Nimbus 发送心跳信息给 ZooKeeper

public void sendHeartbeat() {

// 构建心跳信息

HeartbeatInfo info = new HeartbeatInfo();

info.setWorkerId(getWorkerId());

info.setTimestamp(System.currentTimeMillis());

info.setResourceUsage(getResourceUsage());

// 发送心跳信息到 ZooKeeper

zkClient.sendHeartbeat(info);

}

```

参数说明:`workerId` 是分配给每个 Supervisor 的唯一标识符,`timestamp` 是当前时间戳,`resourceUsage` 是资源使用情况。

逻辑分析:代码块中的 `sendHeartbeat` 方法是一个周期性任务,负责向 ZooKeeper 更新当前工作节点的状态,包括 CPU 和内存的使用情况。这样可以确保 Storm 集群管理器能够及时了解集群的运行状态,并做出相应的调度决策。

### 2.1.2 Storm的容错机制和消息保证

Storm 的容错机制确保了即使发生故障,也能保证消息至少被处理一次。Storm 的消息保证机制包括:

- **At-Least-Once**: 保证每个消息至少被处理一次,但是可能会有重复处理的情况。

- **At-Most-Once**: 只确保每个消息最多被处理一次,但不保证消息一定会被处理。

- **Exactly-Once**: Storm 本身并不直接支持,需要额外的机制来实现。

表格展示容错级别:

| 容错级别 | 保证情况 | 重复处理 | 丢失消息 |

|----------|----------|----------|----------|

| At-Least-Once | 至少一次 | 可能 | 不可能 |

| At-Most-Once | 最多一次 | 不可能 | 可能 |

| Exactly-Once | 精确一次 | 不可能 | 不可能 |

在实际应用中,Storm 的容错通常是通过消息的确认机制来实现的。当一个 Tuple(消息的最小单元)被处理完成并且其后续 Tuple 也都被成功处理,系统会发送一个确认信号给消息源。如果在处理过程中发生故障,系统会重新发送 Tuple 进行处理。

代码块示例和逻辑分析:

```java

// 假设这是一个 bolt 的 execute 方法

public void execute(Tuple input) {

// 处理输入 Tuple

try {

processTuple(input);

// 发送确认信号

collector.ack(input);

} catch (Exception e) {

// 发送失败信号

collector.fail(input);

}

}

```

参数说明:`Tuple` 是需要处理的数据单元,`collector` 是用来确认和失败消息的工具类实例。

逻辑分析:在这个例子中,当处理 Tuple 成功后,`ack` 方法被调用来发送确认信号,从而防止消息被重复处理。如果处理失败(例如因为异常),则调用 `fail` 方法来确保 Tuple 能被重新发送。这个机制保证了 Storm 的容错能力。

## 2.2 Storm实时数据流处理

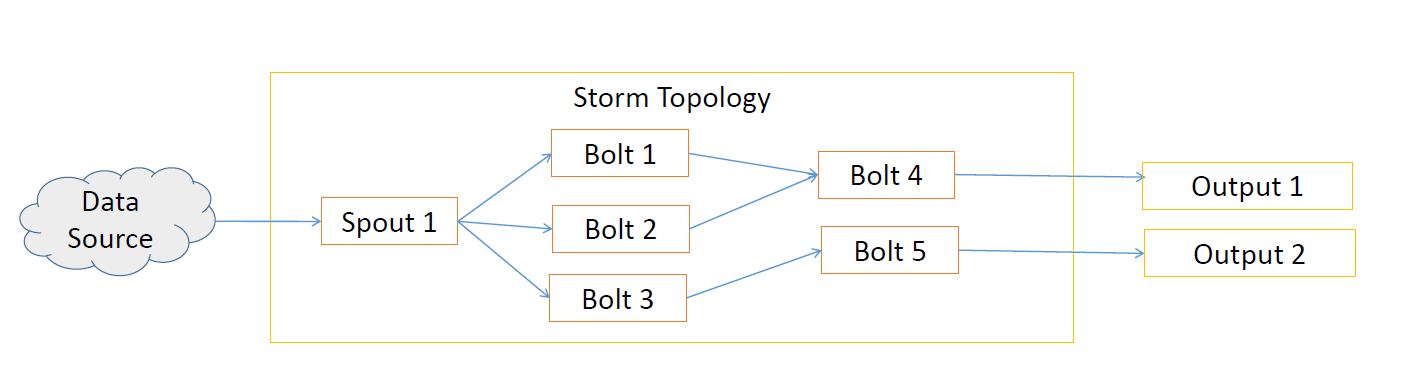

### 2.2.1 Spouts与Bolts的数据处理模型

在 Storm 中,数据处理是通过 Spouts 和 Bolts 来完成的。Spouts 负责从数据源获取数据流,而 Bolts 负责处理这些数据流。

- **Spouts**: 负责从数据源拉取数据流,它可以是一个读取消息队列的组件,也可以是一个周期性从网站爬取数据的组件。

- **Bolts**: 接收来自 Spouts 的数据流,执行各种数据处理逻辑,比如过滤、聚合、关联等。

表格展示 Spout 和 Bolt 的区别:

| 组件 | 功能 | 数据流向 |

|------|------|----------|

| Spout | 数据源的读取 | 外部系统 -> Storm |

| Bolt | 数据处理逻辑 | Spout -> Bolt |

代码块示例和逻辑分析:

```java

// 一个简单的 Spout 实现

public class RandomSentenceSpout extends BaseRichSpout {

private SpoutOutputCollector collector;

@Override

public void open(Map config, TopologyContext context, SpoutOutputCollector collector) {

this.collector = collector;

}

@Override

public void nextTuple() {

// 随机生成句子并发送

String[] sentences = { "the cow jumped over the moon", "an apple a day keeps the doctor away" };

String sentence = sentences[(int) (Math.random() * sentences.length)];

this.collector.emit(new Values(sentence));

// 休眠一段时间后再次发送

Utils.sleep(10);

}

}

```

参数说明:`collector` 用于发送数据到 Bolts。

逻辑分析:这个 Spout 每隔10毫秒生成一条随机句子并发送。`nextTuple` 方法被周期性调用来从数据源拉取数据并发送到后续的 Bolts。

### 2.2.2 实时数据处理流程详解

实时数据处理流程涉及到 Spouts 将数据推送到 Bolts,Bolts 进行数据处理,并将处理结果继续推送到其他 Bolts。这个过程在 Storm 中是一个不断循环的数据流。

流程图示例如下:

```mermaid

graph LR

S[Spout] --> B1["Bolt 1"]

B1 --> B2["Bolt 2"]

B2 --> B3["Bolt N"]

B3 --> S2[输出]

```

逻辑分析:在 Storm 中,Spout

0

0