PyTorch高效学习率调整法:优化器的终极使用手册

发布时间: 2024-12-12 07:03:28 阅读量: 9 订阅数: 16

实现SAR回波的BAQ压缩功能

# 1. PyTorch优化器基础

在深度学习中,优化器是提升模型训练效率和效果的关键组件。PyTorch,作为一种流行的深度学习框架,提供了多种优化器供研究者和开发者选择。优化器的作用在于根据损失函数的梯度来调整模型参数,以便最小化目标函数。理解PyTorch中优化器的基础知识是进行深度学习模型训练不可或缺的一步。

本章节将介绍PyTorch中常用的优化器,并对其背后的基本原理进行详细解析。我们将通过对比不同的优化器,如SGD、Adam以及RMSprop等,来理解它们各自的特点和适用场景。此外,本章还将讲解如何在PyTorch中实现这些优化器,为后续章节中更复杂的学习率调整策略打下坚实的基础。通过以下代码示例,我们将展示如何初始化一个使用SGD优化器的模型,并进行基本的参数更新操作:

```python

import torch.optim as optim

# 假设已有模型和损失函数

model = ...

criterion = ...

# 初始化优化器,选择SGD,并设置适当的超参数

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# 训练循环中的一步

optimizer.zero_grad() # 清空过往梯度

loss.backward() # 反向传播,计算梯度

optimizer.step() # 更新参数

```

通过上述代码和章节内容,我们将为读者提供一个清晰的优化器使用图景,为深入探讨学习率调整策略做好铺垫。

# 2. 理论详解:学习率调整策略

### 2.1 学习率调整的重要性

#### 2.1.1 学习率对训练的影响

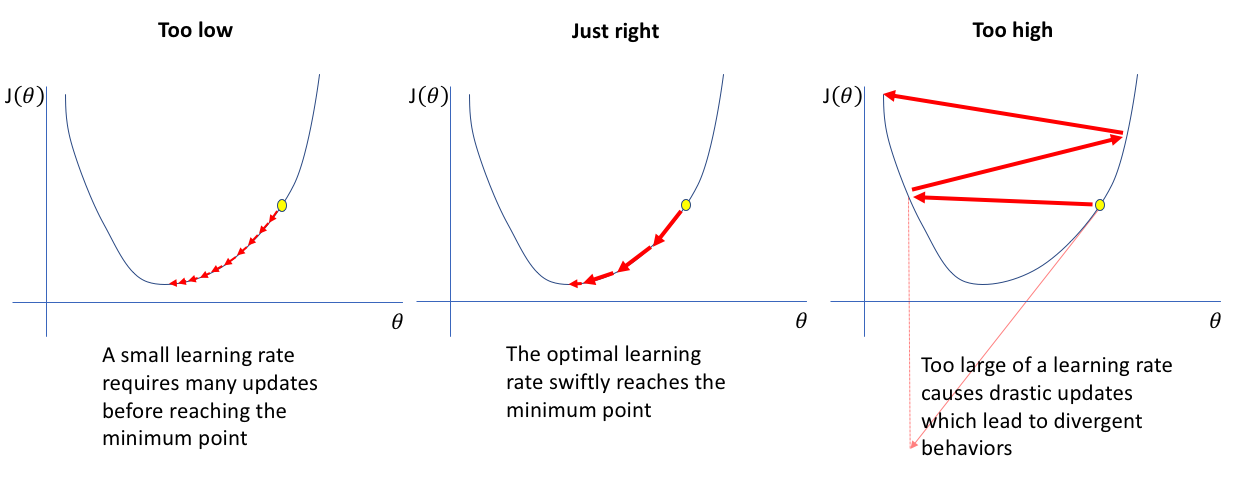

学习率是深度学习中最重要的超参数之一,它决定了在训练过程中模型参数更新的幅度。学习率过高可能导致模型无法收敛,而学习率过低则会使得训练过程过于缓慢,甚至在局部最小值附近陷入停滞。因此,合理选择学习率及其调整策略对于优化模型性能至关重要。

```mermaid

graph LR

A[开始训练] --> B[设置初始学习率]

B --> C{学习率是否合适}

C --> |是| D[训练收敛]

C --> |否| E[调整学习率]

E --> B

D --> F[完成训练]

```

在上述流程中,学习率是否设置得当直接决定了训练能否顺利进行和收敛。

#### 2.1.2 学习率的理论上限与下限

学习率的理论上限是指可以使得模型权重更新稳定的最大学习率值。超过这个值,模型的损失函数可能会开始发散,导致训练无法进行。而学习率的下限是指模型权重更新已经非常缓慢,即使再增加训练迭代次数,模型性能也几乎不再提升的最小学习率值。这个下限通常是难以准确计算的,需要通过实验来估计。

### 2.2 常用的学习率调整方法

#### 2.2.1 固定学习率法

固定学习率是最简单的学习率调整方法,即在整个训练过程中使用一个恒定的学习率。这种方法的实现非常简单,不需要额外的计算资源,但其缺点也很明显:它不能适应训练过程中损失函数的变化,往往难以达到最佳的训练效果。

#### 2.2.2 学习率衰减策略

学习率衰减策略是指随着训练的进行逐渐减小学习率的方法。这种方法通常可以在训练初期快速收敛,在后期则通过减小学习率来精细化模型参数,避免过大的更新导致模型不稳定。

一个典型的学习率衰减策略是按固定周期或按特定的损失值阈值来减少学习率。例如,可以每若干个epoch将学习率乘以一个小于1的因子(例如0.1)。

#### 2.2.3 学习率预热技术

学习率预热技术是指在训练的初期阶段逐渐增加学习率,直到达到一个预设的阈值。这种方法的目的是让模型首先在较低的学习率下稳定地进行参数更新,然后在训练过程中逐渐增加学习率,以加速收敛。

### 2.3 高级调整技术

#### 2.3.1 循环学习率策略

循环学习率策略是一种创新的学习率调整方法,它通过在一定范围内循环调整学习率来探索不同学习率下的优化效果。具体来说,学习率在每个周期内按照一定的周期性函数(如三角函数或锯齿函数)进行调整,这样可以在训练过程中多次遍历不同的学习率值,从而找到最优的训练参数。

```python

# 示例代码:循环学习率的调整

def cyclic_learning_rate(epoch, cycle, base_lr=1e-3, max_lr=1e-2):

# cycle指一个周期的迭代数

# epoch当前的训练轮数

# base_lr基学习率

# max_lr最大学习率

period = cycle * 2 # 上升和下降构成一个周期

step = (max_lr - base_lr) / period

lr = base_lr + (max_lr - base_lr) / 2 * (1 - math.cos(epoch % period / period * math.pi))

return lr

# 应用示例

current_epoch = 20

lr = cyclic_learning_rate(current_epoch, cycle=5)

print(f"Current learning rate is: {lr}")

```

#### 2.3.2 自适应学习率算法(如AdamW)

自适应学习率算法是一种通过算法自动调整每个参数的学习率的方法。例如,Adam算法结合了动量优化和RMSprop,能够为不同的参数自动调整学习率。AdamW是在Adam的基础上增加了权重衰减(weight decay)功能,使得其在训练过程中对学习率有更好的控制,因此在很多情况下比标准的Adam算法更有效。

```python

# 示例代码:AdamW优化器在PyTorch中的实现

from torch.optim import AdamW

model = ... # 定义模型

optimizer = AdamW(model.parameters(), lr=1e-3, weight_decay=1e-2)

```

通过这些章节内容的深入分析,我们了解了学习率调整策略在深度学习模型训练过程中的重要性,以及如何应用这些策略来提升模型的训练效果。后续章节将介绍在PyTorch中如何实践这些学习率调整策略,并探讨如何评估和选择最佳的调整策略。

# 3. PyTorch中的学习率调整实践

在深度学习的训练过程中,选择合适的优化器和学习率调整策略至关重要。PyTorch提供了一系列内置的学习率调整器来帮助研究者和开发者实现这一目标。这一章,我们将详细介绍如何在PyTorch中使用和自定义学习率调整策略,以及如何评估和选择最合适的策略。

## 3.1 使用PyTorch内置学习率调整器

PyTorch为学习率的调整提供了简单而强大的内置API,可以通过简单的几行代码实现常用的学习率调整策略。

### 3.1.1 StepLR和MultiStepLR的使用

`StepLR`是PyTorch中最简单的学习率衰减策略之一,每经过一定的步数(epochs),学习率就会按照预设的因子衰减。而`MultiStepLR`则是在`StepLR`的基础上,增加了在特定的epochs进行学习率衰减的功能。

```python

import torch.optim as optim

from torchvision import datasets, models, transforms

from torch.optim.lr_scheduler import StepLR, MultiStepLR

# 假设我们已经有了一个优化器optimizer

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# StepLR使用

scheduler = StepLR(optimizer, step_size=30, gamma=0.1)

for epoch in range(100):

# 训练过程

train(...)

# 更新学习率

scheduler.step()

```

在上述代码中,学习率在第30、60、90...轮结束后会衰减10倍。

### 3.1.2 ExponentialLR和CosineAnnealingLR的使用

`ExponentialLR`实现了学习率按指数衰减,而`CosineAnnealingLR`则是基于余弦退火算法,可以使得学习率在训练过程中周期性地达到最小值。

```python

scheduler = CosineAnnealingLR(optimizer, T_max=100, eta_min=1e-5)

```

在这里,`T_max`定义了学习率衰减的周期,`eta_min`定义了衰减后学习率的最小值。这两类学习率调整策略在一些任务中,如训练ResNet时,可能会带来更好的性能。

## 3.2 自定义学习率调整策略

虽然PyTorch提供了许多内置的学习率调整策略,但在面对复杂任务时,我们可能需要根据具体情况定制学习率调整逻辑。

### 3.2.1 定制周期性调整逻辑

有时候,训练过程中的某些信号可以作为学习率调整的触发条件,如损失的变化、模型输出的稳定度等。

```python

scheduler = torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda=lambda epoch: 0.95 ** epoch)

```

在这里,我们可以定义一个自定义的lambda函数来实现复杂的周期性调整。

### 3.2.2 结合外部信号的调整方法

在一些先进的训练策略中,可能会依赖于外部的监控和指导信号,如验证集上的指标,来动态调整学习率。

```python

# 假设我们有一个外部信号的函数

def external_signal_metric():

# 返回一个与模型性能相关的指标值

...

# 使用LambdaLR根据外部信号调整学习率

scheduler = torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda=lambda epoch: 1 / (1 + external_signal_metric()))

```

在这个例子中,我们根据一个外部定义的性能指标函数`external_signal_metric()`来调整学习率。

## 3.3 学习率调整策略的评估与选择

在训练深度学习模型时,评估学习率调整策略的性能至关重要。

### 3.3.1 常见评估指标和可视化

常用的学习率调整策略的评估指标包括训练损失、验证集上的准确率、损失收敛速度和模型在测试集上的表现等。

### 3.3.2 调整策略的实验比较

在选择学习率调整策略时,我们需要对不同的策略进行实验比较。基于实验数据,我们可以使用表格和图形(如学习率变化曲线、损失收敛曲线)来直观展示不同学习率调整策略的优劣。

```mermaid

graph LR

A[开始训练] --> B[固定学习率]

A --> C[StepLR]

A --> D[ExponentialLR]

B --> E[评估模型性能]

C --> E

D --> E

E --> F[比较并选择最佳策略]

```

这个流程图展示了从开始训练到选择最佳学习率调整策略的过程。

在接下来的章节中,我们将进一步深入到学习率调整与优化器的组合策略中,探讨如何进行更高级的训练优化。

# 4. 综合应用:结合优化器的深入优化

在深入学习了PyTorch中的学习率调整策略之后,我们将进入实际应用阶段,探讨如何将这些策略结合到优化器中进行更高级的模型优化。本章节将着重于实现高效的学习率调度与优化器组合,分析不同任务下的最佳实践,并构建一个系统化的学习率调整框架。

## 4.1 高效的学习率调度与优化器组合

### 4.1.1 优化器选择对学习率调整的影响

在深度学习中,不同的优化器对于学习率的敏感度不一,因此,优化器的选择直接影响学习率的调度策略。例如,SGD(随机梯度下降)通常需要较低的学习率和适当的学习率衰减,而Adam优化器由于其自适应特性,对学习率的选择可以较为宽松,甚至在一些情况下使用较大的学习率也不会导致训练过程的发散。

代码块示例:

```python

import torch.optim as optim

# SGD优化器

sgd_optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# Adam优化器

adam_optimizer = optim.Adam(model.parameters(), lr=0.001)

```

在使用这些优化器时,学习率的初始值以及学习率调度策略的选择至关重要。不同的优化器与学习率调度的组合可能会产生不同的优化效果。

### 4.1.2 调度器与优化器的协同工作

调度器与优化器的协同工作是提升模型性能的关键。一个良好的调度器能够适应学习过程中的各种变化,如模型收敛速度、梯度的稳定性等,而优化器则负责在给定的学习率下有效地更新模型参数。

代码块示例:

```python

# 使用StepLR作为学习率调度器配合SGD优化器

scheduler = optim.lr_scheduler.StepLR(sgd_optimizer, step_size=30, gamma=0.1)

# 训练循环中的调度器更新步骤

for epoch in range(num_epochs):

train_model(model, train_loader)

scheduler.step() # 更新学习率

```

上述代码展示了如何将StepLR调度器与SGD优化器结合使用。每经过30个epoch,学习率会减少到原来的1/10。这样的协同工作可以使得模型在训练初期快速收敛,随后逐步减少学习率以进行精细调整。

## 4.2 案例分析:不同任务下的最佳实践

### 4.2.1 图像分类任务的优化

图像分类任务通常使用卷积神经网络(CNN)作为基础模型。在优化这一类型的任务时,常用的策略包括:

- 使用学习率预热技术以防止训练初期模型过于敏感。

- 在训练中后期采用学习率衰减策略,如StepLR或CosineAnnealingLR。

代码块示例:

```python

# CosineAnnealingLR调度器

cosine_scheduler = optim.lr_scheduler.CosineAnnealingLR(sgd_optimizer, T_max=num_epochs, eta_min=0)

# 训练循环中的调度器更新步骤

for epoch in range(num_epochs):

train_model(model, train_loader)

cosine_scheduler.step() # 更新学习率

```

### 4.2.2 自然语言处理任务的优化

自然语言处理(NLP)任务通常利用循环神经网络(RNN)或Transformer模型。在这一类任务中,使用的学习率调度策略可以是:

- 学习率预热策略,以保证模型开始时对词汇的学习有足够的敏感性。

- 循环学习率策略,如Cyclical Learning Rate,可以进一步提高模型对复杂数据结构的适应性。

代码块示例:

```python

# 自定义循环学习率调度器

class CyclicLR:

# ...(省略具体实现细节)

# 实例化并使用CyclicLR调度器

cyclic_scheduler = CyclicLR(sgd_optimizer, base_lr=0.001, max_lr=0.1)

# 训练循环中的调度器更新步骤

for epoch in range(num_epochs):

train_model(model, train_loader)

cyclic_scheduler.step() # 更新学习率

```

### 4.2.3 强化学习任务的优化

强化学习(RL)任务通常更为复杂,需要针对不同的环境和奖励函数进行学习率的调整。策略包括:

- 结合外部信号,如奖励或性能指标,动态调整学习率。

- 在探索期使用较大的学习率,而在利用期则减小学习率。

代码块示例:

```python

# 自定义基于奖励的学习率调度器

class RewardBasedScheduler:

# ...(省略具体实现细节)

# 实例化并使用基于奖励的学习率调度器

reward_scheduler = RewardBasedScheduler(sgd_optimizer)

# 训练循环中的调度器更新步骤

for epoch in range(num_epochs):

train_model(model, train_loader)

reward_scheduler.update() # 根据外部奖励更新学习率

```

## 4.3 系统化的学习率调整框架

### 4.3.1 框架设计与实现

一个系统化的学习率调整框架应该能够适应不同的模型训练需求,同时提供灵活的接口来实现各种学习率调整策略。框架的设计应包括以下几个核心组件:

- **调度策略管理器**:负责管理不同的学习率调度策略,并提供接口供外部调用。

- **优化器适配器**:适配不同的优化器,使得学习率调度策略能够与之协同工作。

- **监控与回调机制**:实时监控模型训练状态,并在特定条件触发时进行学习率的调整。

### 4.3.2 框架在实际项目中的应用

在实际项目中应用学习率调整框架,需要遵循以下步骤:

1. **模型和数据准备**:首先确定模型架构和数据处理流程。

2. **优化器选择**:根据模型特点选择合适的优化器。

3. **调度策略选择与配置**:基于任务特性和模型训练状态选择适当的学习率调度策略,并进行配置。

4. **训练与评估**:开始训练模型,并使用验证集评估模型性能,同时监控学习率的调整效果。

表格示例:

| 任务类型 | 适用模型 | 优化器推荐 | 学习率调度策略 |

|----------|----------|-------------|----------------|

| 图像分类 | CNN | SGD或Adam | StepLR/CosineAnnealingLR |

| NLP | RNN/Transformer | AdamW | CyclicLR |

| 强化学习 | RL算法 | Adam或RMSprop | 奖励驱动的自定义策略 |

以上是一个简化的框架应用示例表格,实际应用时还需要根据具体情况调整细节。通过这种方式,可以使得学习率调整更加系统化和高效化,同时降低调整过程的复杂性。

在完成以上章节的撰写后,本章节会涉及内容的深入和应用的展示。通过对学习率调度与优化器组合的案例分析,我们不仅能够理解在不同任务下如何选择合适的学习率调整策略,还能掌握如何设计和实现一个系统化的学习率调整框架,并在实际项目中应用该框架,以达到提升模型训练效果的目的。

# 5. 学习率调整的自动化

## 5.1 自动学习率调整技术概述

### 5.1.1 自动调整方法的历史与现状

学习率调整技术从最初的固定学习率,到现在的自适应学习率算法,已经经历了多次演进。早期的研究集中于梯度下降算法的基本变种,如SGD。随后,人们意识到学习率的重要性,从而开发出了学习率衰减策略,以防止在训练过程中过早地陷入局部最小值。

随着深度学习的发展,自适应学习率算法如Adam、RMSprop等应运而生。这些算法通过调节学习率,以解决不同参数更新的步长问题。此外,研究者开始尝试自动化学习率调整,如使用学习曲线分析、在线学习率调整、以及利用梯度信息来动态调整学习率。

目前,自动学习率调整技术已经逐渐成为提高深度学习模型性能的有效工具。一些框架和库,比如PyTorch的`torch.optim.lr_scheduler`,已经内置了多种学习率调度器,甚至出现了专门针对自动学习率调整的库如Optuna等。

### 5.1.2 自动调整技术的优势与局限

自动学习率调整技术的优势在于它减少了模型训练过程中的手动干预,使得研究人员能够更加专注于模型结构和算法设计。此外,自动化技术有助于发现更优的学习率策略,从而提高模型的最终性能。

然而,现有的自动调整技术也存在局限性。例如,自动化方法可能需要大量的实验来搜索最优的学习率,这个过程可能耗时且计算资源消耗巨大。另外,自动化方法可能在某些特定任务上不如手动调整的学习率有效,尤其是在面对非标准数据集或者复杂的模型结构时。

## 5.2 从手动到自动的演进路径

### 5.2.1 半自动学习率调整方法

半自动学习率调整方法结合了手动调整和自动调整的优势。在此类方法中,研究人员通常会设置一个学习率范围,并使用自动化算法在该范围内进行学习率的微调。半自动方法的关键在于使用某种自动化策略来缩小可能的学习率范围,并加速找到最佳学习率的过程。

举个例子,研究者可以使用简单的网格搜索来确定合适的学习率区间,随后利用基于梯度的自适应调整算法在该区间内搜索更精确的学习率。这样的方法虽然减少了搜索空间,但仍需要对学习率调整有基本的理解和预判。

### 5.2.2 全自动学习率调整技术

全自动学习率调整技术旨在完全自动化选择学习率的过程,无需研究者进行任何手动干预。一些流行的自动化框架,如Optuna和Ray Tune,利用贝叶斯优化、进化算法等高级技术自动寻找最优的学习率和优化器配置。

全自动方法可以显著减少模型训练所需的时间和资源,但在实践中也面临一些挑战。例如,自动化技术可能在非常大的参数空间中进行优化,这会导致搜索过程变得非常缓慢。此外,全自动方法的性能依赖于训练任务和数据集的特性,可能需要特定的配置以实现最佳效果。

## 5.3 自动学习率调整的挑战与展望

### 5.3.1 当前技术的不足与改进方向

当前的自动学习率调整技术虽然在很多方面表现优异,但在某些情况下仍存在不足。比如,在大规模数据集或者复杂模型中,自动化方法可能无法有效收敛,或者需要非常长的时间才能找到合适的参数。

为了改进这些不足,未来的研究可能集中在开发更高效的算法来减少搜索时间,提高模型的收敛速度和最终性能。这可能涉及到结合多种学习率调整策略,以及使用更先进的机器学习技术来指导搜索过程。

### 5.3.2 未来趋势与可能的研究方向

未来自动学习率调整技术的一个关键趋势是个性化和自适应策略的发展。这意味着算法将能够根据训练数据的特性、模型的复杂度以及训练任务的类型,自动选择最合适的调整方法。

此外,研究者也在探索将学习率调整与其他超参数优化方法相结合,实现更全面的模型自动调整。例如,结合神经架构搜索(NAS)和超参数优化,以寻找最优的模型架构和训练策略。这些努力有助于构建更强大、更智能的深度学习训练系统,进一步推动AI技术的进步。

0

0