【判别分析详解】:Applied Multivariate Statistical Analysis 6E习题的专业应用

发布时间: 2024-12-28 03:55:40 阅读量: 7 订阅数: 9

Applied Multivariate Statistical Analysis 6E【课后习题答案】.pdf

# 摘要

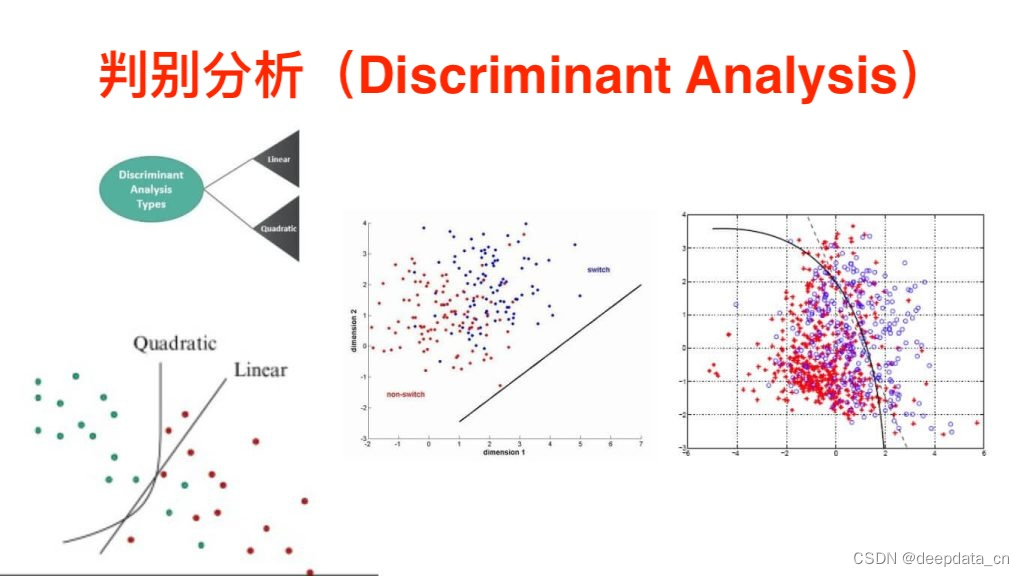

判别分析作为一种统计分类技术,在数据挖掘和模式识别领域中发挥着重要作用。本文首先概述了判别分析的理论基础和统计方法,包括线性判别分析(LDA)及其应用案例、基于距离和概率的判别方法。继而在第三章深入探讨了判别分析在实际问题中的应用,如市场营销和医学诊断,同时涉及了数据预处理、特征选择和结果评估的技术细节。文章最后探讨了多类判别分析、判别分析与机器学习集成,以及最新的优化和创新方法,旨在为读者提供判别分析的全方位理解和应用指导。

# 关键字

判别分析;统计分类;线性判别分析;概率模型;数据预处理;机器学习集成

参考资源链接:[Applied Multivariate Statistical Analysis 6E【课后习题答案】.pdf](https://wenku.csdn.net/doc/646077715928463033adfd77?spm=1055.2635.3001.10343)

# 1. 判别分析的理论基础

判别分析是一种统计分类技术,旨在通过已知类别的样本建立分类规则,从而对未知类别样本进行分类预测。在数据分析领域,这一技术扮演着至关重要的角色,尤其是在处理需要分类决策的复杂数据集时。判别分析的基本假设是不同类别的样本具有不同的均值向量,且各类别数据的协方差矩阵相同或相似。根据这些假设,判别函数被用来最大化类间距离和最小化类内距离,从而实现对样本的有效分类。

## 1.1 统计分类的基本原理

在判别分析中,统计分类的基本原理是构建一个或多个判别函数,这些函数可以是线性的或者是非线性的。线性判别函数通常以线性组合的方式将特征空间中的点映射到一个值,根据这个值来决定样本的类别。而构建这些函数的过程需要依据历史数据中的模式,即已经标记的样本点。

## 1.2 判别分析与机器学习的关系

尽管判别分析早于现代机器学习的发展,但它与机器学习中的分类算法有着紧密的联系。判别分析提供了一个理论框架,强调了不同类别数据特征的统计差异,这为后续的机器学习分类模型,如支持向量机(SVM)和神经网络,提供了理论基础。在实际应用中,判别分析经常被用于初步的数据分析和模型构建阶段,以帮助确定哪些特征对于分类任务最为重要。

# 2. 判别分析的统计方法

### 2.1 线性判别分析(LDA)

#### 2.1.1 LDA的基本概念和计算原理

线性判别分析(Linear Discriminant Analysis,LDA)是一种经典的统计方法,用于在给定类别标签的情况下,寻找能够最佳区分这些类别的特征线性组合。LDA的目标是最大化类别间距离与类别内距离之比,以达到分类的目的。

计算原理上,LDA通过以下步骤实现:

1. 计算每一类的均值向量。

2. 计算类内散度矩阵(Within-class Scatter Matrix),也称为协方差矩阵。

3. 计算类间散度矩阵(Between-class Scatter Matrix)。

4. 解决广义特征值问题,找到使得类间散度矩阵和类内散度矩阵之比最大的线性变换。

5. 使用得到的线性变换对数据进行降维。

这种方法假设数据在每一个类别内服从高斯分布,且不同类别具有相同的协方差矩阵。

```math

S_B = \sum_{i=1}^{c} n_i (\mu_i - \mu) (\mu_i - \mu)^T

S_W = \sum_{i=1}^{c} \sum_{x \in X_i} (x - \mu_i)(x - \mu_i)^T

```

其中,`S_B` 是类间散度矩阵,`S_W` 是类内散度矩阵,`n_i` 是第`i`类的样本数,`μ_i` 是第`i`类的均值向量,`μ` 是所有样本的均值向量,`X_i` 是第`i`类的样本集合,`c` 是类别的数量。

在Python中,使用`sklearn`的`LinearDiscriminantAnalysis`类可以直接进行LDA操作。下面是一个简单的例子:

```python

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 创建并拟合LDA模型

lda = LinearDiscriminantAnalysis(n_components=2) # 降维至2维

lda.fit(X, y)

```

在上面的代码中,`n_components` 参数定义了降维后的维数。通过`fit`方法,我们训练了LDA模型,并且可以根据模型进行数据的转换。

#### 2.1.2 LDA在不同领域的应用案例

LDA不仅在理论研究中有其重要地位,在工业界也广泛应用于各类问题。举几个典型应用案例:

1. **金融领域**:在信用评分中,LDA可以帮助银行区分不同信用等级的客户群体,通过分析客户的历史信用数据来预测其违约概率。

2. **生物信息学**:在基因表达数据分析中,LDA被用于识别基因表达谱中的特征,以发现潜在的癌症标志物。

3. **文本挖掘**:LDA常被用于主题建模中,例如,在文档聚类中,通过LDA可以识别出隐含的主题信息,从而用于文档分类。

在每个案例中,LDA的核心功能都是相同的:在保留类别间区分度的同时减少数据的维度,最终帮助我们更好地理解和分类数据。不同的应用领域对LDA算法进行了适当的调整以适应特定的业务需求和数据特性。

### 2.2 基于距离的判别分析

#### 2.2.1 距离度量方法的选择和原理

基于距离的判别分析方法依赖于度量数据点之间的相似性或距离。最常用的距离度量方法包括欧氏距离、曼哈顿距离和切比雪夫距离等。选择合适的距离度量方法对于分析的结果有重大影响。

- **欧氏距离(Euclidean Distance)**:两点之间直线距离,是最直观的距离度量方法。

```math

d(\textbf{p}, \textbf{q}) = \sqrt{\sum_{i=1}^{n} (p_i - q_i)^2}

```

- **曼哈顿距离(Manhattan Distance)**:两点之间沿坐标轴的绝对轴距总和。

```math

d(\textbf{p}, \textbf{q}) = \sum_{i=1}^{n} |p_i - q_i|

```

- **切比雪夫距离(Chebyshev Distance)**:在数值上等于两点在各坐标轴上差值的最大值。

```math

d(\textbf{p}, \textbf{q}) = \max_i |p_i - q_i|

```

选择距离度量时需要考虑数据的特性,例如数据的尺度、形状以及数据中的异常点。不同距离度量对于异常点的敏感程度不同,因此选择合适的距离度量可以提高分类的准确性和鲁棒性。

下面的Python代码展示了如何使用sklearn中的不同距离度量进行k-近邻分类:

```python

from sklearn.neighbors import KNeighborsClassifier

from sklearn import datasets

# 加载数据集

iris = datasets.load_iris()

X, y = iris.data, iris.target

# 创建KNN分类器

knn = KNeighborsClassifier(n_neighbors=5, metric='minkowski', p=2)

# 使用欧氏距离进行拟合

knn.fit(X, y)

```

在上述代码中,`metric` 参数可以设置为多种距离度量方法,例如 'euclidean', 'manhattan', 'chebyshev' 等,而 `p` 参数在使用闵可夫斯基距离时用于控制距离计算的方式。

#### 2.2.2 距离判别方法的实践操作

实践中,距离判别方法的一个常见例子是k-最近邻算法(k-Nearest Neighbors,k-NN),这是一个非常直观的分类方法,其核心思想是基于这样一个假设:相似的数据点往往属于同一类别。该方法的关键在于找到测试点最近的k个点,并根据这些最近邻点的类别信息来决定测试点的类别。

- **分类决策**:通过多数投票原则来决定测试点的类别。

- **距离度量**:确定距离计算的方法,如前面所述。

- **k值选择**:选择合适的k值,过小的k值可能导致过拟合,而过大的k值可能导致欠拟合。

在Python中,`KNeighborsClassifier`类在`sklearn`库中提供了k-NN的实现,下面是一个使用k-NN进行分类的简单例子:

```python

from sklearn.neighbors import KNeighborsClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report, accuracy_score

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

# 创建k-NN分类器实例,这里选择k=5

knn = KNeighborsClassifier(n_neighbors=5)

# 训练模型

knn.fit(X_train, y_train)

# 预测测试集

y_pred = knn.predict(X_test)

# 评估模型

print(classification_report(y_test, y_pred))

print("Accuracy:", accuracy_score(y_test, y_pred))

```

通过上述代码,我们首先导入了必要的库和数据集,然后将数据集分为训练集和测试集。我们创建了一个k-NN分类器,并使用训练集数据对其进行训练。最后,我们用训练好的模型对测试集数据进行预测,并输出分类报告和准确率来评估模型性能。

### 2.3 基于概率的判别分析

#### 2.3.1 贝叶斯判别原理及其应用

贝叶斯判别分析是建立在贝叶斯理论基础之上的一种统计方法。其核心思想是利用贝叶斯公式,在已知一部分信息的情况下,计算一个未知参数的条件概率分布,这个过程通常被称为贝叶斯推断。

贝叶斯判别方法的计算公式如下:

```math

P(C_i|X) = \frac{P(X|C_i)P(C_i)}{P(X)}

```

其中,`P(C_i|X)` 表示给定观测数据X的条件下,数据属于类别`C_i`的概率;`P(X|

0

0