【MapReduce容错机制详解】:确保数据正确聚合的7大策略

发布时间: 2024-10-30 23:39:34 阅读量: 59 订阅数: 29

2021最新直播系统+短视频源码+教程+演示APP+开发文档+IOS与安卓源码

# 1. MapReduce容错机制概述

MapReduce作为大数据处理领域的重要框架,其容错机制确保了处理过程的高可靠性。任何大规模数据处理系统中,容错都是一个核心问题,尤其是在处理海量数据时,系统的某个部分失败几乎是不可避免的。MapReduce通过一系列策略,例如数据副本、任务监控和重计算等,保证了数据处理任务在发生故障时能够自动恢复并继续执行,从而提高了系统的稳定性和可用性。本章将概述MapReduce的容错机制,为后续深入讨论奠定基础。

# 2. MapReduce容错机制的基本理论

MapReduce是大数据处理中的一个核心框架,它允许用户通过定义Map和Reduce两个函数来处理大规模数据集。为了实现高可靠性,MapReduce框架具备了复杂的容错机制。这些机制确保在大规模分布式计算过程中,即使某些计算节点发生故障,整个作业也能够完成。

## 2.1 MapReduce的工作原理

### 2.1.1 MapReduce框架的基本组件

MapReduce框架主要由四个基本组件构成:JobTracker、TaskTracker、Job和Task。

- **JobTracker**:负责作业的调度和管理,包括任务分配、监控和容错处理。

- **TaskTracker**:在每个节点上运行,负责执行由JobTracker分配的Task,并向JobTracker报告状态。

- **Job**:用户提交给MapReduce框架的作业,一个Job包含输入数据、Map函数、Reduce函数和输出数据。

- **Task**:Job的子任务,分为Map Task和Reduce Task。Task是实际在数据上执行操作的基本单元。

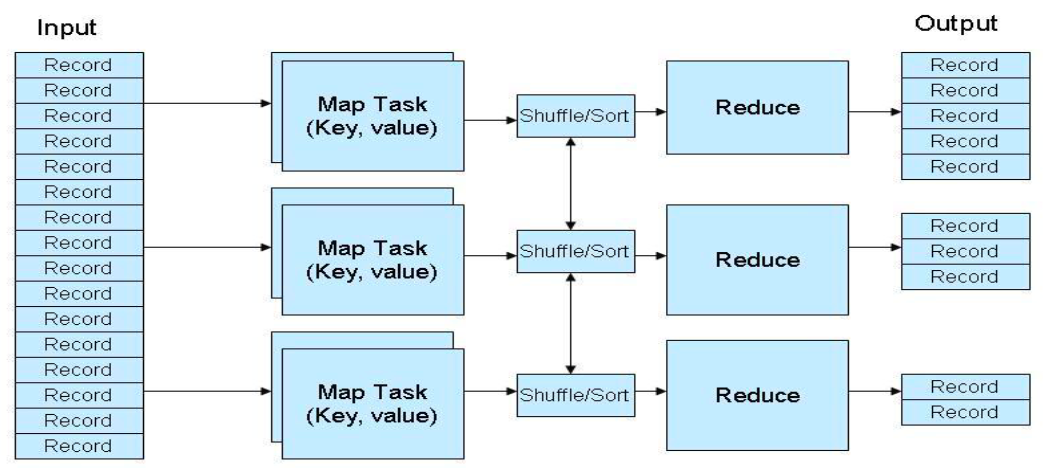

### 2.1.2 数据处理流程与任务划分

数据处理流程如下:

1. **输入数据读取**:MapReduce从HDFS(Hadoop Distributed File System)读取输入文件。

2. **Map阶段**:输入文件被切分为固定大小的数据块(默认为64MB)。每个数据块由Map任务并行处理。

3. **Shuffle阶段**:Map任务的输出(中间键值对)经过排序和分组,为Reduce阶段做准备。

4. **Reduce阶段**:Shuffle后的中间数据被分发给Reduce任务,并最终输出到HDFS。

Map阶段可以并行执行,提高处理速度,而Reduce阶段则依赖于Map的输出。

## 2.2 MapReduce容错机制的重要性

### 2.2.1 容错机制在大数据处理中的作用

大数据处理的一个核心挑战是保证作业在出现硬件故障或软件错误时仍能够顺利完成。MapReduce框架通过以下方式实现:

- **数据副本**:数据块通常存储多个副本,以防节点故障导致数据丢失。

- **任务失败自动重试**:MapReduce框架会监控TaskTracker和Task的状态,一旦发现任务失败,会自动在其他节点重新调度。

- **作业恢复**:框架能够从失败中恢复,继续完成未完成的Map和Reduce任务。

### 2.2.2 容错与系统稳定性的关联

MapReduce的容错机制对于系统的稳定性至关重要。系统稳定性体现在两个方面:

- **任务调度策略**:包括资源动态调度和负载均衡,确保任务高效执行。

- **故障检测与恢复**:快速检测节点故障,并立即启动恢复流程,减少停机时间。

容错机制不仅保证了作业的顺利完成,也提高了整个系统的可用性和可靠性,为大规模分布式计算提供了稳定的运行环境。

在下一章中,我们将深入探讨MapReduce的容错策略,包括数据副本机制、重计算策略和心跳与状态监控技术。

# 3. MapReduce的容错策略详解

## 3.1 数据副本机制

### 3.1.1 副本策略的设计原理

数据副本机制是MapReduce框架中用以提高容错能力的核心策略之一。其基本思想是通过在不同节点存储数据的多个副本,以防止数据丢失或损坏导致计算失败。副本机制的设计原理涉及以下几个关键点:

- **可靠性与成本的平衡**:副本数量越多,系统可靠性越高,但同时会占用更多的存储资源和带宽,增加成本。

- **副本放置策略**:副本应该放置在不同的节点、机架,甚至不同的数据中心,以对抗节点故障和区域性故障。

- **一致性与可用性的权衡**:副本间保持一致性会增加通信和同步开销,而过于放松一致性要求则可能影响计算的准确性。

### 3.1.2 副本数量与性能平衡

副本数量的确定是一个需要权衡系统可靠性、存储成本与读写性能的问题。设计副本策略时,通常需要考虑以下因素:

- **数据访问频率**:访问频率高的数据应当有更多副本以提高读取性能。

- **存储成本**:副本数量越多,对存储资源的需求越大,成本越高。

- **故障模式**:不同类型的故障(如硬盘故障、网络故障、数据中心故障等)应该通过副本策略加以防护。

通常,在实践中选择三副本策略是一种常见折衷方案。该策略能够满足大多数业务场景下对容错性的需求,同时不会过多增加成本和复杂性。

```markdown

| 副本数量 | 可用性 | 故障恢复时间 |

```

0

0