【Python迭代器技巧全解析】:itertools模块带你深入数据处理世界(终极指南)

发布时间: 2024-10-02 15:25:43 阅读量: 47 订阅数: 5

Python迭代器模块itertools使用原理解析

# 1. Python迭代器基础与概念

Python作为一门高级编程语言,在数据处理和算法设计领域具有广泛的应用。迭代器作为Python的核心概念之一,在实现数据的高效遍历和处理中扮演着重要角色。本章将带你深入理解迭代器的基本概念,探讨其在Python中的实现机制,并展示如何通过迭代器进行基本的数据操作。

## 1.1 迭代器与可迭代对象

在Python中,迭代器(iterator)是一个实现了迭代器协议的对象,包含两个主要方法:`__iter__()` 和 `__next__()`。`__iter__()` 方法返回迭代器对象本身,而 `__next__()` 方法返回序列的下一个元素。可迭代对象(iterable)则是包含 `__iter__()` 方法的对象,能够通过迭代器逐一访问其元素。典型的可迭代对象包括列表(list)、字典(dict)、字符串(str)等。

```python

# 示例代码:使用迭代器遍历列表

my_list = [1, 2, 3, 4, 5]

iterator = iter(my_list)

while True:

try:

element = next(iterator)

print(element)

except StopIteration:

break

```

## 1.2 迭代器的优势

使用迭代器的优势在于它能够以一种延迟计算(lazy evaluation)的方式逐个产生元素,这意味着在迭代过程中不需要将所有元素一次性加载到内存中。这种特性对于处理大型数据集特别有用,能够显著减少内存使用,提高程序的性能和效率。

## 1.3 迭代器的应用场景

迭代器广泛应用于数据处理、文件读取、网络通信等领域。在这些场景中,迭代器允许我们以一种可控且资源消耗小的方式来处理数据流。例如,在处理日志文件时,逐行读取和处理文件可以使用迭代器来避免一次性将整个文件加载到内存中。

```python

# 示例代码:逐行读取文件

with open('example.log', 'r') as ***

***

***

```

通过上述示例,我们可以看到迭代器在实际应用中的直观表现,下一章节我们将进一步探索itertools模块的高级用法,揭示迭代器在数据处理中的更深层潜力。

# 2. 深入理解itertools模块

## 2.1 itertools模块的基本组成

### 2.1.1 创建无限迭代器

Python的`itertools`模块提供了创建无限迭代器的工具,这些迭代器在执行时可以连续生成数据,直到被外部强制停止或达到某个终止条件。在很多情况下,无限迭代器可以帮助我们处理连续的数据流。

例如,`count(start=0, step=1)`函数会从一个起始值开始,以固定的步长持续生成一个无限的整数序列。这个迭代器会一直工作,直到你手动停止它。

下面是一个`count`的使用示例:

```python

import itertools

# 创建从10开始的无限计数迭代器

counter = itertools.count(10, 2)

# 迭代前5个值

for _ in range(5):

print(next(counter))

```

执行逻辑说明:

- `itertools.count(10, 2)` 创建了一个从10开始,每次增加2的无限迭代器。

- `for _ in range(5)` 循环了5次,每次循环中通过`next(counter)`取出迭代器的下一个值并打印。

### 2.1.2 创建终止迭代器

与无限迭代器相对的是终止迭代器,它在执行时会生成有限的序列。在某些场景下,我们可能需要对一组数据进行处理,但又不希望迭代器无限制地执行下去。此时,终止迭代器就显得特别有用。

例如,`cycle(iterable)`函数会创建一个无限重复某个可迭代对象内容的迭代器,但是我们可以通过控制迭代次数来终止迭代过程。

下面是一个`cycle`的使用示例:

```python

import itertools

# 创建无限循环迭代器

repeater = itertools.cycle(['do', 're', 'mi'])

# 迭代前8个值

for _ in range(8):

print(next(repeater))

```

执行逻辑说明:

- `itertools.cycle(['do', 're', 'mi'])` 创建了一个无限循环迭代器。

- `for _ in range(8)` 循环了8次,每次循环中通过`next(repeater)`取出迭代器的下一个值并打印。

## 2.2 itertools模块的组合工具

### 2.2.1 排列组合的生成

在数据分析、数学计算以及算法设计中,经常需要生成排列和组合。`itertools`模块提供了几种工具函数来处理这些场景。

`permutations(iterable, r=None)`函数会生成所有可能的排列,而`combinations(iterable, r)`函数则生成所有可能的组合。它们都是从给定的可迭代对象中生成特定长度的序列。

下面是一个`permutations`和`combinations`的使用示例:

```python

import itertools

# 创建字符串列表

elements = ['a', 'b', 'c']

# 生成所有长度为2的排列

print(list(itertools.permutations(elements, 2)))

# 生成所有长度为2的组合

print(list(***binations(elements, 2)))

```

执行逻辑说明:

- `itertools.permutations(elements, 2)`生成所有可能的长度为2的排列。

- `***binations(elements, 2)`生成所有可能的长度为2的组合。

输出结果:

```

[('a', 'b'), ('a', 'c'), ('b', 'a'), ('b', 'c'), ('c', 'a'), ('c', 'b')]

[('a', 'b'), ('a', 'c'), ('b', 'c')]

```

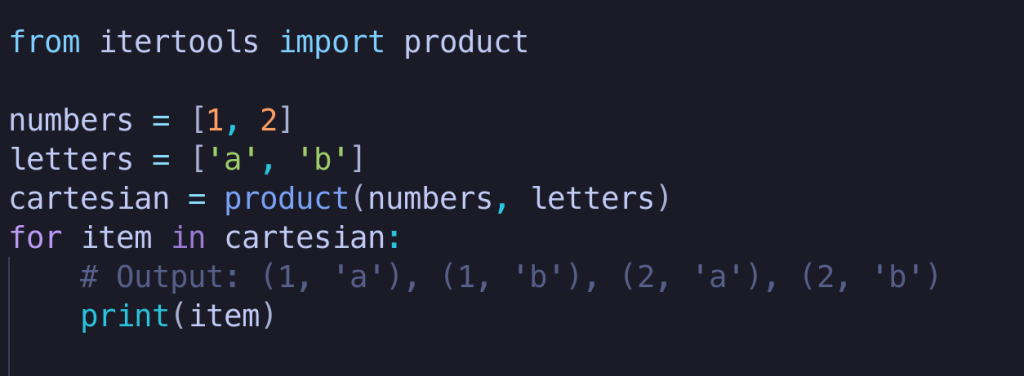

### 2.2.2 产品迭代与笛卡尔积

当需要从多个集合中选择元素,并将这些元素的所有可能组合都生成时,可以使用`itertools.product(*iterables, repeat=1)`函数。它实际上实现了笛卡尔积。

下面是一个`product`的使用示例:

```python

import itertools

# 创建两个列表

colors = ['red', 'green', 'blue']

fruits = ['apple', 'banana', 'cherry']

# 生成所有可能的颜色与水果的组合

color_fruits = list(itertools.product(colors, fruits))

print(color_fruits)

```

执行逻辑说明:

- `itertools.product(colors, fruits)`函数生成了两个列表中所有可能的颜色与水果的组合。

- `list()`函数将生成的迭代器转换成列表以便打印查看。

输出结果:

```

[('red', 'apple'), ('red', 'banana'), ('red', 'cherry'), ('green', 'apple'), ('green', 'banana'), ('green', 'cherry'), ('blue', 'apple'), ('blue', 'banana'), ('blue', 'cherry')]

```

## 2.3 itertools模块的过滤工具

### 2.3.1 过滤函数与条件筛选

`itertools`模块中的`filterfalse(predicate, iterable)`函数提供了一种过滤功能,但与内置的`filter()`函数不同,`filterfalse()`会保留那些使得`predicate`返回False的元素。

使用此函数时,可以通过传递一个返回布尔值的函数或一个布尔值,来控制哪些元素应该被过滤掉。

下面是一个`filterfalse`的使用示例:

```python

import itertools

# 创建一个数字列表

numbers = range(-5, 5)

# 定义一个函数,用于过滤掉正数

def filter_positive(x):

return x > 0

# 使用filterfalse过滤正数

negative_numbers = list(itertools.filterfalse(filter_positive, numbers))

print(negative_numbers)

```

执行逻辑说明:

- `itertools.filterfalse(filter_positive, numbers)`用于过滤掉列表中的正数。

- `filter_positive`函数用于检测元素是否大于0,返回False的会被加入到最终列表中。

输出结果:

```

[-5, -4, -3, -2, -1]

```

### 2.3.2 筛选和分割数据集

在数据处理中,经常需要按照某些条件将数据分割成不同的组。`itertools`中的`takewhile(predicate, iterable)`和`dropwhile(predicate, iterable)`函数可以实现这样的需求。`takewhile`会持续从迭代器中取出元素,直到条件不再满足;而`dropwhile`则会丢弃直到条件满足为止的所有元素,之后开始取出元素。

下面是一个`takewhile`和`dropwhile`的使用示例:

```python

import itertools

# 创建一个数字列表

numbers = range(-5, 5)

# 定义一个函数,用于检测元素是否为负数

def is_negative(x):

return x < 0

# 使用takewhile获取负数

negative_numbers_takewhile = list(itertools.takewhile(is_negative, numbers))

# 使用dropwhile跳过负数

non_negative_numbers_dropwhile = list(itertools.dropwhile(is_negative, numbers))

print(f"Negative numbers (takewhile): {negative_numbers_takewhile}")

print(f"Non-negative numbers (dropwhile): {non_negative_numbers_dropwhile}")

```

执行逻辑说明:

- `itertools.takewhile(is_negative, numbers)`将返回列表中所有的负数,直到遇到第一个非负数。

- `itertools.dropwhile(is_negative, numbers)`会跳过所有负数,并返回第一个非负数之后的所有元素。

输出结果:

```

Negative numbers (takewhile): [-5, -4, -3, -2, -1]

Non-negative numbers (dropwhile): [0, 1, 2, 3, 4]

```

通过这些示例,我们可以看出`itertools`模块为处理迭代器提供了丰富的方法,无论是生成数据序列、还是对数据进行复杂的筛选和组合,都可以通过该模块实现简洁高效的代码编写。这些工具函数不仅逻辑清晰,而且执行效率高,是进行数据处理和算法设计时不可或缺的一部分。

# 3. itertools在数据处理中的应用

## 3.1 复杂数据结构的迭代

### 3.1.1 多维数组与嵌套迭代

在处理复杂的数据结构时,例如多维数组,传统的循环方法可能变得笨重且难以维护。迭代器提供了嵌套迭代的能力,这对于多维数据结构的遍历尤其有用。使用`itertools`模块中的`chain`和`product`函数可以创建组合迭代器,方便地遍历多维数据。

例如,考虑一个三维数组的迭代,可以使用嵌套的`chain`函数将多个迭代器链接起来,实现对所有元素的连续访问。

```python

import itertools

# 假设有一个三维数组

array_3d = [[[1, 2], [3, 4]], [[5, 6], [7, 8]]]

# 使用itertools.chain将三维数组转换为一维迭代器

chain_iter = itertools.chain(*itertools.chain(*array_3d))

# 输出元素

for element in chain_iter:

print(element)

```

该代码块将三维数组转换为一维迭代器,实现了元素的连续访问。`*`操作符用于解包嵌套数组。

### 3.1.2 字典与集合的迭代方法

字典和集合是Python中非常常用的数据结构,它们提供了内置的方法来直接迭代。不过,有时需要以特定的顺序或模式来访问这些数据结构的元素。`itertools`模块提供了多种工具,以便更好地控制迭代过程。

例如,对于字典,可以使用`itertools.chain`来迭代键和值。

```python

import itertools

# 假设有一个字典

my_dict = {'a': 1, 'b': 2, 'c': 3}

# 使用itertools.chain迭代字典的键和值

keys = my_dict.keys()

values = my_dict.values()

chain_iter = itertools.chain(keys, values)

# 输出元素

for element in chain_iter:

print(element)

```

在处理集合时,可能需要获取集合的所有可能的子集。`***binations`函数可以帮助我们完成这个任务。

```python

import itertools

# 假设有一个集合

my_set = {1, 2, 3}

# 使用***binations获取所有可能的子集

subsets = [subset for r in range(len(my_set) + 1) ***binations(my_set, r)]

# 输出所有子集

for subset in subsets:

print(subset)

```

这段代码使用列表推导式结合`***binations`生成从空集到包含所有元素的集合的所有子集。

## 3.2 数据预处理与清洗

### 3.2.1 数据缺失值处理

在数据处理中,数据预处理是一个重要的步骤,其中处理缺失值是一个常见任务。`itertools`模块可以帮助我们在迭代过程中有效地识别和处理缺失值。

考虑以下包含缺失值的数据集:

```python

import numpy as np

# 假设有一个包含缺失值的数据集

data = np.array([1, np.nan, 3, 4, np.nan, 6])

```

我们可以使用`itertools.filterfalse`函数过滤出数据中的非缺失值。

```python

from itertools import filterfalse

import numpy as np

filtered_data = list(filterfalse(np.isnan, data))

# 输出过滤后的数据

print(filtered_data)

```

代码中使用`filterfalse`函数配合`numpy.isnan`方法过滤掉数据中的NaN值,得到一个没有缺失值的数据集。

### 3.2.2 数据标准化与归一化

数据标准化与归一化是数据预处理中的重要环节,它们能够帮助模型更好地学习数据特征。`itertools`可以帮助我们在迭代过程中进行数据的转换。

对于标准化处理,我们可以通过迭代计算每个数值的均值和标准差,然后将每个数值标准化为均值为0,标准差为1的数据。

```python

import numpy as np

from itertools import starmap, tee

# 假设有一个数据集

data = np.array([1, 2, 3, 4, 5])

# 计算均值和标准差的函数

def mean_std(values):

mean = sum(values) / len(values)

std = np.sqrt(sum((x - mean) ** 2 for x in values) / len(values))

return mean, std

# 复制迭代器以重复使用

data_iter, data_iter_copy = tee(data)

# 计算均值和标准差

mean, std = mean_std(data_iter)

# 迭代标准化数据

normalized_data = starmap(lambda x, m, s: (x - m) / s, zip(data_iter_copy, repeat(mean), repeat(std)))

# 输出标准化后的数据

print(list(normalized_data))

```

这里使用了`starmap`函数,它对数据集中的每个元素应用给定的函数,并利用`tee`函数复制迭代器,以便在计算均值和标准差时重复使用数据集。

## 3.3 高级数据处理技巧

### 3.3.1 数据聚合与分组

数据聚合与分组是数据分析和处理中经常需要执行的操作。使用`itertools`可以创建高度定制化的分组和聚合操作。

以一个简单的分组聚合为例,假设我们有一个包含重复元素的列表,我们想要根据某些标准对它们进行分组。

```python

from itertools import groupby

# 假设有一个列表

data = ['apple', 'banana', 'apple', 'orange', 'banana', 'apple']

# 按元素分组

grouped_data = groupby(data)

# 输出分组结果

for key, group in grouped_data:

print(key, list(group))

```

`groupby`函数是基于连续相同的元素进行分组,因此排序是一个关键步骤,以确保分组按照预期工作。

### 3.3.2 基于迭代器的内存优化

在处理大型数据集时,内存消耗可能成为一个问题。迭代器的一个主要优点是它们是惰性的,意味着它们只在需要时才生成值,这有助于内存管理。

例如,使用`itertools.count`和`itertools.takewhile`可以创建一个无限的迭代器,它根据特定的条件进行元素生成,只有当条件满足时才进行迭代。

```python

from itertools import count, takewhile

# 创建一个无限迭代器

counter = count(start=100)

# 只取前10个大于100的数

first_ten = takewhile(lambda x: x < 200, counter)

# 输出元素

for element in first_ten:

print(element)

```

在这个例子中,`count`创建了一个从100开始的无限迭代器,而`takewhile`则根据提供的函数从迭代器中取出元素,直到条件不再满足(在这个例子中是数字小于200)。

以上章节内容展示了如何在实际的数据处理场景中应用`itertools`模块来提高效率和质量。通过结合itertools的高级迭代工具和数据结构,我们能够处理更加复杂的数据问题,同时保持代码的简洁和可读性。接下来的章节将继续深入,介绍`itertools`在与其它Python模块协同工作时的强大能力。

# 4. itertools与其他Python模块的协同

itertools模块以其高效和强大的迭代功能,在Python编程中占据着重要地位。它不仅可以独立使用,还能与其他模块如numpy、pandas和multiprocessing协同工作,实现更复杂的迭代和计算任务。在本章中,我们将深入探讨itertools如何与这些模块结合,以及如何将它们有效地应用于数据处理和并行计算中。

## 4.1 使用itertools与numpy加速计算

numpy是Python中用于科学计算的核心库,提供了高性能的多维数组对象和相关工具。itertools与numpy的结合可以实现矩阵操作的迭代和统计分析的高效执行。

### 4.1.1 矩阵操作与迭代器

在数据分析和数值计算中,矩阵操作是核心组成部分。numpy的ndarray对象支持高效的矩阵运算,但结合itertools,我们可以利用迭代器来创建和处理更为复杂的矩阵序列。

```python

import numpy as np

import itertools

# 创建一个3x3的矩阵

matrix = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 使用itertools.product生成矩阵中所有元素的笛卡尔积

cartesian_product = list(itertools.product(matrix, repeat=2))

# 输出笛卡尔积结果

print(cartesian_product)

```

在上述代码中,`itertools.product`函数生成了一个矩阵中所有元素的笛卡尔积。这在某些特定的数值分析任务中非常有用,如机器学习特征交叉生成或统计学中的配对样本分析。

### 4.1.2 统计分析与itertools

在进行统计分析时,itertools可以用来生成样本空间、组合和排列,这些通常是统计学中进行假设检验和随机变量分析的基础。

```python

from itertools import combinations

# 定义一个数据序列

data = [1, 2, 3, 4, 5]

# 生成所有可能的三元组合

combinations_of_three = list(combinations(data, 3))

# 输出所有组合

print(combinations_of_three)

```

这段代码创建了一个序列中所有可能的三元组合。在实际应用中,这可以用于生成所有可能的实验条件组合,以确定哪些变量对结果有显著影响。

## 4.2 使用itertools与pandas处理数据集

pandas是Python中最流行的用于数据分析和操作的库之一。itertools与pandas的结合可以用于迭代数据帧(DataFrame)和处理时间序列数据。

### 4.2.1 数据帧的迭代与处理

在pandas中处理数据时,经常会需要对数据帧进行迭代操作。itertools可以帮助我们创建更复杂的数据迭代模式,特别是在处理大型数据帧时。

```python

import pandas as pd

from itertools import islice

# 创建一个示例数据帧

df = pd.DataFrame({'A': range(10), 'B': range(10, 20)})

# 使用islice进行数据帧的分块迭代

for chunk in islice(df, 0, None, 2):

print(chunk)

```

在这段代码中,`islice`函数用于分块迭代数据帧。这对于分批处理大量数据,或者在数据处理任务中实现内存优化非常有用。

### 4.2.2 时间序列数据的迭代应用

时间序列数据在金融、气象、经济等领域非常重要。itertools与pandas结合,可以实现对时间序列数据的高效迭代处理。

```python

import pandas as pd

from itertools import accumulate

# 创建一个时间序列数据帧

dates = pd.date_range('***', periods=10)

data = range(10)

ts = pd.Series(data, index=dates)

# 使用itertools.accumulate计算累积和

cumulative_sum = list(accumulate(ts))

# 输出累积和结果

print(cumulative_sum)

```

上述代码使用`itertools.accumulate`来计算时间序列的累积和。这对于分析数据的累积趋势和变化非常有用。

## 4.3 使用itertools进行并行计算

并行计算是提高计算效率的重要手段。itertools可以与Python的`multiprocessing`模块结合,实现迭代数据的共享和分布式迭代计算。

### 4.3.1 进程间迭代数据的共享

为了在多个进程中共享迭代数据,可以使用`multiprocessing`模块创建的共享数据结构,如`Value`和`Array`。

```python

from multiprocessing import Process, Value

import itertools

def increment_counter(counter):

for i in range(10):

counter.value += 1

return counter.value

if __name__ == '__main__':

counter = Value('i', 0) # 创建一个共享的整数变量

processes = []

for i in range(10):

p = Process(target=increment_counter, args=(counter,))

processes.append(p)

p.start()

for p in processes:

p.join()

print('Final counter value:', counter.value)

```

在以上示例中,`increment_counter`函数在一个进程中被调用,用于递增共享变量`counter`。这演示了如何在多个进程间共享和迭代处理数据。

### 4.3.2 分布式迭代与计算

分布式迭代通常涉及到网络通信和数据分区。itertools可以在本地或远程的计算节点之间有效地迭代和处理数据。

```python

from multiprocessing.dummy import Pool as ThreadPool

import itertools

def process_element(element):

return element * 2 # 一个简单的数据处理函数

if __name__ == '__main__':

data = range(100)

pool = ThreadPool(10) # 创建一个拥有10个线程的线程池

# 使用线程池并行处理数据

results = pool.map(process_element, data)

print(results)

```

在这个例子中,使用`ThreadPool`来并行处理数据,这使得数据处理速度加快,尤其是在涉及大量的独立计算任务时。

在下一章中,我们将进一步探讨itertools在实际项目中的应用案例,以及如何在项目中构建复杂的业务逻辑和进行性能优化。

# 5. itertools在实际项目中的案例分析

## 5.1 实现高效的数据管道

迭代器在数据管道中扮演着至关重要的角色。数据管道通常指的是一系列的数据处理步骤,每一个步骤处理完数据后,将其输出到下一个步骤,直至完成整个数据处理过程。在Python中,可以使用itertools来高效实现数据管道,特别是在处理大规模数据集时,其内存效率和性能优势尤为明显。

### 5.1.1 数据流处理技巧

数据流的处理技巧关键在于如何设计一个清晰、高效的数据流程。在设计数据管道时,需要考虑到数据处理的顺序性、数据流的可控性以及性能的最优化。itertools模块提供了多个工具函数和生成器,可以用来创建数据流处理过程中的各种组件。

下面是一个使用`itertools.count()`和`itertools.takewhile()`组合的示例,演示如何实现一个简单的数据流处理:

```python

import itertools

# 无限数据流生成器

def data_stream():

for i in itertools.count(1):

yield i

# 数据流处理函数,例如过滤出小于10的数字

def process_stream(stream):

for data in stream:

if data >= 10:

break

yield data * data

# 使用生成器表达式创建数据管道

data_pipeline = (data * 2 for data in process_stream(data_stream()))

# 输出前几个数据项

for item in itertools.islice(data_pipeline, 5):

print(item)

```

在上述代码中,`data_stream`函数是一个无限的整数生成器,而`process_stream`函数则是一个数据处理函数,它过滤并处理了传入的数据流。`data_pipeline`通过生成器表达式,创建了一个新的数据管道,实现了数据的二次处理。

### 5.1.2 大数据集的迭代处理策略

当处理大数据集时,关键是要减少内存的使用和提高处理速度。一个有效的策略是使用`itertools.chain()`来组合多个数据源或者数据块,这样可以减少内存中同时存在的数据量。下面的代码演示了一个处理大数据集的迭代处理策略:

```python

import itertools

# 假设我们有多个大型数据文件

file_names = ['large_data_file_1.csv', 'large_data_file_2.csv', 'large_data_file_3.csv']

# 读取数据的生成器函数

def read_large_files(file_names):

for file_name in file_names:

with open(file_name, 'r') as ***

***

***

* 使用itertools.chain()将多个文件的内容“链式”处理

data_chain = itertools.chain(*[read_large_files([file]) for file in file_names])

# 数据处理函数,例如清洗和转换

def process_large_data(data_chain):

for line in data_chain:

# 进行数据清洗和转换

yield transform(line)

# 将处理后的数据写入新的文件或进行下一步处理

for processed_data in process_large_data(data_chain):

write_to_output(processed_data)

```

在这个例子中,`read_large_files`函数使用生成器来逐行读取文件内容,从而减少了内存的占用。`itertools.chain()`用于将多个文件生成器的输出串联起来,形成一个连续的数据流。这样,我们就可以在不一次性加载所有数据的情况下,对整个数据集进行处理。

## 5.2 构建复杂的业务逻辑

在构建复杂的业务逻辑时,迭代器模式能帮助我们设计出易于扩展、维护的代码结构。在业务逻辑中,我们常常需要在不同的操作之间,根据条件进行分支处理,或者在一系列操作完成后进行汇总。

### 5.2.1 工作流程中迭代器的使用

迭代器模式在工作流程中的应用,能够让我们清晰地定义数据的处理步骤,并且在需要时轻松地添加或修改步骤。使用迭代器来构建工作流程的代码示例如下:

```python

import itertools

# 定义一个工作流程,其中包含多个数据处理步骤

def process_data(data_iterator):

for data in data_iterator:

# 第一步:数据预处理

preprocessed_data = preprocess(data)

# 第二步:业务逻辑处理

business_data = apply_business_logic(preprocessed_data)

# 第三步:结果输出

yield business_data

def preprocess(data):

# 数据预处理的具体实现

return data.upper()

def apply_business_logic(data):

# 业务逻辑处理的具体实现

return data + ' - logic applied'

# 创建一个包含数据的迭代器

data_iterator = itertools.repeat('input_data', 5)

# 创建数据处理流程

data_pipeline = process_data(data_iterator)

# 获取处理结果

for result in data_pipeline:

print(result)

```

通过定义`process_data`函数,我们可以根据业务需求,不断地扩展数据处理的步骤。每个步骤都使用迭代器来接收和传递数据,这不仅提高了代码的可读性,还增强了其灵活性。

### 5.2.2 事件驱动与迭代器模式

事件驱动编程是一种常见的设计模式,特别适合于事件驱动型应用或复杂交互系统的实现。在事件驱动模型中,迭代器可以用来处理和传输事件数据。这可以帮助我们在不同的事件处理环节之间,平滑地传递数据和状态。

```python

import itertools

# 定义事件处理器

def event_handler(event_iterator):

for event in event_iterator:

# 事件类型检查

if event['type'] == 'data_event':

# 处理数据事件

yield handle_data_event(event)

elif event['type'] == 'control_event':

# 处理控制事件

yield handle_control_event(event)

# 定义事件处理函数

def handle_data_event(event):

# 数据事件的处理逻辑

return event['data']

def handle_control_event(event):

# 控制事件的处理逻辑

return 'Control event handled.'

# 创建事件源

event_source = [

{'type': 'data_event', 'data': 'event_data_1'},

{'type': 'control_event', 'data': 'control_data'},

]

# 创建事件迭代器并启动事件处理流程

event_iterator = (event for event in event_source)

for result in event_handler(event_iterator):

print(result)

```

在该示例中,我们定义了一个事件源和一个事件处理器。事件处理器根据事件的类型,来决定如何处理事件。迭代器用于遍历事件源,并按顺序处理每一个事件。

## 5.3 性能优化实例

性能优化是软件开发中不可或缺的一环,特别是对于计算密集型和数据密集型任务。使用itertools,我们可以发现并实现多种优化策略来提升程序的效率。

### 5.3.1 常见性能瓶颈与解决方案

在实际的项目开发中,常见的性能瓶颈包括数据处理速度慢、内存使用过多、程序响应时间长等问题。itertools提供了一些工具函数,比如`itertools.izip()`和`itertools.islice()`,这些函数能够在处理迭代器时提供更高的效率。

```python

import itertools

# 假设我们有一个大数据集,存储在大列表中

large_data = list(range(1000000))

# 使用列表推导式进行数据处理

data_list_comprehension = [x * 2 for x in large_data]

# 使用itertools.izip()进行数据处理

data_iterzip = itertools.izip(large_data, large_data)

data_iterzip_processed = (x * 2 for x in data_iterzip)

# 使用islice快速跳过或获取一部分数据

data_slice = itertools.islice(large_data, 50000, 100000)

# 对于内存密集型的处理,我们可以使用生成器表达式

def process_large_data(data):

for item in data:

yield item * 2

# 对于计算密集型任务,使用并行计算

import multiprocessing

def parallel_process(data):

pool = multiprocessing.Pool(processes=4)

return pool.map(double_data, data)

def double_data(data):

return data * 2

# 并行处理示例

large_data_parallel = parallel_process(large_data)

```

在这个性能优化的例子中,我们展示了如何使用itertools来改进数据处理的性能,并且结合了Python的`multiprocessing`模块来实现数据的并行计算。

### 5.3.2 利用itertools提升算法效率

有时候,我们可以利用itertools来优化算法的结构,特别是当算法涉及到组合、排列、笛卡尔积等操作时。例如,如果我们需要计算一个大数据集的笛卡尔积,可以使用`itertools.product()`来实现,这样可以避免创建巨大的中间数据结构,从而节省内存。

```python

import itertools

# 定义两个迭代器,代表两组数据

iter1 = itertools.repeat(1, 1000)

iter2 = itertools.repeat(2, 1000)

# 计算两个迭代器的笛卡尔积

cartesian_product = itertools.product(iter1, iter2)

# 输出笛卡尔积的前10项

for item in itertools.islice(cartesian_product, 10):

print(item)

```

在这个例子中,`itertools.product()`计算了两个重复迭代器的笛卡尔积,但并没有一次性地将所有组合存储到内存中,从而实现了内存使用的优化。

通过以上案例分析,我们可以看到itertools如何在不同场景中提供高效的解决方案。在实际项目中,合理利用itertools及其相关工具,可以显著提升数据处理的效率和程序的性能。

# 6. Python迭代器技巧的未来展望

随着Python语言的不断进化,迭代器作为其核心概念之一,也在不断地更新和扩展。在这一章节中,我们将探讨迭代器的新特性,社区和开源项目对迭代器的贡献,以及未来学习迭代器技巧的路径和资源。

## 6.1 新版本迭代器的更新与特性

Python在新版本的发布中不断完善迭代器协议,并引入了新的迭代工具,为开发者提供了更多的便利性和性能优势。

### 6.1.1 迭代器协议的改进

从Python 3.3开始,PEP 380引入了子生成器的概念,允许在生成器内部使用`yield from`语句来简化对其他生成器的调用。到了Python 3.6,PEP 525提出了异步生成器和异步迭代器的概念,为异步编程提供了迭代器支持。

```python

async def read_file_async(file):

async with open(file, 'r') as f:

while True:

line = await f.readline()

if not line:

break

yield line

```

上面的代码展示了如何使用异步生成器来异步读取文件内容,每个`yield`暂停当前生成器,直到下一个`for`循环请求新的元素。

### 6.1.2 新型迭代工具的引入

Python 3.4引入了`asyncio`模块,这是用于编写单线程并发代码的库,其中包含了各种异步迭代工具。`as_completed`函数可以异步迭代Future对象的集合,这对于处理并发任务的完成情况非常有用。

```python

import asyncio

async def fetch_data(url):

# 模拟耗时的网络请求操作

await asyncio.sleep(1)

return url

async def main():

urls = ['***', '***', '***']

tasks = [asyncio.create_task(fetch_data(url)) for url in urls]

for task in asyncio.as_completed(tasks):

print(await task)

asyncio.run(main())

```

在上述示例中,`asyncio.as_completed`用于迭代Future对象,并在它们完成时立即提供结果,这对于网络请求等异步操作尤其高效。

## 6.2 社区与开源对迭代器的支持

Python社区和开源项目在迭代器的使用和扩展上有着显著的贡献,不少项目提供了解决实际问题的迭代工具。

### 6.2.1 开源项目中的迭代器应用案例

例如,`scikit-learn`库中的数据管道(`Pipeline`)就是一种应用迭代器的优秀案例。它允许将多个数据处理和模型训练步骤串联起来,形成一个可迭代的处理流。

```python

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

pipeline = Pipeline([

('scaler', StandardScaler()),

('classifier', LogisticRegression()),

])

pipeline.fit(X_train, y_train)

```

在上述代码中,`Pipeline`对象可以像迭代器一样被迭代,实现数据的逐步处理和模型的逐步训练。

### 6.2.2 社区驱动的迭代器扩展功能

社区开发者通过PEP(Python Enhancement Proposals)和提交代码到GitHub等平台,不断地推动Python迭代器功能的扩展。例如,PEP 498 "Literal String Interpolation" 引入了格式化字符串字面量(f-string),简化了字符串中变量的插入和格式化操作。

```python

name = "Alice"

greeting = f"Hello, {name}!"

```

这里的`f-string`是迭代器和字符串格式化结合的典型应用,使代码更加简洁易读。

## 6.3 迭代器技巧的学习资源和路径

学习迭代器并不是一朝一夕的事情,需要系统地学习和实践。以下是一些学习资源和路径的建议。

### 6.3.1 在线教程与文档

Python官方文档对于迭代器有详细的介绍,包括基本概念和内置函数的使用。此外,各种在线教育平台如RealPython、Kaggle和Coursera提供了大量与迭代器相关的教程和课程。

### 6.3.2 代码库与项目实战

GitHub是Python开发者的天堂,通过阅读和理解开源项目中的迭代器用法,可以极大地提升实践能力。比如,参与`numpy`、`pandas`等项目的代码贡献,能有效学习迭代器在高性能计算中的应用。

在这个信息爆炸的时代,持续学习和实践是掌握迭代器技巧不可或缺的两个方面。无论是通过在线资源的学习,还是通过参与社区和开源项目的实战,都能帮助开发者深刻理解迭代器的精髓,并将其应用于解决实际问题中。

在下一节中,我们将继续探讨Python迭代器的未来趋势,以及如何在未来的编程实践中发挥迭代器的最大价值。

0

0