聚类分析深度解读:数据挖掘中的策略与技巧

发布时间: 2025-01-06 09:36:08 阅读量: 14 订阅数: 13

深度解析:数据分析的奥秘

# 摘要

聚类分析作为数据挖掘的重要分支,广泛应用于市场细分、生物信息学、社交网络分析等多个领域。本文首先概述了聚类分析的基本概念,随后详细探讨了各类聚类算法的理论基础,包括距离度量方法、基本聚类类型以及评价标准。进一步,本文提出了聚类分析的高级技巧,比如特征选择、高维数据的处理以及大规模数据集的应对策略。针对聚类分析的实际应用,文中列举了市场细分、生物学以及社交网络分析等案例。最后,文章展望了聚类分析的未来趋势,涵盖对非欧几里得数据结构的处理、聚类算法自动化选择与调整,以及提升算法的解释性和可解释性。

# 关键字

聚类分析;距离度量;K-Means;高维数据;特征选择;自动化聚类;解释性

参考资源链接:[数据挖掘概念与技术第三版课后习题答案解析](https://wenku.csdn.net/doc/2qs4paq2n0?spm=1055.2635.3001.10343)

# 1. 聚类分析概述

聚类分析,作为数据挖掘的核心技术之一,它致力于将数据中的样本或对象按照相似性分组成多个类别。这一过程无需预先给定样本的类别信息,是典型的无监督学习方法。聚类在市场分析、生物信息学、社交网络分析等多个领域有着广泛的应用。掌握聚类分析不仅可以帮助我们更好地理解数据的内在结构,还可以挖掘出数据中潜在的、有用的信息和模式。通过对数据进行合理的分组,可以为决策提供依据,为后续的数据分析与应用打下坚实的基础。聚类方法的多样性和灵活性让它成为处理复杂数据问题的一个有力工具。

# 2. 聚类算法的理论基础

## 2.1 距离度量与相似性

### 2.1.1 距离度量的概念与重要性

距离度量是聚类分析中的一个核心概念,其目的在于量化数据点之间的相似性或差异性。通常在几何空间中,数据点可以被看作是n维空间中的一个点,而距离度量则用于计算这些点之间的距离。这种距离度量对于定义和区分数据点所属的簇是至关重要的。

距离度量在聚类中的重要性体现在以下几个方面:

1. **识别簇内密度**:通过距离度量,我们可以识别出数据点之间的紧密程度,这直接关系到簇内数据点的密度。簇内密度较高表明聚类效果较好,即簇内数据点相似度高,差异性小。

2. **确定簇的边界**:通过分析数据点之间的距离,可以更精确地确定簇的边界。簇边界是簇与簇之间区别的关键,良好的距离度量有助于在边界处提供清晰的划分。

3. **影响聚类算法的性能**:不同的距离度量方法会影响聚类算法的最终结果。选择合适的距离度量能够提高算法的准确性和效率。

### 2.1.2 常见的距离度量方法

在聚类分析中,存在多种距离度量方法。以下是一些最常用的距离度量方法:

- **欧几里得距离(Euclidean Distance)**:

欧几里得距离是最常见的度量方式,它直接对应于空间几何中的直线距离。对于两个点$x = (x_1, x_2, ..., x_n)$和$y = (y_1, y_2, ..., y_n)$,其欧几里得距离计算公式如下:

```math

d(x, y) = \sqrt{\sum_{i=1}^{n} (x_i - y_i)^2}

```

欧几里得距离对数值的变化非常敏感,特别是在特征值范围差异较大的数据集中表现尤为明显。

- **曼哈顿距离(Manhattan Distance)**:

曼哈顿距离是计算点在标准坐标系上的绝对轴距总和。对于两个点$x = (x_1, x_2, ..., x_n)$和$y = (y_1, y_2, ..., y_n)$,其曼哈顿距离计算公式如下:

```math

d(x, y) = \sum_{i=1}^{n} |x_i - y_i|

```

曼哈顿距离对于小的测量误差不如欧几里得距离敏感,且在某些情况下计算效率更高。

- **余弦相似性(Cosine Similarity)**:

余弦相似性用于衡量两个向量的夹角,通常用于文本数据。其值表示两个非零向量的夹角的余弦值,取值范围在[-1, 1]。余弦相似性计算公式如下:

```math

\text{similarity} = \frac{x \cdot y}{||x|| \times ||y||} = \frac{\sum_{i=1}^{n} x_i y_i}{\sqrt{\sum_{i=1}^{n} x_i^2} \times \sqrt{\sum_{i=1}^{n} y_i^2}}

```

当两个向量的夹角越小,其余弦值越接近1,表示两个向量在方向上越相似。

## 2.2 聚类算法的基本类型

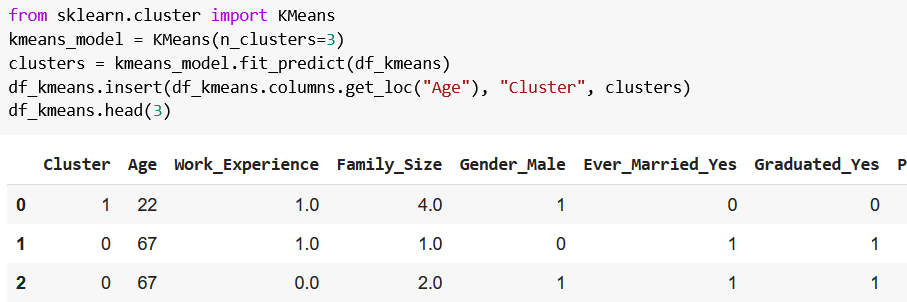

### 2.2.1 划分方法:K-Means算法

K-Means算法是一种划分方法,旨在将数据集分为K个簇,使得每个数据点都属于离它最近的簇中心。K-Means算法简洁且效率高,非常适合于大规模数据的聚类分析。

K-Means算法的基本步骤如下:

1. **选择初始簇中心**:随机选择K个数据点作为初始的簇中心。

2. **分配数据点**:对于数据集中的每一个数据点,根据其与各簇中心的距离,将点分配到最近的簇中心所代表的簇中。

3. **更新簇中心**:对于每个簇,重新计算簇内所有点的均值作为新的簇中心。

4. **迭代**:重复步骤2和步骤3,直到簇中心不再变化或达到预先设定的迭代次数。

K-Means算法的关键在于选择合适的K值,这通常通过肘部法则等方法来确定。K-Means算法的一个局限是它对初始簇中心的选择非常敏感,且假设簇是凸形且大小相似的。

### 2.2.2 层次方法:AGNES和DIANA

层次方法通过构建一个层次的簇树(称为树状图)来组织数据点。在树状图中,簇是通过合并或分裂的方式逐步构建出来的,不需要预先指定簇的数量K。

层次聚类包含两种主要策略:

- **AGNES (AGglomerative NESting)**:自下而上合并策略。初始时,每个数据点都是一个独立的簇。然后算法逐步合并那些距离最近的簇,直至达到所需的簇数或满足停止条件。

- **DIANA (DIvisive ANAlysis)**:自上而下分裂策略。最开始将所有数据点视为一个簇,然后逐步分裂簇中的数据点,直至达到所需的簇数或满足停止条件。

层次聚类的主要优点是可以得到数据点之间的关系层次结构,这在数据探索和可视化方面特别有用。不过,层次聚类的计算复杂度较高,特别是对于大规模数据集来说,计算代价较大。

### 2.2.3 密度方法:DBSCAN和OPTICS

基于密度的聚类算法不会假设簇的形状和大小,它们通过寻找高密度区域来定义簇。与K-Means等划分方法不同,基于密度的方法能够在噪声数据存在的情况下获得更为精确的簇边界。

DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种流行的基于密度的聚类算法。DBSCAN算法主要依赖两个参数:邻域半径ε和最小点数MinPts。它将簇定义为在ε

0

0