【MIKE模型数据管理】:确保模拟准确性的4个关键步骤

发布时间: 2025-01-09 16:48:19 阅读量: 23 订阅数: 34

MIKE Zero网格生成器在水流与波浪模拟中的应用

# 摘要

本文全面介绍了MIKE模型数据管理的关键方面,涵盖了从数据收集、整合到存储、备份以及处理和分析的全过程。强调了有效的数据管理在提升模型模拟准确性方面的重要性,并探讨了各种数据管理策略和实践。文中详细阐述了数据收集的不同方法论,数据整合过程中的清洗、融合、标准化和验证策略,以及数据存储架构和备份策略的选择。通过对数据预处理和分析方法的讨论,本文指出了如何通过优化数据质量管理来提高模型模拟的准确性,并强调了持续改进数据管理流程的必要性。最后,分享了一些MIKE模型数据管理的最佳实践。

# 关键字

MIKE模型;数据管理;数据收集;数据整合;数据备份;模拟准确性;统计分析;数据挖掘

参考资源链接:[MIKE水质培训教程.doc](https://wenku.csdn.net/doc/3cyktsqp9y?spm=1055.2635.3001.10343)

# 1. MIKE模型数据管理概述

数据管理是任何组织维持业务连续性的基础。在复杂的数据生态系统中,MIKE模型提供了一种数据管理的方法论,它不仅优化数据流,而且提升了数据的利用效率和准确性。本章节将重点介绍MIKE模型的基本概念,其如何将数据转化为可操作的见解,并讨论在数据管理中面对的挑战及如何克服。

## 1.1 数据管理的重要性

随着信息技术的飞速发展,数据管理已经从单纯的记录保存转变为涉及数据的存储、处理、分析、安全性和合规性等多个层面的综合活动。数据质量直接关系到企业的决策质量,有效管理的数据能够推动业务的增长和创新。

## 1.2 MIKE模型的定义

MIKE模型,即“管理信息和知识生态系统”模型,是一个整合了数据管理最佳实践的框架。它不仅关注数据本身,更注重数据流动的过程,确保数据在正确的时间、正确的地点以正确的格式提供给需要的人员。

## 1.3 数据管理面临的挑战

数据管理面临着众多挑战,包括数据量的激增、数据异构性、数据安全及隐私问题、数据质量控制等。要克服这些挑战,组织需要建立起完备的数据治理结构,并不断更新技术,来适应日新月异的技术环境和市场要求。

# 2. 数据收集与整合

## 2.1 数据收集方法论

### 2.1.1 传统数据来源与采集技术

在信息时代以前,数据收集主要依赖于纸质记录、邮寄调查问卷、电话采访以及通过政府公布的统计数据等方式。虽然现在数字化已经成为主流,但是这些传统方式仍然在某些特定场景下发挥着作用。例如,对于某些人口稀少的地区或者特定人群的调查研究,传统的数据收集方法依然是重要手段。

传统数据来源的一个主要特点是数据的准确性和可靠性相对较高。由于涉及到人工收集和录入,原始数据的错误率可以得到有效控制。例如,邮寄问卷调查通过严格的邮寄地址筛选和人工分拣来确保问卷的回收率,电话采访则通过训练有素的采访人员来保证问题的正确提出与记录。

### 2.1.2 现代数据来源与采集技术

随着技术的发展,我们见证了数据来源的爆发式增长。现代数据来源包括但不限于传感器数据、社交媒体数据、网络日志、移动设备数据等。这些数据来源主要通过自动化技术进行采集,能够提供规模大、速度高的数据流。

现代数据采集技术的关键在于如何高效地处理这种高频率和大数据量的数据。比如,物联网(IoT)设备可以实时采集环境数据并将其传送到云端,而社交媒体平台则可以使用爬虫技术自动化地抓取用户生成的内容。这些技术不仅大大提高了数据采集的速度,也使得数据分析能够更加接近实时决策。

## 2.2 数据整合策略

### 2.2.1 数据清洗与预处理

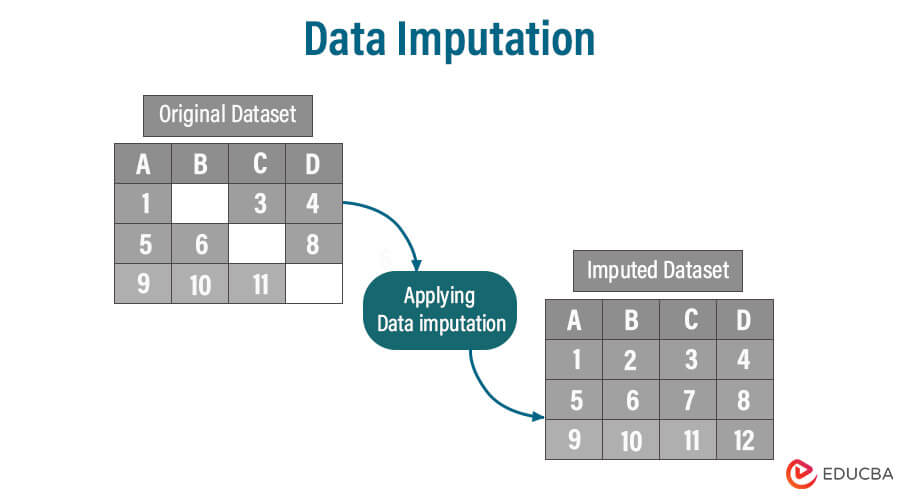

在数据整合的第一阶段,数据清洗与预处理是必不可少的。数据清洗的目标是识别和纠正(或删除)数据集中的错误和不一致,确保数据质量。常见的数据清洗步骤包括处理缺失值、去除重复记录、纠正拼写错误以及格式化日期和数字。

数据清洗通常涉及到大量的数据操作,因此需要使用像Python中的Pandas库来实现高效的数据处理。Pandas提供了丰富的数据结构和操作函数,可以方便地对数据进行清洗、筛选、合并等操作。例如,使用`dropna()`函数可以去除数据中的缺失值,而`duplicated()`函数则用于检测和删除重复的记录。

### 2.2.2 数据融合与转换

在数据清洗之后,接下来是数据融合与转换。数据融合是指将来自不同数据源的数据合并到一起的过程。由于不同数据源的结构和语义可能不一致,因此这一阶段的关键是数据转换,即把各种格式的数据转换为统一格式。

数据转换常常涉及到数据类型转换、数据规范化和数据合并等操作。比如,在SQL数据库中,我们可能需要使用`CAST`或`CONVERT`语句将一列的数据类型从字符串转换为日期类型。在Python中,可以使用Pandas的`astype()`函数对数据类型进行转换。数据融合时,经常需要使用到`join()`或`merge()`等函数来合并不同数据集。

### 2.2.3 数据标准化与验证

在数据整合的最后阶段,数据标准化与验证是保证数据一致性的关键步骤。数据标准化是指将数据转化为通用格式,以利于比较和进一步处理。验证则是确保数据符合规定的格式、范围、类型等要求。

数据标准化的一个常见例子是对地址进行格式化,确保所有的地址数据遵循同样的格式。在Python中,可以使用正则表达式对地址进行匹配和转换。验证数据则可能涉及到更复杂的逻辑,比如检查邮政编码是否符合相应的城市规范。

数据整合是一个系统工程,不同来源的数据需要通过清洗、融合、标准化等一系列环节,才能被有效地整合到一起。下面的表格和代码块,将更详细地说明数据整合的具体实施步骤和注意事项。

# 3. 数据存储与备份

数据存储与备份是确保数据安全性和可恢复性的关键环节。在本章中,我们将深入探讨数据存储解决方案,以及如何制定有效的备份和灾难恢复计划。

## 3.1 数据存储解决方案

### 3.1.1 数据库管理系统选择

选择合适的数据库管理系统(DBMS)是实现高效数据存储的基础。在众多的数据库管理系统中,我们需要根据数据类型、访问模式、性能要求和成本效益比来做出选择。

**关系型数据库** 如 MySQL, PostgreSQL, SQL Server 通常用于结构化数据,它们提供了强大的事务处理和一致性保证。它们的查询语言 SQL 也

0

0