特征重要性评估手册

发布时间: 2024-11-03 23:50:52 阅读量: 65 订阅数: 28

NSWC可靠性手册

# 1. 特征重要性评估概述

特征重要性评估是机器学习和数据科学中的一个核心环节,它涉及到从原始数据中识别出哪些特征对最终模型预测有显著贡献。评估特征的重要性不仅可以帮助我们更好地理解数据,还能指导特征工程过程,例如进行特征选择或降维,从而提高模型的性能和效率。

在构建机器学习模型时,特征的选择往往决定了模型的质量和解释力。一个优秀的特征可以帮助模型更准确地捕捉到数据中的关键信息,而一个无关的特征可能会引入噪声,甚至导致模型过拟合。因此,特征重要性评估对于提升模型泛化能力、减少训练时间、降低过拟合风险等方面具有重要意义。

为了深入理解特征重要性,接下来的章节将探讨特征重要性的定义、评估方法以及其在实际应用中的意义和挑战。我们会从理论基础讲起,逐步深入到实践中如何应用,再到未来可能的发展趋势。

# 2. 特征重要性评估的理论基础

## 2.1 特征重要性的定义和意义

### 2.1.1 特征在机器学习中的作用

特征是机器学习模型的基石。它们是原始数据的量化或抽象表示,机器学习模型通过学习这些特征来对新的数据进行预测或分类。在特征工程的过程中,我们希望选取的特征能够最大限度地包含对预测任务有帮助的信息,并减少冗余和无关的特征。一个优秀的特征集合可以极大地提高模型的性能,使得模型训练更加高效,预测更加准确。

### 2.1.2 特征重要性对模型性能的影响

特征重要性的评估对于机器学习模型的开发至关重要。首先,通过对特征重要性的评估,我们可以识别出哪些特征对于模型的预测能力贡献最大,从而进行有效的特征选择。这不仅有助于减少模型的复杂度,提高训练效率,还有助于避免过拟合问题。其次,特征重要性的评估还能够为数据预处理提供指导,比如在缺失数据处理、异常值检测以及数据增强等方面提供依据。此外,通过对特征重要性的分析,还可以获得对问题领域的更深刻理解,从而指导后续的数据收集工作。

## 2.2 特征重要性评估的方法论

### 2.2.1 模型无关的特征重要性评估方法

模型无关的特征重要性评估方法不依赖于任何特定的模型,因此具有较强的普适性。这些方法包括但不限于:特征重要性递归消除(RFE)、基于随机森林的特征重要性评分、特征重要性递归分析(Permutation Importance)等。例如,随机森林算法中的特征重要性评分基于特征的平均不纯度减少。这意味着特征被用作分割节点时,数据的纯度(如信息增益或基尼不纯度)的平均减少量。

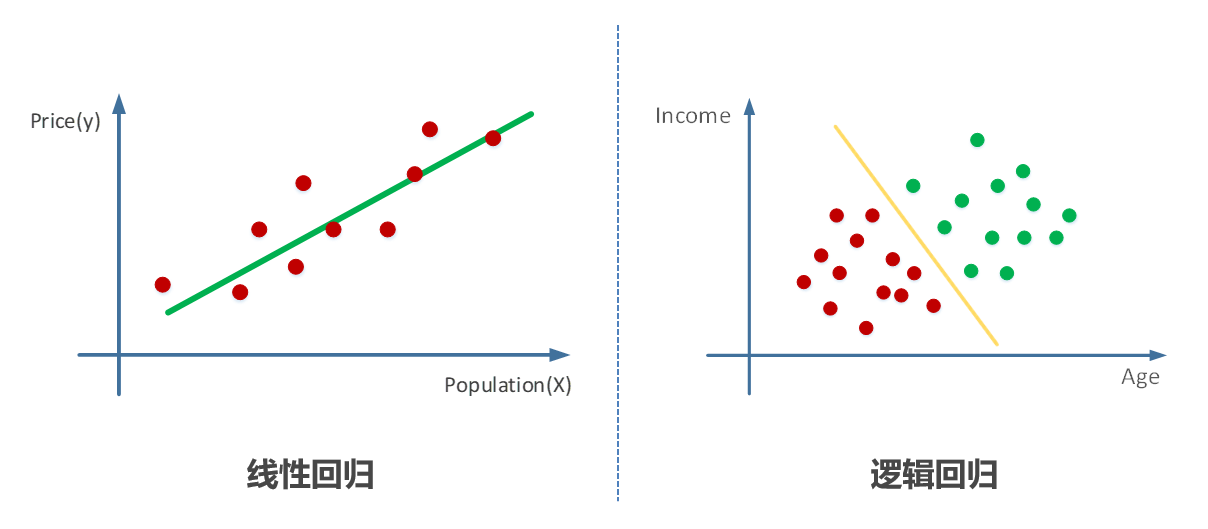

### 2.2.2 模型依赖的特征重要性评估方法

模型依赖的特征重要性评估方法则与特定的模型绑定。例如,在线性回归模型中,特征的重要性可以通过回归系数的大小来衡量;在深度神经网络中,可以通过梯度上升或下降过程中特征的梯度大小来评估特征的重要性。每个模型有其特定的方法来解释特征的重要性,这通常与模型的内部机制密切相关。

### 2.2.3 特征重要性评估方法的比较和选择

选择合适的特征重要性评估方法需要考虑多个因素。例如,数据的规模、维度、特征类型、模型的复杂度、计算资源等。模型无关的方法适合快速评估特征的重要性,但可能不如模型依赖的方法那么精确。模型依赖的方法虽然精确,但计算代价往往更高,并且在某些情况下可能需要专业知识来解释结果。下面的表格提供了一些不同评估方法的比较:

| 特征重要性评估方法 | 依赖模型 | 计算代价 | 适用性 | 精确度 |

|-------------------|--------|---------|------|-------|

| 随机森林特征重要性 | 是 | 中等 | 广泛 | 高 |

| 线性回归系数 | 是 | 低 | 适用线性模型 | 中 |

| Permutation Importance | 否 | 高 | 广泛 | 中到高 |

| Shapley值解释 | 是 | 高 | 广泛 | 非常高 |

根据问题的特定需求和资源的限制,可以选择最适合的方法进行特征重要性的评估。

在本章节中,我们介绍了特征重要性的理论基础,并探讨了模型无关和模型依赖的评估方法及其比较。下章节将深入探讨特征重要性评估的实践应用,通过具体的工具和案例来进一步理解这些理论。

# 3. 特征重要性评估的实践应用

在深入理解了特征重要性评估的理论基础之后,我们现在将目光转向实际应用。实践应用的探索将帮助我们更清楚地了解如何在不同场景中有效地实施特征重要性评估,并将理论转化为实际操作。

## 3.1 常用特征重要性评估工具和库

### 3.1.1 Python中的特征重要性评估库

Python作为数据科学领域最受欢迎的编程语言之一,拥有许多强大的库来支持特征重要性评估。其中最著名的包括:

- **scikit-learn**: 这个库几乎成为机器学习项目的标配。它提供了一系列方法来进行特征重要性评估,包括决策树、随机森林、梯度提升树等模型内置的特征重要性属性。

- **feature_engine**: 专门用于特征工程的库,它提供了更细致的特征选择和特征重要性评估工具。

- **eli5**: 提供了一个统一的界面来查看不同模型的特征重要性,包括树模型、线性模型和一些集成模型。

下面的代码块演示了如何使用scikit-learn来计算随机森林的特征重要性:

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

# 加载iris数据集

iris = load_iris()

X, y = iris.data, iris.target

# 创建随机森林分类器

rf = RandomForestClassifier(n_estimators=100)

# 训练模型

rf.fit(X, y)

# 打印特征重要性

feature_importances = rf.feature_importances_

for i, imp in enumerate(feature_importances):

print(f'Feature {iris.feature_names[i]}: {imp:.4f}')

```

在此代码中,我们使用了Iris数据集,并构建了一个随机森林分类器。在训练后,我们得到了每个特征的重要性分数,并将其打印出来。这些分数是根据特征在构建树时的平均不纯度减少量来计算的。

### 3.1.2 R语言中的特征重要性评估工具

R语言在统计分析和机器学习方面同样表现出色,它也拥有一些强大的库用于特征重要性评估,如:

- **randomForest**: 这个包提供了对随机森林模型的完整实现,同时包括了计算特征重要性的功能。

- **xgboost** 和 **lightgbm**: 这些库提供了梯度提升树的实现,并且允许用户获取特征重要性评分。

以下是一个使用`randomForest`包来评估Iris数据集中特征重要性的R代码示例:

```r

library(randomForest)

# 加载数据集

data(iris)

# 选择特征和标签

X <- iris[, 1:4]

y <- iris[, 5]

# 训练随机森林模型

set.seed(123)

rf_model <- randomForest(x = X, y = y, importance = TRUE)

# 输出特征重要性

print(rf_model$importance)

```

在R代码示例中,我们用Iris数据集来训练一个随机森林模型,并通过设置`importance = TRUE`来确保特征重要性被计算和存储在模型对象中。之后,我们可以简单地打印这个对象来查看不同特征的重要性。

## 3.2 特征重要性评估案例分析

### 3.2.1 分类问题的特征重要性评估实例

分类问题通常涉及将数据点分配到两个或多个类别。以下是一个使用Python和scikit-learn库来评估分类问题特征重要性的实例。

假设我们有一个信用评分的数据集,我们想要构建一个模型来预测客户是否会违约。我们将使用随机森林分类器来进行特征重要性评估。

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

import pandas as pd

from sklearn.datasets import fetch_openml

# 加载信用评分数据集

credit_data = fetch_openml('credit-g', version=1)

X, y = credit_data.data, credit_data.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练随机森林模型

rf = RandomForestClassifier(n_estimators=100)

rf.fit(X_train, y_train)

# 评估模型性能

predictions = rf.predict(X_test)

print(classification_report(y_test, predictions))

# 特征重要性分析

importances = rf.feature_importances_

indices = np.argsort(importances)[::-1]

# 打印特征重要性

for f in range(X_train.shape[1]):

print("%d. feature %d (%f)" % (f + 1, indices[f], importances[indices[f]]))

```

在此案例中,我们首先加载了`credit-g`数据集,并将其划分为训练集和测试集。然后,我们训练了一个随机森林分类器,并对模型在测试集上的预测性能进行了评估。最后,我们对特征重要性进行了排序,并打印出来。

### 3.2.2 回归问题的特征重要性评估实例

回归问题涉及到预测一个连续值的输出。以下是一个使用Python和scikit-learn库评估回归问题特征重要性的示例。

我们将使用波士顿房价数据集来演示如何进行特征重要性评估。该数据集包含波士顿地区房屋的多个特征,目标是预测房屋中位数价格。

```python

from sklearn.datasets import load_boston

from sklearn.ensemble import RandomForestRegressor

import numpy as np

# 加载波士顿房价数据集

```

0

0