【EIP-CIP-V2-1.0 中文版】:企业集成模式实战指南:从入门到精通

发布时间: 2024-12-14 08:43:26 阅读量: 3 订阅数: 16

EIP-CIP-V1-1.0.zip_CIP_EIP-CIP-V1-1.0_cip specification_eip_spec

参考资源链接:[CIP-EtherNet/IP V2.1适配中文版:2006年5月发布](https://wenku.csdn.net/doc/4269f5midn?spm=1055.2635.3001.10343)

# 1. 企业集成模式(EIP)概述

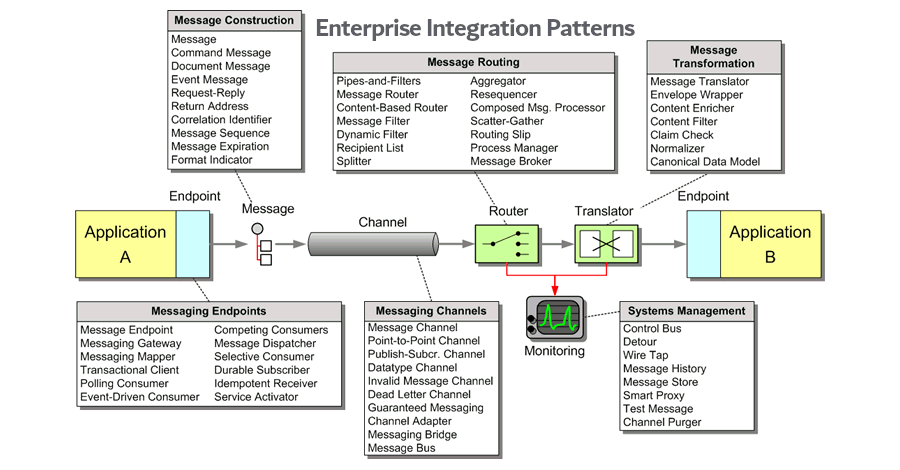

在现代企业信息技术的应用中,企业集成模式(Enterprise Integration Patterns,简称EIP)是一个核心概念,它是架构师和开发人员用于构建可靠的、可维护和可扩展的系统的关键工具。通过EIP,企业能够有效地将各种不同的技术、系统和组件连接起来,确保数据和信息流在企业内部和外部顺畅流通。

企业集成模式不仅仅关注技术层面的实现,它还涉及业务流程、组织结构和工作流等多个方面。在设计和部署集成模式时,关键是要理解业务需求,以及这些需求是如何影响系统架构和集成策略的。通过这种方式,EIP可以促进业务的灵活性和敏捷性,支持企业在不断变化的市场环境中保持竞争力。随着技术的快速发展,EIP也在不断地演进,以应对新的挑战和机遇。接下来的章节将深入探讨集成模式的基本理论、分类、选择和应用。

# 2. 集成模式的基本理论

### 2.1 集成模式的定义与原则

#### 2.1.1 什么是集成模式

集成模式(Integration Patterns)是软件架构中的一套设计模式,它关注如何在不同的系统组件、应用程序或服务之间进行有效、高效的数据和控制流交互。这些模式为解决集成问题提供了经过验证的解决方案,使得系统之间的通信变得标准化和可预测。集成模式不仅包括了接口和协议的选择,还包括了消息的格式和传递机制,以及错误处理和事务管理的策略。

在深入探讨集成模式之前,我们需要理解其存在的必要性。企业信息系统日益复杂,跨越不同的平台和技术栈。要实现这些系统的无缝集成,就需要一种通用的语言来描述不同的集成方法。集成模式为实现这种通用语言提供了框架。无论是在企业内部的不同部门之间,还是在不同企业之间的供应链管理中,集成模式都能够提供标准化的集成解决方案。

#### 2.1.2 集成模式的六大原则

集成模式的六大原则为系统集成提供了理论基础和实践指导。以下是这些原则的概述:

- **原则1:保证单一责任(Single Responsibility)**

集成的每个组件应该只有一个责任或行为改变的理由。这意味着集成系统中的每一个服务或组件应该专注于完成一个任务。

- **原则2:开放封闭原则(Open/Closed Principle)**

系统、模块或函数应该对扩展开放,对修改关闭。在集成模式中,这意味着当需求变化时,我们应当通过扩展组件功能而不是修改现有组件来适应新的集成需求。

- **原则3:依赖倒置原则(Dependency Inversion Principle)**

高层次的模块不应该依赖于低层次的模块,两者都应该依赖于抽象。抽象不应该依赖于细节,细节应该依赖于抽象。这一点在集成模式中尤为重要,它能够确保在系统变化时,集成方式的灵活性。

- **原则4:接口隔离原则(Interface Segregation Principle)**

多个专门的接口优于单一的复杂接口。这意味着集成服务应当提供专门的接口供不同的集成场景使用,而不是一个大而全的接口。

- **原则5:里氏替换原则(Liskov Substitution Principle)**

子类应该能够替换掉它们的基类。在集成模式中,这意味着新的集成组件应该能够在不改变原有系统结构的情况下,替换掉旧的组件。

- **原则6:最少知识原则(Least Knowledge Principle)**

一个对象应该尽可能少地知道其他对象。这一原则经常被表述为“别问太多问题”。在集成模式中,这意味着组件间的交互应该尽量简单,仅通过定义良好的接口或协议进行。

这些原则是构建健壮、可维护和可扩展的企业集成模式的基础。它们指导开发人员在设计集成系统时做出正确的决策,以确保系统的长期健康。

### 2.2 集成模式的分类

#### 2.2.1 基于数据流的模式

基于数据流的模式关注的是数据在系统间传输和处理的方式。这些模式通常包括:

- **文件传输模式(File Transfer Pattern)**:数据以文件的形式在系统间传输。这种方式简单、直观,适用于数据量大的场景。

- **共享数据库模式(Shared Database Pattern)**:不同的系统共享同一个数据库,通过直接访问数据库来实现数据同步和共享。

- **数据映射模式(Data Mapping Pattern)**:源系统和目标系统之间的数据结构可能不同。数据映射模式负责将一种格式的数据转换成另一种格式。

- **批量更新模式(Bulk Update Pattern)**:在定时任务中进行数据更新,通常适用于数据同步场景。

基于数据流的模式各有其优势和局限性,它们的选择需要根据实际业务需求和数据特性的具体分析。

#### 2.2.2 基于请求-响应的模式

基于请求-响应的模式更多地关注于系统间的交互和实时性要求。此类模式包括:

- **请求-应答模式(Request-Reply Pattern)**:一种同步交互模式,其中发起请求的一方在收到响应之前会阻塞,直到请求得到处理。

- **远程过程调用模式(Remote Procedure Call, RPC Pattern)**:允许一个程序调用另一个地址空间中的程序,通常通过网络调用。

- **发布-订阅模式(Publish-Subscribe Pattern)**:基于事件的模式,允许发布者发布消息而不需要知道订阅者的具体信息,反之亦然。

- **异步消息传递模式(Asynchronous Messaging Pattern)**:这种模式在消息的发送者和接收者之间提供了解耦合,通常通过消息队列实现。

选择合适的请求-响应模式需要综合考虑业务场景、数据实时性和系统间的耦合度。

### 2.3 集成模式的选择与应用

#### 2.3.1 如何根据业务需求选择模式

选择集成模式时需要考虑许多因素,如数据量大小、实时性要求、系统的耦合程度以及对事务一致性的要求。以下是一些选择集成模式时的指导性建议:

- **考虑数据量和传输频率**:对于数据量大且传输频率低的场景,可以考虑使用文件传输模式。相反,对于需要实时或近实时交互的场景,请求-应答模式可能更为合适。

- **确定系统的耦合程度**:如果系统间需要紧密协作,共享数据库模式可能是有效的方式。而如果系统间需要解耦合,可能更倾向于使用消息队列或者发布-订阅模式。

- **评估事务一致性要求**:在需要保证跨系统事务一致性的场景中,可以考虑两阶段提交(2PC)等事务管理模式。

- **考虑技术栈和现有基础设施**:集成模式的选择也应基于现有的技术和基础设施,以减少成本并提高实施效率。

通过对上述因素的综合考虑,我们可以选择最适合当前业务需求的集成模式。

#### 2.3.2 集成模式的适用场景分析

**应用场景1:企业内部数据同步**

在企业内部,经常需要进行数据同步,例如ERP系统与CRM系统之间的数据共享。这种情况下,共享数据库模式或数据映射模式可能更加适用。共享数据库模式能够保证数据的一致性,而数据映射模式则适合在结构差异较大的系统间进行数据转换和同步。

**应用场景2:实时业务决策支持**

在需要实时业务决策支持的场景中,例如高频交易系统,请求-应答模式和远程过程调用模式可以提供快速的响应。然而,如果系统间耦合度太高,可以采用异步消息传递模式来降低耦合性,同时保持消息的实时传输。

**应用场景3:跨组织的业务流程整合**

在跨组织的业务流程整合中,如供应链管理,发布-订阅模式可以用来处理合作伙伴间的消息传递。这种模式可以支持松散耦合的集成,使得参与方可以在不影响整个流程的情况下加入或退出。

通过分析不同集成模式的适用场景,企业可以根据自己的特定需求来选择和实施相应的集成策略,以实现业务流程的高效运作。

# 3. 企业集成模式的实践应用

企业集成模式(Enterprise Integration Patterns,简称EIP)是企业信息系统集成领域的核心概念,它为不同系统间的信息交换和业务流程整合提供了具体的指导和解决方案。在第三章中,我们将深入探讨EIP在实际工作中的应用,包括数据集成、应用集成和流程集成等不同层面,以及它们在实践中的应用案例和效果评估。

## 3.1 实现数据集成的模式应用

### 3.1.1 文件传输模式实践

文件传输模式(File Transfer Pattern)是最常见的数据集成方式之一,主要涉及到在两个系统间传输文件。在实际应用中,这通常意味着使用FTP协议或者HTTP/HTTPS协议,将数据文件从一个系统移动到另一个系统。

**案例分析:** 假设一家公司有财务系统需要定期将报表数据传输给审计团队,通常会使用FTP模式进行数据传输。审计团队的系统会定期检查FTP服务器上的文件夹,如果发现新文件,就下载并进行处理。

**代码示例:** 使用Python的`paramiko`库实现一个简单的FTP客户端上传文件的操作。

```python

import paramiko

# 创建SSH对象

ssh = paramiko.SSHClient()

ssh.set_missing_host_key_policy(paramiko.AutoAddPolicy())

# 连接服务器

ssh.connect(hostname="ftp.example.com", username="user", password="password")

# 创建SFTP对象

sftp = ssh.open_sftp()

# 上传文件

sftp.put('local财务报表.csv', '/报表/财务报表.csv')

# 关闭连接

sftp.close()

ssh.close()

```

**参数说明与逻辑分析:**

- `hostname`、`username`、`password`:分别表示FTP服务器的主机名、用户名和密码。

- `local财务报表.csv`:本地文件路径。

- `/报表/财务报表.csv`:远程服务器上文件的目标路径。

通过这种方式,财务系统可以周期性地将报表文件自动上传到FTP服务器,供审计团队下载使用。

### 3.1.2 数据转换模式实践

在进行数据集成时,源系统和目标系统之间的数据格式往往不一致,这就需要数据转换模式。数据转换模式涉及到将数据从一种格式转换为另一种格式,以便在异构系统间共享数据。

**案例分析:** 例如,一家企业拥有一个遗留的库存管理系统和一个现代的电子商务平台,两个系统间交换的数据格式不同。库存管理系统使用XML格式,而电商平台则使用JSON格式。为了实现两个系统间的数据同步,需要在数据传输前进行格式转换。

**代码示例:** 使用Python的`json`和`xml.etree.ElementTree`模块实现从XML到JSON的转换。

```python

import json

import xml.etree.ElementTree as ET

# XML数据示例

xml_data = '''<inventory>

<item>

<id>123</id>

<name>Awesome Product</name>

<quantity>10</quantity>

</item>

<!-- More items -->

</inventory>'''

# 将XML转换为Python对象

root = ET.fromstring(xml_data)

# 解析XML并构建JSON结构

def xml_to_json(element):

if len(element) == 0: # Base case: if element has no sub-elements, return its text.

return element.text

else: # Recursive case: construct a dict with tag as key and element's children as values.

return {element.tag: [xml_to_json(child) for child in element]}

json_output = xml_to_json(root)

# 打印结果

print(json.dumps(json_output, indent=4))

```

**参数说明与逻辑分析:**

- `xml_data`:原始XML格式的字符串数据。

- `ET.fromstring()`:从字符串中解析XML数据。

- `xml_to_json()`:递归函数用于将解析后的XML数据转换为JSON格式。

通过上述代码,我们可以将库存管理系统中的XML格式数据转换为电子商务平台可以理解的JSON格式数据,从而实现数据的无缝集成。

## 3.2 实现应用集成的模式应用

### 3.2.1 请求-响应模式实践

请求-响应模式(Request-Reply Pattern)是集成模式中非常经典的一种交互方式,其中一个系统(请求方)发送消息给另一个系统(响应方),等待并接收响应。这种模式适用于需要同步处理的场景。

**案例分析:** 在订单管理系统中,当需要验证订单信息时,系统会向验证服务发送请求,等待服务返回验证结果。请求-响应模式确保了请求和响应之间的完整性和一致性。

**代码示例:** 使用Python的`requests`库实现一个同步请求的示例。

```python

import requests

# 假设验证服务的API端点是 'https://api.example.com/verify_order'

api_endpoint = 'https://api.example.com/verify_order'

# 订单数据

order_data = {

'order_id': 'ORD12345',

'customer_id': 'CUST67890',

'total_amount': 100.00

}

# 发送请求并获取响应

response = requests.post(api_endpoint, json=order_data)

# 检查响应状态码

if response.status_code == 200:

# 处理响应数据

print(response.json())

else:

print("请求失败,状态码:", response.status_code)

```

**参数说明与逻辑分析:**

- `api_endpoint`:验证服务的API端点。

- `order_data`:需要发送给验证服务的订单数据,这里使用了JSON格式。

- `requests.post()`:使用POST方法发送请求,并将订单数据以JSON格式包含在请求体中。

- `response.status_code`:响应的状态码,用于检查请求是否成功。

- `response.json()`:如果响应体是JSON格式的数据,可以直接转换成Python对象进行处理。

通过上述代码,订单管理系统可以确保订单在得到验证服务的响应之后才继续处理,保证了业务流程的正确性。

### 3.2.2 发布-订阅模式实践

发布-订阅模式(Publish-Subscribe Pattern)是一种非同步的集成模式,它允许系统发布消息(事件)到一个中央消息系统,并由一个或多个订阅者(消费者)进行处理。这种模式在需要解耦的系统间通信中非常有用。

**案例分析:** 例如,一个电子商务平台可能有一个营销活动引擎,它需要向不同的系统发布促销活动信息。不同的后端服务(如推荐系统、库存系统)都可能对这些信息感兴趣,并根据活动信息调整自己的行为。

**代码示例:** 假设使用Apache Kafka作为消息队列,Python的`kafka-python`库来实现生产者和消费者。

```python

from kafka import KafkaProducer, KafkaConsumer

# 创建生产者

producer = KafkaProducer(

bootstrap_servers=['localhost:9092'],

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

# 发布消息

producer.send('marketing_events', {'event_type': 'promotion_started', 'product_id': 'PROD123'})

# 创建消费者

consumer = KafkaConsumer(

'marketing_events',

bootstrap_servers=['localhost:9092'],

auto_offset_reset='earliest',

value_deserializer=lambda m: json.loads(m.decode('utf-8'))

)

# 订阅消息并处理

for message in consumer:

print(message.value)

```

**参数说明与逻辑分析:**

- `bootstrap_servers`:Kafka集群的地址列表。

- `value_serializer` 和 `value_deserializer`:分别用于序列化和反序列化消息数据。

- `marketing_events`:营销活动事件的Kafka主题。

在这个案例中,营销活动引擎作为生产者向Kafka主题`marketing_events`发布促销活动信息,推荐系统和库存系统作为消费者订阅该主题,并根据接收到的消息进行相应的业务逻辑处理。

## 3.3 实现流程集成的模式应用

### 3.3.1 业务流程模式实践

业务流程模式(Business Process Pattern)通常用于描述企业内的业务流程以及这些流程如何被集成。这种模式通常涉及工作流引擎的使用,通过工作流引擎来管理复杂的业务逻辑和任务流。

**案例分析:** 在一个企业中,订单的处理可能涉及多个部门和流程,如订单录入、库存检查、发货等。这些步骤需要按一定的顺序执行,并确保相关数据在各个部门间准确传递。

**代码示例:** 使用Activiti作为工作流引擎来实现一个订单处理流程。

```java

// 假设使用Java和Activiti工作流引擎API

import org.activiti.engine.*;

import org.activiti.engine.history.HistoricProcessInstance;

import org.activiti.engine.runtime.ProcessInstance;

// 部署流程定义

RepositoryService repositoryService = processEngine.getRepositoryService();

repositoryService.createDeployment()

.addClasspathResource("order-processing.bpmn")

.deploy();

// 启动流程实例

RuntimeService runtimeService = processEngine.getRuntimeService();

ProcessInstance processInstance = runtimeService.startProcessInstanceByKey("orderProcessing");

// 查询流程实例历史

HistoryService historyService = processEngine.getHistoryService();

HistoricProcessInstance historicProcessInstance = historyService.createHistoricProcessInstanceQuery()

.processInstanceId(processInstance.getId())

.singleResult();

System.out.println("Order " + historicProcessInstance.getId() + " processed.");

```

**参数说明与逻辑分析:**

- `order-processing.bpmn`:定义了业务流程的BPMN文件,包含了订单处理的所有步骤和决策点。

- `repositoryService`:用于部署流程定义。

- `runtimeService`:用于启动流程实例。

- `historyService`:用于查询流程实例的历史记录。

通过这种方式,企业可以实现一个跨部门的、高度集成的业务流程管理,每个步骤都会被记录并可供审计和分析。

### 3.3.2 事务流程模式实践

事务流程模式(Transaction Process Pattern)强调的是业务流程的事务性,即在业务处理过程中保证数据的一致性和完整性。在实际应用中,这可能意味着一系列操作要么全部成功,要么在发生错误时全部回滚。

**案例分析:** 在金融服务行业中,转账操作必须保证事务性,即资金从一个账户扣除后必须准确无误地存入另一个账户,任何一步失败都需要撤销已执行的操作。

**代码示例:** 使用Spring框架的声明式事务管理特性来处理银行转账事务。

```java

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import org.springframework.transaction.annotation.Transactional;

@Service

public class BankingService {

@Autowired

private AccountRepository accountRepository;

@Transactional

public void transferMoney(String fromAccount, String toAccount, double amount) {

Account fromAcc = accountRepository.findById(fromAccount);

Account toAcc = accountRepository.findById(toAccount);

// 检查余额

if (fromAcc.getBalance() >= amount) {

fromAcc.setBalance(fromAcc.getBalance() - amount);

toAcc.setBalance(toAcc.getBalance() + amount);

// 保存账户状态

accountRepository.save(fromAcc);

accountRepository.save(toAcc);

} else {

throw new RuntimeException("Insufficient funds");

}

}

}

```

**参数说明与逻辑分析:**

- `@Transactional`:Spring框架提供的注解,声明`transferMoney`方法为一个事务性操作。

- `accountRepository`:用于访问和操作账户信息的数据仓库接口。

- `fromAccount`、`toAccount`、`amount`:转账操作需要的参数。

在这个例子中,银行转账操作使用了Spring的声明式事务管理来确保操作的原子性。如果在操作过程中发生异常,例如资金不足,所有的更改将会被回滚,保证账户状态的正确性。

在本章节中,我们探讨了企业集成模式在不同场景下的具体应用,通过实际案例和代码示例展示了如何将EIP理论应用到实践工作中。下一章节,我们将继续深入探讨EIP在不同系统间的集成实战,包括传统企业IT系统和现代云计算环境。

# 4. ```

# 四章:EIP在不同系统间的集成实战

## 4.1 EIP在传统企业IT系统中的应用

### 4.1.1 ERP系统与CRM系统的集成

企业资源计划(ERP)系统和客户关系管理(CRM)系统是现代企业信息系统的两大支柱。ERP系统负责企业内部资源的管理,如供应链、库存、生产、财务等;而CRM系统则专注于客户信息的管理,包括销售、市场营销、客户服务等。EIP使得这两个系统可以有效集成,从而优化企业的业务流程和决策过程。

集成ERP和CRM系统通常涉及多个步骤,包括数据同步、流程整合和用户界面集成。数据同步确保两个系统中的客户和交易信息是准确和最新的。流程整合则确保销售、市场营销和客户服务的流程能够在两个系统之间无缝流转。用户界面的集成则提供了统一的操作体验,使得用户可以在一个界面中同时操作ERP和CRM系统。

一个实际的ERP与CRM集成案例可能包括如下步骤:

1. 分析ERP和CRM系统中的关键数据模型,确定需要同步的数据字段。

2. 设计并实现数据同步机制,这可以通过定制开发的数据接口或使用中间件产品来实现。

3. 利用EIP模式(如消息队列、服务总线等)来确保数据变更能够实时或按预定时间间隔同步。

4. 设计和部署流程整合的策略,这可能包括业务规则的同步、事件驱动的处理流程等。

5. 实现用户界面的集成,确保用户可以无缝地从一个系统跳转到另一个系统。

### 4.1.2 数据库之间的集成技术

在传统的IT环境中,数据库集成是一个常见的挑战。不同的数据库系统可能使用不同的数据模型、存储过程、触发器等,这些都增加了集成的复杂性。EIP提供了多种技术来解决这些问题,包括数据复制、ETL(抽取、转换、加载)工具和数据服务接口。

数据复制技术允许在两个或多个数据库之间保持数据的一致性。这种技术可以通过数据库管理系统的内置复制功能或第三方数据同步工具来实现。复制的挑战包括处理数据冲突、网络延迟和数据丢失等问题。

ETL工具是另一种流行的数据集成方式,它可以从各种来源提取数据,然后进行清洗、转换和加载到目标数据库中。ETL流程通常用于数据仓库建设或大规模数据迁移项目。

数据服务接口(如Web服务、REST API)提供了一种程序化的方式,使得应用程序能够访问和操作数据库中的数据,而不必关心底层数据存储的具体实现。这种方式提高了数据访问的灵活性,并允许更细粒度的访问控制。

### 4.2 EIP在现代云计算环境中的应用

#### 4.2.1 微服务架构中的模式应用

微服务架构是一种将单个应用程序作为一套小型服务开发的方法,每个服务运行在其独立的进程中,并使用轻量级通信机制通信。微服务的分布式特性使得EIP在其中扮演着至关重要的角色。微服务之间经常需要异步通信、负载均衡、服务发现等集成模式。

异步通信模式在微服务架构中很常见,它允许服务间通过消息队列进行通信,这不仅提高了系统的可伸缩性,还提高了系统的容错能力。例如,一个订单服务可以向消息队列发送订单创建事件,然后其他服务如库存服务、支付服务等监听该队列,并根据事件执行相应的业务逻辑。

服务发现是微服务架构的另一个关键集成模式。随着服务数量的增加,手动维护服务位置信息变得不切实际。服务发现模式允许服务实例注册自己的位置,并动态发现其他服务实例。服务注册中心(如Consul、Eureka)通常用于这一目的,确保服务间的高效通信。

#### 4.2.2 云服务与本地服务的集成策略

云计算的兴起为IT系统带来了新的集成挑战和机遇。企业需要将现有的本地服务与云服务集成,以充分利用云计算的灵活性和可伸缩性。这种集成可能包括数据迁移、服务对接、API网关的使用等。

数据迁移是将本地数据移动到云服务中的过程,可以采用多种方式,如直接数据库复制、ETL工具或数据传输服务。每个方法都有其适用场景,需要根据数据量大小、数据类型和迁移频率等因素来选择。

服务对接涉及在本地服务和云服务之间建立通信机制。这可能需要使用VPN、专线等安全连接,或者利用云服务提供商提供的安全网关。关键在于确保通信的安全性和可靠性。

API网关是云服务集成的一个核心组件,它作为微服务架构中的统一入口,对外提供API接口,并在内部协调各个微服务的调用。API网关还可以处理安全性、限流、监控、负载均衡等跨服务的集成问题。

### 4.2.3 实现代码段

为了展示EIP在现代云计算环境中的应用,下面提供一个使用消息队列技术实现的简单代码段。

```python

import pika

# 连接到RabbitMQ服务器

connection = pika.BlockingConnection(

pika.ConnectionParameters('localhost')

)

channel = connection.channel()

# 声明队列,队列名称为 'hello'

channel.queue_declare(queue='hello')

# 回调函数,当接收到消息时会被调用

def callback(ch, method, properties, body):

print("Received message: %s" % body)

# 开始接收消息

channel.basic_consume(

queue='hello',

on_message_callback=callback,

auto_ack=True)

print(' [*] Waiting for messages. To exit press CTRL+C')

channel.start_consuming()

```

在这个Python示例中,我们使用了pika库来与RabbitMQ消息队列进行交互。首先,我们声明了一个名为"hello"的队列,然后定义了一个回调函数来处理从队列中接收到的消息,并开始消费队列中的消息。这个简单的代码段展示了异步消息处理的一个基本例子,是微服务架构中常见的集成模式之一。

### 4.2.4 实现流程图

在微服务架构中,服务间的集成流程往往比较复杂。为了更好地理解服务集成的各个步骤和组件之间的关系,可以使用流程图进行可视化。下面是一个使用mermaid语法绘制的简单服务集成流程图。

```mermaid

graph LR

A[客户端请求] -->|REST API| B(服务A)

B -->|异步消息| C(服务B)

C -->|数据库操作| D[数据库]

D -->|响应消息| C

C -->|响应数据| B

B -->|返回响应| A

```

在这个流程图中,客户端通过REST API向服务A发送请求。服务A处理请求后,会将异步消息发送给服务B。服务B接收到消息后进行数据库操作,并将响应消息发送回服务B。最后,服务B将操作结果返回给服务A,服务A再将最终响应返回给客户端。

通过这种方式,我们不仅能够理解各个服务之间的集成流程,还能清晰地看到数据流的方向和集成的各个关键点。

## 4.3 实现表格

在企业集成的实战案例中,通常会涉及到不同服务或组件的性能和特性比较。下面是一个表格,用于比较不同的消息队列服务的特性。

| 特性/服务 | RabbitMQ | Apache Kafka | AWS SQS |

|------------|----------|--------------|---------|

| 消息模式 | 点对点和发布-订阅 | 主要发布-订阅 | 点对点 |

| 消息协议 | AMQP, MQTT等 | 自定义协议 | 自定义协议 |

| 持久化 | 支持 | 支持 | 支持 |

| 水平扩展性 | 支持 | 支持 | 支持 |

| 社区支持 | 优秀 | 良好 | 优秀 |

| 企业支持 | 有 | 有 | 有 |

表格清晰地展示了RabbitMQ、Apache Kafka和AWS SQS这三种消息队列服务的不同特性,帮助读者在选择合适的消息队列服务时做出更加明智的决策。这些特性包括消息模式、支持的协议、是否支持消息持久化和水平扩展性,以及社区和企业支持的情况。

## 4.4 实现列表

在讨论EIP集成模式时,我们经常会提到一系列的最佳实践和关键考虑因素。下面是一个列表,总结了在进行系统间集成时应该遵循的一些原则和建议:

- **数据一致性**:确保数据在各个系统间保持一致是集成工作的首要任务。实现这一点可能需要复杂的同步机制和事务管理。

- **服务松耦合**:服务间的集成应该尽可能地松耦合,以提高系统整体的灵活性和可维护性。

- **错误处理和补偿机制**:在集成的过程中应该有明确的错误处理机制,并为可能出现的失败情况提供补偿措施。

- **安全性考虑**:数据传输和接口调用的安全性是不可或缺的,应该考虑使用加密、认证和授权等安全措施。

- **可扩展性**:集成解决方案应该考虑到未来可能的增长和变化,为系统提供良好的可扩展性。

- **监控和日志记录**:集成解决方案应该包括监控和日志记录机制,以便跟踪集成的健康状况和进行问题诊断。

遵循这些原则和建议,可以帮助开发团队构建更加健壮、可靠和易于维护的集成解决方案。

在本章节中,我们深入探讨了EIP在不同系统间的集成实战,包括传统企业IT系统和现代云计算环境中的应用场景。我们分析了ERP与CRM系统的集成、数据库之间的集成技术以及微服务架构中的模式应用。通过代码、流程图和表格,我们为读者提供了实际的案例和操作步骤,以及不同集成模式的性能比较和最佳实践建议。这些知识和技能对于任何想要实现系统集成的专业IT人士来说都是至关重要的。

```

# 5. EIP集成模式的优化与高级应用

## 5.1 集成模式的性能优化策略

### 5.1.1 缓存机制的应用

在企业集成模式(EIP)中,性能优化是确保系统高效运行的关键因素。缓存机制作为一种广泛使用的优化策略,能够显著提升数据检索的速度并降低系统延迟。在EIP环境中,缓存可以用于多种场景,比如缓存频繁访问的数据库查询结果、外部服务的响应数据等。

```java

// 示例代码:简单的缓存处理逻辑

public class SimpleCache {

private Map<String, Object> cacheMap = new ConcurrentHashMap<>();

public Object get(String key) {

return cacheMap.get(key);

}

public void put(String key, Object value) {

cacheMap.put(key, value);

}

public void invalidate(String key) {

cacheMap.remove(key);

}

}

```

缓存实现需要考虑数据一致性、缓存失效策略和缓存穿透等问题。常见的缓存失效策略包括时间过期、空间淘汰等。在实现缓存时,务必考虑到数据的时效性,避免过时数据对业务处理造成干扰。

### 5.1.2 异步处理与消息队列

异步处理是提高系统吞吐量和响应速度的重要技术手段。通过引入消息队列,系统可以将耗时的任务异步处理,从而保证前台用户界面的快速响应。消息队列还可以提供消息重试、死信处理等机制,保障消息的可靠传递。

```

// 伪代码:使用消息队列进行异步处理

sendToQueue(message); // 将消息发送到队列

// 消费者监听队列并处理消息

onMessageReceived(message) {

// 异步处理逻辑

process(message);

}

```

在选择消息队列时,需要根据业务需求考虑消息队列的支持特性,如消息持久化、事务支持、消息顺序保证等。常用的开源消息队列有RabbitMQ、Apache Kafka等。

## 5.2 集成模式的安全性考量

### 5.2.1 认证授权机制的实现

在集成模式中,认证授权机制是保护数据和服务安全的重要组成部分。确保只有授权用户可以访问敏感资源,可以有效防止未授权访问和数据泄露。在设计认证授权时,通常会用到OAuth、JWT等安全协议。

```java

// 示例代码:简单的JWT认证流程

public String generateJwtToken(User user) {

// 生成token并签名

return Jwts.builder()

.setSubject(user.getUsername())

.signWith(SignatureAlgorithm.HS512, secretKey)

.compact();

}

public Claims validateJwtToken(String token) {

return Jwts.parser()

.setSigningKey(secretKey)

.parseClaimsJws(token)

.getBody();

}

```

实现认证授权机制时,要确保秘钥的安全存储和定期更新,避免秘钥泄露造成的风险。同时,对敏感操作进行审计跟踪,确保有完整的日志记录。

### 5.2.2 数据加密与传输安全

数据加密是保护数据安全的重要手段。在集成模式中,数据在存储和传输时应进行加密处理。可以采用对称加密和非对称加密来保护数据的安全。数据传输过程中,使用SSL/TLS协议可以确保数据在传输过程中的机密性和完整性。

```xml

<!-- 示例代码:在HTTP请求中配置SSL -->

<Connector port="443" protocol="HTTP/1.1"

SSLEnabled="true"

maxThreads="150"

scheme="https" secure="true"

clientAuth="false" sslProtocol="TLS"

keystoreFile="path/to/keystore"

keystorePass="keystorePassword"/>

```

在使用数据加密时,需要合理选择加密算法和密钥长度,遵循业界最佳实践。同时,定期对加密算法和密钥进行审计和更新,以防破解和滥用。

## 5.3 集成模式的高级应用案例

### 5.3.1 复杂业务流程的集成案例分析

复杂的业务流程往往涉及到多个服务和系统的深度集成。在这种场景下,集成模式需要满足高度的业务灵活性和可扩展性。例如,金融服务中的信贷审批流程可能需要集成风险评估系统、客户管理系统等多个外部系统。

```mermaid

graph LR

A[用户申请] --> B[信贷审批服务]

B --> C[风险评估系统]

B --> D[客户管理系统]

C --> E{风险评估结果}

D --> F{客户信用信息}

E -->|高风险| G[拒绝]

E -->|低风险| H[审批通过]

F -->|信用良好| H

F -->|信用不良| G

H --> I[合同生成]

G --> J[结束]

```

为了处理复杂业务流程的集成,可以采用基于事件驱动的集成模式。在这种模式下,每个系统作为事件的生产者或消费者,通过事件总线进行通信。这种方式有助于降低系统间耦合度,使得业务流程能够灵活地扩展和调整。

### 5.3.2 大数据集成与处理模式

大数据集成通常涉及到大量的数据聚合和处理。为了有效地集成大数据,通常需要采用分布式数据处理框架,如Apache Hadoop或Apache Spark。在大数据集成模式中,数据的提取、转换和加载(ETL)过程是核心。

```shell

# Hadoop文件系统命令示例

hadoop fs -mkdir /data/input

hadoop fs -put localfile /data/input

hadoop jar hadoop-mapreduce-examples.jar grep /data/input /data/output 'dfs[a-z.]+'

```

在实施大数据集成时,需要注意数据的安全性和合规性,确保敏感信息在传输和处理过程中的安全。同时,分布式数据处理需要考虑任务调度、资源管理和容错机制,以提高数据处理的效率和可靠性。

通过这些案例分析,我们可以看到EIP集成模式在不同业务场景下的应用方式以及为提高性能和安全性所采取的策略。在面对更复杂的业务流程和大数据处理需求时,EIP提供了灵活的解决方案和强大的扩展能力。

# 6. EIP-CIP-V2-1.0的未来发展趋势

随着技术的快速发展,企业集成平台(EIP)也不断地演化,其具体的实现和架构也在不断地成熟和创新。EIP-CIP-V2-1.0作为当前集成平台的一个版本,它既是对过去经验的总结,也是面向未来的重要起点。

## 6.1 EIP-CIP-V2-1.0的进化与扩展

### 6.1.1 新兴技术对集成模式的影响

集成平台作为连接不同系统和应用的桥梁,其发展与新兴技术紧密相关。云计算、微服务架构、大数据、人工智能、物联网等新兴技术的发展,对集成模式的进化产生了深远的影响。

**云计算**提供了一种新的服务方式和部署模型,使得集成平台能够更加灵活地利用资源,并在高可用性和弹性方面迈出了新的一步。而**微服务架构**的崛起,要求集成平台提供更加细粒度的服务集成能力,同时也促进了集成模式向服务网格等更高级的集成形态发展。

**大数据**技术推动集成平台必须拥有更强的数据处理和分析能力,以支持更复杂的业务需求。对于**人工智能**,集成平台将需要融入更多的智能处理能力,比如通过机器学习模型对集成过程进行智能预测和优化。

### 6.1.2 集成模式的未来发展方向

面对技术演进和市场变化的双重压力,EIP-CIP-V2-1.0以及未来的集成平台将朝着如下方向发展:

- **平台化和智能化**。集成平台将变成一个全面的解决方案,它不仅提供基础的集成能力,还提供AI驱动的决策支持、智能监控和自动化运维等能力。

- **去中心化和分布式**。集成模式将逐步向去中心化发展,支持分布式的数据和服务架构,降低单点故障的风险,并提高系统的整体可用性。

- **安全性与合规性**。随着数据隐私和网络安全的日益重视,集成平台需要在设计之初就考虑安全性因素,实现细粒度的权限控制、加密传输和安全审计。

## 6.2 企业集成的创新实践

### 6.2.1 人工智能与集成模式的结合

人工智能(AI)与集成平台的结合带来了许多创新的可能性。通过在集成平台上引入AI技术,可以实现对数据流的智能监控、对异常行为的实时检测、智能路由选择等。此外,结合自然语言处理(NLP)技术,集成平台可以更好地理解用户需求,从而提供更为人性化的服务。

例如,一个智能集成平台可以利用机器学习算法对历史的集成任务进行分析,学习数据模式和业务逻辑,预测可能出现的集成故障,并提前进行干预。通过AI,集成平台可以实现自我诊断和自我修复,大大提高了系统的可靠性和效率。

### 6.2.2 物联网(IoT)集成模式的探索

物联网(IoT)的发展为集成平台带来了新的挑战,也提供了新的机遇。将物联网设备和传感器无缝集成到企业的IT架构中,实现设备数据的实时监控和管理,对于企业运营至关重要。

集成平台需要适应物联网设备的多样性和高频率的数据更新,提供灵活的数据采集、处理和传输机制。例如,一个智能工厂中的设备可以通过集成平台实时传输工作状态数据,这些数据可以被集成平台汇总分析,以优化生产流程、提前预警设备故障,并实现设备的智能化管理。

随着物联网设备的快速增长,集成平台也需要支持大规模设备的管理和数据聚合,这可能需要引入边缘计算等新技术来支撑。边缘计算允许数据在产生地点或靠近数据源头进行处理,从而减少了对中心服务器的压力,并降低了延迟。

第六章作为文章的收尾,我们不仅展望了EIP-CIP-V2-1.0的未来发展趋势,也探讨了在新兴技术的推动下,企业集成的创新实践。这将为我们描绘一个更为丰富和动态的企业集成未来图景。

0

0