系统洞察:SATI3.2数据收集与分析的实用技巧

发布时间: 2024-12-13 17:00:19 阅读量: 11 订阅数: 7

SATI3.2 +手册+参考文献

参考资源链接:[SATI 3.2:文献信息挖掘与可视化软件案例研究](https://wenku.csdn.net/doc/6412b6a2be7fbd1778d476cd?spm=1055.2635.3001.10343)

# 1. SATI3.2简介及其在数据收集中的重要性

## 1.1 SATI3.2概述

SATI3.2是一种广泛应用于IT领域的数据收集工具,它通过高效的数据抓取和处理机制,帮助企业和研究机构快速获取所需信息。该工具的出现,极大地提升了数据收集的速度和准确性,是数据驱动决策的关键技术之一。

## 1.2 SATI3.2的核心优势

SATI3.2之所以受到青睐,主要得益于其强大的功能和用户友好的操作界面。它支持多种数据源,如网络、系统日志、数据库等,并提供了丰富多样的数据处理功能。此外,它的可扩展性和模块化设计使得用户可以根据具体需求自定义数据采集和处理流程。

## 1.3 数据收集的重要性

在当今的大数据时代,信息已成为企业制定战略、优化运营、预测市场趋势和提升竞争力的关键资源。SATI3.2通过提供精确和及时的数据收集,为企业分析和理解内外部环境提供了坚实的数据基础,从而推动了基于数据的智能化决策进程。

# 2. SATI3.2的数据采集技巧

### 2.1 数据采集基础与工具使用

#### 2.1.1 数据采集的概念和方法

在大数据时代,数据采集是整个数据分析和应用流程的基础。数据采集,简单来说,就是指使用特定的工具或方法从各种数据源中获取信息。数据源可以是公开的,如开放数据网站、社交媒体、公共记录等;也可以是私有的,如企业内部数据库、系统日志等。

数据采集的方法可以分为两种:被动采集和主动采集。被动采集通常是指在用户使用应用或访问网站时,通过追踪他们的行为来收集数据。这种方法需要数据采集工具或服务集成到应用或网站中。主动采集则是指使用爬虫、API等技术,按照既定规则,从外部数据源直接获取数据。

#### 2.1.2 常用的数据采集工具介绍

在数据采集的实践中,有许多工具可以帮助我们高效地完成任务。以下是一些广泛使用的数据采集工具:

1. **Web爬虫(Web Crawler)**: 如Scrapy、BeautifulSoup、Selenium等,它们可以自动化地浏览网页,并从网页中提取结构化数据。

2. **API(Application Programming Interface)**: 许多网站和在线服务提供了API接口,允许开发者以编程的方式访问数据,例如Twitter API、Facebook Graph API等。

3. **数据库直接连接(Database Connection)**: 通过SQL或NoSQL数据库的访问接口,直接从数据库中读取数据。

4. **系统日志采集工具**: 如Logstash、Fluentd等,它们可以收集和处理系统日志文件,方便后续分析。

### 2.2 数据采集实践操作

#### 2.2.1 网络数据采集实战

网络数据采集涉及的主要是网页数据的抓取。这里以Scrapy为例,展示如何进行网络数据采集。

首先,安装Scrapy:

```bash

pip install scrapy

```

然后,创建一个Scrapy项目:

```bash

scrapy startproject myproject

```

进入项目目录,创建一个爬虫:

```bash

cd myproject

scrapy genspider example example.com

```

在 `example.py` 中,编写爬虫规则,例如:

```python

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

allowed_domains = ['example.com']

start_urls = ['http://example.com']

def parse(self, response):

# 提取网页中的信息

yield {

'title': response.xpath('//title/text()').get(),

'url': response.url

}

```

最后,运行爬虫:

```bash

scrapy crawl example

```

这个例子展示了如何抓取一个网页的标题和URL。

#### 2.2.2 系统日志数据采集实战

系统日志是诊断和监控系统状态的重要数据来源。下面使用Fluentd来收集和转发系统日志。

首先,安装Fluentd:

```bash

sudo td-agent install

```

配置Fluentd来监听系统日志文件,并将日志数据转发到指定的目的地。在 `td-agent.conf` 中,添加以下配置:

```xml

<system>

log_level info

</system>

<source>

@type tail

path /var/log/syslog

pos_file /var/log/td-agent/syslog.pos

tag system

format none

</source>

<match system>

@type file

path /var/log/td-agent/collected_system_logs

</match>

```

重启Fluentd服务:

```bash

sudo service td-agent restart

```

这样配置之后,Fluentd会实时监听 `/var/log/syslog` 文件,并将新日志数据追加到 `/var/log/td-agent/collected_system_logs` 文件中。

### 2.3 数据采集的高级策略

#### 2.3.1 针对性数据采集策略

针对性数据采集策略是指根据具体需求定制化的采集方法。根据数据采集的目的,我们可能需要收集特定类型的数据,或者是从特定的数据源中收集数据。比如,在进行市场调研时,我们可能需要从社交媒体平台上采集特定用户群体的发言数据。

这里需要考虑数据的关联性、时间性和准确性。例如,对于时间序列数据的采集,就需要保证数据采集的连续性和实时性。

#### 2.3.2 数据采集的自动化和智能化

自动化数据采集是提高效率和减少人为错误的重要手段。通过编程实现数据采集脚本,可以在无人干预的情况下定期运行,实现数据的持续采集。

智能化数据采集则是在自动化的基础上,加入机器学习等技术,使系统能够根据数据模式和采集结果自我优化采集策略。例如,如果一个爬虫在采集过程中发现目标网站的结构发生变化,它可以自动调整抓取规则,以适应新结构。

#### 3.1 数据预处理与清洗

##### 3.1.1 数据预处理的基本步骤

数据预处理是数据分析中的一个核心步骤,包括以下步骤:

1. 数据清洗:识别并处理缺失数据、异常值和噪声。

2. 数据集成:将多个数据源整合到一起。

3. 数据转换:将数据转换为适合分析的格式。

4. 数据规约:减少数据量,但不丢失重要信息。

##### 3.1.2 清洗数据的常见方法

数据清洗通常包含以下方法:

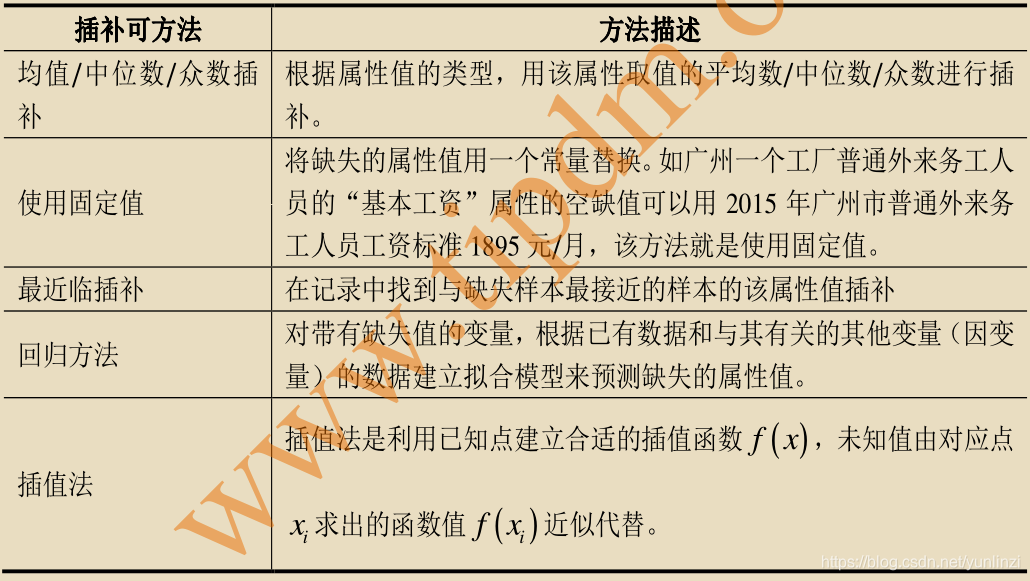

- 处理缺失值:常用方法有删除含有缺失值的记录、填充缺失值、使用模型预测缺失值等。

- 处理异常值:可以使用统计学方法识别异常值,并根据情况决定是否删除或替换。

- 数据转换:如对分类数据进行编码、对数值数据进行标准化或归一化处理。

接下来,我们将深入探讨如何利用工具和代码实现高效的数据预处理和清洗工作。

# 3. SATI3.2数据处理技巧

数据处理是数据分析的中心环节,它包括数据的预处理、清洗、转换、整合和模型化等多个步骤。在数据处理过程中,数据质量直接影响到后续分析的准确性与有效性。SATI3.2在数据处理方面提供了强大的工具和功能,本文将对如何使用SATI3.2进行数据预处理与清洗、数据分析方法论以及数据可视化进行详细阐述。

## 3.1 数据预处理与清洗

### 3.1.1 数据预处理的基本步骤

数据预处理是将原始数据转换为适合分析的状态的过程。它通常涉及以下几个基本步骤:

1. 数据集成:合并多个数据源的数据。

2. 数据清理:处理数据中不一致性和错误的问题。

3. 数据转换:通过缩放等方法使数据适合模型分析。

4. 数据规约:减少数据量,但尽可能保持数据的完整性。

预处理数据是数据分析中不可或缺的一部分,是确保最终分析结果准确、可靠的必要条件。

### 3.1.2 清洗数据的常见方法

清洗数据的目的在于提高数据质量。下面是一些常见的数据清洗方法:

- 缺失值处理:识别并填补或删除缺失值。

- 异常值检测:使用统计方法识别并处理异常值。

- 数据类型转换:确保数据类型符合分析要求。

- 数据规范化:使数据落在统一的范围内,例如标准化或归一化。

通过使用SATI3.2内置的数据清洗工具,用户可以便捷地对数据进行清洗和预处理,从而确保数据质量。

#### 代码示例:处理缺失值

```python

import pandas as pd

# 假设df是我们的DataFrame,其中包含一些缺失值

df = pd.read_csv('data.csv')

# 检查并填充缺失值

df.fillna(df.mean(), inplace=True)

# 检查并删除含有缺失值的行

df.dropna(inplace=True)

```

在上述代码中,我们使用了pandas库来处理数据集`data.csv`中的缺失值。首先我们计算了数值型特征的均值,并用这个均值填充了对应的缺失值。接着,删除了所有含有缺失值的行。

## 3.2 数据分析方法论

### 3.2.1 描述性统计分析方法

描述性统计分析是对数据集的特征进行简化和总结的数学工具。它包括:

- 中心趋势度量:例如均值、中位数和众数。

- 离散趋势度量:例如标准差、方差和范围。

- 形态分布分析:例如偏度和峰度。

这些方法提供了一个数据集的概览,有助于快速识别数据集中的趋势和模式。

### 3.2.2 推断性统计分析方法

推断性统计分析用于从数据样本中推断总体特征。它涉及:

- 置信区间的计算。

- 假设检验,如t检验和卡方检验。

- 回归分析,预测变量间的关系。

这些技术允许研究者推断数据背后的潜在真相,并对总体参数做出统计上的推断。

## 3.3 数据可视化

### 3.3.1 数据可视化的工具和方法

数据可视化是通过图形化的方法展示数据,以帮助用户更直观地理解数据和分析结果。常见的数据可视化工具包括:

- Excel图表

- Tableau

- Python的matplotlib和seaborn库

- R语言的ggplot2包

这些工具和库提供了丰富的图表类型,如折线图、柱状图、散点图和热图等,可以满足不同的数据可视化需求。

### 3.3.2 可视化设计的最佳实践

数据可视化不仅仅是画出漂亮的图表,更需要传达准确的信息。以下是一些最佳实践:

- 确保数据与可视化图形匹配,避免误导观众。

- 使用合适的颜色和标签,使图表易于理解和美观。

- 选择正确的比例和尺度,保证数据的可比性。

- 对于复杂的分析结果,可以使用交互式图表增加用户体验。

### 示例:Python中使用matplotlib绘制条形图

```python

import matplotlib.pyplot as plt

import numpy as np

# 生成示例数据

categories = ['Category A', 'Category B', 'Category C']

values = [10, 20, 30]

y_pos = np.arange(len(categories))

# 创建条形图

plt.bar(y_pos, values, align='center', alpha=0.5)

plt.xticks(y_pos, categories)

plt.ylabel('Value')

plt.title('Simple Bar Chart')

# 显示图表

plt.show()

```

上述代码使用matplotlib库绘制了一个简单的条形图,其中包含三个类别的值。`align='center'`表示条形图居中对齐,`alpha=0.5`提供了50%的透明度。最后,我们设置了y轴标签、x轴标签和图表标题,并使用`plt.show()`显示了图表。

## 表格示例:可视化不同数据类型的可视化方法

| 数据类型 | 可视化方法 | 示例工具 |

|--------------|----------------------------------|-------------------|

| 分类数据 | 条形图、饼图 | matplotlib, Tableau |

| 顺序数据 | 排序条形图、箱形图 | pandas, seaborn |

| 数值数据 | 直方图、散点图、箱线图 | matplotlib, ggplot2 |

| 时间序列数据 | 折线图、堆叠面积图 | Excel, R's ggplot2 |

在上述表格中,我们列举了几种数据类型及其推荐的可视化方法和对应的工具。这对于数据分析师在选择合适的可视化方案时提供了参考。

## Mermaid流程图示例:数据清洗流程

```mermaid

graph LR

A[开始数据清洗] --> B[检查缺失值]

B --> C[缺失值处理]

C --> D[异常值检测]

D --> E[异常值处理]

E --> F[数据类型转换]

F --> G[数据规范性检查]

G --> H[结束数据清洗]

```

上述流程图展示了数据清洗的基本步骤,这有助于指导分析师进行系统的数据清洗工作,确保数据清洗过程的连贯性和完整性。

通过上述章节的深入讲解,我们可以了解到SATI3.2在数据处理方面的强大功能和实际应用。下一章将详细介绍SATI3.2在数据应用实例中的实际使用情况,从而更加贴近IT和相关行业专业人士的实际需求。

# 4. SATI3.2数据应用实例

## 4.1 企业数据监控与分析

### 4.1.1 实时数据监控解决方案

在现代企业运营中,实时监控关键业务指标对于快速响应市场变化和内部管理至关重要。SATI3.2作为一个强大的数据集成平台,能够为企业提供实时数据监控解决方案,确保数据的即时收集、处理和分析。

**应用架构**

实时数据监控解决方案的实施需要一个精心设计的应用架构。首先,企业的IT基础设施需要与数据源进行集成,比如ERP系统、CRM系统和网络设备。这些数据源需要通过APIs或者代理来持续地向SATI3.2平台推送数据。

**代码块示例:**

```python

import sati32

import time

# 初始化SATI3.2连接

sati32_client = sati32.connect()

# 设置数据源配置

data_sources = [

{'name': 'erp', 'url': 'http://erp-system/api/data'},

{'name': 'crm', 'url': 'http://crm-system/api/data'},

]

# 启动数据流监控任务

for source in data_sources:

task = sati32_client.start_data_stream(name=source['name'], url=source['url'])

# 实时数据处理

while True:

for source in data_sources:

records = task.get_records(source['name'])

for record in records:

# 处理实时数据

process_record(record)

time.sleep(1) # 等待一秒钟

```

**参数说明与逻辑分析**

- `sati32.connect()` 建立与SATI3.2平台的连接。

- `data_sources` 定义了所有需要监控的数据源。

- `sati32_client.start_data_stream` 启动数据流监控任务,从指定的URL收集数据。

- `task.get_records` 从数据流中获取实时记录,并进行处理。

**数据集成和流处理**

SATI3.2支持与多个数据源的实时集成,并且通过流处理技术,使数据能即时被处理和分析。企业可以设置告警机制,当监控的数据超过阈值时,自动触发警报,从而快速应对可能出现的问题。

### 4.1.2 基于数据的业务决策支持

SATI3.2平台能够为企业提供基于数据驱动的决策支持。通过分析实时监控到的数据,企业可以更好地理解业务趋势、用户行为和市场动态。

**数据报告和可视化**

利用SATI3.2的数据可视化工具,可以创建直观的仪表板和报告,帮助管理层快速了解业务状况,并做出基于数据的决策。

**代码块示例:**

```javascript

// JavaScript代码块创建数据可视化报告

let dashboard = sati32.createDashboard();

dashboard.addChart('LineChart', { source: 'sales_data_stream', metric: 'Revenue', timeframe: 'LastMonth' });

dashboard.addTable('SalesSummary', { source: 'sales_data_stream', fields: ['Product', 'QuantitySold', 'Revenue'] });

dashboard.display();

```

**参数说明与逻辑分析**

- `sati32.createDashboard()` 创建一个新的数据可视化报告。

- `dashboard.addChart` 向报告中添加一个折线图,展示销售数据流中的收入变化。

- `dashboard.addTable` 添加一个表格,展示产品销售的详细概览。

- `dashboard.display()` 显示创建的报告。

**预测分析和报告生成**

通过集成机器学习模型,SATI3.2可以进一步扩展,用于预测分析。例如,预测销售趋势或库存需求,从而帮助企业提前作出决策,优化资源分配。

## 4.2 安全数据收集与威胁分析

### 4.2.1 安全事件数据的收集与处理

在一个企业IT环境中,安全事件数据的收集与处理是至关重要的。SATI3.2可以与各种安全工具集成,收集安全事件日志,如防火墙、入侵检测系统、防病毒软件等。

**收集与集成过程**

首先,安全管理员需要将所有相关的安全工具日志配置到SATI3.2平台中。然后,SATI3.2将开始实时收集日志,并对数据进行解析和归一化处理。

**代码块示例:**

```python

# 安全日志收集配置

security_logs = {

'firewall': 'http://firewall-system/security/log',

'ids': 'http://ids-system/security/log',

}

# 配置安全日志收集任务

for log_type, url in security_logs.items():

sati32_client.add_data_stream(name=log_type, url=url, parser=security_log_parser)

```

**参数说明与逻辑分析**

- `security_logs` 字典包含不同安全工具的日志URL。

- `sati32_client.add_data_stream` 配置数据流收集任务,并指定日志解析器 `security_log_parser`。

**威胁分析和告警**

在收集和解析安全事件数据之后,SATI3.2平台可以进行威胁分析。系统将使用预定义的规则检测潜在的攻击行为,并在检测到威胁时,通过邮件、短信或者应用推送等方式发出警报。

### 4.2.2 威胁情报的分析和应用

威胁情报的收集和分析对企业来说是维护网络安全的关键。SATI3.2平台可以集成威胁情报源,比如开源威胁情报平台和商业威胁情报服务。

**集成外部威胁情报源**

SATI3.2能够通过API集成外部的威胁情报源,并将这些情报与内部安全事件日志进行关联,以检测和响应已知的威胁模式。

**代码块示例:**

```python

# 集成外部威胁情报源

threat_feeds = {

'alienvault': 'https://alienvault.com/feeds',

'cve': 'https://cve.mitre.org/data feeds.xml',

}

# 定期轮询并更新威胁情报

for feed_name, feed_url in threat_feeds.items():

sati32_client.update威胁情报(name=feed_name, url=feed_url)

```

**参数说明与逻辑分析**

- `threat_feeds` 字典包含了外部威胁情报源的名称和URL。

- `sati32_client.update威胁情报` 负责定期从外部源更新威胁情报数据。

**告警和防御策略调整**

通过与内部安全事件数据的关联分析,SATI3.2能够帮助安全团队发现潜在的攻击,并及时调整防御策略,甚至自动执行预定的缓解措施。

## 4.3 研究数据收集与科学分析

### 4.3.1 学术研究中的数据收集方法

在学术研究中,数据的收集是一个非常关键的过程。SATI3.2可以帮助研究者自动化收集和整理大量的数据来源,包括在线问卷、APIs、数据库和其他研究机构共享的数据。

**自动化数据收集**

研究者可以使用SATI3.2提供的API和脚本,自动从各种在线平台收集数据,减少手工操作,加快数据收集速度。

**代码块示例:**

```python

import sati32

# 配置在线问卷数据流

survey_questions = [

'What is your age?', 'What is your gender?', 'What is your level of education?'

]

# 连接在线问卷平台

survey_platform = sati32.connect('https://example-survey-platform.com')

# 开始收集问卷数据

for question in survey_questions:

sati32_client.add_data_stream(name=question, url=survey_platform.url_for(question))

```

**参数说明与逻辑分析**

- `survey_questions` 列出了研究需要收集的问题。

- `survey_platform` 是在线问卷平台的连接实例。

- `sati32_client.add_data_stream` 添加问卷数据流,指定问题对应的URL。

**数据整理和预处理**

收集到的数据需要经过清洗和整理,以确保其质量。SATI3.2的数据处理工具可以自动化这一过程,为研究分析提供干净、准确的数据集。

### 4.3.2 数据分析在科研中的应用案例

数据分析是科研工作中必不可少的环节。SATI3.2的数据分析工具集成了统计学和机器学习算法,能够支持复杂的数据分析需求。

**高级统计分析**

使用SATI3.2进行描述性统计分析、假设检验、回归分析等,能够帮助研究者揭示数据的深层次含义。

**代码块示例:**

```r

# R语言代码块进行高级统计分析

library(sati32)

# 加载数据集

data_set <- sati32.load_dataset('research_data')

# 描述性统计分析

summary_stats <- sati32.describe(data_set)

# 回归分析

regression_result <- sati32.regress(data_set, dependent='Outcome', independent='Predictor')

```

**参数说明与逻辑分析**

- `sati32.load_dataset` 加载需要分析的数据集。

- `sati32.describe` 进行描述性统计分析。

- `sati32.regress` 进行回归分析,其中 `Outcome` 和 `Predictor` 分别代表因变量和自变量。

**机器学习应用**

对于更加复杂的数据分析任务,如模式识别、预测建模等,SATI3.2可以应用其内置的机器学习工具进行处理。

通过本章节的介绍,我们已经详细探讨了SATI3.2在企业数据监控与分析、安全数据收集与威胁分析以及学术研究中的数据应用实例。接下来的章节,我们将更深入地了解SATI3.2的性能优化和故障排除方法。

# 5. SATI3.2的性能优化和故障排除

在第四章中,我们了解了如何将SATI3.2应用于不同的数据场景中,并讨论了数据收集、分析和应用实例。现在我们进入第五章,深入探讨如何优化SATI3.2的性能,并有效处理出现的故障。

## 5.1 性能优化的方法和策略

性能优化是确保SATI3.2能够高效运行的关键环节。我们需要考虑优化数据收集和处理的各个方面。

### 5.1.1 优化数据收集性能的技术

数据收集的性能优化可以通过多种途径实现:

- **资源管理**:合理分配内存和CPU资源给数据采集任务,确保关键任务获得足够资源。

- **缓存机制**:实施缓存策略,减少对数据库或外部API的直接调用。

- **并发采集**:对于高流量数据,采用并发采集可以大幅提升效率。

### 5.1.2 数据处理性能的提升方法

数据处理性能的提升同样重要,涉及到数据预处理和分析:

- **预处理算法优化**:优化数据清洗算法,减少不必要的计算。

- **流处理技术**:应用流处理技术,进行实时数据分析,提高响应速度。

- **批处理与流处理结合**:合理结合批处理与流处理,处理不同类型的分析需求。

## 5.2 故障诊断和问题解决

在使用SATI3.2过程中,可能会遇到各种问题,包括性能瓶颈和系统故障。

### 5.2.1 日常监控和告警机制

要维持系统的稳定运行,日常监控和告警机制是必不可少的:

- **监控工具的部署**:使用如Prometheus和Grafana等监控工具,实时监测系统性能指标。

- **告警策略**:定制告警策略,当指标异常时及时通知维护人员。

### 5.2.2 常见问题的诊断和解决步骤

面对常见问题,有一套标准化的诊断和解决步骤:

1. **识别问题**:首先需要准确识别问题是出在数据采集还是数据处理环节。

2. **查看日志**:检查相关日志文件,寻找错误信息和异常提示。

3. **复现问题**:尝试复现问题场景,分析影响因素。

4. **解决问题**:根据问题类型,采取相应的解决措施,比如重启服务、调整配置、修复代码错误等。

## 5.3 安全性和隐私保护

在数据采集和处理过程中,始终需要关注安全性和隐私保护。

### 5.3.1 数据收集过程中的安全性考虑

- **数据加密**:在传输和存储过程中使用加密技术,如TLS和AES。

- **访问控制**:限制对敏感数据的访问,实施最小权限原则。

### 5.3.2 数据隐私保护的最佳实践

数据隐私保护需要遵循法规和最佳实践:

- **数据匿名化**:处理个人数据前先进行匿名化处理。

- **合规性检查**:定期进行合规性检查,确保符合GDPR、CCPA等法规要求。

为了确保数据隐私,建议制定和遵循一个严格的数据处理和保护政策。

以上内容详细介绍了SATI3.2在性能优化和故障排除方面的策略和最佳实践。在本章中,我们探讨了性能优化的技术和方法,以及如何诊断和解决系统中遇到的问题。此外,还特别强调了在数据收集过程中确保数据安全性和遵守隐私保护的重要性和实践。这些知识不仅能够帮助IT专业人士提升工作效率,而且对于保障数据安全和合规性具有重要意义。

0

0