【R语言Capet包全面教程】:从基础入门到高级实战,一站式解决数据包管理与分析难题

发布时间: 2024-11-02 16:43:13 阅读量: 39 订阅数: 31

# 1. Capet包简介与安装配置

## 1.1 Capet包概览

Capet是R语言的一个扩展包,旨在简化数据科学流程。从数据的导入导出、处理到高级分析、机器学习和图形展示,Capet包提供了一系列工具来帮助用户更高效地完成数据科学任务。

## 1.2 安装Capet包

在R控制台中输入以下命令,即可安装Capet包:

```R

install.packages("Capet")

```

## 1.3 Capet包的配置与加载

安装完成后,使用`library()`函数来加载Capet包:

```R

library(Capet)

```

加载后,即可开始使用Capet包提供的功能进行数据分析工作。

### 小结

在本文的第一章中,我们了解了Capet包的基本概念,并指导了如何在R环境中安装和配置Capet包。这为后续章节中更深入地探讨Capet包的各项功能打下了基础。接下来,我们将深入Capet包的数据处理与可视化等核心内容。

# 2. 基础数据处理与可视化

## 2.1 Capet包中的基础数据结构

### 2.1.1 向量与矩阵的操作

在Capet包中,向量是基本的数据结构之一,用于存储一组相同类型的数据。向量的操作包括创建、访问元素、向量运算和向量的合并等。向量可以通过`c()`函数创建,例如:

```r

vector_a <- c(1, 2, 3, 4, 5)

```

矩阵是一个二维数组,其中所有数据类型都是相同的。矩阵的操作涉及创建矩阵、访问元素、矩阵运算和矩阵的转置等。创建矩阵使用`matrix()`函数:

```r

matrix_a <- matrix(1:6, nrow = 2, ncol = 3)

```

在处理数据时,常见的操作是对向量或矩阵进行索引,选择特定的元素或子集。例如,选择向量中的第二个和第四个元素:

```r

selected_elements <- vector_a[c(2, 4)]

```

矩阵的索引稍微复杂,因为需要指定行和列:

```r

selected_element_matrix <- matrix_a[2, 3]

```

向量和矩阵还可以进行加、减、乘、除等算术运算,这些运算通常按元素进行。例如,两个相同长度向量的加法:

```r

vector_b <- c(6, 7, 8, 9, 10)

sum_vector <- vector_a + vector_b

```

矩阵相乘需要满足特定条件,且使用 `%*%` 运算符:

```r

matrix_b <- matrix(6:11, nrow = 2)

product_matrix <- matrix_a %*% matrix_b

```

### 2.1.2 数据框(Data Frame)的创建和修改

数据框是Capet包中一种复杂的数据结构,它是一个表格型的数据结构,其中的数据可以是不同的类型。数据框的创建可以通过`data.frame()`函数完成。例如:

```r

df <- data.frame(

Name = c("Alice", "Bob", "Charlie"),

Age = c(25, 30, 35),

Score = c(85, 90, 95)

)

```

数据框的修改包括添加新列、删除列、修改列以及数据类型转换等。添加新列的示例:

```r

df$Grade <- cut(df$Score, breaks = c(0, 60, 70, 80, 90, 100),

labels = c("F", "D", "C", "B", "A"))

```

删除列可以通过`NULL`赋值实现:

```r

df$Score <- NULL

```

修改列的值:

```r

df$Age[df$Name == "Alice"] <- 26

```

数据类型转换,例如将字符型转换为因子型:

```r

df$Name <- as.factor(df$Name)

```

数据框可以视为多个向量的集合,其中每个向量代表一个变量(列),并且变量可以具有不同的数据类型。这种灵活性使得数据框非常适合于实际数据处理工作。

## 2.2 Capet包的数据导入导出功能

### 2.2.1 导入各种数据源的方法

Capet包支持导入多种数据源,包括CSV、Excel、数据库连接和网页数据等。导入数据的基本方法是使用`read.*()`系列函数。

例如,从CSV文件读取数据:

```r

data_csv <- read.csv("data.csv")

```

从Excel文件导入数据,需要使用`readxl`包中的`read_excel()`函数:

```r

library(readxl)

data_excel <- read_excel("data.xlsx")

```

从数据库中导入数据,需要使用相应的数据库接口包,如`RMySQL`或`RPostgreSQL`,并使用`dbGetQuery()`函数:

```r

library(RMySQL)

conn <- dbConnect(MySQL(), user = "user", password = "pass", dbname = "db", host = "host")

query <- "SELECT * FROM table"

data_db <- dbGetQuery(conn, query)

```

从网页抓取数据,则可使用`rvest`包:

```r

library(rvest)

page <- read_html("***")

table <- html_table(html_nodes(page, "table")[[1]])

```

### 2.2.2 数据导出到不同格式的操作

数据导出操作通常使用`write.*()`系列函数。将数据导出到CSV文件:

```r

write.csv(data_csv, "output.csv")

```

将数据保存为Excel文件,则使用`write.xlsx()`函数,它属于`openxlsx`包:

```r

library(openxlsx)

write.xlsx(data_excel, "output.xlsx")

```

导出数据到数据库,则需使用数据库连接并调用`dbWriteTable()`函数:

```r

dbWriteTable(conn, "output_table", data_db, append = TRUE)

```

将数据框保存为HTML文件,可以使用`html_table()`函数:

```r

html_data <- html_table(data_csv)

writeLines(html_data, "output.html")

```

Capet包提供的数据导入导出功能非常强大,能够覆盖大多数常见场景,但也需要针对具体的数据源选择合适的工具和方法。

## 2.3 Capet包的数据清洗和预处理

### 2.3.1 缺失值与异常值处理

数据清洗是数据分析前的重要步骤,涉及到处理缺失值、异常值和格式不一致等问题。在Capet包中,缺失值通常表示为`NA`,处理方法包括删除含有缺失值的行或列,或者填充缺失值。

例如,删除含有缺失值的行:

```r

data_complete <- na.omit(data_csv)

```

填充缺失值,可以选择填充特定值或使用统计方法(如均值、中位数):

```r

data_filled <- data_csv

data_filled[is.na(data_filled)] <- mean(data_filled, na.rm = TRUE)

```

处理异常值通常需要基于数据的具体含义来判断,常见的方法有Z分数法、箱型图判断和IQR(四分位距)法等:

```r

data_robust <- data_csv

# 使用Z分数法处理异常值,假设阈值为3

z_scores <- abs(scale(data_robust))

data_robust <- data_robust[z_scores < 3, ]

```

### 2.3.2 数据转换与整合技巧

数据转换包括类型转换、数据标准化、归一化等操作,而数据整合则涉及到数据框的合并和连接。

类型转换是将数据从一种类型转换为另一种类型,如字符型转换为数值型:

```r

data_converted <- as.numeric(as.character(data_csv$column))

```

数据标准化是为了消除不同量纲的影响,常见的标准化方法包括最小-最大标准化和Z分数标准化:

```r

data_normalized <- scale(data_csv)

```

数据整合通常使用`merge()`函数,根据一个或多个键值来合并两个数据框:

```r

data_merged <- merge(data_csv, another_data_csv, by = "key_column")

```

使用`rbind()`或`cbind()`函数可以将数据框纵向或横向连接:

```r

data_rowbinded <- rbind(data_csv, another_data_csv)

data_colbinded <- cbind(data_csv, additional_column = 1:nrow(data_csv))

```

数据清洗和预处理是数据分析的基础,只有数据质量得到保证,后续分析的结果才可靠。

以上章节内容涉及了Capet包的基础数据结构操作、数据导入导出的方法以及数据清洗和预处理的技巧。掌握这些技能对于处理数据并进行有效分析至关重要。

# 3. 高级数据管理技巧

## 复杂数据操作

### 列表(List)和数组(Array)的高级用法

在数据处理中,列表(List)和数组(Array)是两种极其重要的数据结构,尤其是在处理非结构化数据或进行高度复杂的数据操作时。Capet包提供了一系列函数来管理这些结构,使其操作更加灵活和强大。

列表(List)是Capet中最灵活的数据类型,可以包含不同类型的元素,包括其他列表。这种能力使得它成为嵌套数据的理想选择。列表中的每个元素可以被赋予一个名称,便于检索和操作。

```r

# 创建一个包含不同数据类型的列表

my_list <- list(

name = "John Doe",

age = 30,

is_member = TRUE,

scores = c(90, 85, 93)

)

# 访问列表中的数据

print(my_list$name) # 输出 "John Doe"

print(my_list$scores) # 输出 [90, 85, 93]

```

数组(Array)通常用于处理多维数据,可以看作是更高维度的向量。它在数据科学和统计分析中非常重要,尤其是在处理图像数据、时间序列数据和多变量数据时。

```r

# 创建一个二维数组

my_array <- array(1:6, dim = c(2, 3))

# 打印数组内容

print(my_array)

```

### 分组与聚合计算

分组与聚合是数据分析中常用的高级操作。Capet包中的`dplyr`和`data.table`扩展包提供了方便的分组聚合功能。在实际应用中,通常需要根据某些特定的条件对数据进行分组,并对每组数据进行汇总、计算平均值、求和等操作。

```r

# 加载dplyr包

library(dplyr)

# 创建示例数据框

data <- data.frame(

Group = c("A", "B", "A", "B", "A"),

Value = c(2, 3, 4, 1, 5)

)

# 使用group_by和summarise进行分组聚合

result <- data %>%

group_by(Group) %>%

summarise(Sum = sum(Value), Mean = mean(Value))

print(result)

```

## 条件筛选与数据重塑

### 筛选、排序和选择操作

数据筛选是数据分析中不可或缺的一步。Capet包提供了多种方法来筛选数据,包括基于条件的筛选、行和列的索引、匹配特定模式的文本筛选等。通过这些方法,用户可以从庞大的数据集中快速提取出有用的信息。

```r

# 创建示例数据框

df <- data.frame(

ID = 1:6,

Name = c("Alice", "Bob", "Charlie", "David", "Eve", "Frank"),

Score = c(88, 95, 90, 94, 82, 85)

)

# 使用Capet的筛选功能提取Score大于90的行

filtered_df <- df[df$Score > 90, ]

print(filtered_df)

```

数据排序是另一种常用的数据处理手段,常用于在进行数据探索时查找特定值或值域。Capet包中可以使用`order()`函数或`dplyr`包的`arrange()`函数进行排序操作。

```r

# 使用dplyr的arrange函数进行排序

sorted_df <- df %>%

arrange(desc(Score))

print(sorted_df)

```

### 数据重塑与合并技术

在分析多变量数据时,数据重塑是一个重要的步骤。Capet包中的`reshape2`包和`tidyr`包提供了方便的工具来对数据进行重塑。这包括将数据从宽格式转换为长格式,或反之,这在进行统计分析和图形展示时特别有用。

```r

# 使用tidyr包中的gather函数将数据框重塑为长格式

long_df <- df %>%

gather(key = "Subject", value = "Grade", -ID, -Name)

print(long_df)

```

数据合并则是将来自不同数据源的相关数据整合到一起的过程。Capet包的`dplyr`和`merge()`函数提供了强大的数据合并功能。通过指定合并的键值,用户可以将两个数据框按照共同的列进行合并。

```r

# 创建第二个示例数据框

df2 <- data.frame(

ID = c(1, 2, 5),

Age = c(22, 33, 25)

)

# 使用merge函数合并两个数据框

merged_df <- merge(df, df2, by = "ID")

print(merged_df)

```

## 文本挖掘与数据处理

### 文本数据的清洗与处理

文本数据是数字时代的一大信息来源,有效地清洗和处理这些数据对于提取有价值的信息至关重要。Capet包中的`stringr`包和基础函数如`gsub()`和`grepl()`提供了一系列工具来完成这些任务。

```r

# 创建示例文本数据

text <- c("Hello, world!", "Capet is awesome!", "R rocks!")

# 使用gsub函数替换文本中的特定字符串

cleaned_text <- gsub("!", "", text)

print(cleaned_text)

```

### 文本特征提取与分析

在文本数据经过预处理之后,通常需要提取出一些特征,以便进行进一步的分析。这包括词频统计、关键词提取、文本分类等。Capet包通过`tm`包等扩展包提供了这样的工具。

```r

# 创建一个示例的文档矩阵

docs <- VCorpus(VectorSource(text))

# 将文本转换为小写

docs <- tm_map(docs, content_transformer(tolower))

# 创建一个词频文档矩阵

tdm <- TermDocumentMatrix(docs)

# 查找词频

findAssocs(tdm, "capet", 0.8)

```

通过上面的示例,我们可以看到Capet包在处理文本数据方面提供了强大的功能。文本数据的清洗和特征提取是进行后续文本分析和挖掘的基础。随着数据科学的发展,文本挖掘技术在社交网络分析、情感分析、搜索引擎优化等多个领域得到了广泛的应用。

# 4. 统计分析与图形展示

## 4.1 Capet包的统计分析方法

### 4.1.1 基本统计描述

在处理数据时,我们经常需要获取数据集的描述性统计信息,如均值、中位数、标准差等。Capet包提供了多种函数来帮助用户轻松获取这些信息。

```R

data <- c(10, 20, 30, 40, 50)

mean_data <- mean(data) # 计算均值

median_data <- median(data) # 计算中位数

sd_data <- sd(data) # 计算标准差

```

上述代码块展示了如何使用Capet包中的`mean()`, `median()`, `sd()`函数来获取数据集的基本描述性统计。每一个函数的参数都是`data`,代表我们要分析的数据集合。`mean()`函数返回所有数值的平均值,`median()`返回中位数,而`sd()`函数则计算标准差,这是衡量数据分散程度的重要指标。

使用这些基本的统计函数时,需要注意数据类型。例如,`mean()`和`sd()`函数通常用于数值型向量。如果数据中包含NA(缺失值),则默认情况下函数会返回NA。可以通过`na.rm = TRUE`参数来排除这些缺失值,从而计算出其他非缺失值的统计结果。

```R

data_with_na <- c(10, 20, NA, 40, 50)

mean_data_with_na <- mean(data_with_na, na.rm = TRUE)

```

在此代码块中,`data_with_na`数据集包含一个NA值。通过设置`na.rm = TRUE`,我们可以排除这个NA值,并计算其他数值的均值。

### 4.1.2 假设检验与置信区间

统计分析不仅包括计算描述性统计信息,而且包括更深入的推断统计,如假设检验和置信区间的计算。

假设检验是统计学中的一个基本概念,用于测试关于总体参数的假设。在Capet包中,可以使用`t.test()`函数进行单样本t检验,以及`var.test()`进行方差齐性的F检验等。

```R

# 单样本t检验

t_test_result <- t.test(data, mu = 35) # 检验均值是否等于35

# 方差齐性F检验

f_test_result <- var.test(data1, data2) # 检验两个数据集的方差是否相等

```

在`t.test()`函数中,`data`是用于检验的样本数据,`mu`参数是我们设定的总体均值的假设值。函数返回一个包含t统计量、p值和置信区间的结果。

`var.test()`函数用于比较两个数据集的方差是否相同。这里`data1`和`data2`代表两个独立的样本数据集,函数会返回方差比的检验结果。

置信区间给出了一个区间估计,可以用来估计一个总体参数(例如均值或比率)的真实值。使用`confint()`函数可以获取模型参数的置信区间。

```R

# 假设有一个回归模型对象lm_model

confint(lm_model)

```

这里`confint()`函数接收一个拟合好的模型对象(如线性回归模型),并返回模型参数的置信区间,这有助于了解参数的不确定性范围。

通过进行假设检验和计算置信区间,研究人员能够更精确地了解数据集背后可能的总体参数,以及所做估计的可信程度。这对于科学研究和决策支持具有重要意义。

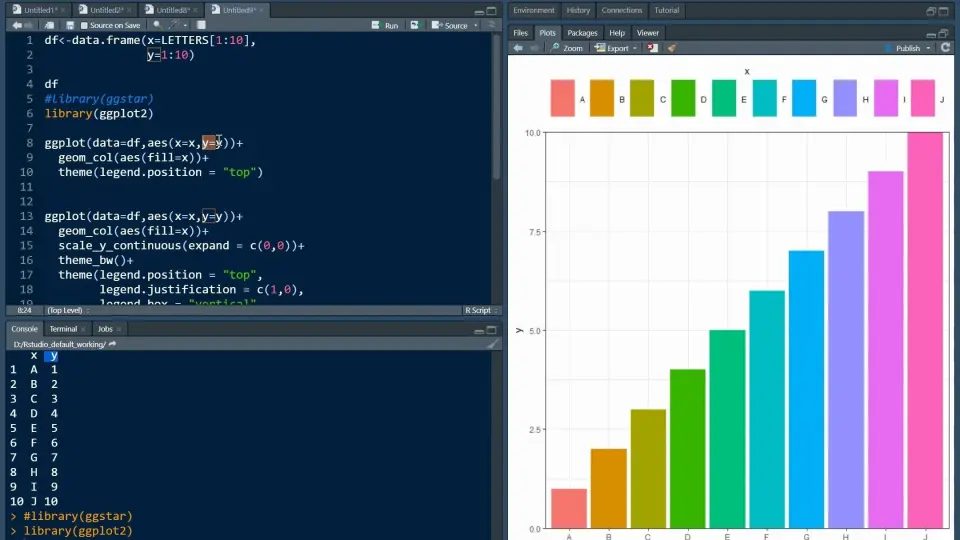

## 4.2 Capet包的图形化数据展示

### 4.2.1 基本图形的绘制技巧

在数据分析和探索性数据可视化中,绘制基本图形是一个必不可少的步骤。Capet包提供了多个函数来生成各种类型的基本图形。

```R

# 绘制直方图

hist(data)

# 绘制箱线图

boxplot(data)

```

在这里,`hist()`函数创建了数据集`data`的直方图,直观显示了数据的分布情况。`boxplot()`函数则绘制了一个箱线图,它通过五个统计量(最小值、第一四分位数、中位数、第三四分位数和最大值)来展示数据的分布特征,并能直观地识别出异常值。

为了增强基本图形的表达效果,Capet包允许用户在绘图时添加多种参数。

```R

# 绘制带有自定义标题和轴标签的直方图

hist(data, main = "Histogram of Data", xlab = "Data Values", ylab = "Frequency", col = "lightblue")

```

在这个例子中,我们对`hist()`函数的输出进行了增强,通过添加`main`参数来指定图表的标题,`xlab`和`ylab`参数来设置x轴和y轴的标签,`col`参数来设定图形的填充颜色。这些改动使得直方图更加直观和易于理解。

### 4.2.2 高级图形定制与展示

除了基本图形之外,Capet包还支持高级图形的定制,使用户能够根据自己的需求创建独特的视觉展示。

```R

# 绘制散点图

plot(x_data, y_data, main = "Scatter Plot Example", xlab = "X Values", ylab = "Y Values", col = "red", pch = 16)

# 添加线性拟合线

abline(lm(y_data ~ x_data), col = "blue")

```

在这个散点图示例中,我们绘制了`x_data`和`y_data`之间的关系,并通过`abline()`函数添加了一个线性回归线(通过`lm()`函数计算得到)。我们为散点图设置了标题、轴标签和点的颜色与形状。

为了创建更为复杂的图形,Capet包的`ggplot2`扩展包提供了更多高级图形定制选项。

```R

# 使用ggplot2绘制高级散点图

library(ggplot2)

ggplot(data = my_data, aes(x = x_column, y = y_column)) +

geom_point() +

geom_smooth(method = "lm", se = FALSE, col = "blue") +

labs(title = "Advanced Scatter Plot with Linear Fit", x = "X Axis Label", y = "Y Axis Label")

```

这段代码展示了如何使用`ggplot2`包中的`ggplot()`函数来创建一个高级散点图。通过`aes()`函数,我们指定了数据框架`my_data`中的`x_column`和`y_column`对应于图形的x轴和y轴。`geom_point()`函数用于添加散点,而`geom_smooth()`函数则添加了基于线性模型的平滑曲线。`labs()`函数用于自定义图表的标题和轴标签,增加了图表的信息性和美观性。

通过学习和掌握这些基本和高级图形定制技巧,数据分析师可以有效地将复杂数据转换为直观的视觉展示,这对于数据分析的解释和呈现至关重要。

结合了上述统计分析和图形展示技巧后,我们不仅可以进行数据的深入分析,而且还可以将分析结果以更易理解的方式呈现给相关利益相关者。这为数据科学家提供了一套强大的工具集,以推动决策过程中的数据驱动型见解。

# 5. 机器学习与数据挖掘

机器学习与数据挖掘是现代数据分析不可或缺的一部分,Capet包通过提供一系列算法和功能,使得在R语言中进行机器学习和数据挖掘工作变得更为便捷。本章节将深入探讨Capet包在机器学习与数据挖掘方面的应用,包括常用机器学习算法的实现、模型训练与评估方法,以及Capet包在数据挖掘中的具体功能。

## 5.1 Capet包在机器学习中的应用

机器学习技术能够从数据中自动学习并作出预测或决策,极大地推动了数据科学的发展。Capet包提供了一系列机器学习算法的接口,使得用户能够在R环境中快速实现机器学习模型的构建。

### 5.1.1 常用机器学习算法的实现

Capet包集成了多种类型的机器学习算法,包括分类、回归、聚类等,覆盖了大多数常见的机器学习任务。

#### 分类算法

- **逻辑回归(Logistic Regression)**

逻辑回归是一种广泛用于二分类问题的模型。在Capet包中,可以使用`capet::glm()`函数来实现逻辑回归模型。

```R

# 逻辑回归示例

model_lr <- capet::glm(Class ~ ., data = training_data, family = binomial)

```

- **随机森林(Random Forest)**

随机森林是一种集成学习方法,能够提高模型的预测性能。Capet包中的`capet::randomForest()`函数可以方便地拟合随机森林模型。

```R

# 随机森林示例

library(capet)

model_rf <- randomForest(Class ~ ., data = training_data)

```

#### 回归算法

- **线性回归(Linear Regression)**

线性回归模型适用于预测连续值变量。`capet::lm()`函数是实现线性回归的标准方法。

```R

# 线性回归示例

model_lm <- capet::lm(Sales ~ ., data = training_data)

```

- **支持向量机(Support Vector Machine, SVM)**

支持向量机是一种有效的分类与回归算法。Capet包提供`capet::svm()`函数用于支持向量机模型的拟合。

```R

# SVM示例

model_svm <- capet::svm(Class ~ ., data = training_data)

```

#### 聚类算法

- **K-均值(K-means)**

K-均值聚类是一种将数据集划分为K个子集的算法。Capet包中的`capet::kmeans()`函数能够实现此算法。

```R

# K-均值聚类示例

set.seed(123)

model_kmeans <- capet::kmeans(training_data, centers = 3)

```

### 5.1.2 模型训练与评估方法

模型训练和评估是机器学习中的关键步骤。Capet包支持多种评估指标和交叉验证方法,可以帮助用户更准确地评估模型性能。

#### 模型训练

模型训练是指使用数据集对机器学习模型进行参数估计的过程。Capet包通过简洁的语法使训练过程变得简单高效。

```R

# 示例:使用逻辑回归模型

# training_data 是一个包含预测变量和响应变量的数据框

model <- capet::glm(response ~ ., data = training_data, family = binomial)

```

#### 模型评估

模型评估则侧重于检验模型在未见数据上的泛化能力。在Capet包中,可以使用混淆矩阵、精确度、召回率等多种评估指标。

```R

# 评估逻辑回归模型的精确度

predictions <- predict(model, newdata = test_data, type = 'response')

predictions_class <- ifelse(predictions > 0.5, 1, 0)

confusion_matrix <- table(Predicted = predictions_class, Actual = test_data$response)

accuracy <- sum(diag(confusion_matrix)) / sum(confusion_matrix)

```

## 5.2 Capet包的数据挖掘功能

数据挖掘是从大量数据中提取或“挖掘”出信息的过程。Capet包在数据挖掘领域也提供了丰富的功能,尤其在关联规则学习和集成学习方面表现突出。

### 5.2.1 关联规则学习

关联规则学习是发现数据集中变量之间有趣关系的方法,常用于市场篮子分析。Capet包中的`capet::apriori()`函数实现了Apriori算法,这是一种广泛使用的关联规则学习方法。

```R

# 示例:使用Apriori算法发现关联规则

# transaction_data 是交易数据集

rules <- capet::apriori(transaction_data, parameter = list(supp = 0.001, conf = 0.8))

inspect(rules[1:5])

```

### 5.2.2 集成学习与模型优化

集成学习是将多个模型的预测结果结合起来以获得更好的预测性能。Capet包的`capet::randomForest()`函数已经提到了如何使用随机森林算法。此外,还提供了其他集成方法,如梯度提升决策树(Gradient Boosting Decision Trees, GBM)等。

```R

# 示例:使用GBM进行集成学习

library(capet)

gbm_model <- capet::gbm(Class ~ ., data = training_data, n.trees = 100, interaction.depth = 3, n.minobsinnode = 10)

```

模型优化涉及调整模型的参数以获得最佳性能。Capet包支持网格搜索和随机搜索等多种优化方法。

```R

# 示例:使用网格搜索优化随机森林模型

set.seed(123)

tuneGrid <- expand.grid(.mtry=c(2, 3, 4))

control <- capet::trainControl(method="cv", number=5)

tuneRF <- capet::train(Class ~ ., data=training_data, method="rf", trControl=control, tuneGrid=tuneGrid)

```

至此,第五章:机器学习与数据挖掘已介绍完毕,详细探讨了Capet包在机器学习和数据挖掘领域的应用,包括实现常用机器学习算法、模型训练与评估方法,以及数据挖掘相关的关联规则学习和集成学习等技术。通过这些内容的介绍,相信读者已经对如何在R中使用Capet包开展机器学习和数据挖掘有了更深入的了解。接下来的第六章将通过实战案例,进一步展示Capet包在不同领域的应用效果和潜力。

# 6. R语言Capet包实战案例分析

Capet包作为R语言中的一个重要工具包,它在复杂数据分析、统计分析、数据可视化等领域提供了强大支持。本章节将通过实战案例来深入探讨Capet包的应用价值和实际操作,为读者提供实用的知识和技能。

## 6.1 复杂数据分析项目实战

### 6.1.1 项目需求分析与数据收集

在开始使用Capet包处理复杂数据分析项目之前,首先需要进行项目需求分析。这一阶段,关键任务是明确项目目标、确定分析方法以及收集必要的数据。例如,如果项目的目标是分析社交媒体用户行为,那么需要收集的数据可能包括用户互动次数、点赞数、评论内容等。

在数据收集阶段,Capet包可用来清洗和预处理从不同数据源(如CSV文件、数据库、API接口等)中导入的数据。例如,使用`capet::read_csv`函数可以读取CSV文件数据,并且在读取时直接指定数据类型和处理缺失值。

```R

# 示例:读取CSV文件数据

data <- capet::read_csv("user_data.csv",

col_types = cols(

user_id = col_double(),

like_count = col_double(),

comment_text = col_character()

),

na = c("NA", "", "NULL"))

```

### 6.1.2 数据处理与分析策略

在数据收集后,下一步就是对数据进行处理。使用Capet包可以有效地进行数据的筛选、转换、整合等操作。例如,根据需要筛选出互动次数超过一定阈值的用户数据进行分析,可以使用`capet::filter`函数。

```R

# 示例:筛选互动次数超过100的用户数据

filtered_data <- capet::filter(data, interaction_count > 100)

```

此外,数据处理阶段还涉及数据整合、数据转换等步骤。Capet包提供了多种函数来处理这些任务,如`capet::mutate`用于创建或修改变量,`capet::summarise`用于数据摘要统计。

## 6.2 Capet包在特定领域的应用

### 6.2.1 生物信息学中的应用

Capet包在生物信息学领域同样有着广泛的应用。例如,在基因表达数据分析中,可以使用Capet包对基因表达矩阵进行预处理、标准化和差异表达分析。`capet::normalize`函数可以对数据进行标准化处理,而`capet::ANOVA`则可以用于进行方差分析。

```R

# 示例:基因表达数据的标准化处理

normalized_data <- capet::normalize(expression_matrix, method = "quantile")

# 示例:进行方差分析

ANOVA_results <- capet::ANOVA(normalized_data, group = group_factor)

```

### 6.2.2 社会科学中的应用案例

在社会科学领域,Capet包可用于调查数据的分析、人口统计数据的建模等。比如,在进行某个社会调查项目时,可以利用Capet包对调查问卷结果进行汇总、因子分析、以及聚类分析等。

```R

# 示例:进行因子分析

factor_analysis <- capet::factanal(survey_data, factors = 3)

# 示例:进行聚类分析

cluster_analysis <- capet::kmeans(survey_data, centers = 5)

```

## 6.3 Capet包的未来发展趋势与挑战

### 6.3.1 新功能介绍与学习路径

随着Capet包的持续更新,新功能和工具也在不断地被加入。例如,Capet包可能引入了对大数据处理的支持,或者增加了新的统计模型。对于希望深入学习Capet包的用户,建议从基础数据结构的操作开始,逐步深入到高级功能的学习,如机器学习、数据挖掘等。

### 6.3.2 面临的挑战与解决方案

尽管Capet包功能强大,但它在处理极其庞大的数据集时可能会遇到性能瓶颈。一个常见的挑战是内存管理。为了解决这个问题,用户可以采取数据分块处理的策略,或者使用Capet包的`capet::memcap`功能来监控内存使用情况。

在面对数据质量的挑战时,如缺失数据和异常值问题,用户需要熟练掌握Capet包提供的数据清洗和预处理功能。通过合理使用Capet包中的数据处理工具,可以大幅提高数据分析的准确性和效率。

通过上述章节的介绍和实例展示,读者应能更好地理解Capet包在不同领域中的应用,并且在实战中有效利用该工具包解决问题。

0

0