Hadoop Archive架构深度解析:数据压缩存储优化的5大策略

发布时间: 2024-10-27 15:41:06 阅读量: 34 订阅数: 31

免费的防止锁屏小软件,可用于域统一管控下的锁屏机制

# 1. Hadoop Archive的基本概念和原理

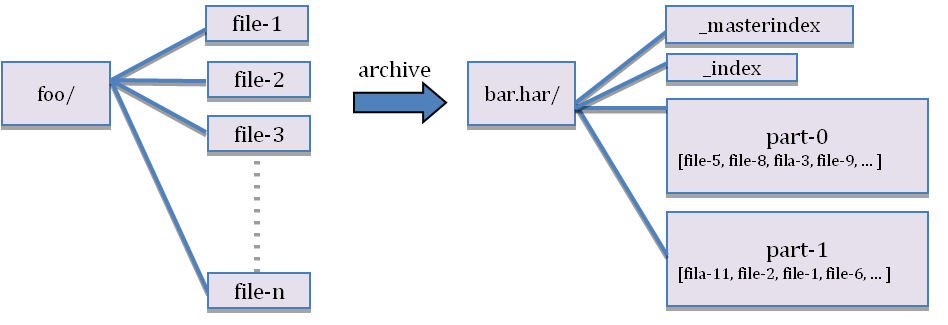

在大数据生态系统中,Hadoop作为核心组件,扮演了重要角色。其中,Hadoop Archive(HAR)是专为优化存储HDFS中的小文件而设计的高效工具。它的基本概念可以被理解为一种封装好的文件存档格式,允许系统将大量小文件打包成更少的HDFS文件,从而减少NameNode的内存消耗。

Hadoop Archive的原理涉及到对原始数据进行打包和压缩,通过归档操作,文件系统元数据被转换为更少、更大的文件,这有助于提高NameNode的效率,并减少了对文件系统元数据的操作。在这个过程中,Hadoop利用SequenceFile格式进行文件的存储,这个格式支持数据的压缩,可以进一步提升存储效率。

此外,Hadoop Archive提供了针对不同数据类型和压缩需求的优化方案。其核心优势是能够显著减少NameNode的负载,这对于维护大规模Hadoop集群的稳定性和性能至关重要。随着数据量的增长,Hadoop Archive能够帮助组织有效地管理存储,提升数据处理和访问的速度。

# 2. 数据压缩存储优化的理论基础

## 2.1 数据存储优化的目标和意义

### 2.1.1 存储优化的重要性

随着数据量的日益增长,企业和组织面临的一个主要挑战是如何高效地存储这些数据。数据存储优化可以大幅度减少所需的物理存储空间,降低存储成本,并且能够提高数据检索效率。合理的存储优化策略可以改善数据的存储结构,优化数据访问路径,减少数据冗余,从而加快数据处理速度,提升系统性能。

### 2.1.2 存储优化的目标

数据存储优化的根本目标是确保数据的高可用性、安全性和经济性。高可用性意味着数据在需要时能够可靠地访问;安全性强调对数据的保护措施,防止数据被未经授权的人访问或篡改;而经济性则关注以最低的成本实现上述目标。优化存储的目标还包括提高数据的读写速度,压缩数据以减少存储空间的需求,以及实现数据的快速备份和恢复。

## 2.2 数据压缩技术的分类和原理

### 2.2.1 无损压缩技术

无损压缩技术可以完全恢复原始数据,不会丢失任何信息。这种压缩方式适用于需要精确数据的场合,比如文本文件、可执行程序、数据库文件等。常见的无损压缩算法包括Huffman编码、Lempel-Ziv-Welch (LZW)、Deflate等。这些算法通常通过查找和消除数据中的冗余信息来实现压缩。

### 2.2.2 有损压缩技术

与无损压缩不同,有损压缩在提高压缩率的同时会丢失一部分信息。这种压缩适用于对质量要求不是极端严格的场合,比如图像、音频和视频文件。有损压缩允许在压缩过程中根据某种标准舍去一些人眼或人耳不易察觉的信息,以此达到更高的压缩比。JPEG和MP3是常见的有损压缩格式。

## 2.3 Hadoop Archive的压缩算法

### 2.3.1 压缩算法的选择和应用

Hadoop Archive(HAR)是一种特定的压缩方法,适用于Hadoop环境中的HDFS(Hadoop分布式文件系统)。HAR能够将多个小文件打包成一个大文件,减少NameNode的内存消耗,并且通过压缩来减少存储空间。Hadoop支持多种压缩格式,包括Gzip、Bzip2、Snappy等。选择合适的压缩算法需要考虑压缩和解压速度、压缩率和对原始数据的访问频率等因素。

### 2.3.2 压缩算法的优缺点分析

- **Gzip**:Gzip使用DEFLATE算法,它结合了LZ77压缩和哈夫曼编码。Gzip压缩比高,但压缩和解压速度相对较慢。适用于对压缩比要求较高但对速度要求不高的场景。

- **Bzip2**:Bzip2使用Burrows-Wheeler变换和霍夫曼编码,它的压缩比通常高于Gzip,但解压速度更慢。它适合需要最大化压缩比但可以接受较慢解压速度的场景。

- **Snappy**:Snappy由Google开发,旨在实现快速压缩和解压速度,特别适用于对速度要求较高而对压缩比要求一般的场景。Snappy的压缩率低于Gzip和Bzip2,但压缩和解压速度是其主要优势。

```plaintext

| 压缩算法 | 压缩率 | 压缩速度 | 解压速度 |

|----------|--------|----------|----------|

| Gzip | 高 | 慢 | 慢 |

| Bzip2 | 更高 | 慢 | 更慢 |

| Snappy | 低 | 快 | 快 |

```

在选择压缩算法时,需要平衡压缩率和速度之间的关系,并考虑数据的特性和应用场景。例如,数据备份可能更适合使用Gzip或Bzip2进行压缩,以节省存储空间;而实时数据处理则更倾向于使用Snappy,以减少延迟。

## 2.4 Hadoop Archive压缩算法的配置和使用

### 2.4.1 Hadoop Archive的配置方法

配置Hadoop Archive是一个简单的过程,可以通过Hadoop的命令行工具来完成。要创建Hadoop Archive,需要使用`hadoop archive`命令,该命令允许用户指定一系列参数,如输入路径、输出路径、压缩算法、块大小和归档命名等。下面是一个配置Hadoop Archive的基本命令:

```bash

hadoop archive -archiveName <name>.har -p <hdfs-path> <input-dir>

```

在这个例子中,`<name>.har`是归档文件的名称,`<hdfs-path>`是HDFS上的归档目录路径,而`<input-dir>`是要归档的HDFS目录。

### 2.4.2 Hadoop Archive的使用实例

假设我们需要为HDFS中的`/user/data`目录创建一个Hadoop Archive,我们可以使用如下命令:

```bash

hadoop archive -archiveName data.har -p /user/data /user/data

```

执行完毕后,可以在指定的目录下找到名为`data.har`的文件。这个文件包含了`/user/data`目录下所有数据的压缩归档。使用Hadoop的`-ls`命令可以查看HAR文件的内部结构。

```bash

hadoop fs -ls /user/data/data.har

```

这将列出HAR文件内包含的所有文件和目录。

## 2.5 数据压缩存储优化的策略和方法

### 2.5.1 数据存储策略

数据存储策略包括数据的分类存储、层次化存储以及基于数据生命周期的存储管理。分类存储意味着根据数据的类型和用途将其存储在不同的存储介质上,比如热数据存储在SSD上,而冷数据则可以迁移到成本更低的存储介质上。层次化存储是根据数据访问频率的不同将数据放置在不同性能的存储层,以实现成本和性能之间的最佳平衡。数据生命周期管理则是通过制定策略来自动将数据从一个存储层迁移到另一个层,从而优化存储空间和成本。

### 2.5.2 数据压缩策略

数据压缩策略包括选择合适的压缩算法、决定压缩的时机和位置、以及实施压缩过程中的性能监控和管理。无损压缩和有损压缩的选择要根据具体数据类型和应用场景来决定。压缩的时机可以是数据写入时进行压缩,也可以是数据静止时批量压缩。性能监控和管理则涉及到压缩过程对系统性能的影响,需要合理调度压缩操作,以避免对用户访问和系统性能造成过大影响。

## 2.6 数据压缩存储优化的效果评估

### 2.6.1 压缩效率的评估

压缩效率通常可以通过压缩比和压缩/解压速度来评估。压缩比是指压缩前后的数据大小比,理想情况下,压缩比越高表示压缩效率越好。但是,压缩效率的评估不能只看压缩比,还要考虑压缩和解压的速度。如果一个压缩算法的压缩速度非常慢,即便压缩比很高,也可能不适合实时数据处理的应用场景。

### 2.6.2 存储效率的评估

存储效率的评估则涉及到存储空间的利用率和数据的访问速度。高存储效率意味着使用最小的存储空间达到最优的数据访问性能。这需要根据存储策略和压缩策略的实施情况来综合评估。评估工具可以是系统自带的性能监控工具

0

0